안녕하세요! 오늘은 최신 오픈소스 멀티모달 모델인 LLaVA-OneVision에 대해 알아보겠습니다. 이 모델은 단일 이미지, 다중 이미지, 그리고 비디오 시나리오에서도 우수한 성능을 발휘하는 최초의 오픈소스 모델로, 멀티모달 AI 중에서도 주목받고 있습니다. 특히, 이미지 기반 전이 학습을 통해 비디오 처리까지 가능하다는 점이 큰 장점입니다. 또한, 여러 벤치마크에서 GPT-4V 및 GPT-4o 같은 상용 모델들과 비교해도 매우 경쟁력 있는 성능을 보여주고 있습니다. 이번 블로그에서는 LLaVA-OneVision의 개요, 주요 특징, 벤치마크 성능을 살펴보고, 직접 테스트를 진행해 보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

LLaVA-OneVision 개요

LLaVA-OneVision은 LLaVA-NeXT에서 발전된 모델로, 두 모델은 밀접한 관계를 가지고 있습니다. LLaVA-NeXT는 초기 LLaVA 시리즈의 일환으로, 주로 단일 이미지 처리와 고해상도 이미지에 대한 확장성에 중점을 두었습니다. 이 모델은 높은 성능을 자랑하며 멀티모달 학습에서 강력한 기반을 제공했습니다.

LLaVA-OneVision은 LLaVA-NeXT의 아키텍처를 기반으로 하여 개발되었으며, 특히 비디오와 다중 이미지 처리에서 전이 학습을 통해 뛰어난 성능을 발휘합니다. 이를 통해 단일 이미지뿐만 아니라 다양한 시나리오에서 더 나은 성능을 발휘할 수 있는 새로운 기능을 얻었습니다. 따라서 LLaVA-OneVision은 LLaVA-NeXT의 확장 버전으로, 전이 학습 및 멀티모달 시나리오에 적합하게 설계된 후속 모델이라고 할 수 있습니다.

LLaVA-NeXT에 대한 자세한 내용은 아래 포스팅을 참고하시면 될 것 같습니다.

2024.02.08 - [AI 언어 모델] - LLaVA NeXT: 제미나이 프로를 뛰어넘는 오픈소스 멀티모달 AI!

LLaVA NeXT: 제미나이 프로를 뛰어넘는 오픈소스 멀티모달 AI!

안녕하세요! 오늘은 멀티모달 대규모 언어 모델 LLaVA의 업데이트 소식에 대해 알아보겠습니다. LLaVA (Language-Image Visual Assistant, 언어-이미지 시각 어시스턴트)는 시각적 지시 조정기술(Visual Instructi

fornewchallenge.tistory.com

LLaVA-OneVision은 다양한 크기와 성능을 제공하는 여러 모델 버전을 지원합니다.

- 0.5B 모델: 가장 작은 모델로, 상대적으로 적은 자원으로 실행할 수 있으며, 경량화된 환경에 적합합니다.

- 7B 모델: 중간 크기의 모델로, 더 많은 데이터를 처리하고 학습할 수 있으며, 다중 이미지 및 비디오 처리에서 뛰어난 성능을 발휘합니다.

- 72B 모델: 가장 큰 모델로, 높은 처리 성능과 정확도를 요구하는 환경에서 사용할 수 있습니다. 이 모델은 GPT-4V 및 GPT-4o와 비교해도 우수한 성능을 발휘합니다.

또한 LLaVA-OneVision은 이미지에서 비디오로의 작업전이(Task Transfer)를 통해 강력한 비디오 이해능력을 보여줍니다. 이는 AI가 한 영역에서 학습한 지식을 다른 관련 영역에 적용할 수 있다는 것을 의미하며, 이러한 접근방식을 통해 AI 시스템에서 새로운 능력이 '출현'할 수 있음을 시사합니다.

LLaVA-OneVision 특징 및 주요 기능

LLaVA-OneVision의 아키텍처는 LLaVA 시리즈에서 발전된 것으로, 다양한 시각적 신호를 처리할 수 있도록 확장되었습니다. 특히 비디오 이해와 시나리오 간 전이 학습을 통해 복잡한 컴퓨터 비전 작업에서도 우수한 성능을 보입니다. 또한, LLaVA-OneVision은 오픈소스로 공개되어 있으며, 학습 코드, 사전 학습된 모델 체크포인트(0.5B, 7B, 72B) 및 데이터셋을 제공하여 커뮤니티의 개발을 촉진하고 있습니다. 이를 통해 사용자는 모델을 직접 테스트하거나 추가 연구를 수행할 수 있습니다.

또한, SigLIP라는 비전 인코더를 사용해 이미지를 단어 임베딩 공간으로 변환하는데, 이를 통해 텍스트와 시각적 데이터를 통합하여 처리할 수 있습니다. 또 다른 특징으로는 Qwen-2 언어 모델을 사용한다는 점이 있습니다. 이 모델은 언어 처리 능력이 뛰어나고, 시각적 신호를 기반으로 한 질문에 답하는 성능이 우수합니다. 이를 통해 복잡한 시각적 정보를 해석하고 다양한 작업을 수행할 수 있습니다.

LLaVA-OneVision의 주요 특징 중 하나는 AnyRes 전략입니다. 이 전략은 이미지의 해상도와 토큰 수를 조정하여 시각적 데이터를 효과적으로 표현할 수 있게 합니다. 단일 이미지, 다중 이미지, 비디오와 같은 다양한 시나리오에서 토큰을 효율적으로 할당하여 성능과 비용을 균형 있게 유지합니다.

LLaVA-OneVision은 주요 기능은 다음과 같습니다.

- 단일 이미지 처리: LLaVA-OneVision은 고해상도 이미지 처리에서 우수한 성능을 발휘하며, 단일 이미지를 통해 세부적인 시각적 정보를 이해하고 분석할 수 있습니다.

- 다중 이미지 처리: 다중 이미지를 동시에 처리하여 이미지 간의 차이점이나 관계를 분석하는 능력을 가지고 있습니다. 이를 통해 복잡한 멀티이미지 시나리오에서도 효과적으로 사용할 수 있습니다.

- 비디오 분석: LLaVA-OneVision은 이미지 기반 전이 학습을 통해 비디오 데이터까지 처리할 수 있습니다. 비디오 프레임을 연속적으로 분석하여 행동 인식이나 장면 이해와 같은 작업을 수행합니다.

- 전이 학습: 모델은 다양한 시나리오 간의 학습 전이를 가능하게 하며, 이미지를 기반으로 비디오 처리 능력을 학습하는 등 새로운 기능을 획득합니다. 이러한 전이 학습은 모델의 범용성을 크게 확장시킵니다.

- 오픈소스 및 확장성: LLaVA-OneVision은 오픈소스 모델로, 학습 코드와 사전 학습된 체크포인트를 제공하여 누구나 모델을 활용하거나 확장할 수 있습니다. 커뮤니티가 참여할 수 있도록 모델, 데이터셋, 코드가 공개되어 있으며, 이를 통해 다양한 연구와 응용이 가능합니다.

LLaVA-OneVision은 이러한 기능을 바탕으로 다양한 멀티모달 시나리오에서 강력한 성능을 발휘하며, 특히 비디오 분석과 다중 이미지 처리에서 상용 모델에 필적하는 성능을 보여줍니다.

LLaVA-OneVision 벤치마크 결과

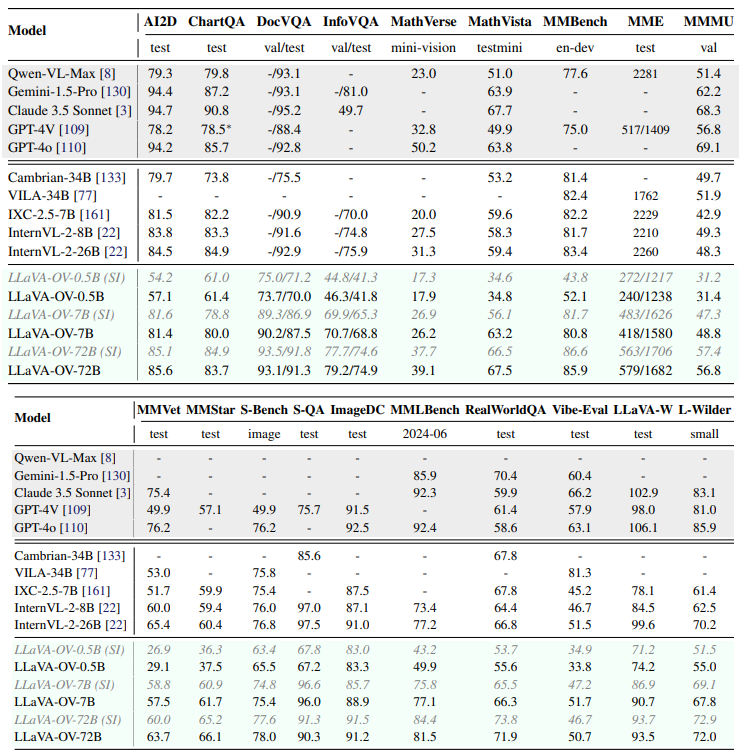

LLaVA-OneVision 모델은 전반적으로 다양한 벤치마크에서 강력한 성능을 보여줍니다. 특히, 멀티모달 및 비전-언어 벤치마크에서 상당한 개선을 보였습니다. 모델 크기가 커질수록 성능이 향상되는 경향을 보이며, LLaVA-OV-72B 모델은 대부분의 벤치마크에서 최상위권 성능을 달성했습니다.

주요 벤치마크 결과는 다음과 같습니다.

- ScienceQA: 90.2/87.5 (7B/72B)로 높은 점수를 기록하며 과학적 추론 능력을 입증했습니다.

- DocVQA: 93.1/93.1 (7B/72B)로 문서 이해 및 시각적 질의응답 능력에서 뛰어난 성적을 거두었습니다.

- MMBench: 85.9/81.5 (7B/72B)로 멀티모달 벤치마크에서도 경쟁력 있는 성능을 보였습니다.

- RealWorldQA: 70.4/71.9 (7B/72B)로 실제 환경 질의응답에서도 견고한 성능을 나타냈습니다.

- LLaVA-W: 90.7/93.5 (7B/72B)로 LLaVA 벤치마크에서도 높은 점수를 기록하며 멀티모달 대화 능력을 입증했습니다.

LLaVA-OV-72B 모델은 대부분의 벤치마크에서 LLaVA-OV-7B 모델보다 상당한 성능 향상을 보였습니다.

- 강점: 다양한 멀티모달 및 비전-언어 벤치마크에서 높은 성능을 달성했습니다. 모델 크기가 커짐에 따라 성능이 향상되는 경향을 보입니다. 과학적 추론, 문서 이해, 시각적 질의응답, 실제 환경 질의응답 등 다양한 작업에서 뛰어난 능력을 보여줍니다.

- 개선점: 일부 벤치마크에서는 다른 최상위 모델에 비해 성능이 약간 낮습니다. 모델 크기가 커짐에 따라 계산 비용이 증가합니다.

LLaVA-OneVision은 다양한 벤치마크에서 GPT-4V 및 GPT-4o와 같은 상용 모델들과 비교하여 경쟁력 있는 성능을 보여줍니다. 예를 들어, AI2D, ChartQA, DocVQA와 같은 단일 이미지 시나리오에서는 GPT-4V에 필적하는 성능을 보이며, 다중 이미지 및 비디오 시나리오에서는 우수한 전이 학습 능력을 통해 GPT-4V를 능가하는 결과를 보였습니다.

LLaVA-OneVision 테스트

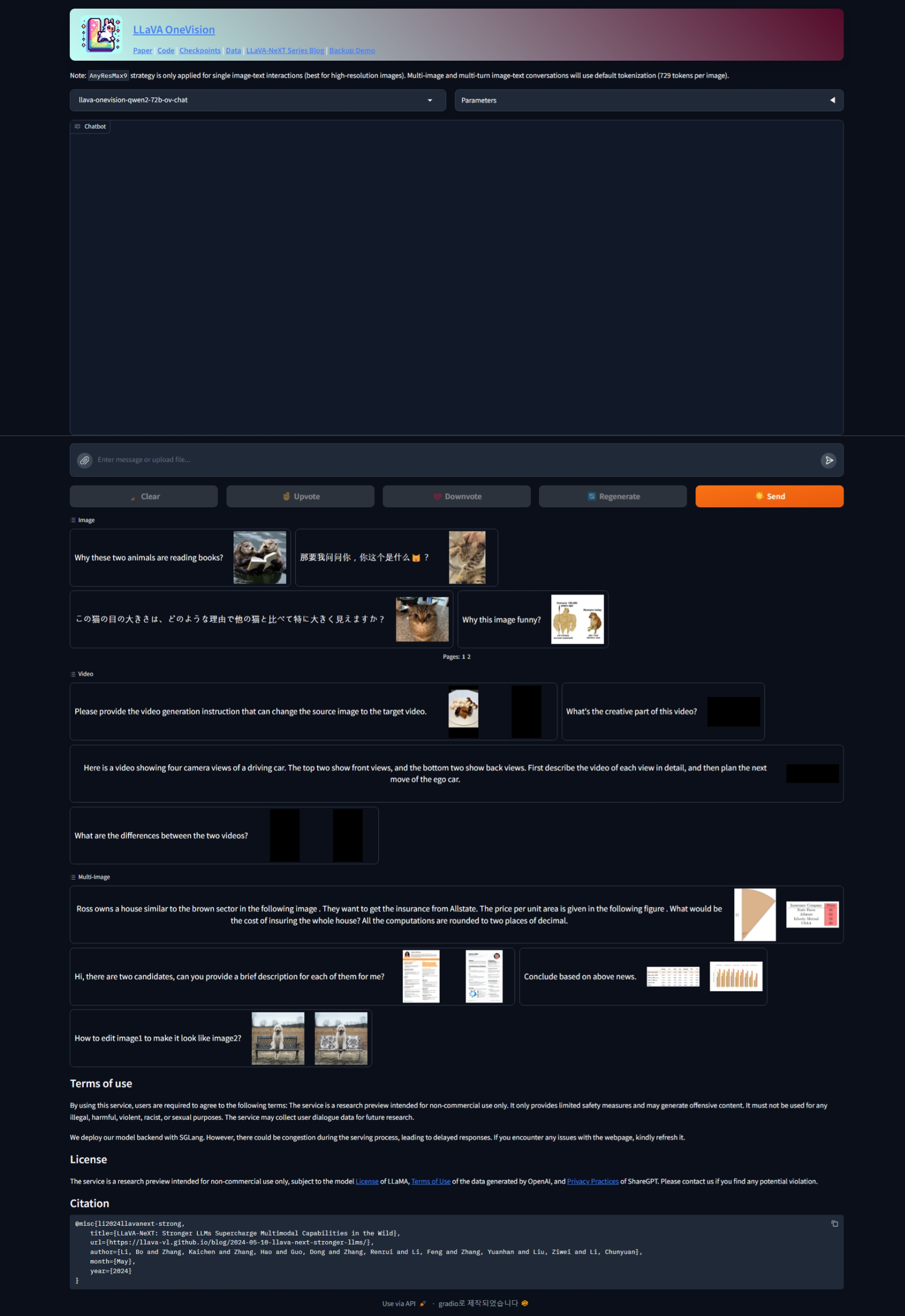

다음은 LLaVA-OneVision을 직접 테스트해 보겠습니다. 테스트 모델은 llava-onevision-qwen2-72b-ov-chat 모델이며, 테스트는 LLaVA-OneVision 데모 웹 사이트에서 진행하였습니다.

https://llava-onevision.lmms-lab.com/

Gradio

Build & Share Delightful Machine Learning Apps

www.gradio.app

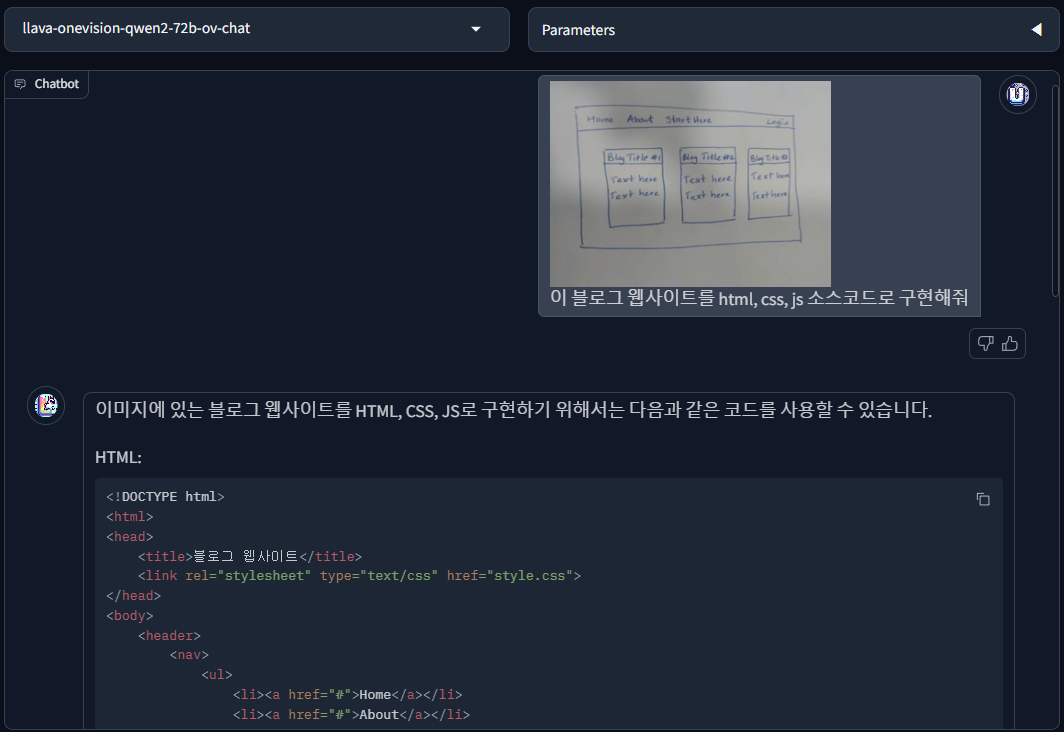

1. 논리적 사고 및 프로그래밍 테스트: 손으로 그린 웹사이트 디자인을 HTML과 CSS 코드로 구현하는 테스트입니다.

| Here's a design for blogging website. Provide the working source code for the website using HTML, CSS and JavaScript as required.(여기 블로깅 웹사이트를 위한 디자인이 있습니다. 필요한 경우 HTML, CSS 및 JavaScript를 사용하여 웹사이트의 작동하는 소스 코드를 제공하십시오.) | |

|

|

테스트 결과, LLaVA-OneVision은 원래 디자인과는 좀 다르지만, 꽤 유사한 웹사이트를 만들었습니다.

2. 시각적 질의응답 테스트: 이미지 이해 및 분석능력을 평가하는 테스트입니다.

| "왜 이 두 동물들이 책을 읽고 있을까요?" | "이 고양이의 눈이 큰 이유는 어떤 이유로 다른 고양이에 비해 특히 크게 보입니까?" |

|

|

| "이 이미지는 창의적이고 유머러스한 묘사로, 아마도 엔터테인먼트 목적으로 편집되거나 연출된 것 같습니다. 현실에서 수달은 책을 읽을 수 있는 인지 능력이 없습니다. 이 장면은 기발하고 재미있게 보이도록 의도된 것으로, 동물들을 인간과 같은 상황에 배치하여 재미와 호기심을 불러일으키려는 것입니다. 이는 보는 사람들을 즐겁게 하고 자연 세계에 대한 경이로움을 느끼게 하려는 목적이 있을 수 있으며, 동시에 동물의 지능과 행동에 대해 생각해보게 할 수도 있습니다." | "고양이의 눈이 특히 크게 보이는 이유에는 여러 가지 요인이 있습니다. 고양이의 품종에 따라 다르지만, 일부 품종은 유전적으로 눈이 큰 특징이 있습니다. 예를 들어, Ragdoll이나 British Shorthair 등의 품종은 그 특징적인 큰 눈으로 알려져 있습니다. 또한, 고양이의 눈은 그 모양이나 얼굴의 크기에 따라 더 크게 보일 수 있습니다. 이 고양이의 경우, 얼굴에 비해 눈이 크게 보이는 것 같습니다. 또한 유전적 특성이나 개체차에 의한 가능성도 있습니다. 다만, 고양이 눈이 비정상적으로 크게 보이는 경우에는, 건강상의 문제가 원인일 가능성도 있습니다. 그러니 눈의 크기나 상태에 대해 걱정된다면 수의사와 상담하는 것이 중요합니다." |

시각적 질의 응답 테스트 결과, LLaVA-OneVision의 이미지 이해 및 분석능력은 매우 정확했습니다.

3. 다국어 및 비디오 이해능력 테스트: 다국어 이해와 비디오 영상분석 기능을 테스트합니다.

| "자, 내가 당신에게 묻겠습니다. 이것은 무엇입니까? 🦊" | "이 영상의 창의적인 부분은 무엇인가요?" |

|

|

| "이것은 긴코너구리(civet)입니다. 아시아 팜 시벳 또는 토디(toddy) 고양이라고도 불립니다. 이들은 독특한 무늬의 털가죽으로 유명하며, 이 털가죽은 그들이 야생 환경에서 매우 좋은 위장 효과를 가지게 합니다. 긴코너구리는 중등 크기의 야생 고양이과 동물로, 주로 남아시아와 동남아시아 지역에 분포합니다. 그들은 야행성 동물이며, 작은 포유류, 조류, 파충류와 양서류, 그리고 과일을 먹고 삽니다. 긴코너구리는 일부 지역에서 애완동물로 키워지기도 하지만, 그들은 여전히 야생 동물이며 적절한 보호와 돌봄이 필요합니다." | "이 영상의 창의적인 부분은 도시 경관이 수중에 잠겨 있는 초현실적이고 상상력 넘치는 개념입니다. 다양한 종류의 물고기와 해양 생물들이 마천루 사이를 자유롭게 헤엄치고 있습니다. 이 영상은 육지와 바다의 경계가 모호해진 세계에 대한 환상적이고 디스토피아적인 비전을 제시하며, 독특하고 매력적인 시각적 경험을 만들어냅니다. 선명한 색상의 사용과 역동적인 움직임은 영상의 전반적인 창의성과 예술적 표현에 더해집니다." |

LLaVA-OneVision의 다국어 및 비디오 분석 성능은 정확하고, 뛰어난 표현력을 보여주었습니다.

4. 다중 이미지 분석 테스트: 이미지 간의 차이점이나 관계를 분석하는 능력을 테스트합니다.

| Ross는 다음 이미지의 갈색 부문과 유사한 집을 소유하고 있습니다 . 그들은 Allstate에서 보험을 받고 싶어합니다. 단위 면적당 가격은 다음 그림에 나와 있습니다 . 집 전체를 보험에 가입하는 데 드는 비용은 얼마입니까? 모든 계산은 소수점 두 자리로 반올림됩니다. |

|

|

| 집 전체를 보험에 가입하는 비용을 계산하려면 먼저 부채꼴의 면적을 계산한 다음, 단위 면적당 가격을 곱해야 합니다. 먼저 부채꼴의 면적을 구해보겠습니다. 부채꼴 면적의 공식은 다음과 같습니다: \[ A = \frac{1}{2} r^2 \theta \] 여기서 \( r \)은 반지름, \( \theta \)는 라디안으로 표현된 각도입니다. 반지름 \( r = 11 \) 단위, 각도 \( \theta = 40^\circ \)이 주어졌으므로, 각도를 라디안으로 변환해야 합니다: \[ \theta = 40^\circ \times \frac{\pi}{180^\circ} = \frac{2\pi}{9} \] 이제 면적을 계산할 수 있습니다: \[ A = \frac{1}{2} \times 11^2 \times \frac{2\pi}{9} = \frac{121\pi}{9} \approx 42.46 \] 따라서 부채꼴의 면적은 약 42.46 제곱 단위입니다. 다음으로, Allstate 보험사의 단위 면적당 가격을 구해야 합니다. 주어진 이미지에 따르면, Allstate의 단위 면적당 가격은 $63입니다. 마지막으로 집 전체를 보험에 가입하는 총 비용을 계산할 수 있습니다: \[ \text{비용} = \text{면적} \times \text{단위 면적당 가격} = 42.46 \times 63 \approx 2675.18 \] 따라서 Allstate 보험사에서 집 전체를 보험에 가입하는 비용은 약 $2675.18이 될 것입니다. (정답)부채꼴의 면적 = (π r² θ) / 360° = (121π 40) / 360 = 121π / 9 ≈ 42.24 제곱미터, Allstate의 보험 가격은 단위 면적당 63달러입니다. 따라서 전체 보험 비용 계산: 42.24 x 63 = 2661.12달러. 문제에서 소수점 둘째 자리까지 반올림하라고 했으므로, 최종 답은 2661.12달러입니다. 따라서, Ross의 집 전체를 Allstate로 보험 들이는 정확한 비용은 2661.12달러입니다. |

테스트 결과, LLaVA-OneVision은 단일 이미지 시각적 질의응답과 다국어 및 비디오 이해 능력에서 높은 성능을 발휘하였으며, 프로그래밍 능력과 수학적 계산은 좀 더 개선이 필요한 것으로 보입니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

맺음말

LLaVA-OneVision은 오픈소스 멀티모달 모델로서 단일 이미지, 다중 이미지, 비디오 분석 벤치마크에서 뛰어난 성능을 자랑하며, AI 연구와 개발에 큰 잠재력을 보여주고 있습니다. 이미지 기반 전이 학습을 통해 비디오 처리 능력까지 확장한 이 모델은 다양한 시나리오에서 높은 정확도와 효율성을 발휘합니다.

LLaVA-OneVision을 테스트해 본 후기는 다음과 같습니다.

- 다중 이미지 인식, 비디오 분석 등 멀티모달 모델의 새로운 가능성을 보여준다.

- 모델의 복잡성, 라이브러리 충돌 등으로 아직 로컬 구현이 어렵다.

- 수학과 코딩 능력은 좀 더 개선이 필요하다.

오늘은 오픈소스 멀티모달의 새로운 가능성을 보여주는 LLaVA-OneVision에 대해 알아보았는데요. 여러분도 데모 웹사이트에서 다중 이미지나 비디오 파일을 통해 모델을 테스트해 보시면 좋은 경험이 되실것 같습니다. 저는 그럼 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.06.25 - [AI 언어 모델] - CoLLaVO: 카이스트의 최첨단 시각-언어 모델 분석 및 테스트👀💬🔍

CoLLaVO: 카이스트의 최첨단 시각-언어 모델 분석 및 테스트👀💬🔍

안녕하세요! 오늘은 최근 카이스트에서 개발한 국산 시각-언어 모델 CoLLaVO에 대해 알아보겠습니다. CoLLaVO 모델은 입력 이미지를 분석하여 객체의 의미 정보와 위치 정보를 추출하는 역할을 하는

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| 🌟업스테이지 Solar Pro Preview 분석: 단일 GPU 최강 AI 모델 (27) | 2024.09.16 |

|---|---|

| 🤖DeepSeek V2.5: 대화와 코딩 능력을 하나로 통합한 차세대 AI 모델 (24) | 2024.09.11 |

| Qwen2-VL: 👁️알리바바의 오픈소스 비전 언어모델 (32) | 2024.09.03 |

| 🎥CogVideoX: 최초의 오픈소스 비디오 생성 AI (22) | 2024.08.30 |

| 🤖마이크로소프트 Phi-3.5 시리즈: 소형 MoE 모델의 혁신 (13) | 2024.08.24 |