안녕하세요! 오늘은 마이크로소프트가 발표한 최신 인공지능 모델, Phi-4-multimodal과 Phi-4-mini에 대해 알아보겠습니다. Phi-4-multimodal은 음성, 시각, 텍스트 데이터를 단일 아키텍처에서 통합적으로 처리할 수 있는 모델로, 다양한 입력을 동시에 분석하고 활용할 수 있으며, Phi-4-mini는 38억 개의 파라미터를 갖춘 경량 모델이면서도, 속도와 효율성을 극대화하여 텍스트 기반 작업에서 대형 모델과 견줄 만큼 우수한 성능을 제공합니다. 이번 블로그에서는 Phi-4 시리즈의 주요 특징과 성능, 벤치마크 결과를 살펴보고, 실제 성능을 테스트하고 분석해 보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

1. 개요

Phi-4-multimodal은 Microsoft의 첫 번째 multimodal 언어 모델로, 56억 개의 파라미터를 가지고 있으며, 음성, 시각, 텍스트를 단일 아키텍처로 통합하여 동시에 처리할 수 있습니다. 이 모델은 텍스트, 오디오, 시각 입력을 단일 시스템으로 처리하여 별도의 파이프라인 없이 다양한 입력을 지원하고, 더 큰 어휘와 다국어 기능을 갖추어 확장성과 효율성이 향상되었으며, 자동 음성 인식(ASR) 및 음성 번역(ST) 성능에서 전문 모델을 능가합니다. 또한, 수학 및 과학 추론, OCR, 차트 이해 등의 시각적 기능에서도 높은 경쟁력을 보입니다.

Phi-4-mini는 38억 개의 파라미터를 가진 모델로, 속도와 효율성을 위해 설계되었으며, 텍스트 기반 작업에서 더 큰 모델보다 뛰어난 성능을 제공합니다. 이 모델은 추론, 수학, 코딩, 지시 수행, 함수 호출 등에서 뛰어난 성능을 발휘하며, 표준화된 프로토콜을 활용한 함수 호출로 외부 지식과 기능에 접근할 수 있습니다. 또한, 최대 128,000개의 토큰을 지원하여 긴 텍스트 처리 능력이 뛰어납니다.

https://azure.microsoft.com/en-us/blog/empowering-innovation-the-next-generation-of-the-phi-family/

Empowering innovation: The next generation of the Phi family | Microsoft Azure Blog

We are excited to announce Phi-4-multimodal and Phi-4-mini, the newest models in Microsoft’s Phi family of small language models. Learn more.

azure.microsoft.com

2. 특징 및 주요 기능

Phi-4-multimodal

- 다중 모드 통합 모델: Phi-4-multimodal은 음성, 시각 및 언어를 포함하는 단일 모델로, 모두 동일한 표현 공간 내에서 동시에 처리됩니다. 그 결과 텍스트, 오디오 및 시각적 입력을 처리할 수 있는 단일 통합 모델이 탄생하여 다양한 모드에 대한 복잡한 파이프라인이나 별도의 모델이 필요하지 않습니다.

- 새로운 아키텍처: Phi-4-multimodal은 LoRA(Low-Rank Adapters) 혼합 디자인으로 다양한 modality(이미지, 음성, 테스트) 간 상호 작용을 처리합니다. SigLIP 기반의 이미지 인코더와 Conformer 기반의 오디오 인코더를 사용하여 각 modality의 특징을 추출하고, LoRA를 통해 모델을 유연하게 조정합니다.

- 다양한 작업 지원: 단일/다중 이미지 QA/요약, 비디오 QA/요약, 시각-음성 작업, 음성 QA/요약/번역/인식 및 오디오 이해를 포함한 광범위한 작업을 지원합니다.

Phi-4-mini

- 컴팩트한 크기: 38억 개의 파라미터를 가진 모델로 200,000개의 어휘 및 입력-출력 임베딩 공유를 특징으로 합니다.

- 아키텍처: 토큰 정보와 값을 저장하는 KV cache 사용량을 최적화하여 장문 생성의 효율성을 높이는 Attention 메커니즘인 Group Query Attention을 갖춘 디코더 전용 트랜스포머 아키텍처를 기반으로 합니다

- 텍스트 기반 작업: 추론, 수학, 코딩, 명령 따르기 및 기능 호출을 포함한 텍스트 기반 작업에서 더 큰 파라미터를 가진 모델보다 뛰어난 성능을 유지합니다.

- 긴 시퀀스 지원: 최대 128,000개의 토큰 시퀀스를 지원하여 높은 정확도와 확장성을 제공하므로 고급 AI 애플리케이션을 위한 강력한 솔루션입니다.

3. 벤치마크 결과

Phi-4-multimodal

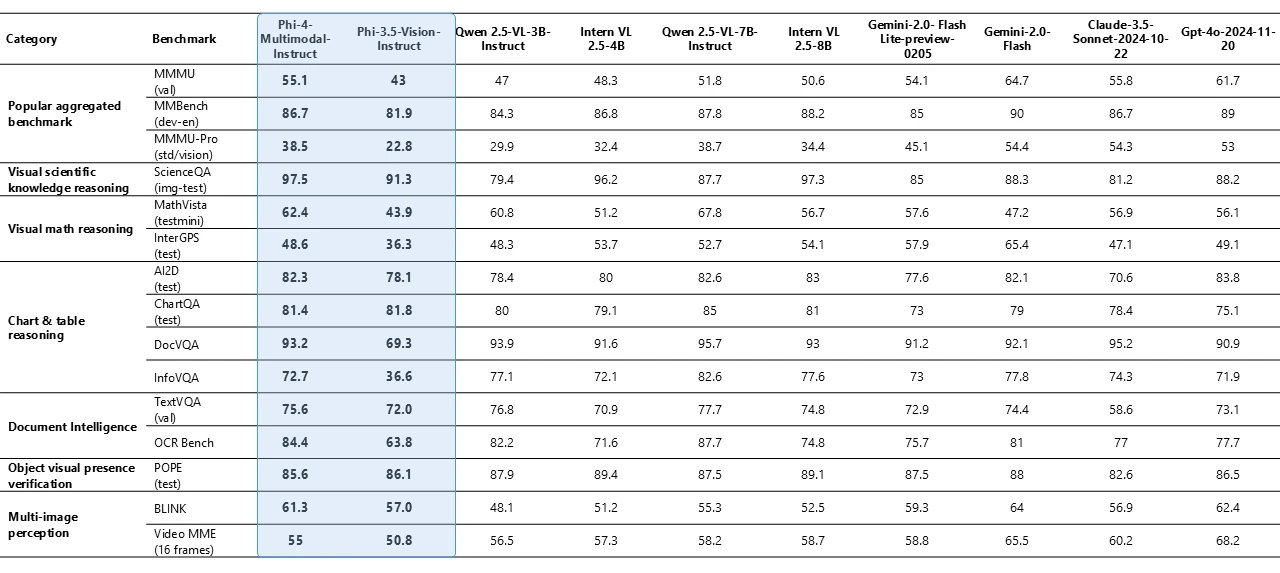

- 시각-언어 벤치마크: Phi-4-multimodal은 이전 모델인 Phi-3.5-Vision보다 크게 개선되었으며, 동급 모델 중 뛰어난 성능을 보입니다. 특히 차트 이해와 과학적 추론에서 Gemini, GPT-4o 등 일부 폐쇄형 모델을 능가합니다. 주요 성능 지표는 MMMU 55.1점, MMBench 86.7점, ScienceQA 97.5점, ChartQA 81.4점입니다. 또한, DocVQA 93.2점, InfoVQA 72.7점으로 데이터 해석에서 강점을 보였고, OCRBench 84.4점으로 문서 처리 능력을 입증했습니다. POPE 85.6점, BLINK 61.3점을 기록하며 다중 이미지 처리에서도 우수한 성능을 보였습니다.

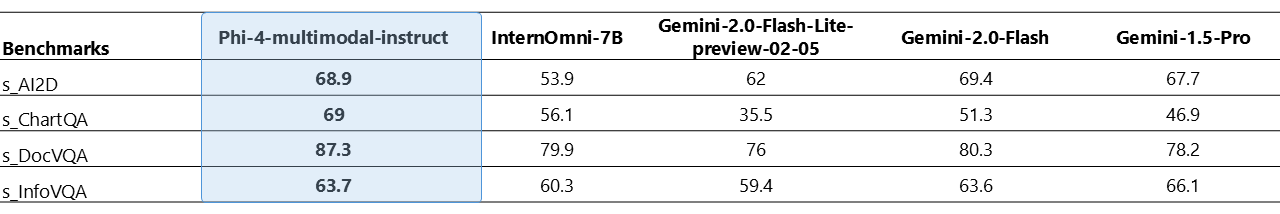

- 시각-음성 벤치마크: InternOmni 및 Gemini-2.0-Flash보다 훨씬 뛰어난 성능을 보이며, 이는 더 큰 모델 크기를 가지고 있습니다. 예를 들어 ShareGPT4o AI2D 및 ShareGPT4o ChartQA 벤치마크에서 Phi-4-multimodal은 InternOmni보다 10점 이상 높은 성능을 달성합니다.

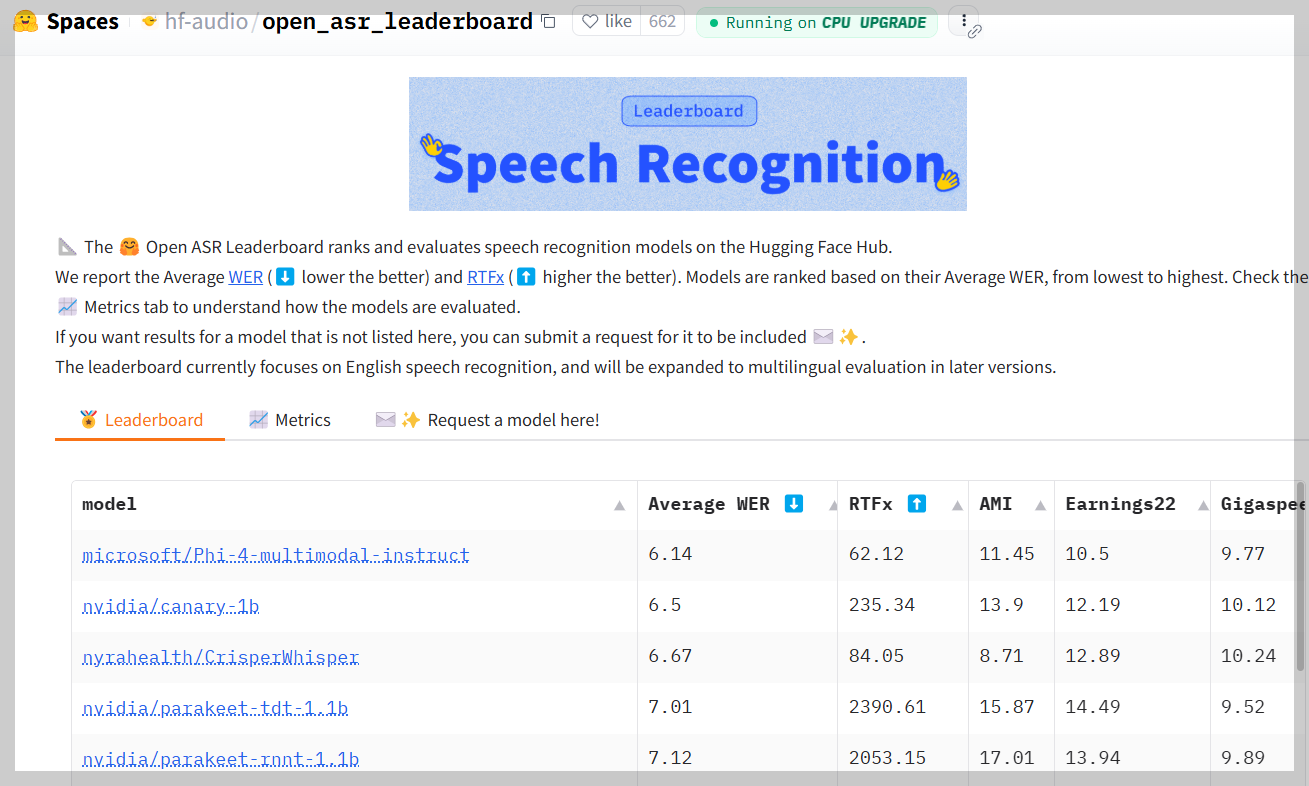

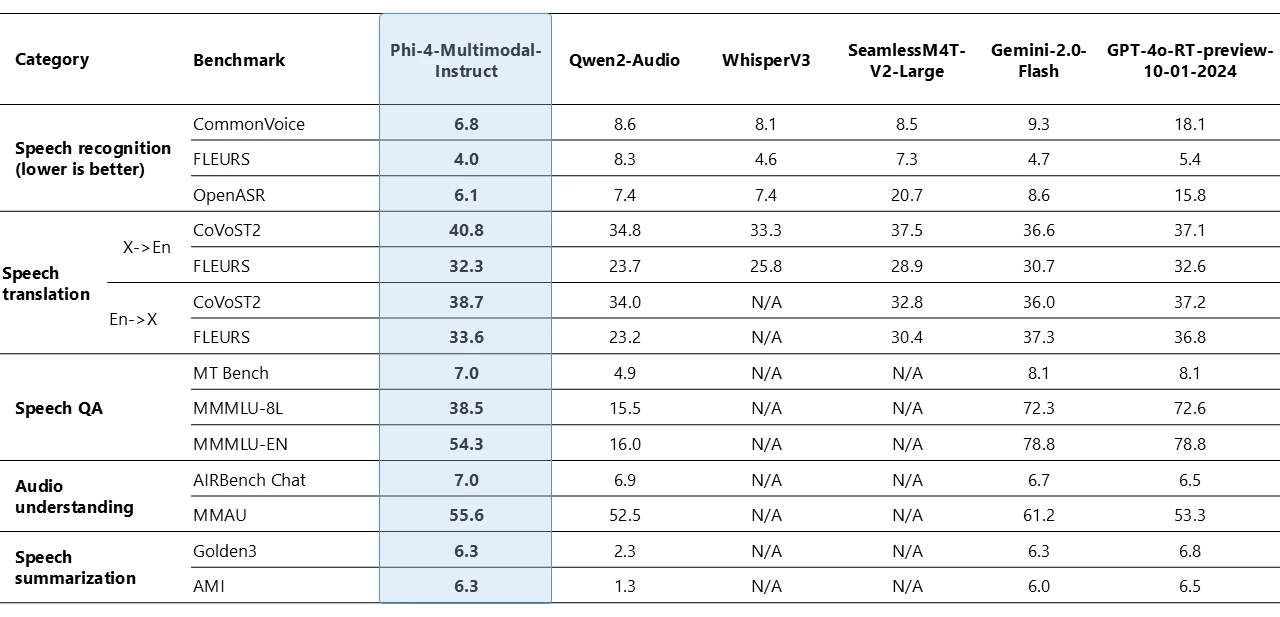

- 음성 관련 작업: ASR(자동 음성 인식) 및 ST(음성 번역) 모두에서 WhisperV3 및 SeamlessM4T-v2-Large와 같은 전문 모델보다 뛰어난 성능을 보입니다. 이 모델은 Huggingface OpenASR 리더보드에서 6.14%의 단어 오류율로 1위를 차지했으며, 2025년 2월 현재 이전 최고 성능인 6.5%를 넘어섰습니다. 또한 음성 요약을 성공적으로 구현하고 GPT-4o 모델과 비슷한 성능 수준을 달성한 몇 안 되는 개방형 모델 중 하나입니다.

Phi-4-mini

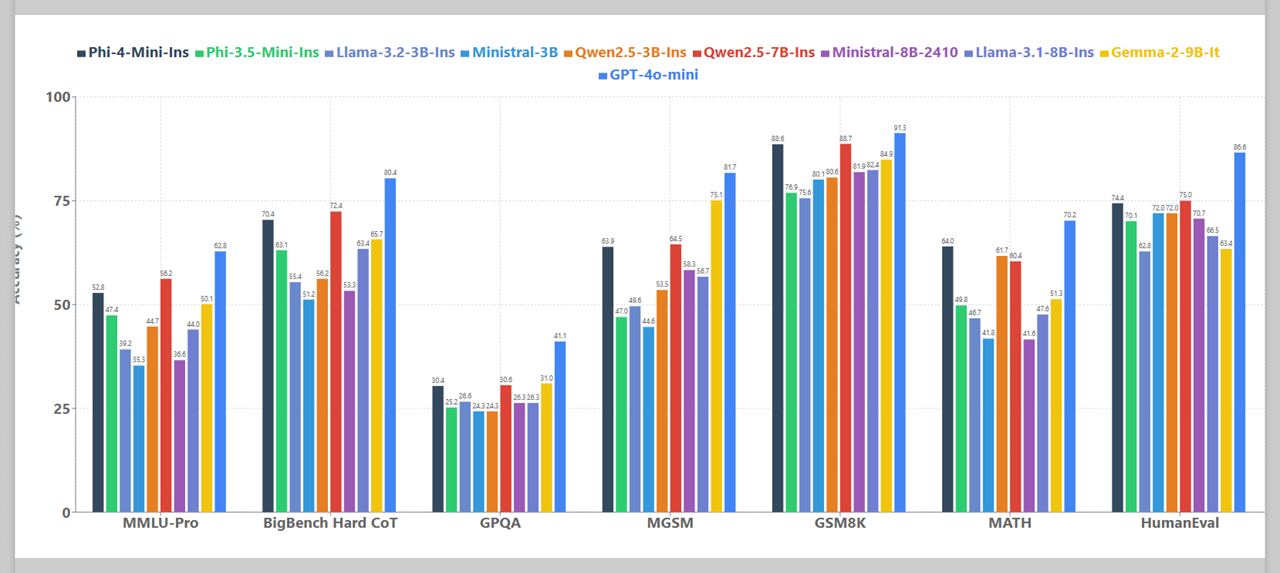

- 전반적인 성능: 다양한 언어 이해 벤치마크에서 Phi-4-mini는 유사한 크기의 모델보다 뛰어난 성능을 보이며 2배 더 큰 모델과 비슷한 수준입니다. 특히 Phi-4-mini는 유사한 크기의 모델뿐만 아니라 대부분의 더 큰 모델보다 큰 차이로 뛰어난 성능을 보입니다.

- 수학 및 추론 기능: Phi-4-mini는 수학 및 추론 관련 벤치마크에서 뛰어난 성능을 보입니다. 수학 벤치마크의 경우 모델은 유사한 크기의 모델보다 훨씬 뛰어난 성능을 보이며 때로는 20점 이상 더 높습니다. 또한 2배 더 큰 모델의 점수보다 뛰어난 성능을 보입니다.

- 코딩 성능: Phi-4-mini의 강력한 추론 기능은 코딩 작업에서도 나타납니다. HumanEval 벤치마크에서 Phi-4- mini는 유사한 크기 및 2배 더 큰 크기의 모델 대부분보다 뛰어난 성능을 보입니다. 하지만 실 사용은 벤치마크 결과와 다를 수 있습니다.

4. 성능 테스트

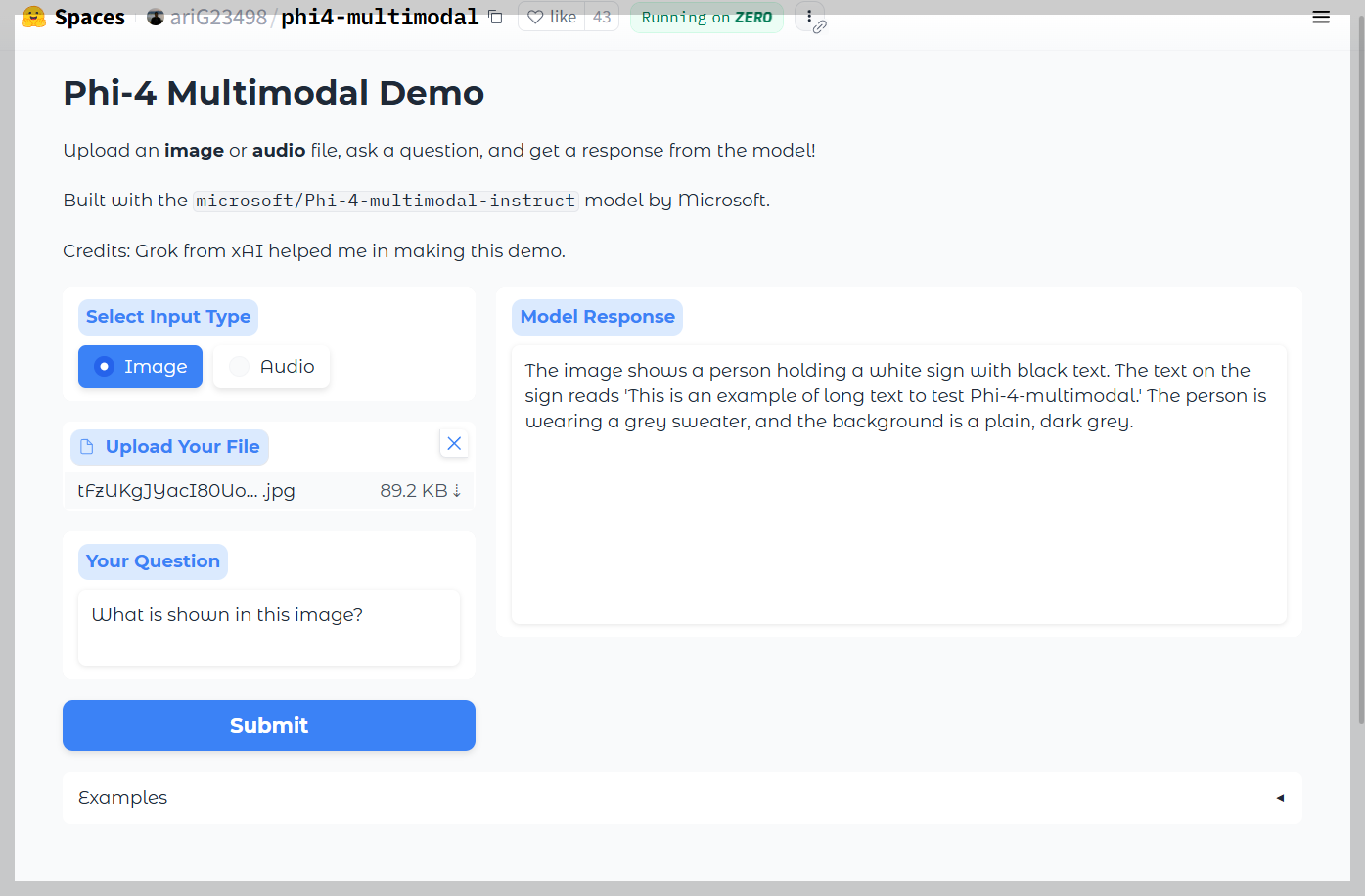

먼저, Phi-4-multimodal의 성능을 테스트해 보겠습니다. 테스트는 허깅페이스 스페이스 ariG23498 사용자의 Phi-4 Multimodal Demo를 활용해서 이미지/그래프/표 인식, 글자 추출 및 코딩성능을 테스트하였습니다.

|

| 질문) What is shown in this image? 답변) The image shows a person holding a white sign with black text. The text on the sign reads 'This is an example of long text to test Phi-4-multimodal.' The person is wearing a grey sweater, and the background is a plain, dark grey. 이미지는 검은색 텍스트가 있는 흰색 표지판을 들고 있는 사람을 보여줍니다. 표지판의 텍스트는 'This is an example of long text to test Phi-4-multimodal'이라고 적혀 있습니다. 이 사람은 회색 스웨터를 입고 있으며, 배경은 평범하고 어두운 회색입니다.- 정답 |

|

| 질문) Analyze the benchmark results of the Phi-4-mini-ins model 답변) The Phi-4-mini-ins model shows varying performance across different benchmarks. It performs best on the MATH benchmark with an accuracy of 70.2%, and its lowest performance is on the GPQA benchmark with an accuracy of 24.3%. Phi-4-mini-ins 모델은 다양한 벤치마크에서 다양한 성능을 보입니다. MATH 벤치마크에서 70.2%의 정확도로 가장 우수한 성능을 보이며, GPQA 벤치마크에서는 24.3%의 정확도로 가장 낮은 성능을 보입니다. - 오답(막대색깔 및 모델구분 오류) |

|

| 질문) Analyze the benchmark results of the Phi-4-multimodal-ins model 답변) The benchmark results of the Phi-4-multimodal-ins model are as follows: Popular aggregated benchmark: 55.1, Visual scientific knowledge reasoning: 97.5, Visual math reasoning: 62.4, Chart & table reasoning: 81.4, Document intelligence: 93.2, Object visual presence: 85.6, Multi-image perception: 61.3, Video MME: 55. Phi-4-multimodal-ins 모델의 벤치마크 결과는 다음과 같습니다: 인기 있는 집계된 벤치마크: 55.1, 시각적 과학적 지식 추론: 97.5, 시각적 수학 추론: 62.4, 차트 및 테이블 추론: 81.4, 문서 지능: 93.2, 객체 시각적 존재: 85.6, 다중 이미지 인식: 61.3, 비디오 MME: 55. - 정답 |

|

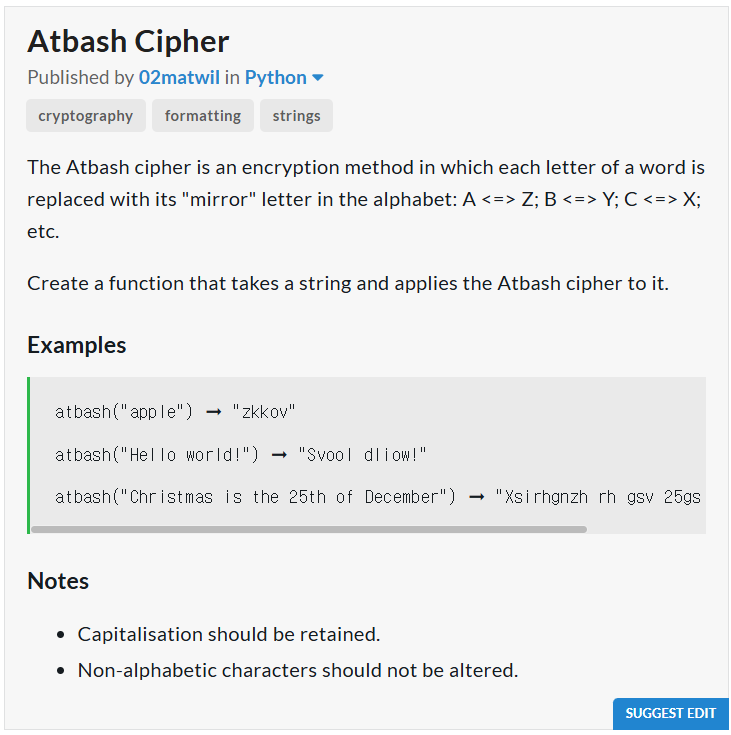

| 질문) Generate python code with no external library from the image 답변) def atbash_cipher(text): alphabet = "abcdefghijklmnopqrstuvwxyz" mirror = alphabet[::-1] result = "" for char in text: if char.isalpha(): if char.isupper(): result += mirror[ord(char) - ord('A')].upper() else: result += mirror[ord(char) - ord('a')] else: result += char return result - 정답 |

|

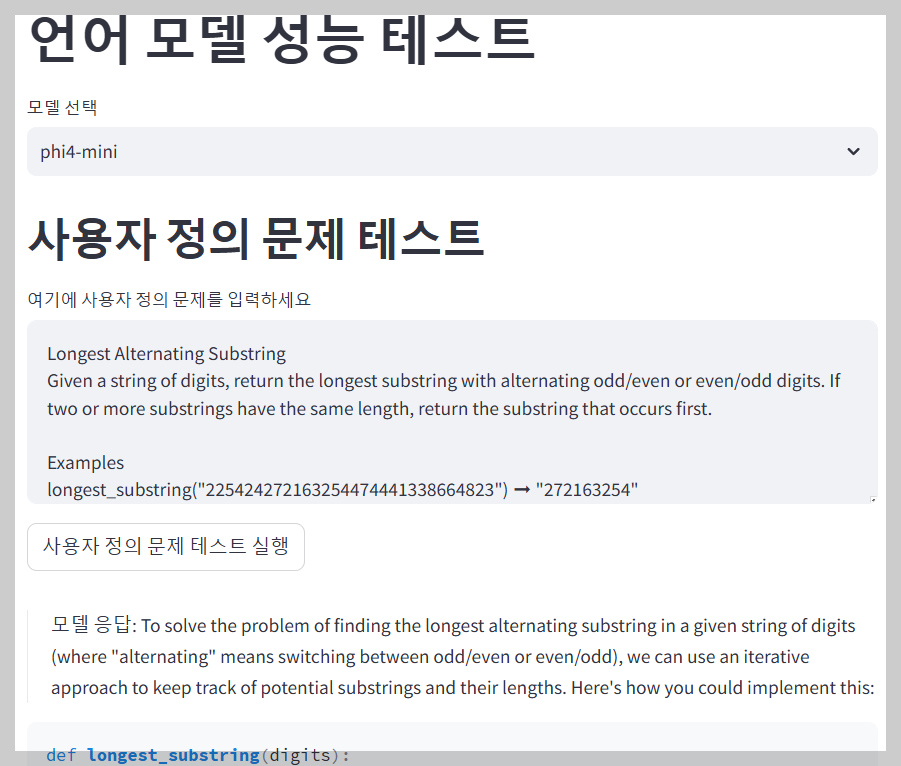

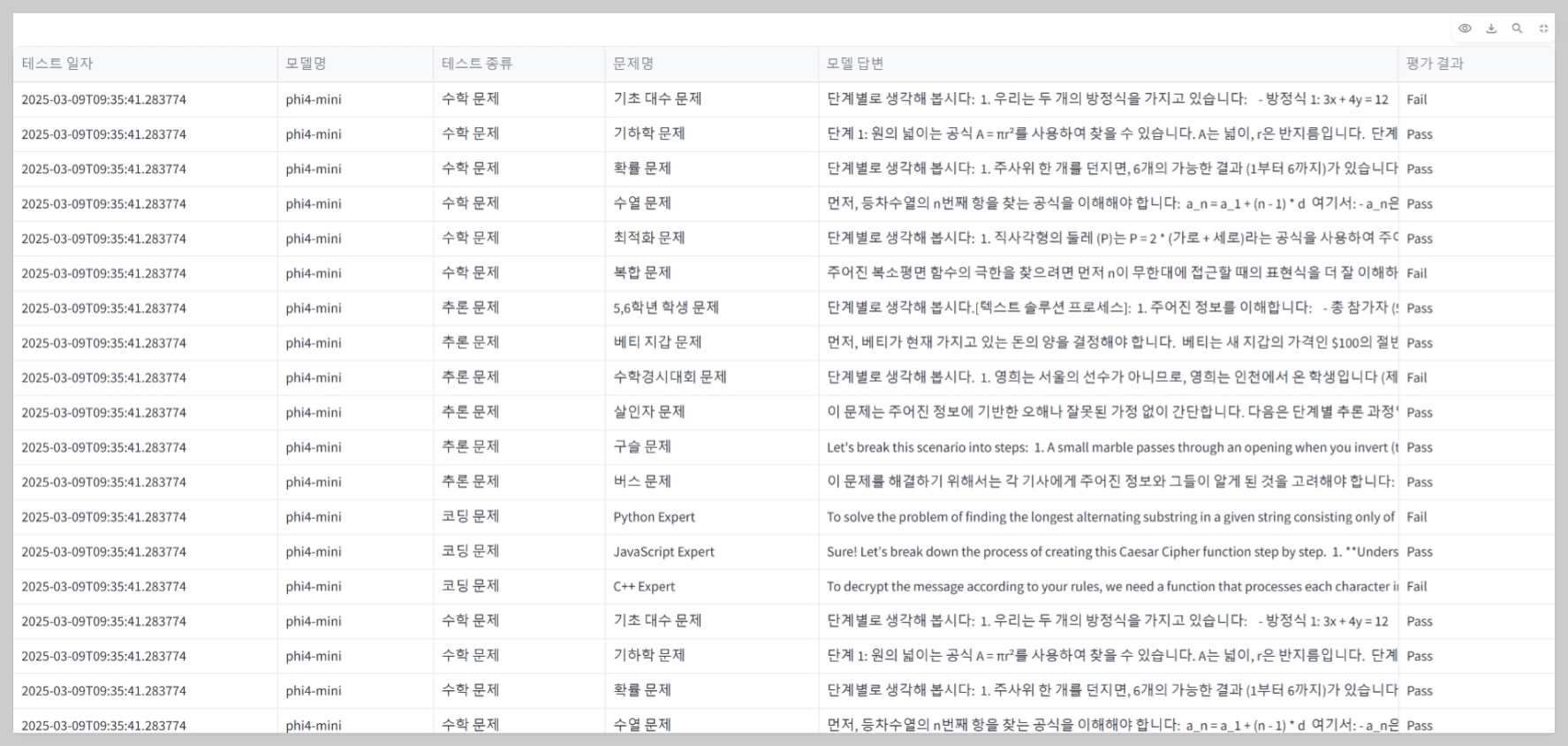

Phi4-mini 모델 테스트는 ollama.com에서 양자화 모델(Q4_K_M, 2.5GB)을 다운로드하여 자체 개발한 테스트 프로그램으로 코딩, 수학, 추론 성능을 테스트하였습니다.

1) 코딩 테스트

| Phi-4-mini | Medium | Hard | Very Hard | Expert |

| Python | Pass | Pass | Pass | Fail |

| JavaScript | Pass | Pass | Fail | Pass |

| C++ | Pass | Fail | Pass | Fail |

코딩 테스트에서 Phi-4-mini는 Python Expert, JavaScript Very Hard, C++ Hard/Expert 난이도를 성공하지 못하였습니다.

2) 수학 테스트

| No. | 문제 구분 | 문제 | Phi-4-mini |

| 1 | 기초 대수 문제 | 두 숫자 𝑥 x와 𝑦 y가 있습니다. 이들이 만족하는 식은 3 𝑥 + 4 𝑦 = 12 3x+4y=12이며, 𝑥 − 2 𝑦 = 1 x−2y=1입니다. 𝑥 x와 𝑦 y의 값을 구하세요 | Pass |

| 2 | 기하학 문제 | 반지름이 7cm인 원의 넓이를 구하세요. 𝜋 = 3.14159 π=3.14159로 계산하세요. | Pass |

| 3 | 확률 문제 | 주사위를 두 번 던졌을 때, 두 숫자의 합이 7이 될 확률을 구하세요. | Pass |

| 4 | 수열 문제 | 첫 번째 항이 3이고, 공차가 5인 등차수열의 10번째 항을 구하세요. | Pass |

| 5 | 최적화 문제 | 어떤 직사각형의 둘레가 36cm입니다. 이 직사각형의 넓이를 최대화하려면 가로와 세로의 길이는 각각 얼마여야 하나요? | Pass |

| 6 | 복합 문제 | 복소평면에서 다음 극한값을 구하시오. lim[n→∞] (1 + i/n)^(n^2) 여기서 i는 허수단위 (i^2 = -1)입니다. | Pass |

수학 테스트에서 Phi-4-mini는 기초 대수, 기하학, 확률, 수열, 최적화, 복합문제 등 6문제를 모두 성공하였습니다.

3) 추론 테스트

| No. | 문제 | Phi-4-mini |

| 1 | 5학년과 6학년 학생 160명이 나무 심기에 참가하였습니다. 6학년 학생들이 각각 평균5그루,5학년 학생들이 각각 평균 3그루씩 심은 결과 모두 560그루를 심었습니다. 나무심기에 참가한 5,6학년 학생은 각각 몇명일까요? |

Pass |

| 2 | 베티는 새 지갑을 위해 돈을 모으고 있습니다. 새 지갑의 가격은 $100입니다. 베티는 필요한 돈의 절반만 가지고 있습니다. 그녀의 부모는 그 목적을 위해 $15를 주기로 결정했고, 할아버지와 할머니는 그녀의 부모들의 두 배를 줍니다. 베티가 지갑을 사기 위해 더 얼마나 많은 돈이 필요한가요? | Pass |

| 3 | 전국 초등학생 수학경시대회가 열렸는데 영희,철수,진호 세사람이 참가했습니다. 그들은 서울,부산,인천에서 온 학생이고 각각 1등,2등,3등 상을 받았습니다. 다음과 같은 사항을 알고 있을때 진호는 어디에서 온 학생이고 몇등을 했습니까? 1) 영희는 서울의 선수가 아닙니다. 2) 철수는 부산의 선수가 아닙니다. 3)서울의 선수는 1등이 아닙니다. 4) 부산의 선수는 2등을 했습니다. 5)철수는 3등이 아닙니다. | Pass |

| 4 | 방 안에는 살인자가 세 명 있습니다. 어떤 사람이 방에 들어와 그중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 남아 있는 살인자는 몇 명입니까? 단계별로 추론 과정을 설명하세요. | Fail |

| 5 | A marble is put in a glass. The glass is then turned upside down and put on a table. Then the glass is picked up and put in a microwave. Where's the marble? Explain your reasoning step by step. | Fail |

| 6 | 도로에 5대의 큰 버스가 차례로 세워져 있는데 각 차의 뒤에 모두 차의 목적지가 적혀져 있습니다. 기사들은 이 5대 차 중 2대는 A시로 가고, 나머지 3대는 B시로 간다는 사실을 알고 있지만 앞의 차의 목적지만 볼 수 있습니다. 안내원은 이 몇 분의 기사들이 모두 총명할 것으로 생각하고 그들의 차가 어느 도시로 가야 하는지 목적지를 알려 주지 않고 그들에게 맞혀 보라고 하였습니다. 먼저 세번째 기사에게 자신의 목적지를 맞혀 보라고 하였더니 그는 앞의 두 차에 붙여 놓은 표시를 보고 말하기를 "모르겠습니다." 라고 말하였습니다. 이것을 들은 두번째 기사도 곰곰히 생각해 보더니 "모르겠습니다." 라고 말하였습니다. 두명의 기사의 이야기를 들은 첫번째 기사는 곰곰히 생각하더니 자신의 목적지를 정확하게 말하였습니다. 첫번째 기사가 말한 목적지는 어디입니까? | Pass |

Phi-4-mini는 추론테스트에서 수학경시대회 문제, 살인자 문제, 구슬문제를 성공하지 못하였습니다.

종합 테스트결과를 유사한 크기의 Qwen-2.5-3B와 비교한 결과는 아래와 같습니다.

| 구분 | 코딩 테스트 결과 | 수학 테스트 결과 | 추론 테스트 결과 | 평균 |

| Phi-4-mini-3.8B(Q4_K_M, 2.5GB) | 66.67 | 100 | 66.67 | 77.78 |

| Qwen-2.5-3B(Q4_K_M, 1.9GB) | 75 | 83.33 | 66.67 | 75 |

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

5. 맺음말

Microsoft의 Phi-4-multimodal 및 Phi-4-mini는 다양한 분야에서 혁신적인 AI 솔루션을 개발할 수 있는 가능성을 제시합니다. 특히 Phi-4-multimodal이 음성, 시각, 텍스트 데이터를 단일 아키텍처에서 통합적으로 처리하는 점, 그리고 Phi-4-mini가 경량 모델임에도 불구하고 수학 테스트에서 뛰어난 성능을 발휘하는 점은 인상적이었습니다.

앞으로 우리 생활의 다양한 곳에서 AI 모델이 사용될 때가 멀지 않은 것 같습니다. 여러분도 한 번씩 허깅페이스 데모페이지에서 Phi-4 모델을 경험해 보시기를 추천드리면서 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.12.28 - [AI 언어 모델] - 📊마이크로소프트 Phi-4: 14B 매개변수로 GPT-4o를 넘어서다

📊마이크로소프트 Phi-4: 14B 매개변수로 GPT-4o를 넘어서다

안녕하세요! 오늘은 마이크로소프트에서 새롭게 발표한 AI 언어 모델 Phi-4에 대해 소개드리겠습니다. Phi-4는 140억 개의 매개변수를 가진 대규모 언어 모델(LLM)로, 기존 Phi 모델 제품군의 최신작입

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| 🤖🔍📊EXAONE Deep: LG AI의 오픈소스 추론 능력 강화 모델 (8) | 2025.03.22 |

|---|---|

| 🤖✨ Gemma 3 모델 심층 분석: 구글의 차세대 개방형 멀티모달 AI (2) | 2025.03.15 |

| 🎯QwQ-32B: 20배 작은 모델로 DeepSeek-R1 따라잡은 강화 학습 모델 (10) | 2025.03.08 |

| 🐪🤖 QwQ-Max-Preview: 알리바바의 최신 추론 모델 심층 분석 ! (10) | 2025.03.05 |

| 📹🚀🔓Wan2.1: Sora보다 강력한 알리바바의 최강 오픈소스 비디오 AI (7) | 2025.03.03 |