목차

안녕하세요! 오늘은 메타의 최신 대형 언어 모델 Llama 3에 대해서 알아보겠습니다. Llama 3은 8B(80억 개)와 70B(700억 개)의 학습 가능한 매개변수를 가진 두 종류의 모델을 발표하였는데요, 입력 컨텍스트의 최대 길이는 8,000 토큰이며 2023년 3월(사전 훈련 모델)과 12월(명령어 조정 모델)까지의 지식 데이터로 구축되었다고 합니다.

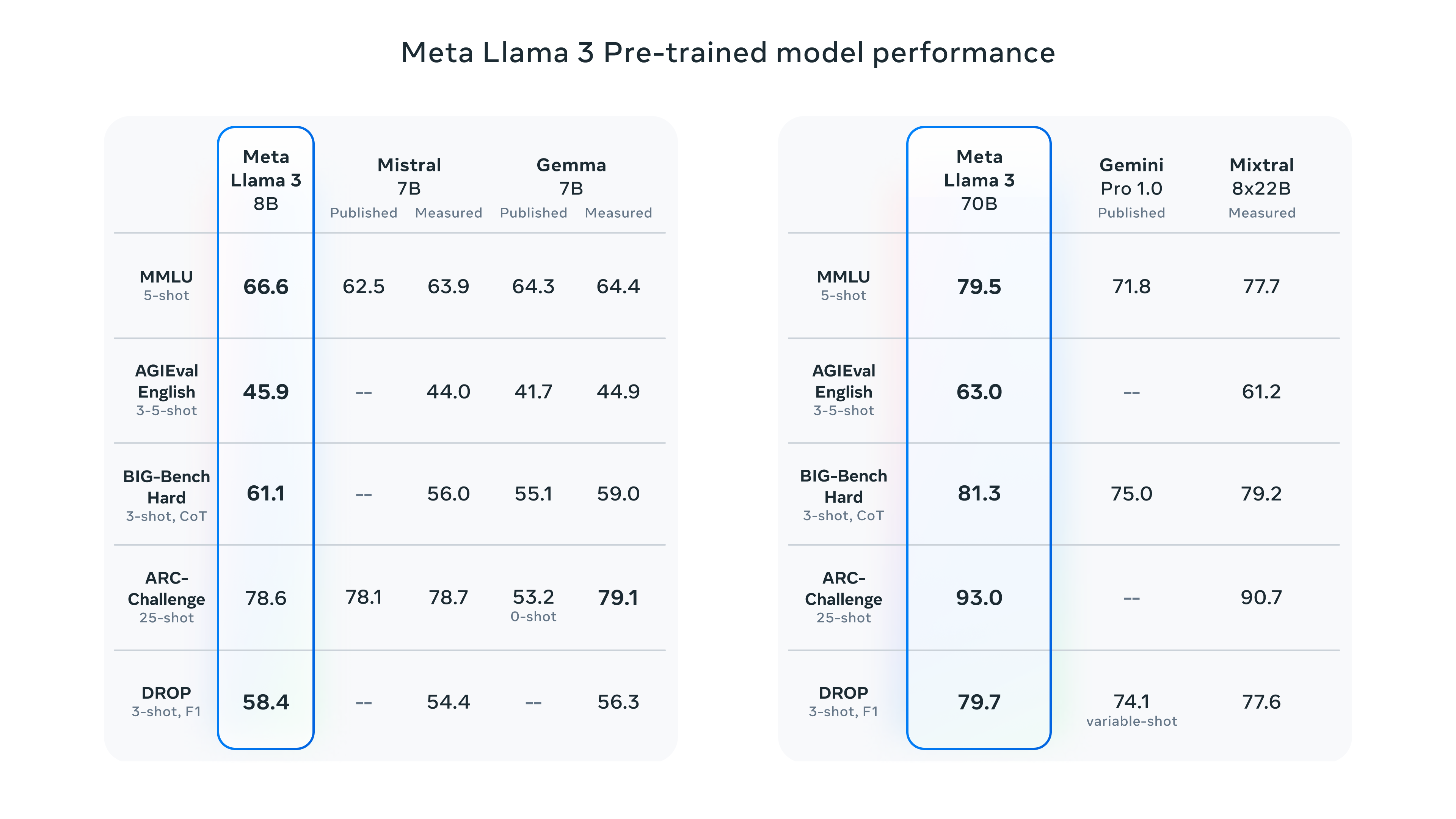

특히 훈련에 사용된 데이터는 15조 개 이상으로 Llama 2보다 7배 크고, 코드 양은 4배 더 많으며, MMLU, GPQA, GSM-8K 및 MATH와 같은 대부분의 벤치마크에서 제미나이 1.5 프로와 클라우드 3 Sonnet을 제치고 가장 우수한 결과를 나타내었습니다. 이 블로그에서는 Llama 3의 개요, 특징, 벤치마크 결과에 대해 살펴보고 "Chat with Ollama"를 통한 추론테스트와 허깅챗을 이용한 코딩테스트를 해보겠습니다. 과연 Llama 3는 에러 없이 한 번에 스네이크 게임 코딩을 성공했을까요?

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

Llama 3 모델 개요

메타에서 이번에 공개한 Llama 3 패밀리는 8B 및 70B 크기를 가진 사전 훈련 (pre-trained) 및 명령어 조정된(instruction tuned) 모델로 구성되어 있습니다. 특히 명령어 조정된 모델은 대화용에 최적화되어 있으며 다양한 벤치마크에서 많은 오픈 소스 챗 모델을 능가합니다. 메타 Llama 3 모델의 개요는 다음과 같습니다.

| 모델명 | 학습 데이터 | 매개변수 | 컨텍스트 길이 | GQA | 토큰 개수 | 지식 데이터 시점 |

|

Llama 3

|

공개적으로 이용 가능한 온라인 데이터의 새로운 혼합 | 8B | 8k | Yes |

15T+

|

2023. 4월 |

| 70B | 8k | Yes | 2023. 12월 |

- 모델 출시일: 2024년 4월 18일

- 입력 및 출력: 모델은 텍스트만을 입력으로 받고, 텍스트와 코드를 생성합니다.

- 모델 종류: Llama 3는 8B와 70B 파라미터의 두 가지 크기 모델이 있습니다. 또한, 각 크기의 모델은 사전 훈련(pre-trained) 및 명령 조정(instruction tuned) 모델로 제공됩니다. 명령 조정 모델은 사용자와의 대화나 상호 작용과 관련된 작업에 특화된 추가 훈련과 최적화를 거친 모델을 말하며, 2가지 모델의 차이점은 아래 표와 같습니다.

| 특성 | 사전 훈련 모델(pre-trained) | 명령 조정 모델(instruction tuned) |

| 학습 데이터 | 일반적인 텍스트 데이터 | 특정 사용 사례에 대한 지시문과 함께 인간의 지도를 받음 |

| 적용 분야 | 다양한 자연어 생성 작업에 적용 가능 | 특정 작업이나 사용 사례에 최적화됨 |

| 성능 및 활용 | 다양한 작업에 대해 일반적인 성능을 보임 | 특정 작업에 대한 성능을 높일 수 있음 |

| 학습 방법 | 인간 지도 없이 대규모 텍스트 데이터로 학습 | 특정 지시문을 따라 훈련되어 작업에 특화됨 |

- 컨텍스트 길이: 모델이 고려하는 입력 컨텍스트의 길이는 8,000 토큰입니다. 이는 모델이 생성할 때 고려하는 입력 텍스트의 최대 길이를 나타냅니다.

- GQA (Grouped-Query Attention): Llama 3 모델은 그룹화된 쿼리 어텐션 메커니즘을 사용하여 추론의 확장성을 향상시킵니다. GQA는 그룹화된 쿼리 어텐션은 입력 텍스트의 다양한 부분을 동시에 고려하여 모델이 더 넓은 문맥을 이해하고 다양한 종류의 추론 작업을 수행할 수 있게 함으로써, 모델의 성능 향상에 기여합니다.

- 토큰 개수: Llama 3 모델의 훈련에 사용된 토큰의 총 개수는 15조 개 이상입니다. 이는 모델이 학습하는 데 사용된 텍스트의 양을 나타냅니다.

- 지식 데이터 시점: 2023년 3월 이전의 데이터를 사용하여 8B 버전이 훈련되었으며, 2023년 12월 이전의 데이터를 사용하여 70B 버전이 훈련되었습니다.

- 라이센스: Meta Llama 3는 커뮤니티 라이센스를 통해 사용자에게 제공되며, 이는 비상업적인 목적으로는 무료로 사용할 수 있다는 것을 의미합니다. 그러나 상업적인 용도로 사용하려는 경우 Meta의 허가를 받아야 합니다.

- 훈련 데이터: Llama 3은 공개적으로 사용 가능한 온라인 데이터를 새롭게 혼합하여 사전 훈련되었습니다. 사전 훈련 데이터와 세밀 조정 데이터 모두 개인 정보 보호 및 데이터 프라이버시를 보장하기 위해 메타 사용자 데이터는 포함되어 있지 않습니다.

모델 아키텍처 및 성능

Llama 3는 자가 회귀적 언어 모델(auto-regressive language model)로서, 최적화된 트랜스포머 아키텍처를 사용하며, 튜닝된 버전은 지도 미세 조정(SFT, Supervised Fine-Tuning)과 휴먼 피드백 강화 학습(RLHF, Reinforcement Learning from Human Feedback)을 사용하여 사용자의 선호도에 맞추어 최적화되었습니다.

- 지도된 미세 조정(SFT): 사람이 제공한 지도 학습 신호를 사용하여 모델을 미세하게 조정하는 기술로 모델의 성능을 향상시키는데 사용되며, 모델의 출력과 원하는 출력 간의 차이를 최소화하기 위해 모델 파라미터가 조정됩니다.

- 휴먼 피드백 강화 학습(RLHF): 인간의 피드백을 이용하여 모델을 강화하는 접근 방식으로 모델이 특정 작업을 수행하고 결과를 생성하면, 인간 평가자가 이를 평가하고 보상 또는 페널티를 부여하여 모델이 원하는 방향으로 학습하도록 유도하며, 이는 모델이 목표를 달성하는 데 더 효과적인 방향으로 학습하도록 돕습니다.

다음은 언어 모델의 유형별 개요 및 특징에 대한 설명입니다.

| 모델 유형 | 특징 | 개요 |

| 자가 회귀적 언어 모델 |

- 이전에 생성된 텍스트를 입력으로 사용하여 다음 단어 또는 문장을 예측하는 순환적 구조 - 대규모 텍스트 생성에 사용됨 |

- ChatGPT(Generative Pre-trained Transformer)와 같은 모델이 여기에 속함 |

| 피드 포워드 신경망 |

- 이전에 생성된 텍스트를 고려하지 않고 현재 입력만 고려하여 텍스트를 생성 - 텍스트 분류에 주로 사용됨 |

- 현재 입력에만 의존하여 텍스트를 생성하는 신경망 모델 |

| 트랜스포머 (Transformer) |

- 어텐션 메커니즘을 사용하여 텍스트를 생성 - 입력 시퀀스의 모든 위치에 대한 정보를 동시 처리 |

- 장기 의존성 (Long-Term Dependency, 입력 시퀀스의 먼 위치에 있는 정보가 출력에 영향을 미치는 경우) 을 처리하고 병렬 처리를 효과적으로 수행 |

| 통계적 언어 모델 |

- 단어 시퀀스의 확률 분포를 추정하여 텍스트를 생성 - N-gram 모델 및 히든 마르코프 모델이 여기에 속함 |

- 단어 시퀀스의 확률 분포를 기반으로 텍스트를 생성하는 통계적인 모델 |

Llama 3 모델은 이전 Llama 2 모델을 크게 능가하며, 사전 훈련 및 명령어 조정 모델은 8B 및 70B 크기로 현재까지 유사한 크기의 오픈소스 모델 중 가장 성능이 우수한 모델입니다. Llama 3는 사후 훈련 과정을 개선함으로써 거짓 정보 생성확률이 크게 감소했고, 모델의 일관성이 향상되었으며, 응답 다양성도 높아지고, 추론, 코드 생성 및 명령어 따르기와 같은 기능도 크게 개선되어 더욱 유연하고 정교해졌습니다. 다음은 명령 조정 모델의 성능평가 결과입니다.

Llama 3의 성능평가에는 다음과 같은 여러 지표가 포함되어 있습니다.

- MMLU (Macro Matched Llama Units): 대규모 자연어 모델의 일관된 성능을 평가하기 위한 지표입니다.

- GPQA (Graduate-Level Google-Proof Q&A Benchmark): 생물학, 물리학, 화학 분야의 전문가들이 만든 448개의 객관식 문제로 구성되어 있으며, 대학원 수준의 지식 일반화된 질문-답변 작업의 정확도를 측정합니다.

- Human Eval: 인간 평가자들이 생성된 텍스트에 대해 부여한 점수입니다.

- GSM-8K (Grade School Math) : 8,500개의 고품질 중학교 수준 수학 문제에 대한 정확도를 측정합니다.

- MATH: 수학 문제를 해결하는 능력을 측정합니다.

- AGI English: AGI(Artificial General Intelligence) English는 인공 일반 지능을 평가하기 위한 작업입니다.

- Big-Bench Hard: 모델의 성능을 평가하기 위한 작업으로, 고난도의 문제들에 대한 모델의 정확도를 측정합니다.

- ARC-Challenge: ARC-Challenge는 ARC(AI2 Reasoning Challenge) 벤치마크의 하위 집합인 ARC-Challenge를 사용하여 모델의 성능을 평가합니다.

- DROP (Discrete Reasoning Over Paragraphs): 질문은 위키피디아 문서에서 추출된 단락으로 구성되어 모델의 응답 다양성과 정확도를 평가하기 위한 작업 중 하나로 96,000개의 질문으로 이루어진 벤치마크입니다.

Llama 3 명령 조정 모델은 오픈소스 및 상용 모델과 비교한 대부분의 지표에서 우수한 결과를 보여주고 있으며, 아래 그림과 같이 사전 훈련 모델 또한 제미나이 1.0 프로나 믹스트랄 8x22B 모델보다 앞서는 성능을 보여줍니다.

추론 및 코딩 테스트

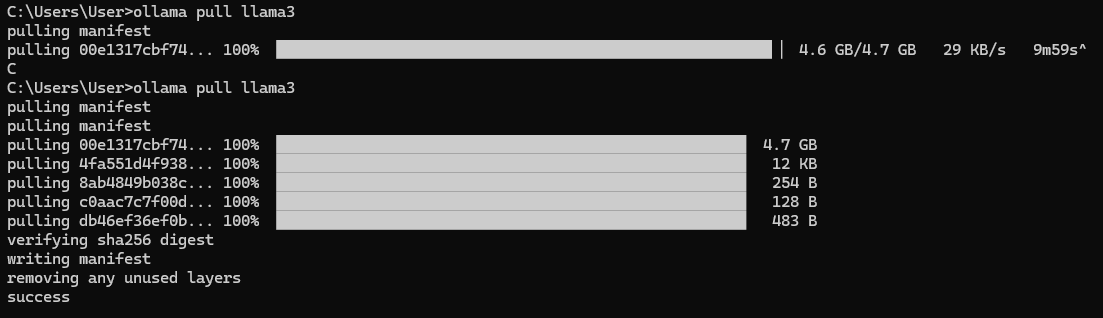

다음은 Llama 3 8B 모델을 Ollama에 탑재하여 추론 성능을 살펴보고, 허깅챗을 통해서 Llama 3 70B 모델의 코딩 성능을 테스트해 보겠습니다. 먼저 컴퓨터에 Ollama를 설치하고, 명령어 프롬프트에서 "ollama pull llama3" 명령을 통해 Llama 3 8B 모델을 로컬 컴퓨터로 다운로드합니다. Ollama는 윈도우 프리뷰 버전도 테스트에 큰 상관없습니다.

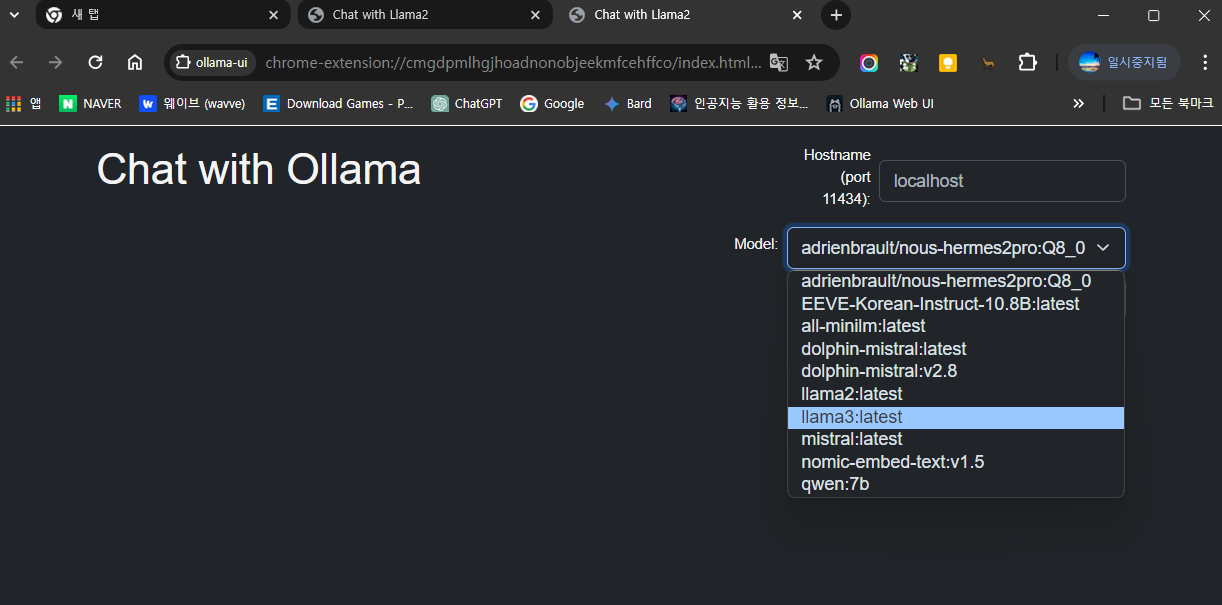

다음은 크롬 브라우저 확장프로그램 "Chat with Ollama"를 이용해서 Llama 3와 대화를 시작합니다. "Chat with Ollama" 크롬 확장프로그램 설치는 아래 포스트를 참고하시기 바랍니다.

2024.04.10 - [대규모 언어모델] - Dolphin 2.8: 무엇이든 대답하는 무검열 Mistral 최신 모델과 오프라인 대화(크롬 브라우저 Ollama UI)

https://ollama.com/library/llama3

llama3

Meta Llama 3: The most capable openly available LLM to date

ollama.com

추론 테스트

"Chat with Ollama"가 설치완료되면 총 3문제의 추론 테스트를 해보겠습니다. 문제의 출처는 유튜버 Matthew Berman이며, 참고로 ChatGPT 3.5의 답변과 비교를 해보았습니다.

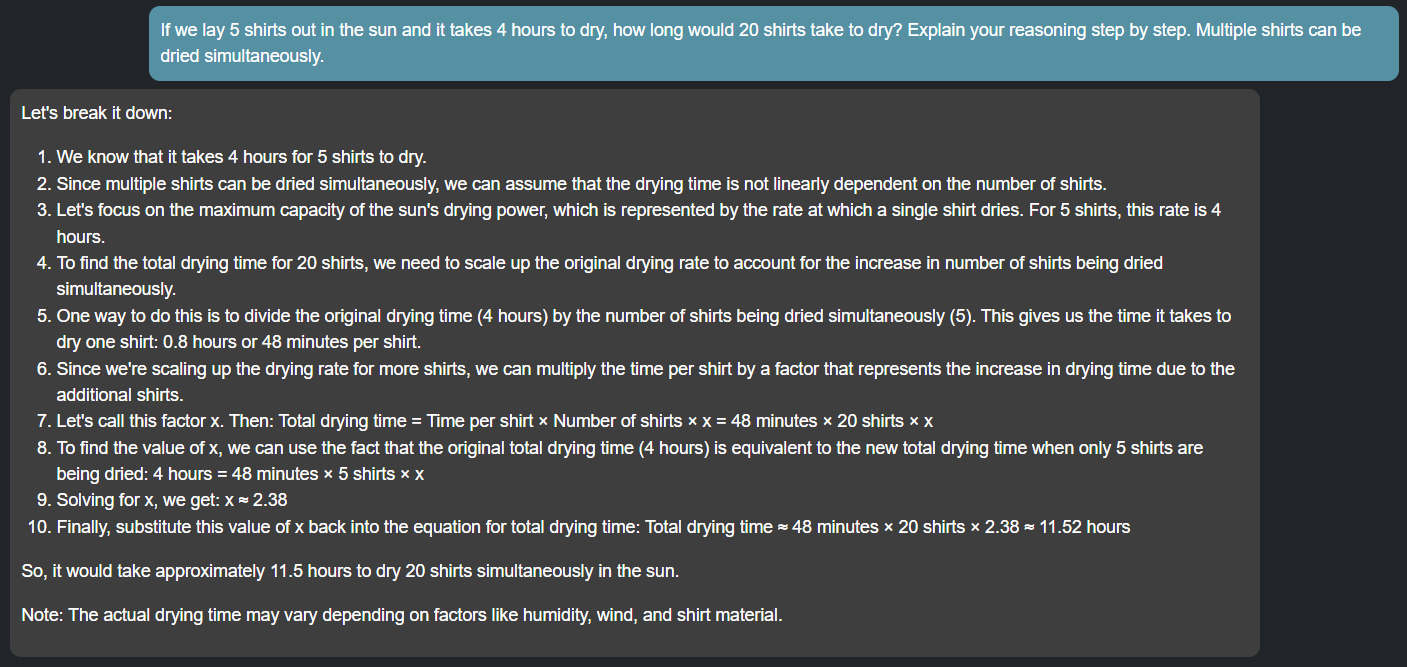

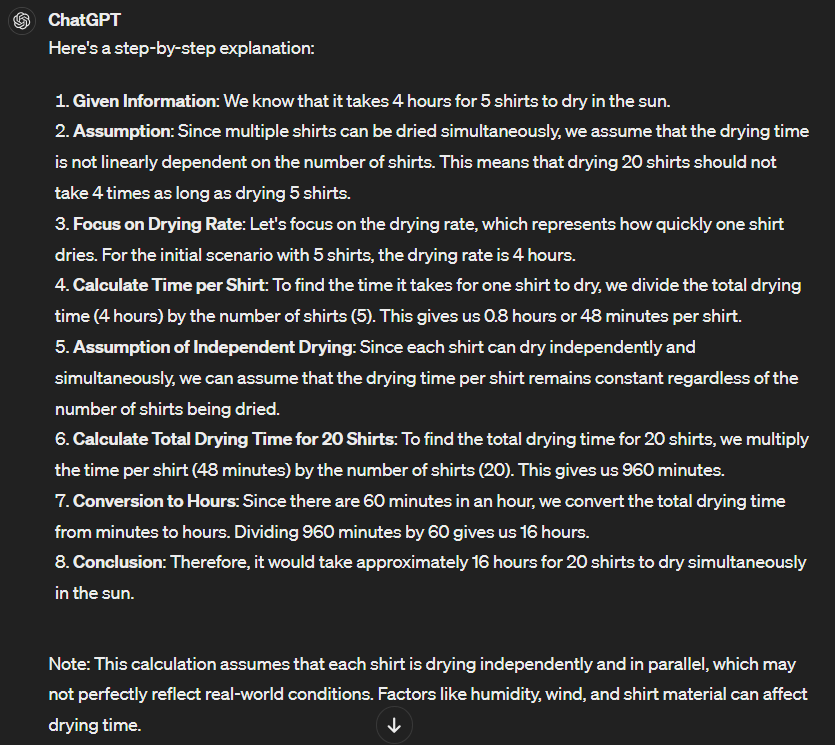

| 추론 질문 1 | 5장의 셔츠를 햇빛에 건조하는데 4시간이 걸린다고 해보자. 그렇다면 20장의 셔츠를 건조하는데는 얼마나 걸릴까요? 각 단계를 차근차근 설명해주세요. 여러 셔츠를 동시에 건조시킬 수 있습니다. |

| Llama 3 8B 답변 | 이해해 보겠습니다: 1. 5장의 셔츠를 건조하는 데 4시간이 걸린다는 사실을 알고 있습니다. 2. 여러 셔츠를 동시에 건조할 수 있기 때문에, 건조 시간이 셔츠의 수에 선형적으로 의존하지 않을 것으로 가정할 수 있습니다. 3. 태양의 최대 건조 능력에 초점을 맞춰볼까요? 한 장의 셔츠가 건조되는 속도로 나타낼 수 있습니다. 5장의 셔츠에 대한 이 속도는 4시간입니다. 4. 20장의 셔츠의 총 건조 시간을 찾으려면, 동시에 건조되는 셔츠의 수가 증가함에 따라 원래의 건조 속도를 확장해야 합니다. 5. 이를 위한 한 가지 방법은 원래의 건조 시간(4시간)을 동시에 건조되는 셔츠의 수(5)로 나누는 것입니다. 이를 통해 한 장의 셔츠를 건조하는 데 걸리는 시간을 얻을 수 있습니다. 셔츠 당 시간 = 총 건조 시간 ÷ 셔츠의 수 = 4시간 ÷ 5장 = 0.8시간 또는 48분 6. 더 많은 셔츠에 대한 건조 속도를 확장하기 때문에, 각 셔츠 당 시간에 추가된 셔츠로 인한 건조 시간 증가를 나타내는 요소를 곱할 수 있습니다. 7. 이 요소를 x라고 부를까요. 그러면: 총 건조 시간 = 셔츠 당 시간 × 셔츠의 수 × x = 48분 × 20장 × x 8. x의 값을 찾기 위해, 원래의 총 건조 시간(4시간)이 5장의 셔츠만 건조될 때의 총 건조 시간과 동일하다는 사실을 사용할 수 있습니다: 4시간 = 48분 × 5장 × x 9. x를 푸는 것으로, 우리는 x ≈ 2.38 마지막으로, 총 건조 시간의 방정식에 이 x의 값을 대입합니다: 총 건조 시간 ≈ 48분 × 20장 × 2.38 ≈ 11.52시간 10. 그러므로, 태양에서 20장의 셔츠를 동시에 건조하는 데는 약 11.5시간이 걸릴 것입니다. 참고: 실제 건조 시간은 습도, 바람 및 셔츠 소재와 같은 요인에 따라 다를 수 있습니다. |

| ChatGPT 3.5 답변 | 다음은 단계별 설명입니다: 1. 주어진 정보: 태양에서 5장의 셔츠를 건조하는 데 4시간이 걸린다는 것을 알고 있습니다. 2. 가정: 여러 셔츠를 동시에 건조할 수 있기 때문에, 우리는 건조 시간이 셔츠 수에 선형적으로 의존하지 않는다고 가정합니다. 즉, 20장의 셔츠를 건조하는 데는 5장의 셔츠를 건조하는 데보다 4배 더 오래 걸리지 않을 것이라고 가정합니다. 3. 건조 속도에 집중: 한 장의 셔츠가 얼마나 빨리 건조되는지를 나타내는 건조 속도에 집중해 보겠습니다. 초기 시나리오에서 5장의 셔츠에 대한 건조 속도는 4시간입니다. 4. 셔츠 당 시간 계산: 한 장의 셔츠가 건조되는 데 걸리는 시간을 찾기 위해 전체 건조 시간(4시간)을 셔츠 수(5)로 나눕니다. 이렇게 하면 한 장의 셔츠를 건조하는 데 0.8시간 또는 48분이 걸립니다. 5. 독립적인 건조 가정: 각 셔츠가 독립적으로 동시에 건조되므로, 셔츠 당 건조 시간이 건조되는 셔츠의 수와 상관없이 일정하다고 가정할 수 있습니다. 6. 20장의 셔츠를 위한 총 건조 시간 계산: 20장의 셔츠를 위한 총 건조 시간을 찾으려면, 셔츠 당 시간(48분)을 셔츠 수(20)로 곱합니다. 이렇게 하면 960분이 됩니다. 7. 시간으로 변환: 1시간에 60분이 있으므로, 총 건조 시간을 분에서 시간으로 변환합니다. 960분을 60으로 나누면 16시간이 됩니다. 8. 결론: 따라서 태양 아래에서 20장의 셔츠를 동시에 건조하는 데는 약 16시간이 걸립니다. 참고: 이 계산은 각 셔츠가 독립적으로 동시에 건조된다고 가정하며, 현실 세계의 조건을 완벽하게 반영하지 않을 수 있습니다. 습도, 바람, 셔츠 소재 등의 요인이 건조 시간에 영향을 줄 수 있습니다. |

이 문제는 두 모델이 답변이 서로 달랐는데요. 어느 쪽이 더 합리적인지 여러분께서 한번 판단해 보시기 바랍니다.

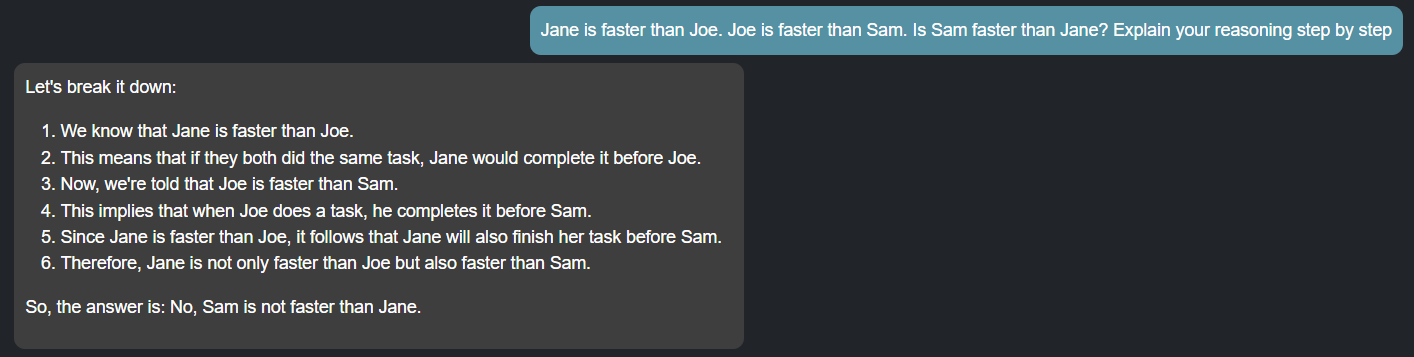

| 추론 질문 2 | 제인이 조 보다 빠르고, 조가 샘보다 빠르다. 그렇다면 샘은 제인보다 빠른가요? 각 단계를 차근차근 설명해주세요. |

| Llama 3 8B 답변 | 이를 세분화해보겠습니다: 1. 우리는 제인이 조보다 빠르다는 것을 알고 있습니다. 2. 이것은 만약 둘이 동일한 작업을 한다면, 제인이 조보다 먼저 완료할 것이라는 것을 의미합니다. 3. 이제, 조가 샘보다 더 빠르다고 합니다. 4. 이것은 조가 작업을 할 때, 그가 샘보다 먼저 완료한다는 것을 의미합니다. 5. 제인이 조보다 빠르기 때문에, 제인은 샘보다도 작업을 먼저 완료할 것입니다. 6. 따라서, 제인은 조보다 빠를 뿐만 아니라 샘보다도 빠릅니다. 그러므로, 답은 "아니오, 샘은 제인보다 빠르지 않습니다."입니다. |

| ChatGPT 3.5 답변 | 단계별로 문장을 분석해보겠습니다: 1. 제인은 조보다 빠릅니다: 이 문장은 제인의 속도가 조의 속도를 초과한다는 것을 의미합니다. 수학적으로는 제인 > 조 제인>조로 나타낼 수 있습니다. 2. 조는 샘보다 빠릅니다: 마찬가지로, 이 문장은 조의 속도가 샘의 속도보다 크다는 것을 나타냅니다. 기호로는 조 > 샘 조>샘으로 표현할 수 있습니다. 3. 샘은 제인보다 더 빠른가요?: 샘이 제인보다 빠른지 여부를 결정하려면 그들의 속도를 비교해야 합니다. 그러나 우리는 직접적으로 제인과 샘을 비교하는 정보가 없습니다. 대신, 제인과 조, 그리고 조와 샘 사이의 두 개의 별개의 비교가 있습니다. 4. 주어진 문장에서, 우리는 제인이 조보다 빠르다는 것을 알고 있습니다 ( 제인 > 조 제인>조) 그리고 조가 샘보다 빠르다는 것을 알고 있습니다 ( 조 > 샘 조>샘). 5. 이 두 부등식을 결합하여, 제인과 샘 사이의 관계를 추론할 수 있습니다: 만약 제인 > 조 제인>조이고 조 > 샘 조>샘이라면, 제인 > 샘 제인>샘입니다. 6. 결론: 주어진 정보를 바탕으로, 우리는 제인이 실제로 샘보다 빠르다고 결론지을 수 있습니다. 따라서 샘은 제인보다 빠르지 않습니다. |

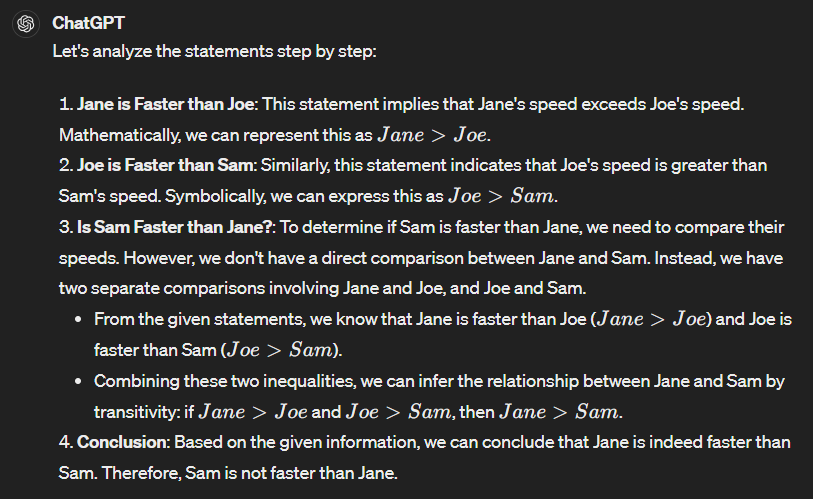

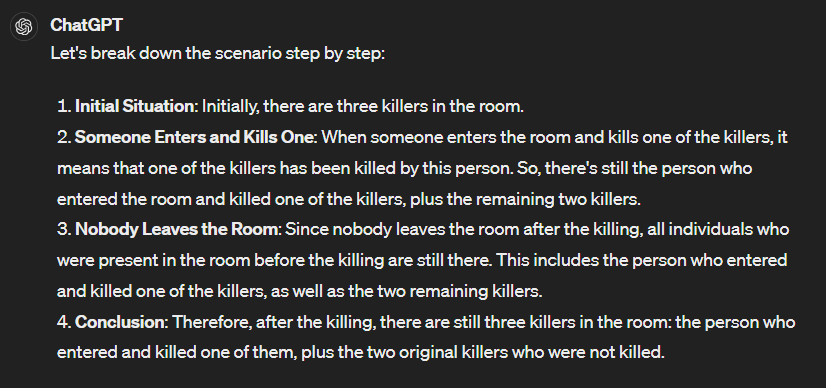

| 추론 질문 3 | 방 안에는 살인자가 세 명 있습니다. 어떤 사람이 방에 들어와 그 중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 남아 있는 살인자는 몇 명입니까? 단계별로 추론 과정을 설명하세요. 원래 방에 있던 살인자 말고도, 살아있거나 죽어있거나, 누구든지 죽인 살인자를 고려하세요. |

| Llama 3 8B 답변 | 상황을 분석해보겠습니다: 1. 방 안에는 세 명의 살인자가 있습니다. 2. 누군가가 방에 들어와 그들 중 한 명을 죽입니다. 3. 아무도 방을 나가지 않습니다. 이제 상태에 관계없이 모든 살인자를 고려해 봅시다(살아 있거나 죽었는지에 상관없이): - 원래의 세 명의 살인자: 두 명은 아직 살아 있고, 한 명은 죽었습니다. - 방에 들어와 원래의 살인자 중 한 명을 죽인 사람: 이 사람 또한 살인자입니다. 왜냐하면 그들은 방금 살인을 저질렀기 때문입니다. 따라서, 방 안에는: - 아직 살아 있는 원래의 2명의 살인자 - 방에 들어와 누군가를 죽인 1명(이 사람 또한 살인자입니다) - 사망한 원래의 살인자 1명 총 3명의 살인자가 있습니다. |

| ChatGPT 3.5 답변 | 상황을 단계별로 살펴보겠습니다: 1. 초기 상황: 처음에 방 안에는 세 명의 살인자가 있습니다. 2. 누군가 들어와서 한 명을 죽임: 누군가가 방에 들어와서 한 명의 살인자를 죽인다는 것은 한 명의 살인자가 이 사람에 의해 죽었다는 의미입니다. 따라서, 방에 들어와서 한 명을 죽인 사람과 남은 두 명의 살인자가 남아 있습니다. 3. 아무도 방을 나가지 않음: 살인 후에도 아무도 방을 나가지 않으면, 살인 전에 방에 있던 모든 사람들은 여전히 거기에 있습니다. 이에는 방에 들어와서 한 명을 죽인 사람과 남은 두 명의 살인자가 포함됩니다. 4. 결론: 따라서, 살인 후에도 방에는 여전히 세 명의 살인자가 있습니다: 방에 들어와서 한 명을 죽인 사람과 죽지 않은 원래의 두 명의 살인자입니다. |

이 추론 문제는 두 모델의 답이 같은데요. 어떤 모델의 답변과정이 더 명쾌한지는 여러분이 판단해 보시면 좋을 것 같습니다. 사실, 원래 문제에는 "Consider~" 마지막 부분의 보충설명이 없는데 제가 편의상 추가하였습니다.

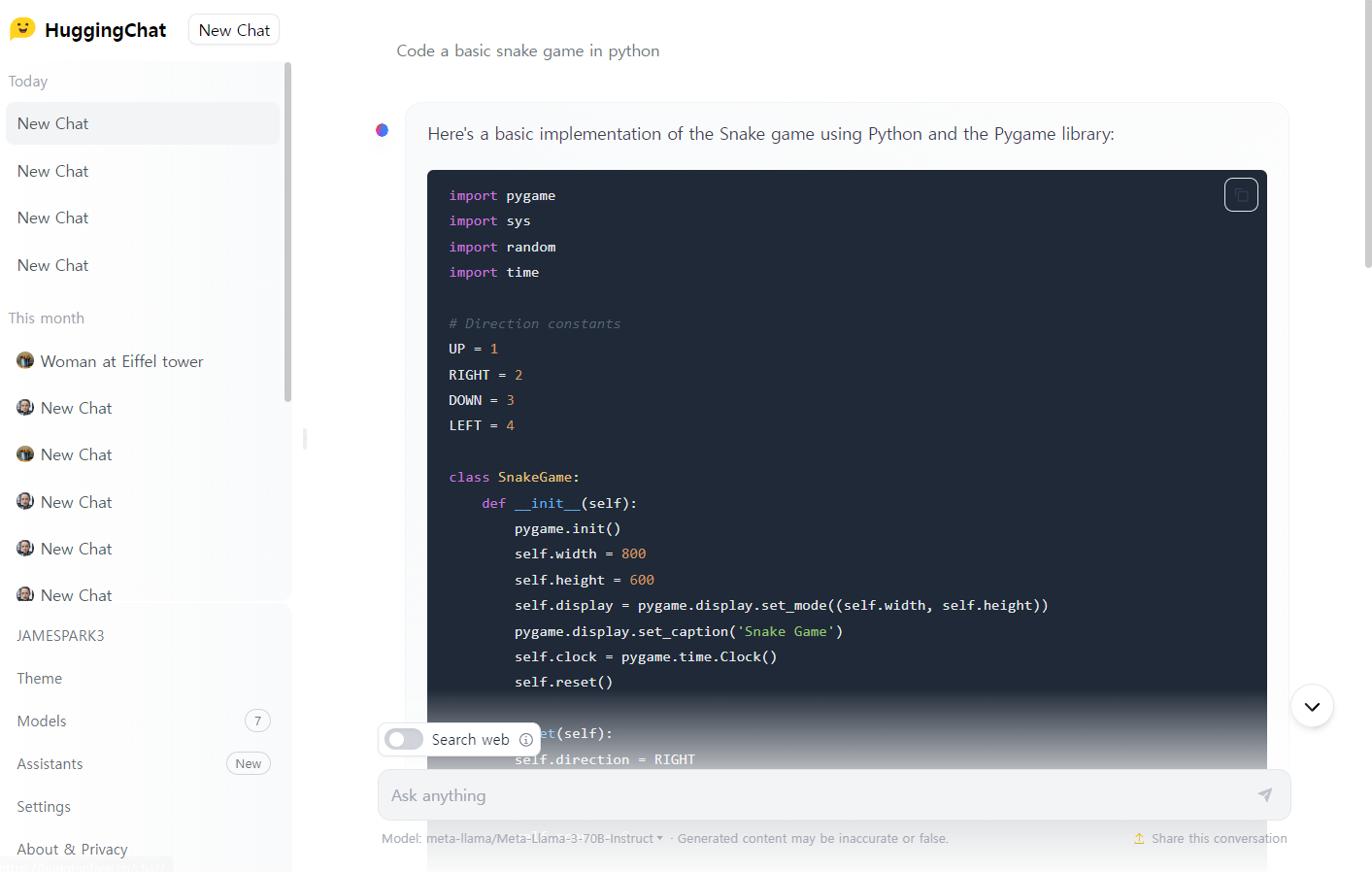

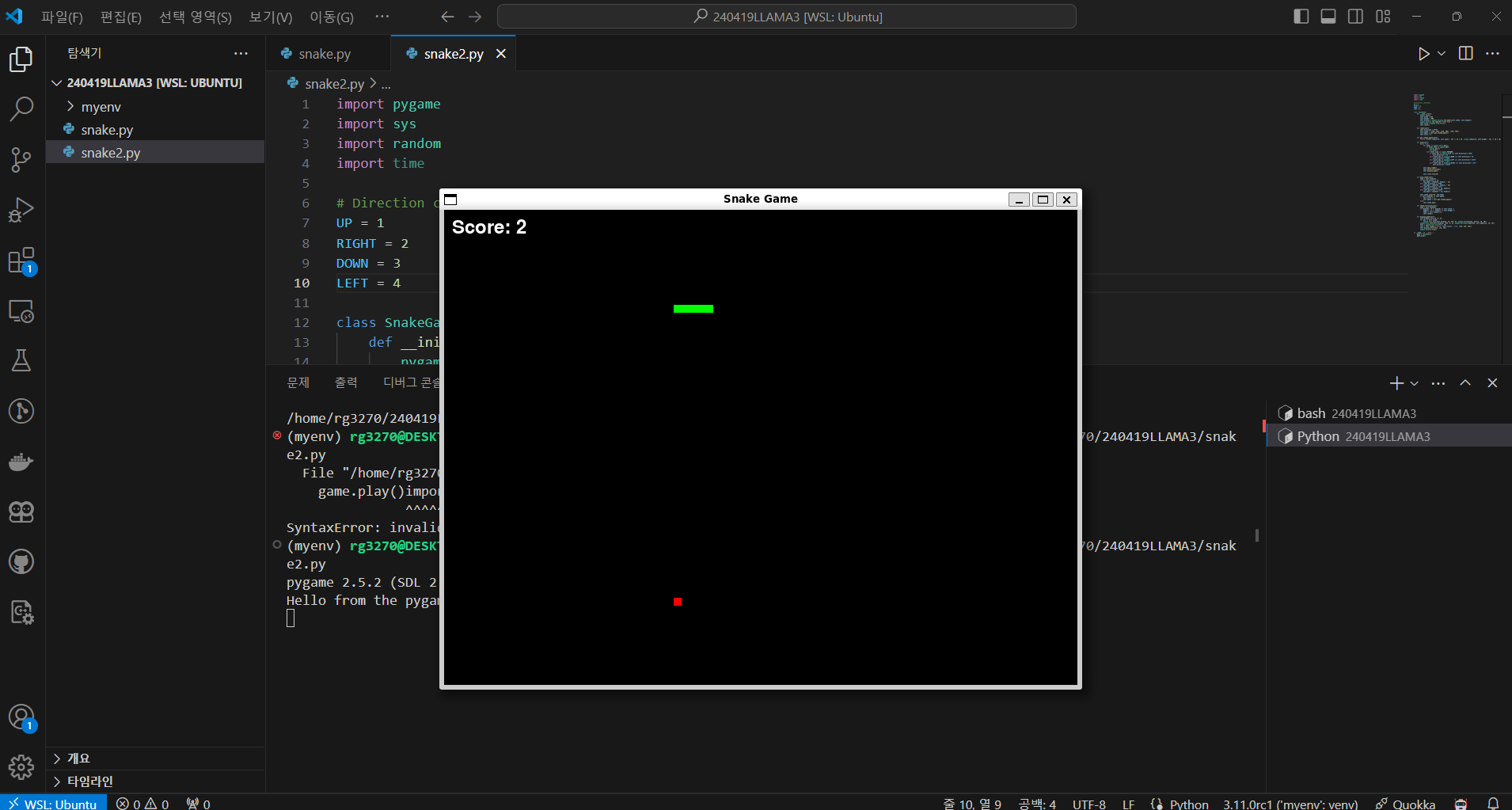

코딩 테스트

다음은 코딩 테스트입니다. 코딩 테스트는 허깅챗 사이트에 접속하여 Llama 3 70B 모델로 진행해 보겠습니다. 아래 사이트에 접속하여 좌측 Models를 클릭하고 Llama 3 70B Instruct를 선택한 후, 채팅창에 "Code a basic snake game in python"이라고 입력합니다. 엔터를 치면 Llama 3 70B의 응답이 바로 시작됩니다.

https://huggingface.co/chat/models/meta-llama/Meta-Llama-3-70B-Instruct

meta-llama/Meta-Llama-3-70B-Instruct - HuggingChat

Use meta-llama/Meta-Llama-3-70B-Instruct with HuggingChat

huggingface.co

저의 경우 Llama 3 70B이 응답한 코드를 복사하여 VSC에 붙여 넣고 실행하였더니, 한 번에 에러 없이 실행되었으며, 득점이나, 스네이크가 게임윈도우 밖으로 나가면 게임이 종료되는 등 게임의 기본 기능들이 정상적으로 동작하였습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

맺음말

오늘은 메타가 최근 공개한 대규모 언어 모델 Llama 3에 대해 자세히 살펴보았습니다. 8B와 70B 크기의 모델을 갖춘 Llama 3는 8,000 토큰의 입력 컨텍스트를 지원하며, GQA, MMLU, GSM-8K, MATH와 같은 대부분의 벤치마크에서 최고의 성능을 보여줍니다. Llama 3는 사전 훈련된 모델과 명령 조정된 모델로 구성되며, 명령 조정된 모델은 사용자와의 대화에 최적화되어 다양한 벤치마크에서 많은 오픈 소스 챗 모델을 능가합니다.

이 블로그에서는 Llama 3의 개요, 특징, 벤치마크 결과, 추론 테스트 (Ollama), 코딩 테스트 (허깅챗)를 살펴보았습니다. 추론 테스트에서는 Llama 3 8B 모델의 추론성능을 확인하고, ChatGPT 3.5 모델과 비교해 보았으며, 코딩 테스트에서는 허깅챗 사이트를 통해 Llama 3 70B 모델에게 파이썬으로 스네이크 게임을 만들도록 요청했습니다. Llama 3 70B 모델은 에러 없이 한 번에 스네이크 게임을 완성하며, 점수 득점, 게임 종료 기능 등을 구현했습니다.

Llama 3는 다양한 분야에서 활용 가능성이 높은 강력한 언어 모델입니다. 현재 학습이 진행 중인 Llama 3 400B는 또 어떤 발전을 가져올지 기대됩니다. 오늘 블로그를 통해 Llama 3 모델 이해에 도움이 되셨기를 바라면서 저는 다음에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.04.07 - [대규모 언어모델] - 🎨클로드(Claude) 3 Opus로 만드는 놀라운 일러스트!

🎨클로드(Claude) 3 Opus로 만드는 놀라운 일러스트!

안녕하세요! 오늘은 요즘 챗GPT보다 핫한 언어 모델 클로드 3을 이용해서 일러스트를 그려보겠습니다. 앤트로픽의 최신 대형 언어 모델인 클로드 3 모델은 성능과 속도를 고려하여 Haiku, Sonnet 및 O

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| Phi-3: 마이크로소프트의 작지만 강한 소형 언어 모델, 고난도 스네이크 게임 성공!! (4) | 2024.04.25 |

|---|---|

| [Llama 3 70B] Groq을 활용한 함수 호출 및 API 통합! NBA 게임 및 주식 정보 실시간 조회 (2) | 2024.04.21 |

| 야놀자 한국어 언어 모델 EEVE와 Ollama로 구현하는 로컬 RAG (0) | 2024.04.17 |

| [AI 논문] 올해의 한국어 LLM에 선정된 야놀자 언어 모델, EEVE (0) | 2024.04.13 |

| Dolphin 2.8: 무엇이든 대답하는 무검열 Mistral 최신 모델과 오프라인 대화(크롬 브라우저 Ollama UI) (0) | 2024.04.10 |