안녕하세요! 이번주 가장 핫한 대형 언어 모델은 Llama3인데요. 오늘은 Groq을 활용해서 Llama 3 함수 호출 및 API 통합을 해보겠습니다. 이 프로그램은 사용자가 Gradio 웹 인터페이스를 통해 NBA 게임결과나 주식가격을 질문을 입력하면, Groq은 사용자 질문에 맞는 API와 함수를 호출하고, 그 실행 결과를 Llama 3에게 전달하며, Llama 3는 실행결과를 해석하여 입력된 질문에 맞는 대답을 출력합니다. 자, 시작해 볼까요?

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

프로그램 개요

이 프로그램은 사용자가 임의로 저장한 NBA 게임 결과와 야후 파이낸스의 실시간 주식 가격의 조회가 가능한데요. 사용자의 질문에 따라 자동으로 Flask 웹 애플리케이션을 통해 사용자 정의 API 및 함수를 호출하거나, Yahoo Finance 외부 API를 호출하며, Groq은 Llama 3에 접속할 수 있는 API를 제공하고, Llama 3는 사용자 질문을 이해하여 해당 API 및 함수 호출 결과를 해석하여 응답을 생성합니다. 이 프로그램의 동작에 대한 요약표는 다음과 같습니다.

| 특징 | NBA 게임 결과 질문 | 현재 주식 가격 조회 |

| 데이터 위치 | 로컬 사용자 데이터 (임의 가공 데이터) | 외부 서비스 데이터 (실시간 주식 가격) |

| 구현방식 | Flask 웹 애플리케이션을 통한 사용자 정의 API 및 함수 호출 |

Yahoo Finance 외부 API 및 사용자 정의 함수 호출 |

| Llama 3 기능 | 사용자 질문 이해, Flask 웹 애플리케이션 호출, 사용자 정의 API 및 함수 실행결과 해석, 응답 생성 |

사용자 질문 이해, Yahoo Finance 외부 API 호출, 사용자 정의 함수 실행결과 해석, 응답 생성 |

| Groq 기능 | Llama 3 접속 API 제공, API 및 함수 호출, API 및 함수 실행결과 Llama 3에게 전달 | |

| 요청 파라미터 | team (NBA 팀명) | ticker (주식의 티커 심볼) |

| 응답 형식 | JSON | JSON |

환경설정 및 API Key 발급

이 블로그에서 사용한 예제코드의 실행환경은 Windows 11 Pro(23H2), 파이썬 버전 3.11, 코드 에디터는 비주얼 스튜디오 코드(이하 VSC)입니다. 먼저 "conda create -n Llama3groq python=3.11 -y" 명령으로 가상환경을 생성하고 "conda activate Llama3groq" 명령으로 활성화합니다. Llama3groq 가상환경 이름은 원하는 이름으로 수정할 수 있습니다.

가상환경 생성이 완료되면 가상환경이 활성화된 상태에서 "pip install groq gradio yfinance requests" 명령어로 의존성을 설치해 줍니다. 여기서 설치되는 라이브러리의 용도는 다음과 같습니다.

- groq: Llama 3과 연결하여 사용자 요청에 따라 API 및 함수 호출을 관리합니다. 사용자가 입력한 질문이나 명령에 맞게 적절한 API나 함수를 호출하고 결과를 수신한 후, 이를 Llama 3에 전달하는 역할을 합니다

- gradio: Gradio는 간단한 코드 작성으로 웹 기반 UI(사용자 인터페이스)를 빠르게 생성할 수 있는 도구입니다. 그라디오를 사용하면 모델의 입력과 출력을 쉽게 시각화하고 상호작용할 수 있는 사용자 인터페이스를 만들 수 있습니다.

- yfinance: Yfinance는 파이썬을 통해 Yahoo Finance에서 금융 데이터를 가져오는 데 사용되는 라이브러리입니다. 이를 통해 사용자는 주식 가격, 거래량, 주가 등 다양한 금융 데이터를 얻을 수 있습니다.

- requests: Requests는 간편한 HTTP 요청을 보내고 받을 수 있는 파이썬 라이브러리입니다. 이를 통해 웹 서버와 통신하고 원격 API에 요청을 보내는 데 사용됩니다. 위 코드에서는 Flask 웹 애플리케이션과 통신하기 위해 사용됩니다.

다음은 Groq API Key를 발급받을 차례인데요. Groq API는 대형 언어 모델 전용 추론 가속 장치인 Groq LPU (Language Processing Unit)를 기반으로 언어 모델을 사용하여 자연어 처리 및 다양한 언어 관련 작업을 수행하는 데 사용되는 API입니다. 이 API를 사용하면 사용자는 텍스트 기반의 입력을 제공하고 해당 입력에 대해 기존 인공지능 모델보다 매우 빠른 응답을 얻을 수 있습니다.

Groq API를 사용하기 위해서는 https://console.groq.com/keys에 접속해서 아래 화면과 같이 "Create API Key" 버튼을 클릭해서 새로운 API Key를 발급받습니다. 기타 Groq API에 대한 자세한 내용은 아래 포스트를 참고하시면 됩니다.

2024.02.29 - [AI 도구] - Groq LPU : 논문 한편 요약하는데 입력-추론-응답까지 2.4초!

Groq LPU : 논문 한편 요약하는데 입력-추론-응답까지 2.4초!

안녕하세요! 오늘은 Groq이라는 회사의 대형 언어 모델 추론성능 가속장치, LPU(Language Processing Unit)에 대해서 알아보겠습니다. Groq은 2016년에 과거 구글 직원이었던 조나단 로스에 의해 설립된 AI

fornewchallenge.tistory.com

코드 작성 및 실행

다음은 코드 작성 및 실행 단계입니다. 이 코드의 출처는 유튜브 "Groq Function Calling Llama 3: How to Integrate Custom API in AI App?"이며, 코드는 api.py와 app.py 두 개로 구성되어 서로 다른 역할을 담당하며 연결되어 동작하므로, api.py를 실행한 상태에서 app.py를 실행해야 합니다.

api.py - Flask 웹 애플리케이션

api.py는 Flask를 사용하여 간단한 웹 애플리케이션을 구현한 것으로 팀명과 점수가 기록되어 있으며, 게임의 결과를 조회할 수 있는 API 엔드포인트를 제공합니다. 클라이언트는 `http://127.0.0.1:5000/score` 엔드포인트에 GET 요청을 보내어 NBA 팀의 이름을 파라미터로 전달하면 해당 팀의 게임 결과를 아래 화면과 같이 JSON 형식으로 받을 수 있습니다.

아래 내용은 api.py 코드입니다.

from flask import Flask, request, jsonify

import json

app = Flask(__name__)

def get_game_score(team_name):

"""Get the current score for a given NBA game"""

team_name = team_name.lower()

if "warriors" in team_name:

return {"game_id": "401585601", "status": 'Final', "home_team": "Los Angeles Lakers", "home_team_score": 121, "away_team": "Golden State Warriors", "away_team_score": 128}

elif "lakers" in team_name:

return {"game_id": "401585601", "status": 'Final', "home_team": "Los Angeles Lakers", "home_team_score": 121, "away_team": "Golden State Warriors", "away_team_score": 128}

elif "nuggets" in team_name:

return {"game_id": "401585577", "status": 'Final', "home_team": "Miami Heat", "home_team_score": 88, "away_team": "Denver Nuggets", "away_team_score": 100}

elif "heat" in team_name:

return {"game_id": "401585577", "status": 'Final', "home_team": "Miami Heat", "home_team_score": 88, "away_team": "Denver Nuggets", "away_team_score": 100}

else:

return {"team_name": team_name, "score": "unknown"}

@app.route('/score', methods=['GET'])

def score():

team_name = request.args.get('team', '')

if not team_name:

return jsonify({'error': 'Missing team name'}), 400

score = get_game_score(team_name)

return jsonify(score)

if __name__ == '__main__':

app.run(debug=True)

위 코드는 Flask 웹 애플리케이션을 사용하여 NBA 게임의 현재 점수를 반환하는 간단한 API를 구현합니다. 여기에는 몇 가지 주요 기능이 있습니다.

- Flask 애플리케이션 설정: `Flask` 클래스를 사용하여 웹 애플리케이션을 생성합니다. 이 코드에서는 `app`이라는 Flask 애플리케이션 객체를 만듭니다.

- 게임 점수 확인 함수: `get_game_score(team_name)` 함수는 특정 NBA 팀의 게임 점수를 반환합니다. 이 함수는 팀 이름을 받아와서 해당 팀의 게임 정보를 확인하고, JSON 형식으로 게임 정보를 반환합니다.

- API 엔드포인트 설정: `/score` 엔드포인트에 대한 핸들러 함수인 `score()` 함수를 정의합니다. 이 함수는 GET 요청을 받아서 특정 NBA 팀의 이름을 쿼리 매개변수로 받습니다. 그런 다음 받은 팀 이름을 사용하여 `get_game_score()` 함수를 호출하여 해당 팀의 게임 점수를 가져옵니다. 마지막으로 게임 정보를 JSON 형식으로 응답합니다.

- 애플리케이션 실행: `__name__`이 `'__main__'`인 경우에만 Flask 애플리케이션을 실행합니다. 이렇게 하면 모듈이 직접 실행될 때만 서버가 실행되고, 다른 모듈에서 임포트 되었을 때는 실행되지 않습니다.

이 애플리케이션을 실행하면, `/score` 엔드포인트에 GET 요청을 보내면 특정 NBA 팀의 게임 점수를 받을 수 있습니다. 또한 이 코드에서는 디버그 모드로 실행되므로 Flask 서버가 수정될 때마다 자동으로 다시 시작됩니다.

app.py - Function 및 API

app.py는 Groq의 API를 통해 Llama 3 대형 언어 모델(LLM)을 사용하여 사용자와의 대화를 처리합니다. 사용자가 입력한 질문을 받아서 LLM에 전달하고, LLM은 입력된 질문을 이해하고 적절한 답변을 생성합니다. 이 과정에서 Groq은 `get_game_score()` 함수와 `get_stock_price()` 함수를 호출하여 질문에 대한 결과를 가져옵니다. 이를 통해 LLM은 대화에 필요한 정보를 확보하고 해당 정보를 사용하여 질문에 대한 응답을 생성합니다.

아래 내용은 app.py 코드입니다. Groq API key는 본인이 발급받은 Key로 입력합니다.

from groq import Groq

import json

import gradio as gr

import yfinance as yf

import requests

client = Groq(api_key="발급받은 API key")

MODEL = 'llama3-70b-8192'

# Function to Get Stock Price

def get_stock_price(parameters):

ticker = parameters["ticker"]

stock = yf.Ticker(ticker)

hist = stock.history(period="1d")

if not hist.empty:

return {"price": hist["Close"].iloc[-1]}

else:

return {"error": "No data available"}

# Function to Get Game Score

def get_game_score(team_name):

"""Get the current score for a given NBA game by querying the Flask API."""

url = f'http://127.0.0.1:5000/score?team={team_name}'

response = requests.get(url)

if response.status_code == 200:

return json.dumps(response.json())

else:

return json.dumps({"error": "API request failed", "status_code": response.status_code})

def run_conversation(user_prompt):

# Step 1: send the conversation and available functions to the model

messages=[

{

"role": "system",

"content": "You are a function calling LLM that uses the data extracted from the get_stock_price and get_game_score functions to answer questions around stock prices and NBA game scores. Answer in Korean in conversational style."

},

{

"role": "user",

"content": user_prompt,

}

]

tools = [

{

"type": "function",

"function": {

"name": "get_stock_price",

"description": "Get the price for a given stock",

"parameters": {

"type": "object",

"properties": {

"ticker": {

"type": "string",

"description": "The ticker symbol of the stock (e.g. 'AAPL')",

}

},

"required": ["ticker"],

},

},

},

{

"type": "function",

"function": {

"name": "get_game_score",

"description": "Get the score for a given NBA game",

"parameters": {

"type": "object",

"properties": {

"team_name": {

"type": "string",

"description": "The name of the NBA team (e.g. 'Golden State Warriors')",

}

},

"required": ["team_name"],

},

},

}

]

response = client.chat.completions.create(

model=MODEL,

messages=messages,

tools=tools,

tool_choice="auto",

max_tokens=4096

)

response_message = response.choices[0].message

tool_calls = response_message.tool_calls

# Step 2: check if the model wanted to call a function

if tool_calls:

# Step 3: call the function

# Note: the JSON response may not always be valid; be sure to handle errors

available_functions = {

"get_stock_price": get_stock_price,

"get_game_score": get_game_score,

} # two functions in this example

messages.append(response_message) # extend conversation with assistant's reply

# Step 4: send the info for each function call and function response to the model

for tool_call in tool_calls:

function_name = tool_call.function.name

function_to_call = available_functions[function_name]

function_args = json.loads(tool_call.function.arguments)

if function_name == "get_stock_price":

function_response = function_to_call(parameters=function_args)

else:

function_response = function_to_call(team_name=function_args.get("team_name"))

messages.append(

{

"tool_call_id": tool_call.id,

"role": "tool",

"name": function_name,

"content": json.dumps(function_response) if function_name == "get_stock_price" else function_response,

}

) # extend conversation with function response

second_response = client.chat.completions.create(

model=MODEL,

messages=messages

) # get a new response from the model where it can see the function response

return second_response.choices[0].message.content

def gradio_interface(user_prompt):

return run_conversation(user_prompt)

if __name__ == "__main__":

interface = gr.Interface(fn=gradio_interface, inputs="text", outputs="text", title="Groq을 활용한 Llama 3 함수 호출 및 API 통합")

interface.launch()

위 코드는 사용자가 입력한 텍스트 기반의 질문을 받아들이고, 그에 따라 함수를 호출하거나 외부 API를 사용하여 요청에 대한 응답을 생성하는 프로그램입니다. 주요 구성 요소 및 기능은 다음과 같습니다:

- Groq 라이브러리 사용: Groq을 사용하여 Llama 3 모델에 연결하고, 이를 통해 자연어 처리 및 이해를 수행합니다. Llama 3은 사용자의 질문을 이해하고, 이에 따라 적절한 작업을 수행하기 위해 필요한 정보를 추출합니다.

- 함수 및 API 호출: 사용자의 질문에 기반하여 적절한 함수 또는 외부 API가 호출됩니다. 예를 들어, 사용자가 NBA 게임 결과를 묻는 경우, `get_game_score` 함수가 호출되어 해당 정보를 반환합니다. 주식 가격을 묻는 경우, Yahoo Finance API를 호출하여 실시간 주식 가격 정보를 가져옵니다.

- 응답 생성: 함수 또는 API 호출의 결과를 기반으로 사용자에게 응답이 생성됩니다. 이 응답은 자연스러운 대화 형식으로 구성되어 사용자가 이해하기 쉽게 제공됩니다.

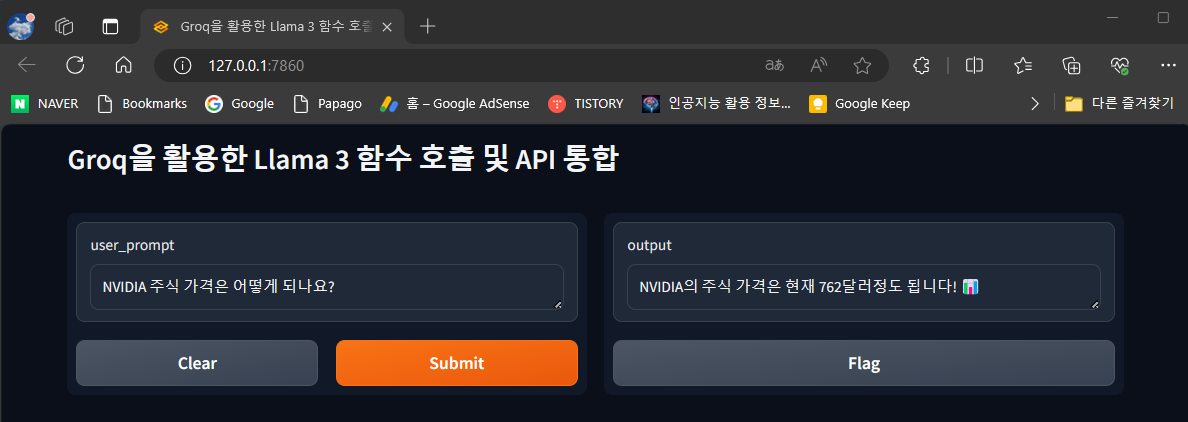

이 코드를 실행하면 아래 이미지와 같이 http://127.0.0.1:7860 주소에서 Gradio 인터페이스 웹 페이지가 열립니다.

app.py의 실행 초기화면에서 아래와 같이 NVIDIA의 주식가격을 질문하면 Yahoo Finance API를 호출하여 실시간 주식가격을 표시합니다. app.py의 코드 내 시스템 프롬프트에 "You are a function calling LLM that uses the data extracted from the get_stock_price and get_game_score functions to answer questions around stock prices and NBA game scores. Answer in Korean in conversational style."와 같이 입력해 놓았기 때문에 Llama 3가 한국어로 잘 대답해 줍니다. 대화체로 해달라고 했더니 이모지도 표현해 주었네요.

다음은 NBA 게임결과를 질문하였더니, 마찬가지로 api.py의 데이터와 일치하는 결과를 정확하게 대답해 주었습니다.

맺음말

오늘 블로그에서는 Groq을 활용한 Llama 3 함수 호출 및 API 통합 프로그램에 대한 소개와 실행 방법을 다루었습니다. 이 프로그램은 사용자가 Gradio 웹 인터페이스를 통해 NBA 게임 결과나 주식 가격을 질문하면, Groq은 사용자 질문에 맞는 API와 함수를 호출하고, 그 실행 결과를 Llama 3에게 전달하며, Llama 3은 실행 결과를 해석하여 입력된 질문에 맞는 대답을 출력합니다.

프로그램을 실행하기 위해 필요한 환경 설정 및 Groq API Key 발급에 대해 설명하였으며, 프로그램의 주요 구성 요소인 api.py와 app.py의 코드를 설명하고, 코드 실행 방법에 대해 안내하였습니다. 프로그램을 실행한 후에는 실제로 사용자가 입력한 주식 가격과 NBA 게임 결과 질문에 대한 Llama 3의 응답을 확인할 수 있었습니다.

이 블로그를 통해 Groq과 Llama 3을 활용하여 자연어 처리 및 함수 호출, API 통합에 대한 방법을 익히는데 도움이 되셨기를 바라면서 오늘 내용을 마치겠습니다. 저는 다음에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.🚀✨

2024.04.19 - [대규모 언어모델] - Llama 3: 추론 테스트 및 스네이크 게임 코딩, 에러 없이 한번에 성공!

Llama 3: 추론 테스트 및 스네이크 게임 코딩, 에러 없이 한번에 성공!

안녕하세요! 오늘은 메타의 최신 대형 언어 모델 Llama 3에 대해서 알아보겠습니다. Llama 3은 8B(80억 개)와 70B(700억 개)의 학습 가능한 매개변수를 가진 두 종류의 모델을 발표하였는데요, 입력 컨텍

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| OpenELM: 애플 최초 오픈소스 소형 언어 모델, 핵심기술과 성능비교 (2) | 2024.04.28 |

|---|---|

| Phi-3: 마이크로소프트의 작지만 강한 소형 언어 모델, 고난도 스네이크 게임 성공!! (4) | 2024.04.25 |

| Llama 3: 추론 테스트 및 스네이크 게임 코딩, 에러 없이 한번에 성공! (3) | 2024.04.19 |

| 야놀자 한국어 언어 모델 EEVE와 Ollama로 구현하는 로컬 RAG (0) | 2024.04.17 |

| [AI 논문] 올해의 한국어 LLM에 선정된 야놀자 언어 모델, EEVE (0) | 2024.04.13 |