안녕하세요! 오늘은 Mistral AI에서 공개한 최신 언어 모델, Mistral Small 3에 대해 살펴보겠습니다. Mistral Small 3는 240억 개의 파라미터를 가진 대규모 언어 모델(LLM)로, 2025년 1월 30일에 출시되었습니다. Mistral Small 3는 성능과 효율성을 동시에 고려하여 경량화된 구조를 유지하면서도 이전 버전보다 뛰어난 자연어 처리 능력을 갖추고 있으며, 로컬 노트북에서도 실행할 수 있을 정도로 최적화되어 있습니다. 또한, Apache 2.0 라이선스로 공개되어 개발자와 기업이 자유롭게 활용할 수 있다는 점도 큰 장점입니다. 이번 블로그에서는 Mistral Small 3의 주요 특징, 벤치마크 결과와 실제 사용법을 살펴보고, 코딩, 수학, 추론 성능을 테스트해 보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

1. Mistral Small 3 개요

Mistral Small 3는 주로 아주 어려운 AI 작업보다는 빠르고 효율적인 성능이 요구되는, 일반적으로 많이 사용되는 생성 AI 작업에 초점을 맞춰 설계되었습니다. 특히 로컬 배포에 최적화된 크기로 설계되어, 단일 RTX 4090 또는 32GB RAM 맥북에서 실행 가능하고, 경쟁 모델에 비해 훨씬 적은 레이어를 가지고 있으며, 이로 인해 전달 시간(forward pass)이 크게 감소했습니다.

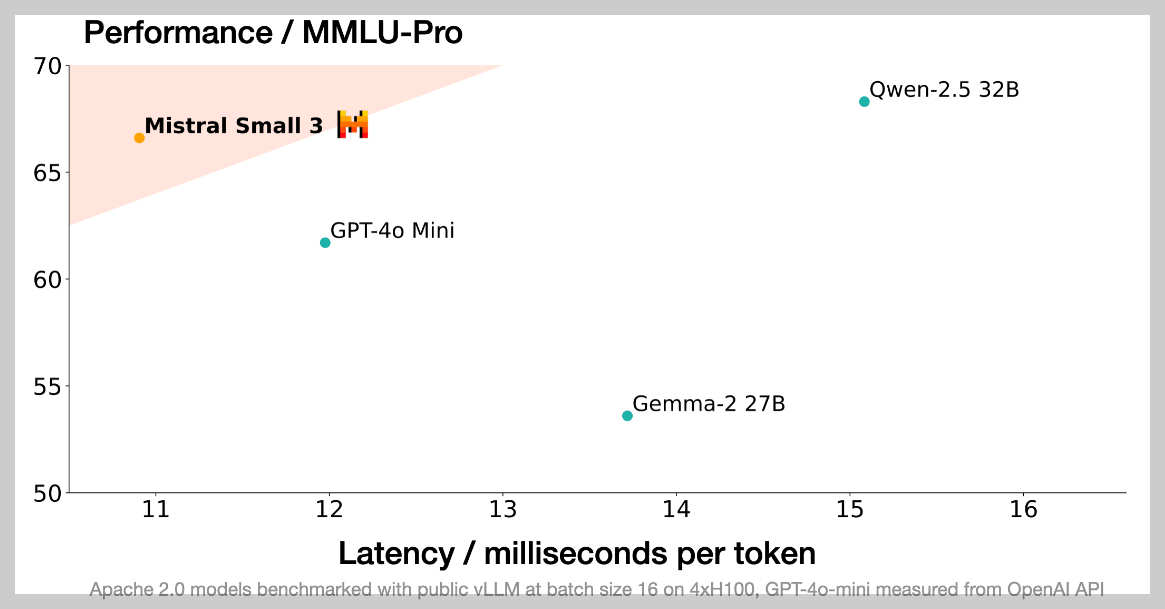

아래 그래프에서 Mistral Small 3는 다른 모델들과 비교하여 상대적으로 낮은 지연 시간(토큰당 밀리초)과 높은 성능을 보여주며, 빠른 응답 속도를 제공하면서도, 경쟁 모델 대비 준수한 성능을 유지하고 있음을 알 수 있습니다.

Mistral Small 3는 사전 학습된 모델과 명령 조정된(instruction-tuned) 모델 모두를 제공하여, 다양한 사용 사례에 적용 가능하도록 지원합니다.

- 사전 훈련된 모델 (Pre-trained model): 특정 작업에 맞춰 조정되지 않은 기본적인 언어 모델입니다. 다양한 언어적 작업을 위한 강력한 기반으로 사용될 수 있습니다.

- Instruction-tuned 모델: 특정 지시(instruction)에 따라 작동하도록 미세 조정된 모델입니다. 즉, 사용자의 명령을 이해하고 그에 따라 적절한 응답을 생성하도록 훈련되었습니다. 이 모델은 코드 생성, 수학 문제 해결, 일반 지식 질문 응답, 명령어 수행 등의 작업에 더 적합합니다.

https://mistral.ai/news/mistral-small-3/

Mistral Small 3

Apache 2.0, 81% MMLU, 150 tokens/s

mistral.ai

2. Mistral Small 3 특징 및 주요 기능

Mistral Small 3의 주요 특징 및 기능은 다음과 같습니다.

- 강력한 언어 및 명령 추종 성능: Mistral Small 3는 일반적인 언어 작업 및 명령 추종 성능에서 뛰어난 성능을 보입니다. 이는 다양한 생성 AI 작업에 적용할 수 있는 강력한 기반을 제공합니다.

- 경쟁 모델 대비 성능: Mistral Small 3는 Llama 3.3 70B 또는 Qwen 32B와 같은 대형 모델과 경쟁할 수 있으며, GPT-4o-mini와 같은 모델의 훌륭한 대체재로 활용될 수 있습니다. 특히 Llama 3.3 70B instruct와 동등한 수준의 성능을 유지하면서 3배 이상 빠른 속도를 제공합니다.

- 효율성: Mistral Small 3는 MMLU 벤치마크에서 81% 이상의 정확도를 기록하며, 150 토큰/초의 빠른 처리 속도를 자랑합니다. 이는 동급 모델 중 가장 효율적인 모델임을 의미합니다.

- 오픈소스 커뮤니티 지원: Mistral Small 3는 Hugging Face, Ollama, Kaggle, Together AI, Fireworks AI 등 다양한 플랫폼을 통해 제공됩니다. 이는 오픈소스 커뮤니티의 참여와 발전을 적극적으로 지원하려는 Mistral AI의 노력을 보여줍니다.

https://huggingface.co/mistralai/Mistral-Small-24B-Instruct-2501

mistralai/Mistral-Small-24B-Instruct-2501 · Hugging Face

Model Card for Mistral-Small-24B-Instruct-2501 Mistral Small 3 ( 2501 ) sets a new benchmark in the "small" Large Language Models category below 70B, boasting 24B parameters and achieving state-of-the-art capabilities comparable to larger models! This mode

huggingface.co

3. Mistral Small 3 벤치마크 결과

Mistral Small 3의 벤치마크 결과는 다음과 같습니다.

- MMLU 정확도: Mistral Small 24B (Base)는 81% 이상의 정확도를 기록하며, 다른 모델들과 비교했을 때, Llama 3.1 70B와 비슷한 수준이며, Gemma 2 27B 보다 높은 언어 성능을 나타냅니다.

- 속도: 150 토큰/초의 처리 속도를 제공하여, 동급 모델 중 가장 효율적인 모델임을 입증했습니다.

- 인간 평가: 외부 제3자 공급업체를 통해 1000개 이상의 독점 코딩 및 일반 프롬프트에 대한 인간 평가를 수행한 결과, Mistral Small 3가 다른 모델에 비해 선호되는 경우가 많았습니다.

- 명령 조정 성능: Mistral Small 3는 코드, 수학, 일반 지식, 명령 추종 벤치마크에서 자신의 3배 크기의 오픈 소스 모델 및 독점 GPT-4o-mini 모델과 경쟁력 있는 성능을 보였습니다. Wildbench, Arena hard, MTBench 등의 평가에서 GPT-4o-2024-05-13 모델을 기반으로 평가되었습니다.

- 사전 학습 성능: Mistral Small 3는 24B 모델임에도 불구하고 Llama 3.3 70B와 같은 3배 더 큰 모델과 경쟁하는 뛰어난 성능을 보여주었습니다.

4. Mistral Small 3 사용방법

Mistral Small 3를 사용할 수 있는 방법은 다음과 같습니다.

- Mistral AI la Plateforme: mistral-small-latest 또는 mistral-small-2501을 사용하여 텍스트 생성을 수행할 수 있습니다. 자세한 내용은 Mistral AI의 문서를 참고하세요.

- 파트너 플랫폼: Hugging Face (base model), Ollama, Kaggle, Together AI, Fireworks AI, IBM watsonx와 같은 플랫폼을 통해 사용할 수 있습니다. 각 플랫폼의 사용법에 따라 Mistral Small 3를 사용하면 됩니다. 참고로 Fireworks AI를 이용해서 Mistral Small 3 챗봇을 만드는 코드는 아래와 같습니다.

import streamlit as st

import requests

import json

# Streamlit 페이지 설정

st.set_page_config(page_title="Mistral 챗봇", page_icon="🤖")

st.title("Mistral Small 3 AI 챗봇")

# API 키 입력 필드

api_key = st.sidebar.text_input("Fireworks API 키를 입력하세요", type="password")

# 세션 상태 초기화

if "messages" not in st.session_state:

st.session_state.messages = []

# 채팅 기록 표시

for message in st.session_state.messages:

with st.chat_message(message["role"]):

st.markdown(message["content"])

# 사용자 입력

if prompt := st.chat_input("메시지를 입력하세요"):

# 사용자 메시지 표시

st.chat_message("user").markdown(prompt)

st.session_state.messages.append({"role": "user", "content": prompt})

# API 요청 설정

url = "https://api.fireworks.ai/inference/v1/chat/completions"

payload = {

"model": "accounts/fireworks/models/mistral-small-24b-instruct-2501",

"max_tokens": 4096,

"top_p": 1,

"top_k": 40,

"presence_penalty": 0,

"frequency_penalty": 0,

"temperature": 0.6,

"messages": st.session_state.messages

}

headers = {

"Accept": "application/json",

"Content-Type": "application/json",

"Authorization": f"Bearer {api_key}"

}

# API 요청 및 응답 처리

if api_key:

try:

response = requests.post(url, headers=headers, json=payload)

response_data = response.json()

# 응답 메시지 표시

assistant_response = response_data['choices'][0]['message']['content']

st.chat_message("assistant").markdown(assistant_response)

st.session_state.messages.append({"role": "assistant", "content": assistant_response})

except Exception as e:

st.error(f"오류가 발생했습니다: {str(e)}")

else:

st.warning("API 키를 입력해주세요.")

- 로컬 환경: Mistral Small 3는 Apache 2.0 라이선스로 배포되므로 모델 가중치를 다운로드하여 로컬 환경에서 실행할 수 있습니다. 특히 Ollama와 같은 도구를 활용하면 양자화(Quantization)를 통해 RTX 4090 GPU 또는 32GB RAM을 가진 Macbook에서도 개인적으로 실행할 수 있습니다.

https://ollama.com/library/mistral-small

mistral-small

Mistral Small 3 sets a new benchmark in the “small” Large Language Models category below 70B.

ollama.com

5. Mistral Small 3 성능 테스트

다음은 Mistral Small 3의 코딩, 수학, 추론 성능을 테스트해 보겠습니다. 코딩은 코딩 교육 사이트 edabit.com의 Python, JavaScript, C++ 문제를 통해 테스트하고, 수학 문제는 기하학, 확률, 수열, 최적화, 복합 문제 등으로 구성된 6개의 문제를 사용했습니다. 추론 문제도 총 6문제이고, 모든 답은 재시도 없이 첫 번째 시도의 채점 결과를 그대로 반영하였습니다.

1) 코딩 테스트

| Mistral Small 3 | Medium | Hard | Very Hard | Expert |

| Python | Pass | Pass | Pass | Pass |

| JavaScript | Pass | Pass | Pass | Pass |

| C++ | Pass | Pass | Pass | Fail |

코딩 테스트 결과 Mistral Small 3는 C++ Expert 난이도를 제외하고 모든 난이도 문제를 성공하였습니다.

2) 수학 및 추론 테스트

| No. | 문제 구분 | 문제 | Mistral Small 3 |

| 1 | 기초 대수 문제 | 두 숫자 x와 y가 있습니다. 이들이 만족하는 식은 3x+4y=12이며, x−2y=1입니다. x와 y의 값을 구하세요 | Pass |

| 2 | 기하학 문제 | 반지름이 7cm인 원의 넓이를 구하세요. π=3.14159로 계산하세요. | Pass |

| 3 | 확률 문제 | 주사위를 두 번 던졌을 때, 두 숫자의 합이 7이 될 확률을 구하세요. | Pass |

| 4 | 수열 문제 | 첫 번째 항이 3이고, 공차가 5인 등차수열의 10번째 항을 구하세요. | Pass |

| 5 | 최적화 문제 | 어떤 직사각형의 둘레가 36cm입니다. 이 직사각형의 넓이를 최대화하려면 가로와 세로의 길이는 각각 얼마여야 하나요? | Pass |

| 6 | 복합 문제 | 복소평면에서 다음 극한값을 구하시오. lim[n→∞] (1 + i/n)^(n^2) 여기서 i는 허수단위 (i^2 = -1)입니다. | Pass |

수학 테스트에서는 기초 대수, 기하학, 확률, 수열, 최적화, 복합문제 등 6문제를 모두 성공하였습니다.

| No. | 문제 | Mistral Small 3 |

| 1 | 5학년과 6학년 학생 160명이 나무 심기에 참가하였습니다. 6학년 학생들이 각각 평균5그루,5학년 학생들이 각각 평균 3그루씩 심은 결과 모두 560그루를 심었습니다. 나무심기에 참가한 5,6학년 학생은 각각 몇명일까요? |

Pass |

| 2 | 베티는 새 지갑을 위해 돈을 모으고 있습니다. 새 지갑의 가격은 $100입니다. 베티는 필요한 돈의 절반만 가지고 있습니다. 그녀의 부모는 그 목적을 위해 $15를 주기로 결정했고, 할아버지와 할머니는 그녀의 부모들의 두 배를 줍니다. 베티가 지갑을 사기 위해 더 얼마나 많은 돈이 필요한가요? | Pass |

| 3 | 전국 초등학생 수학경시대회가 열렸는데 영희,철수,진호 세사람이 참가했습니다. 그들은 서울,부산,인천에서 온 학생이고 각각 1등,2등,3등 상을 받았습니다. 다음과 같은 사항을 알고 있을때 진호는 어디에서 온 학생이고 몇등을 했습니까? 1) 영희는 서울의 선수가 아닙니다. 2) 철수는 부산의 선수가 아닙니다. 3)서울의 선수는 1등이 아닙니다. 4) 부산의 선수는 2등을 했습니다. 5)철수는 3등이 아닙니다. | Pass |

| 4 | 방 안에는 살인자가 세 명 있습니다. 어떤 사람이 방에 들어와 그중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 남아 있는 살아있는 살인자는 몇 명입니까? 단계별로 추론 과정을 설명하세요. | Pass |

| 5 | A marble is put in a glass. The glass is then turned upside down and put on a table. Then the glass is picked up and put in a microwave. Where's the marble? Explain your reasoning step by step. | Pass |

| 6 | 도로에 5대의 큰 버스가 차례로 세워져 있는데 각 차의 뒤에 모두 차의 목적지가 적혀져 있습니다. 기사들은 이 5대 차 중 2대는 A시로 가고, 나머지 3대는 B시로 간다는 사실을 알고 있지만 앞의 차의 목적지만 볼 수 있습니다. 안내원은 이 몇 분의 기사들이 모두 총명할 것으로 생각하고 그들의 차가 어느 도시로 가야 하는지 목적지를 알려 주지 않고 그들에게 맞혀 보라고 하였습니다. 먼저 세번째 기사에게 자신의 목적지를 맞혀 보라고 하였더니 그는 앞의 두 차에 붙여 놓은 표시를 보고 말하기를 "모르겠습니다." 라고 말하였습니다. 이것을 들은 두번째 기사도 곰곰히 생각해 보더니 "모르겠습니다." 라고 말하였습니다. 두명의 기사의 이야기를 들은 첫번째 기사는 곰곰히 생각하더니 자신의 목적지를 정확하게 말하였습니다. 첫번째 기사가 말한 목적지는 어디입니까? | Pass |

추론 성능 테스트에서 모두 성공하였습니다.

| 구분 | 코딩 테스트 결과 | 수학 테스트 결과 | 추론 테스트 결과 | 평균 |

| Mistral Small 3 | 91.67 | 100 | 100 | 97.22 |

| DeepSeek-R1 | 100 | 100 | 100 | 100 |

블로그의 테스트를 종합한 결과, Mistral Small 3는 DeepSeek-R1보다 약간 낮은 점수인 97.22점을 기록하였습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

6. 맺음말

Mistral Small 3는 뛰어난 성능, 효율성, 개방성을 결합한 혁신적인 대규모 언어 모델입니다. 이 모델은 Apache 2.0 라이선스로 제공되어 개발자와 기업 모두가 자유롭게 사용할 수 있으며, 로컬 배포에 최적화된 크기와 빠른 처리 속도를 제공합니다.

Mistral Small 3을 테스트해 본 후기는 다음과 같습니다.

- 무료이며, 응답 속도가 빠르다.

- Hugging Face, Ollama, Kaggle 등 여러 플랫폼에서 사용 가능하다.

- Llama 3.3 70B, GPT-4o-mini를 대체할 수 있다.

이 글을 통해 Mistral Small 3의 다양한 측면을 이해하고, 여러분의 AI 연구 및 개발에 도움이 되기를 바랍니다. 저는 그럼 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.11.26 - [AI 도구] - 🧑💻미스트랄의 새로운 AI 비서 le Chat: 웹 검색, Canvas, 이미지 생성까지!

🧑💻미스트랄의 새로운 AI 비서 le Chat: 웹 검색, Canvas, 이미지 생성까지!

안녕하세요! 오늘은 Mistral AI가 선보인 차세대 AI 도우미인 le Chat을 소개해 드리겠습니다. le Chat은 무료로 제공되는 생성형 AI로, 단순히 대화를 나누는 것을 넘어 창의적인 작업부터 복잡한 문서

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| 🐋DeepSeek-VL2: 고급 멀티모달 이해를 위한 MoE 비전-언어 모델 (6) | 2025.02.09 |

|---|---|

| ✨Gemini 2.0 패밀리: 최대 200만 토큰 지원하는 구글의 최신 AI 모델군 (4) | 2025.02.07 |

| 🤖⚡o3-mini: DeepSeek-R1과 경쟁할 OpenAI의 최신 추론 모델 (5) | 2025.02.01 |

| 🔥Qwen2.5 Max: DeepSeek-V3를 앞선 알리바바의 대규모 MoE 모델 (8) | 2025.01.31 |

| 🎨🤖Janus: DeepSeek AI의 최신 멀티모달 생성 모델 분석 (7) | 2025.01.30 |