안녕하세요! 오늘은 알리바바 클라우드가 새롭게 공개한 대규모 MoE(Mixture-of-Experts) 모델, Qwen2.5-Max에 대해 살펴보겠습니다. Qwen2.5-Max는 20조 개 이상의 토큰으로 학습된 거대한 언어 모델로, MoE 아키텍처를 기반으로 강력한 추론 및 문제 해결 능력을 갖추고 있습니다. 특히, 지도 학습(SFT) 및 인간 피드백 기반 강화 학습(RLHF)을 적용하여 사용자 지시에 더욱 정밀하게 반응하며, 인간 선호도에 맞는 답변을 생성하는 능력을 극대화했습니다. 이 블로그에서는 Qwen2.5-Max의 개요 및 주요 특징, 벤치마크 결과, 그리고 성능 테스트까지 자세히 분석해 보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

1. Qwen 2.5 Max 개요

Qwen2.5 Max는 알리바바 클라우드에서 개발한 대규모 MoE (Mixture-of-Experts) 모델입니다. 이 모델은 대규모 데이터와 모델 크기 확장을 통해 모델 지능을 향상시키려는 목표를 가지고 개발되었으며, 엄선된 지도 학습(Supervised Fine-Tuning, SFT) 및 인간 피드백 기반 강화 학습(Reinforcement Learning from Human Feedback, RLHF) 방법론을 통해 사후 학습을 진행했습니다.

| 구분 | 설명 |

| API 모델 이름 | qwen-max-2025-01-25 |

| 모델 크기 | 1000억 개 이상의 매개변수를 가진 초거대 모델 |

| 사전 학습 | 20조 개 이상의 토큰으로 사전 학습됨 |

| 추가 학습 | SFT(Supervised Fine-Tuning) 및 RLHF(Reinforcement Learning from Human Feedback) 방법론 활용 |

| 컨텍스트 길이 | 8,000 토큰 지원 |

| 입력 토큰 수 제한 | 최대 6,000개 입력 토큰 제한 |

https://qwenlm.github.io/blog/qwen2.5-max/

Qwen2.5-Max: Exploring the Intelligence of Large-scale MoE Model

QWEN CHAT API DEMO DISCORD It is widely recognized that continuously scaling both data size and model size can lead to significant improvements in model intelligence. However, the research and industry community has limited experience in effectively scalin

qwenlm.github.io

Qwen2.5-Max는 대규모 언어 모델(LLM) 연구의 최전선에 있는 모델입니다. MoE 아키텍처를 채택하여 모델 용량과 효율성을 극대화했으며, 엄청난 양의 데이터를 학습하여 복잡한 추론 및 문제 해결 능력을 갖추었습니다. 또한, SFT 및 RLHF를 통해 사용자의 지시에 더 잘 따르고, 인간 선호도에 부합하는 답변을 생성하도록 훈련되었습니다.

2. Qwen 2.5 Max 특징 및 주요 기능

Qwen2.5-Max는 다음과 같은 주요 특징과 기능을 제공합니다.

- 대규모 MoE 모델: MoE 아키텍처는 여러 전문가 네트워크를 사용하여 모델의 용량을 확장하고 학습 효율성을 높입니다. 이는 모델이 더 복잡한 작업을 처리하고 더 많은 지식을 저장할 수 있음을 의미합니다.

- 20조 개 이상의 토큰으로 사전 학습: Qwen2.5-Max는 광범위한 텍스트 데이터 세트로 학습되어 다양한 주제와 스타일에 대한 풍부한 지식을 갖추고 있습니다. 이는 모델이 다양한 질문에 대해 정확하고 유용한 답변을 제공할 수 있도록 합니다.

- SFT 및 RLHF를 통한 사후 학습: 모델은 지도 학습을 통해 특정 작업에 대해 정확하고 일관된 답변을 제공하도록 미세 조정되었으며, 인간 피드백 기반 강화 학습을 통해 인간 선호도에 맞는 답변을 생성하도록 훈련되었습니다. 이는 모델이 사용자 지시에 더 잘 따르고, 창의적이고 매력적인 답변을 생성할 수 있도록 합니다.

| Qwen2.5-Max 데모 영상 |

- 강력한 추론 및 문제 해결 능력: 대규모 학습과 정교한 훈련 과정을 통해 Qwen2.5-Max는 복잡한 추론, 논리적 사고, 문제 해결 능력을 갖추고 있습니다. 이는 모델이 일반적인 질문뿐만 아니라 어려운 학문적 문제나 코딩 문제에도 대처할 수 있음을 의미합니다.

- 다양한 응용 분야 지원: Qwen2.5-Max는 다양한 응용 분야를 지원합니다. 챗봇, 콘텐츠 생성, 텍스트 요약, 번역, 법률 문서 작성 등 다양한 분야에서 유용하게 활용될 수 있습니다. 특히, 코드 생성 및 코드 이해 능력은 소프트웨어 개발 및 자동화 분야에 큰 영향을 미칠 수 있습니다.

- OpenAI API 호환: Qwen2.5-Max는 OpenAI API와 호환되는 인터페이스를 제공하여 사용자가 기존의 개발 환경을 그대로 활용할 수 있도록 지원합니다. 따라서, 기존 OpenAI API 사용 경험이 있는 사용자는 Qwen2.5-Max를 쉽게 활용할 수 있습니다.

- 클라우드 기반 API 제공: 알리바바 클라우드를 통해 API를 제공하므로, 사용자는 복잡한 모델 배포 및 관리 부담 없이 Qwen2.5-Max의 강력한 성능을 활용할 수 있습니다.

3. Qwen 2.5 Max 벤치마크 결과

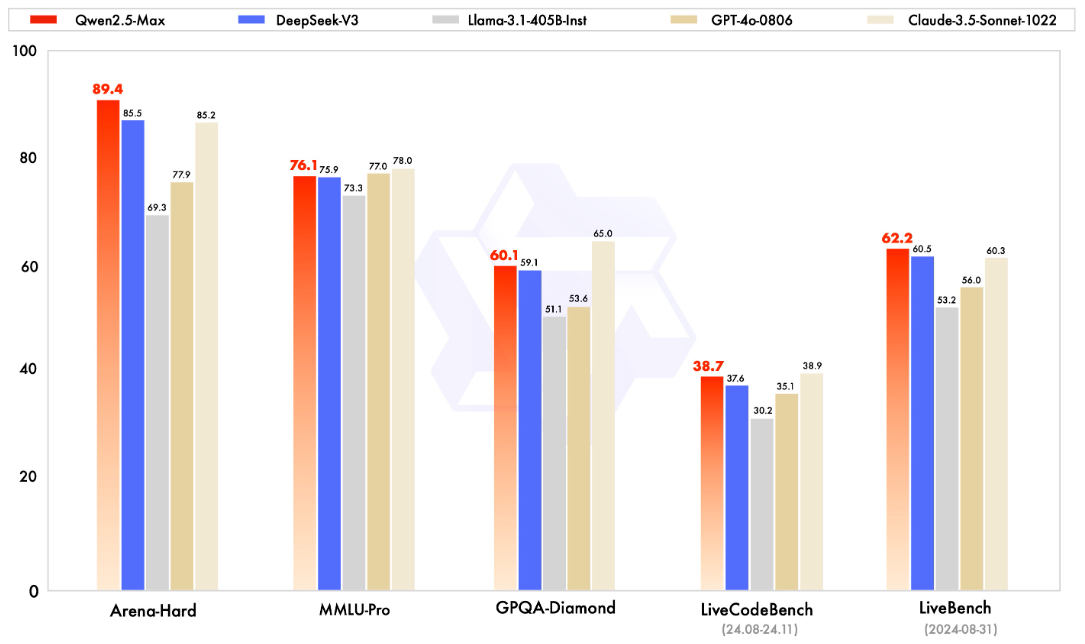

Qwen2.5-Max는 다양한 벤치마크에서 뛰어난 성능을 입증했습니다. 알리바바 클라우드는 커뮤니티에서 큰 관심을 갖는 여러 벤치마크를 통해 Qwen2.5-Max의 성능을 평가했습니다. 여기에는 대학 수준의 지식을 테스트하는 MMLU-Pro, 코딩 능력을 평가하는 LiveCodeBench, 전반적인 능력을 종합적으로 테스트하는 LiveBench, 그리고 인간 선호도를 평가하는 Arena-Hard가 포함됩니다.

기본 모델 성능: 모델 자체의 잠재력과 기본적인 성능 평가

- 기본 모델의 성능을 평가할 때, GPT-4o 및 Claude-3.5-Sonnet과 같은 상용 모델에 접근할 수 없었기 때문에, Qwen2.5-Max는 DeepSeek V3 (최고의 공개 MoE 모델), Llama-3.1-405B (최대 규모의 공개 밀집형 모델), 그리고 Qwen2.5-72B (최고 공개 밀집형 모델)와 비교되었습니다.

- 결과적으로 Qwen2.5-Max 기본 모델은 대부분의 벤치마크에서 상당한 우위를 보였습니다. 이는 Qwen2.5-Max가 뛰어난 기초 성능을 가지고 있음을 의미합니다.

Instruct 모델 성능: 사용자가 직접 사용할 때의 성능

- Qwen2.5-Max는 chat 및 코딩과 같은 다운스트림 응용 프로그램에 사용될 수 있는 instruct 모델에서 DeepSeek V3를 능가하는 성능을 보였습니다. 구체적으로, Arena-Hard, LiveBench, LiveCodeBench, GPQA-Diamond와 같은 벤치마크에서 DeepSeek V3보다 우수한 결과를 보여주었으며, MMLU-Pro를 포함한 다른 평가에서도 경쟁력 있는 결과를 기록했습니다.

- Qwen2.5-Max는 GPT-4o 및 Claude-3.5-Sonnet과 같은 최고의 상용 모델과 비교했을 때도 견줄만한 성능을 나타냈습니다. 이는 Qwen2.5-Max가 상용 모델에 버금가는 수준의 성능을 제공할 수 있음을 시사합니다.

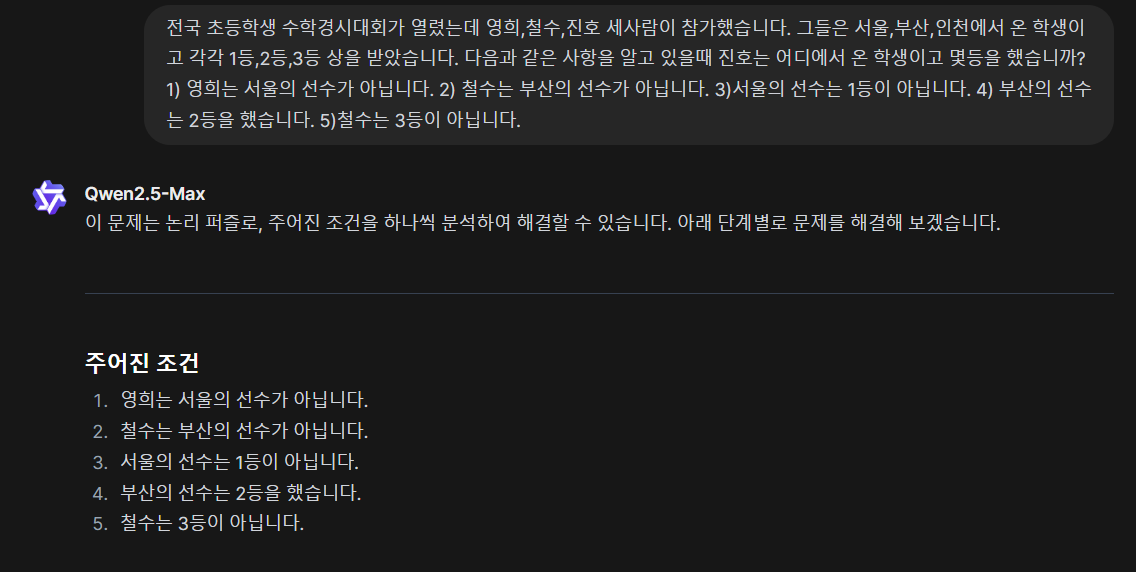

4. Qwen 2.5 Max 성능 테스트

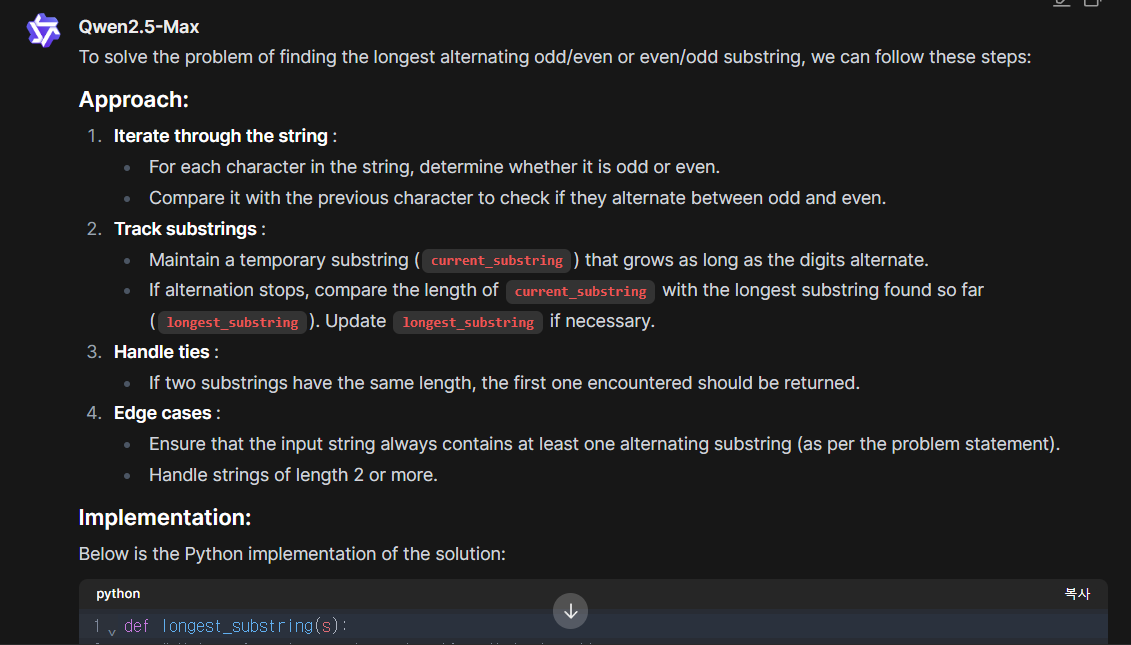

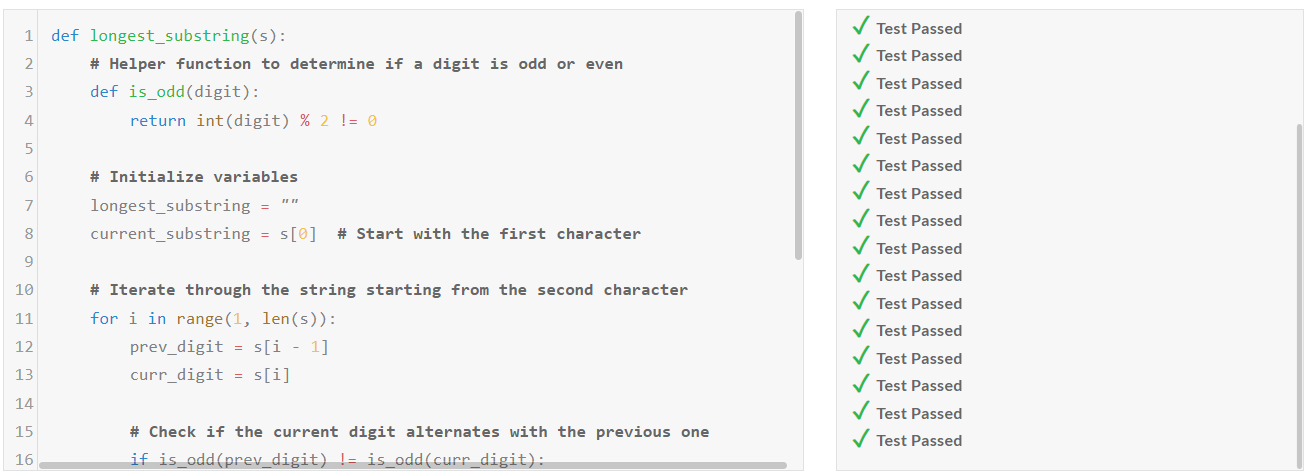

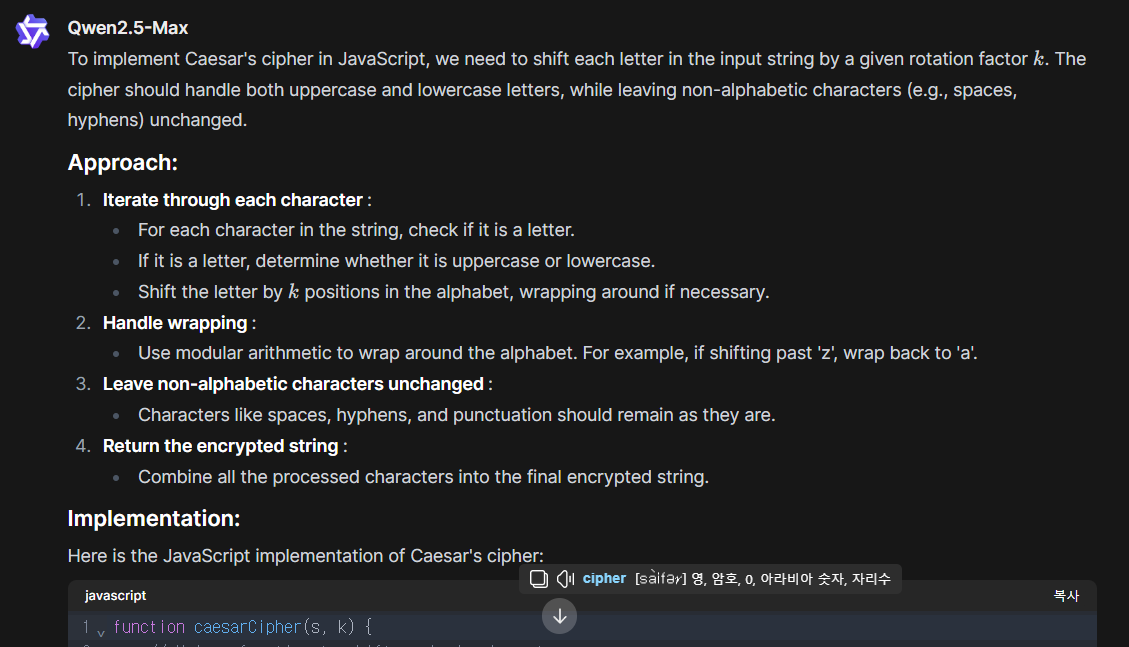

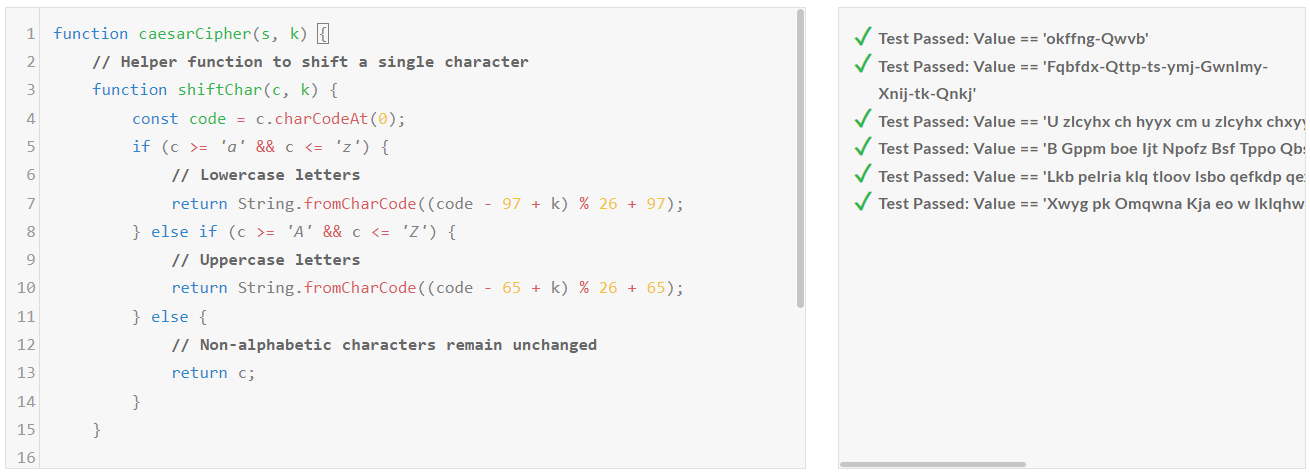

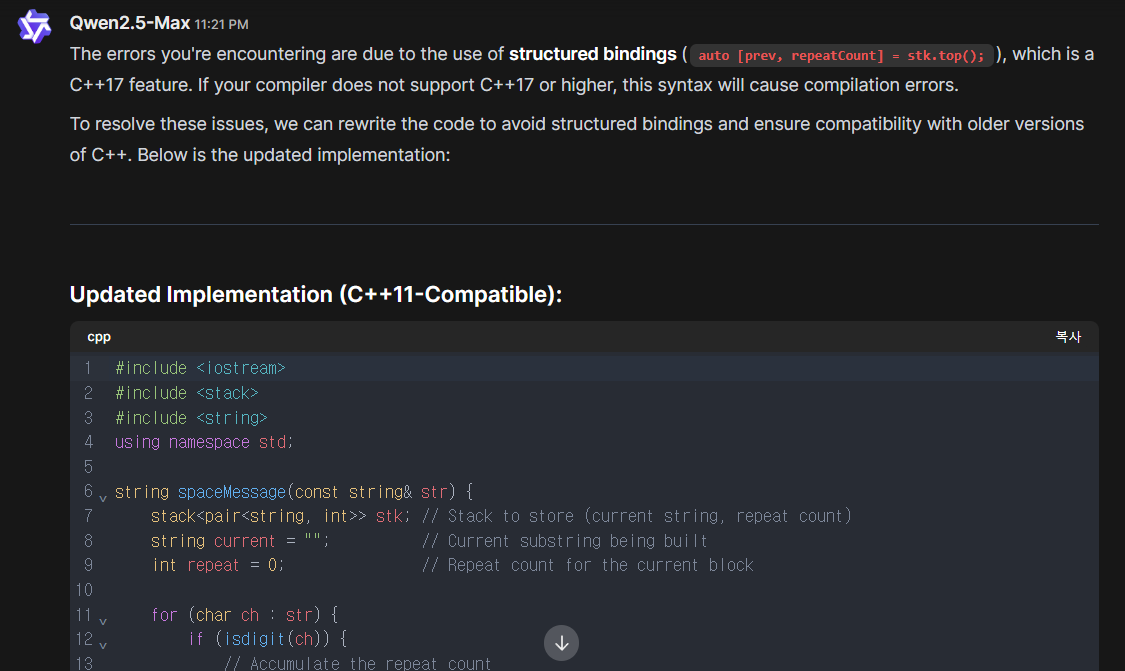

다음은 Qwen2.5-Max의 코딩, 수학, 추론 성능을 테스트해 보겠습니다. 테스트는 https://chat.qwenlm.ai/ 사이트에서 진행하였으며, 코딩은 코딩 교육 사이트 edabit.com의 Python, JavaScript, C++ 문제를 통해 테스트하고, 수학 문제는 기하학, 확률, 수열, 최적화, 복합 문제 등으로 구성된 6개의 문제를 사용했습니다. 모든 평가 항목은 재시도 없이 첫 번째 시도의 채점 결과를 그대로 반영하였습니다.

1) 코딩 테스트

| Qwen2.5-Max | Medium | Hard | Very Hard | Expert |

| Python | Pass | Pass | Pass | Pass |

| JavaScript | Pass | Pass | Pass | Pass |

| C++ | Pass | Pass | Pass | Fail |

코딩 테스트 결과 C++ Expert 난이도를 제외하고 모든 난이도 문제를 성공하였습니다.

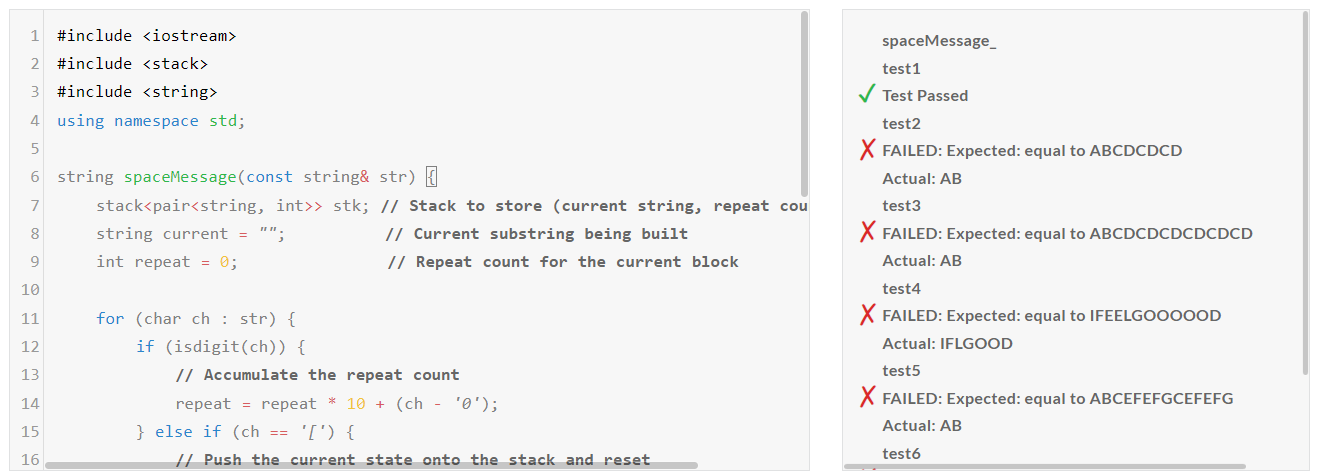

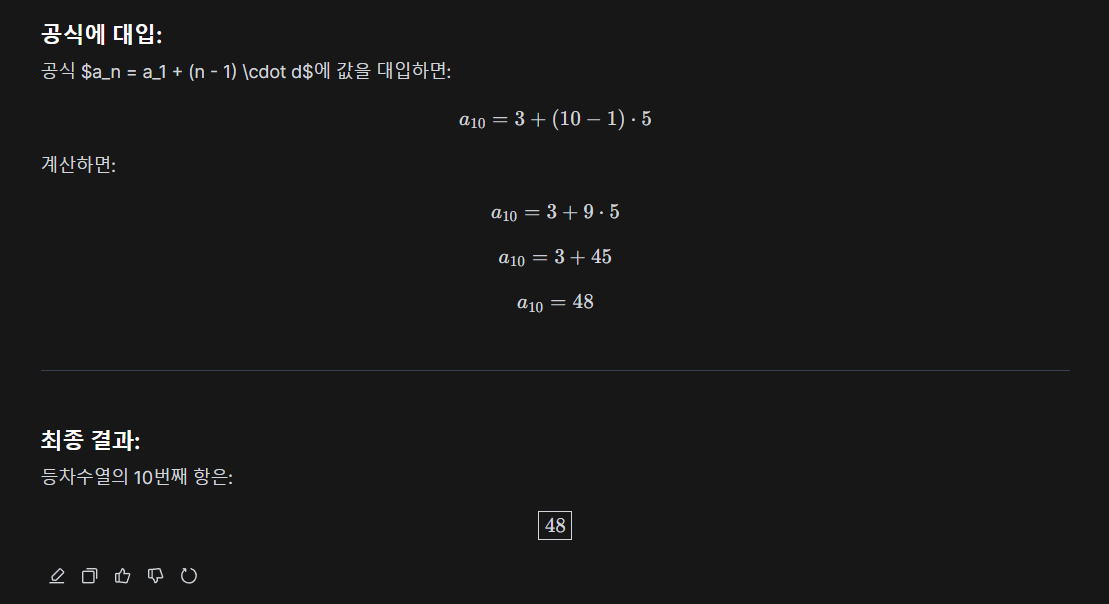

2) 수학 테스트

| No. | 문제 구분 | 문제 | Qwen2.5-Max |

| 1 | 기초 대수 문제 | 두 숫자 𝑥 x와 𝑦 y가 있습니다. 이들이 만족하는 식은 3 𝑥 + 4 𝑦 = 12 3x+4y=12이며, 𝑥 − 2 𝑦 = 1 x−2y=1입니다. 𝑥 x와 𝑦 y의 값을 구하세요 | Pass |

| 2 | 기하학 문제 | 반지름이 7cm인 원의 넓이를 구하세요. 𝜋 = 3.14159 π=3.14159로 계산하세요. | Pass |

| 3 | 확률 문제 | 주사위를 두 번 던졌을 때, 두 숫자의 합이 7이 될 확률을 구하세요. | Pass |

| 4 | 수열 문제 | 첫 번째 항이 3이고, 공차가 5인 등차수열의 10번째 항을 구하세요. | Pass |

| 5 | 최적화 문제 | 어떤 직사각형의 둘레가 36cm입니다. 이 직사각형의 넓이를 최대화하려면 가로와 세로의 길이는 각각 얼마여야 하나요? | Pass |

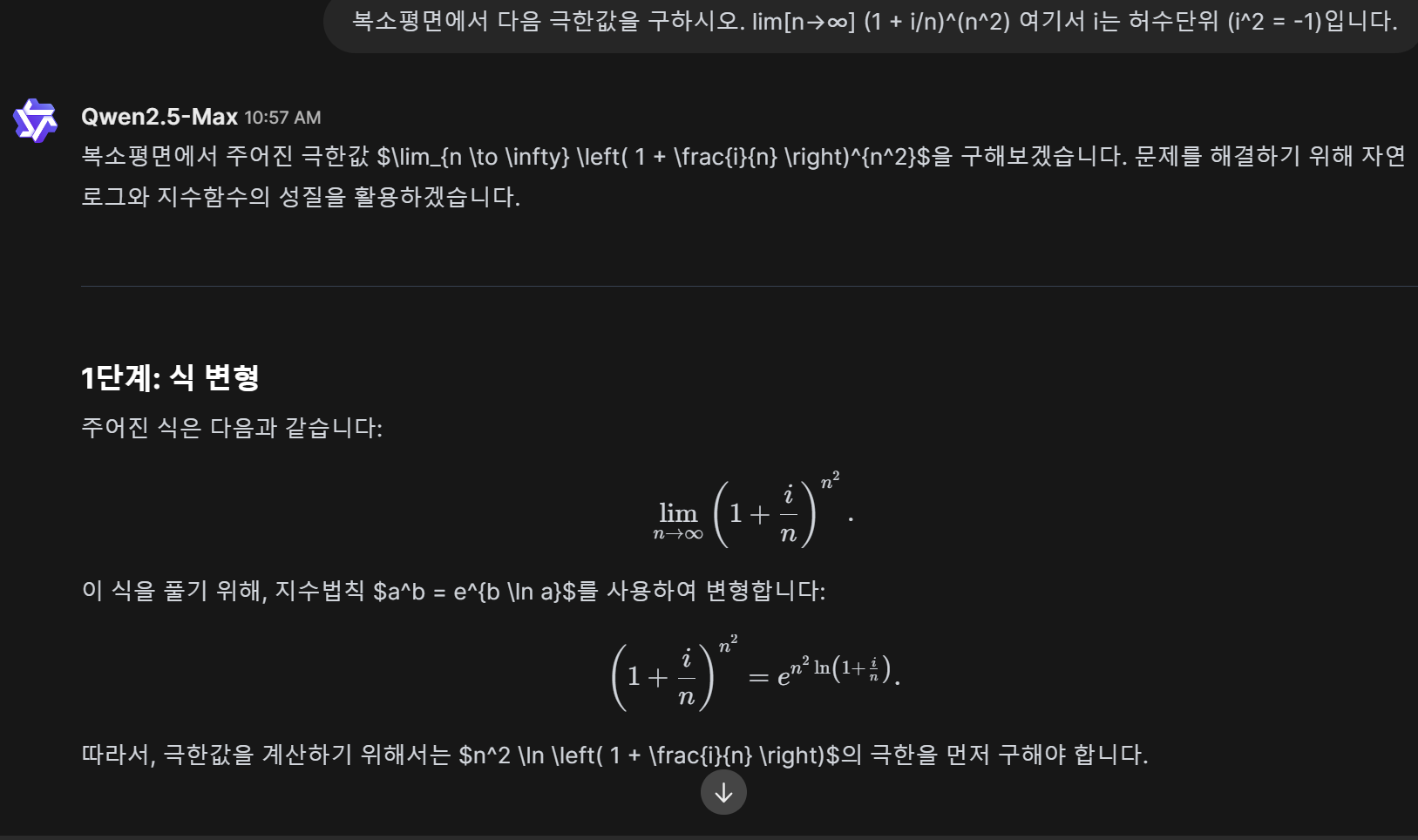

| 6 | 복합 문제 | 복소평면에서 다음 극한값을 구하시오. lim[n→∞] (1 + i/n)^(n^2) 여기서 i는 허수단위 (i^2 = -1)입니다. | Pass |

수학 테스트에서는 기초 대수, 기하학, 확률, 수열, 최적화, 복합문제 등 6문제를 모두 성공하였습니다.

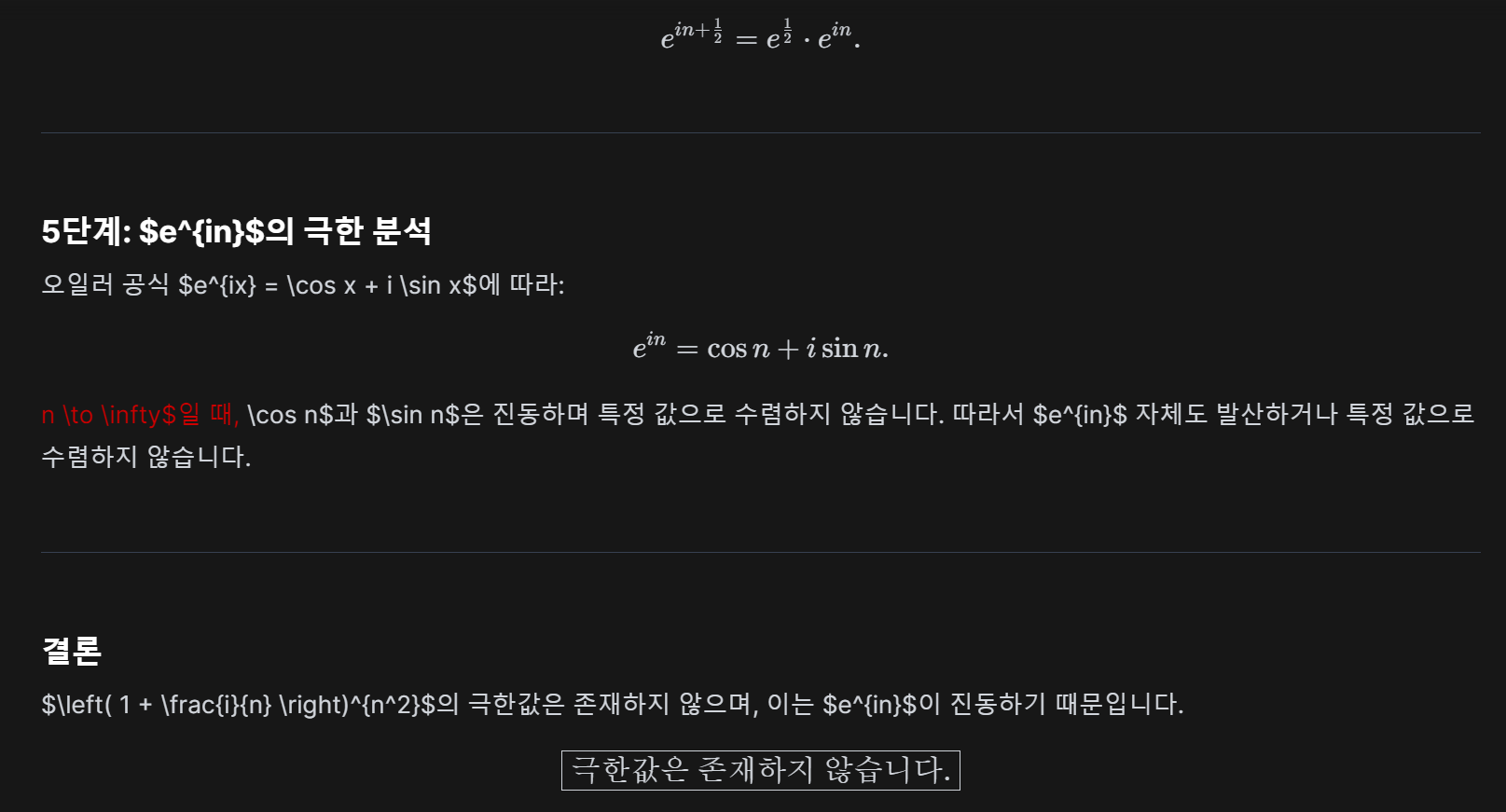

3) 추론 테스트

| No. | 문제 | Qwen2.5 -Max |

| 1 | 5학년과 6학년 학생 160명이 나무 심기에 참가하였습니다. 6학년 학생들이 각각 평균5그루,5학년 학생들이 각각 평균 3그루씩 심은 결과 모두 560그루를 심었습니다. 나무심기에 참가한 5,6학년 학생은 각각 몇명일까요? |

Pass |

| 2 | 베티는 새 지갑을 위해 돈을 모으고 있습니다. 새 지갑의 가격은 $100입니다. 베티는 필요한 돈의 절반만 가지고 있습니다. 그녀의 부모는 그 목적을 위해 $15를 주기로 결정했고, 할아버지와 할머니는 그녀의 부모들의 두 배를 줍니다. 베티가 지갑을 사기 위해 더 얼마나 많은 돈이 필요한가요? | Pass |

| 3 | 전국 초등학생 수학경시대회가 열렸는데 영희,철수,진호 세사람이 참가했습니다. 그들은 서울,부산,인천에서 온 학생이고 각각 1등,2등,3등 상을 받았습니다. 다음과 같은 사항을 알고 있을때 진호는 어디에서 온 학생이고 몇등을 했습니까? 1) 영희는 서울의 선수가 아닙니다. 2) 철수는 부산의 선수가 아닙니다. 3)서울의 선수는 1등이 아닙니다. 4) 부산의 선수는 2등을 했습니다. 5)철수는 3등이 아닙니다. | Pass |

| 4 | 방 안에는 살인자가 세 명 있습니다. 어떤 사람이 방에 들어와 그중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 남아 있는 살인자는 몇 명입니까? 단계별로 추론 과정을 설명하세요. | Pass |

| 5 | A marble is put in a glass. The glass is then turned upside down and put on a table. Then the glass is picked up and put in a microwave. Where's the marble? Explain your reasoning step by step. | Fail |

| 6 | 도로에 5대의 큰 버스가 차례로 세워져 있는데 각 차의 뒤에 모두 차의 목적지가 적혀져 있습니다. 기사들은 이 5대 차 중 2대는 A시로 가고, 나머지 3대는 B시로 간다는 사실을 알고 있지만 앞의 차의 목적지만 볼 수 있습니다. 안내원은 이 몇 분의 기사들이 모두 총명할 것으로 생각하고 그들의 차가 어느 도시로 가야 하는지 목적지를 알려 주지 않고 그들에게 맞혀 보라고 하였습니다. 먼저 세번째 기사에게 자신의 목적지를 맞혀 보라고 하였더니 그는 앞의 두 차에 붙여 놓은 표시를 보고 말하기를 "모르겠습니다." 라고 말하였습니다. 이것을 들은 두번째 기사도 곰곰히 생각해 보더니 "모르겠습니다." 라고 말하였습니다. 두명의 기사의 이야기를 들은 첫번째 기사는 곰곰히 생각하더니 자신의 목적지를 정확하게 말하였습니다. 첫번째 기사가 말한 목적지는 어디입니까? | Pass |

추론 성능 테스트에서는 구슬 문제를 제외하고 모두 성공하였습니다

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

5. 맺음말

Qwen2.5-Max는 알리바바 클라우드의 최신 MoE 모델로, 강력한 추론 능력과 다양한 응용 가능성을 보여주는 인상적인 성능을 입증했습니다. 특히, 대규모 데이터를 활용한 학습과 SFT 및 RLHF를 통한 정밀한 튜닝을 통해 인간 선호도를 반영하는 답변을 생성할 수 있다는 점에서 주목할 만합니다. 벤치마크 결과에서도 DeepSeek V3를 비롯한 경쟁 모델들을 능가하는 성과를 보이며, 코딩, 수학, 추론 등 다양한 영역에서 뛰어난 문제 해결 능력을 발휘했습니다.

최근 DeepSeek AI와 알리바바 등 중국 기업들의 AI 모델이 빠르게 발전하면서, 새로운 AI 모델이 계속 등장하고 있는데요. 과연 다음은 또 어떤 혁신적인 AI 모델이 우리를 깜짝 놀라게 할지 기대됩니다. 그럼 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다!

2024.11.14 - [AI 언어 모델] - 🤖💪Qwen2.5 Coder 32B: 오픈소스로 GPT-4o급 성능에 아티팩트까지!

🤖💪Qwen2.5 Coder 32B: 오픈소스로 GPT-4o급 성능에 아티팩트까지!

안녕하세요! 오늘은 알리바바의 최신 코딩 모델 Qwen2.5-Coder-32B에 대해 알아보겠습니다. Qwen2.5-Coder는 92개 프로그래밍 언어를 지원하며, Cursor 및 Artifacts와 통합되어 사용자 친화적인 개발 환경을

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| 🔓Mistral Small 3: GPT-4o-mini를 대체할 오픈소스 언어 모델 (12) | 2025.02.06 |

|---|---|

| 🤖⚡o3-mini: DeepSeek-R1과 경쟁할 OpenAI의 최신 추론 모델 (5) | 2025.02.01 |

| 🎨🤖Janus: DeepSeek AI의 최신 멀티모달 생성 모델 분석 (6) | 2025.01.30 |

| 🐋DeepSeek-R1: OpenAI-o1 뛰어넘은 오픈소스 추론 모델이 무료! (6) | 2025.01.23 |

| 🚀⚡Codestral 25.01: 2배 빠른 속도로 업그레이드 된 최첨단 코딩 모델! (6) | 2025.01.17 |