안녕하세요! 오늘은 Meta에서 새롭게 발표한 차세대 멀티모달 AI 모델, Llama 4에 대해 알아보겠습니다. Llama 4는 기존 Llama 시리즈의 강점을 계승하면서도, 혁신적인 MoE(Mixture of Experts) 아키텍처와 네이티브 멀티모달 처리 능력을 도입하여 더욱 강력한 개인화 경험을 가능하게 했습니다. 특히, 업계 최고 수준인 1,000만 토큰의 컨텍스트 창과 다양한 전문가 구성 모델을 통해 텍스트, 이미지, 코드 등 복합 데이터를 능숙하게 다루며, LLM 리더보드에서도 상위권을 차지하고 있습니다. 이번 블로그에서는 Llama 4의 개요, 핵심 기능, 벤치마크 결과와 자체 테스트까지 함께 살펴보겠습니다.

1. Llama 4 개요

Meta에서 새롭게 공개한 Llama 4는 개방형, 네이티브 멀티모달 AI 모델로서, 더욱 개인화된 경험을 구축할 수 있도록 설계되었습니다. Llama 4는 혁신적인 MoE (Mixture of Experts) 아키텍처를 최초로 채택한 메타의 Llama 모델 시리즈로, 훈련 및 추론 과정에서 더 높은 계산 효율성과 향상된 품질을 제공합니다.

현재 공개된 Llama 4 모델의 주요 종류와 사양은 다음과 같습니다:

|

모델 이름

|

전문가 수

|

활성 파라미터 수

|

총 파라미터 수

|

컨텍스트 크기

|

|

Llama 4 Scout

|

16개

|

17B

|

109B

|

최대 1000만 토큰

|

|

Llama 4 Maverick

|

128개

|

17B

|

400B

|

최대 100만 토큰

|

|

Llama 4 Behemoth

|

16개

|

288B

|

약 2000B

|

훈련 중

|

|

Llama 4 Reasoning

|

추후 공개

|

추후 공개 | 추후 공개 | 추후 공개 |

- Llama 4 Scout: 170억 개의 활성 파라미터와 16개의 전문가로 구성된 모델입니다. 동급 최고의 멀티모달 모델로 평가받으며, 이전 세대 Llama 모델보다 강력한 성능을 제공합니다. 특히 1,000만 토큰에 달하는 업계 최고 수준의 컨텍스트 창 크기를 자랑하며, 텍스트 및 코드 검색 작업에서 뛰어난 능력을 보여줍니다. 단일 NVIDIA H100 GPU에 Int4 양자화로 탑재 가능합니다.

- Llama 4 Maverick: 170억 개의 활성 파라미터와 128개의 전문가로 구성된 모델입니다. 이미지 및 텍스트 이해 분야에서 최고의 성능을 제공하며, 다양한 언어를 지원하여 언어 장벽을 허무는 AI 애플리케이션 개발에 적합합니다. 일반 어시스턴트 및 채팅 사용 사례를 위한 주력 모델로서, 정밀한 이미지 이해와 창의적인 작문 능력이 뛰어납니다. LMArena에서 1417 Elo 점수를 기록하며 최고의 성능 대비 비용 효율성을 입증했으며, 단일 H100 호스트에서 실행 가능합니다.

- Llama 4 Behemoth: 2,880억 개의 활성 파라미터와 16개의 전문가, 약 2조 개의 파라미터를 가진 티처 모델입니다. 현재 훈련 중이며, 동급 모델 중 최고 수준의 지능을 보여줍니다. 수학, 다국어, 이미지 벤치마크에서 GPT-4.5, Claude Sonnet 3.7, Gemini 2.0 Pro를 능가하는 성능을 목표로 개발되었습니다. Llama 4 Maverick 모델의 코드 증류를 통한 품질 향상을 목표로 합니다.

- Llama 4 Reasoning: 추후 공개될 예정인 모델로, 이름에서 알 수 있듯이 추론 능력에 특화될 것으로 예상됩니다.

이 외에도 Llama 4 Scout와 Llama 4 Maverick의 다양한 변형 모델들이 Hugging Face 플랫폼을 통해 공개되어 있습니다. 이러한 모델들은 transformers 또는 llama-stack과 같은 특정 프레임워크와의 호환성을 제공합니다.

https://ai.meta.com/blog/llama-4-multimodal-intelligence/

The Llama 4 herd: The beginning of a new era of natively multimodal AI innovation

Post-training a model with two trillion parameters was a significant challenge too that required us to completely overhaul and revamp the recipe, starting from the scale of data. In order to maximize performance, we had to prune 95% of the SFT data, as opp

ai.meta.com

2. Llama 4 특징 및 주요 기능

Llama 4는 이전 Llama 모델 대비 다음과 같은 혁신적인 특징과 주요 기능을 제공합니다:

- 네이티브 멀티모달 기능: 텍스트, 이미지, 비디오 데이터를 통합하여 이해하고 처리할 수 있는 진정한 멀티모달 모델입니다. 초기 융합 방식을 통해 다양한 유형의 데이터를 효과적으로 통합하여 사전 훈련을 진행했습니다.

- MoE (Mixture of Experts) 아키텍처: 각 토큰 처리 시 전체 파라미터 중 일부만을 활성화하여 계산 효율성을 높이고, 고정된 계산 자원 내에서 더 높은 품질의 모델을 제공합니다. Llama 4 Maverick 모델의 경우 4,000억 개의 총 파라미터 중 170억 개의 활성 파라미터만을 사용합니다.

- 획기적으로 확장된 컨텍스트 창: Llama 4 Scout는 1,000만 토큰이라는 업계 최고 수준의 컨텍스트 창을 제공하여, 긴 문서 요약, 광범위한 사용자 활동 분석, 방대한 코드베이스 추론 등 이전에는 불가능했던 새로운 가능성을 열어줍니다. Llama 4 Maverick 또한 이전 모델 대비 확장된 컨텍스트 창을 제공합니다.

- 향상된 성능 및 품질: Llama 4 모델은 이전 Llama 모델 대비 높은 품질, 빠른 추론 속도, 저렴한 비용을 제공합니다. 특히 Llama 4 Maverick은 표준 벤치마크에서 Llama 3.3 (70B) 대비 더 높은 출력 품질과 40% 이상 빠른 추론 속도를 보여줍니다.

- 강력한 다국어 지원: 12개의 언어를 지원하여 글로벌 AI 애플리케이션 개발에 용이합니다. 이는 Llama 3.3의 8개 언어 지원에서 크게 확장된 것입니다. 100개 이상의 언어에 대해 10억 개 이상의 토큰으로 사전 훈련되어 다국어 처리 능력이 크게 향상되었습니다.

- 개선된 이미지 이해 능력: MetaCLIP 기반의 비전 인코더를 개선하여 이미지 및 비디오 프레임에 대한 이해도를 높였습니다. 최대 48장의 이미지를 사전 훈련에 활용했으며, 포스트 트레이닝에서도 최대 8장의 이미지를 효과적으로 처리하는 것으로 확인되었습니다.(모델이 한 번에 처리할 수 있는 시각적 입력의 상한선을 나타내며, 그 안에서 최적의 성능을 보장한다는 뜻일 수 있습니다.) Llama 4 Scout는 이미지 내 특정 영역과 사용자 프롬프트를 정확하게 연결하는 이미지 접지 (image grounding) 능력에서 동급 최고 수준의 성능을 자랑합니다.

- 안전 및 책임감 있는 AI: 모델 개발의 각 단계에서 안전장치를 통합하고, 악의적인 사용자로부터 개발자를 보호하기 위한 시스템 수준의 완화 기능을 제공합니다. Llama Guard, Prompt Guard, CyberSecEval 등의 오픈 소스 안전 도구를 통해 잠재적으로 유해한 입력 및 출력을 감지하고 방지할 수 있도록 지원합니다. 정치적, 사회적으로 민감한 주제에 대한 편향성을 줄이기 위한 노력도 지속적으로 이루어져 Llama 3.3 대비 거부 응답률이 낮아지고 응답 균형이 크게 개선되었습니다.

- 유연한 맞춤 설정: Unity Catalog로 관리되는 도구를 사용하여 기업 데이터를 Llama 4에 연결하고, RAG 파이프라인, 코파일럿, 워크플로우 자동화 등을 구축할 수 있습니다. Mosaic AI 플랫폼을 통해 에이전트의 반복, 평가, 개선 작업을 용이하게 수행할 수 있으며, 배치 추론 기능을 통해 대규모 데이터 처리를 위한 인프라 관리 부담을 줄일 수 있습니다. 레이블링 된 데이터셋 또는 TAO (Test-Time Adaptive Optimization)와 같은 기술을 활용하여 특정 사용 사례에 맞게 모델을 맞춤 설정할 수 있습니다.

3. Llama 4 벤치마크 결과

Meta는 Llama 4 모델들이 다양한 벤치마크에서 뛰어난 성능을 보인다고 발표했습니다.

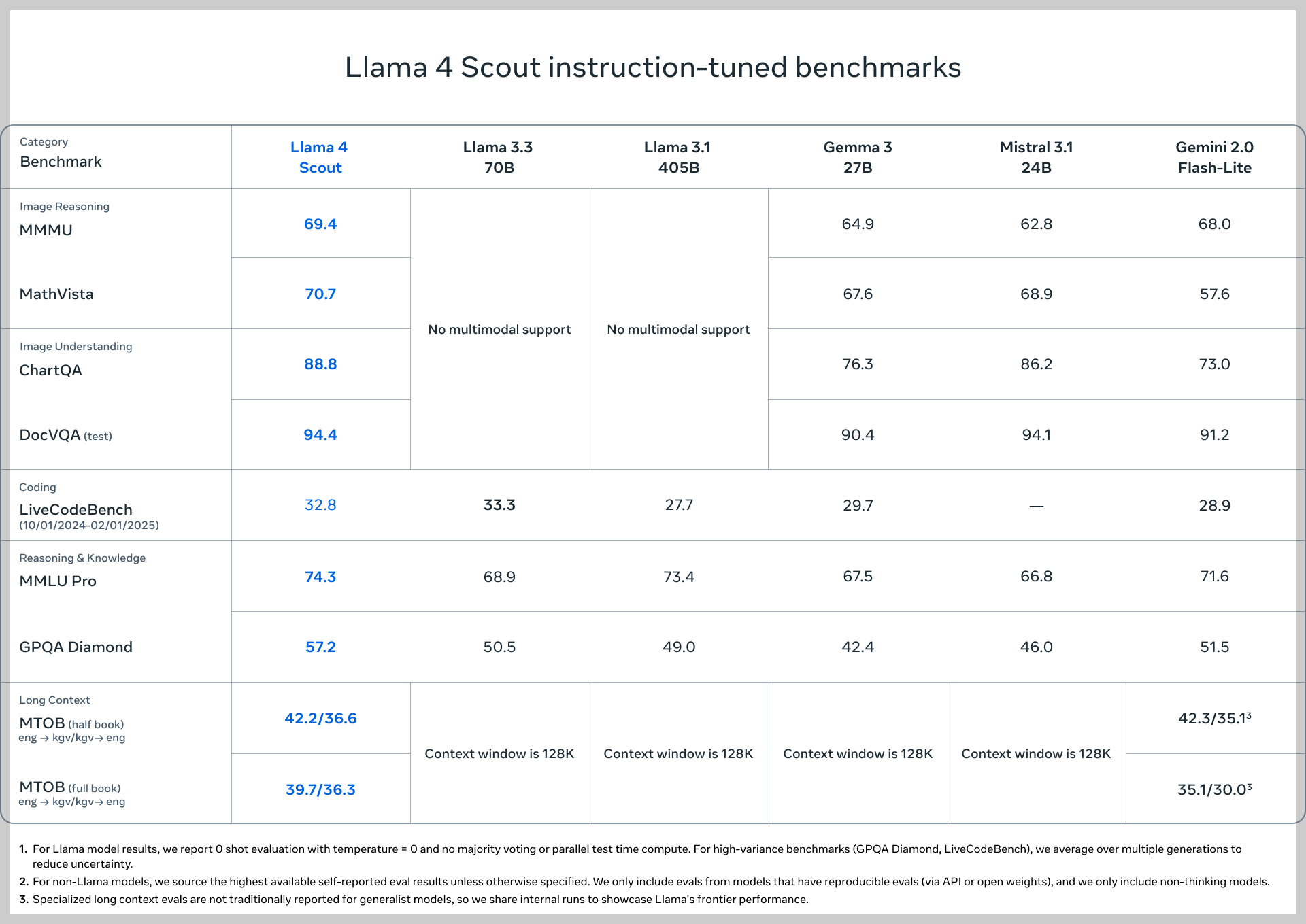

- Llama 4 Scout는 Gemma 3, Gemini 2.0 Flash-Lite, Mistral 3.1 등 동급 모델 대비 광범위한 벤치마크에서 더 나은 결과를 보였습니다. 특히 긴 컨텍스트 이해 능력과 관련된 작업에서 강점을 나타냅니다.

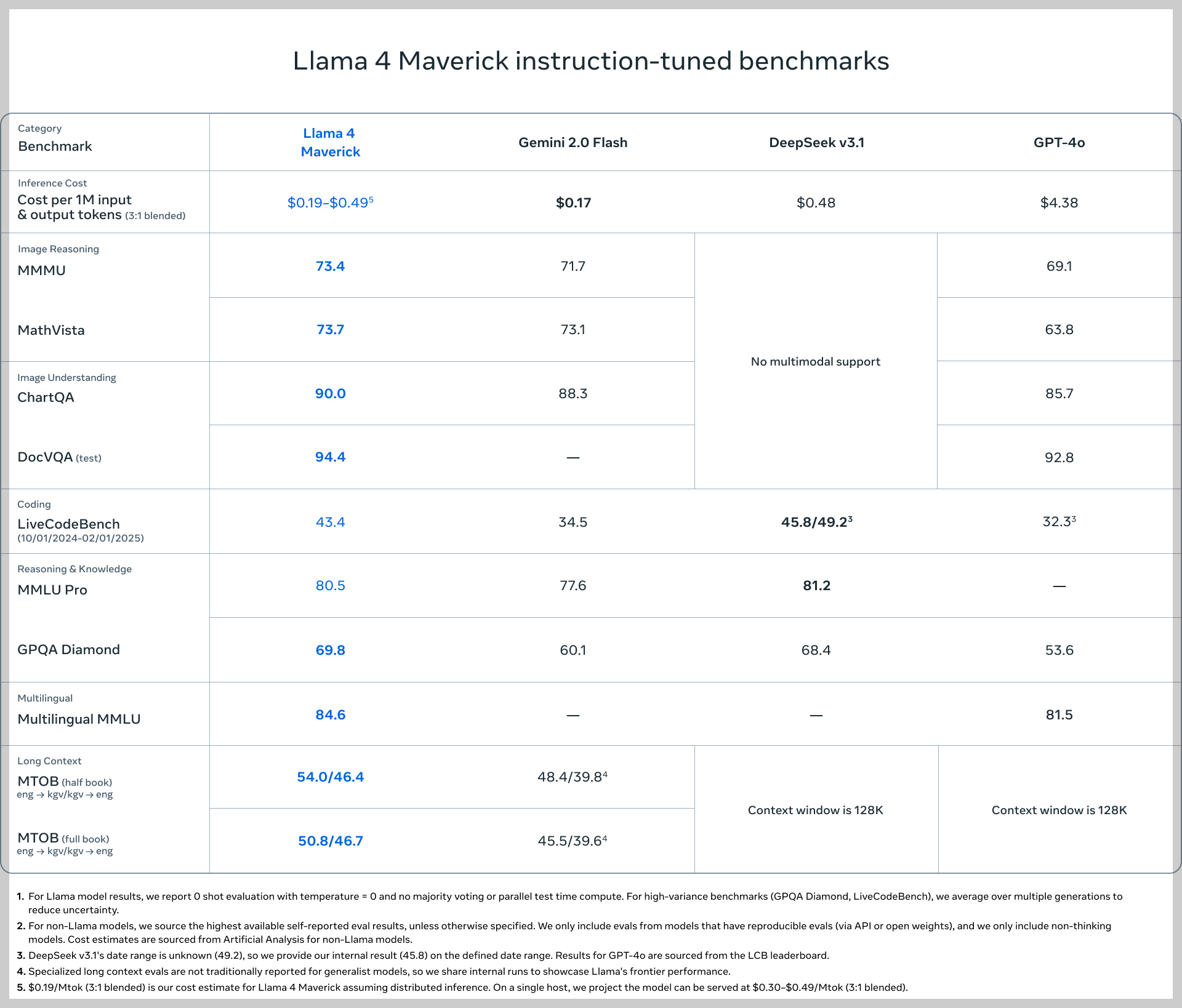

- Llama 4 Maverick은 GPT-4o 및 Gemini 2.0 Flash를 능가하는 성능을 보였으며, 추론 및 코딩 분야에서는 더 큰 모델인 DeepSeek v3와 유사한 결과를 달성했습니다. 이는 절반도 안 되는 활성 파라미터로 달성한 성과입니다.

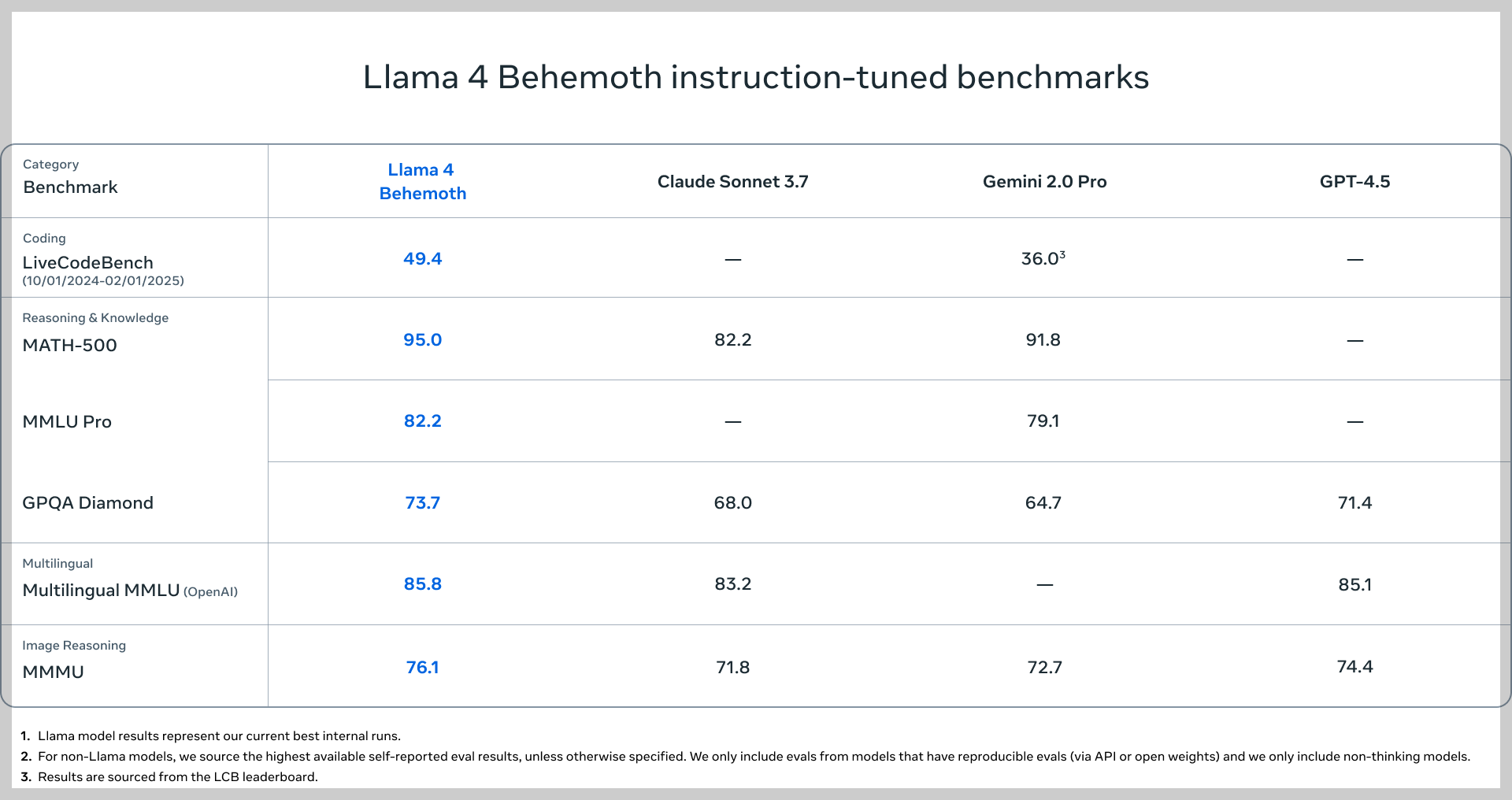

- Llama 4 Behemoth는 수학 (MATH-500), 다국어, 이미지 벤치마크에서 GPT-4.5, Claude Sonnet 3.7, Gemini 2.0 Pro를 능가하는 성능을 보여주는 것으로 보고되었습니다. 이는 Llama 4 Scout 및 Maverick 모델의 성능 향상에 기여한 주요 요인입니다.

Reddit의 r/OpenAI 및 r/LocalLLaMA 커뮤니티에서도 Llama 4에 대한 다양한 의견과 벤치마크 결과에 대한 논의가 활발하게 이루어지고 있습니다. 일부 사용자들은 Llama 4 Maverick (400B) 모델이 DeepSeek v3.1과 유사하거나 더 낮은 비용으로 비슷한 성능을 보이며, 멀티모달 기능과 100만 토큰의 컨텍스트 길이를 강점으로 가진다고 언급했습니다. Llama 4 Scout (109B) 모델은 벤치마크에서 Llama 3.3 70B보다 약간 더 나은 성능을 보이면서 멀티모달 기능과 1,000만 토큰의 컨텍스트 길이를 제공한다는 점에 주목했습니다.

다만, 일부 사용자들은 공개된 벤치마크 결과에 대해 의문을 제기하거나, 실제 사용 환경에서의 성능에 대한 추가적인 검증을 기대하는 의견도 있었습니다. 또한, Llama 4의 큰 모델들이 일반적인 GPU 환경에서 실행하기 어렵다는 점에 대한 우려도 나타났습니다.

4. Llama 4 사용 방법

Llama 4 모델은 다양한 플랫폼과 도구를 통해 개발자 및 기업에서 활용할 수 있습니다.

- Hugging Face: Llama 4 Scout 및 Llama 4 Maverick 모델은 llama.com과 함께 Hugging Face 플랫폼을 통해 다운로드하여 사용할 수 있습니다. transformers 라이브러리를 통해 쉽게 통합하고 활용할 수 있습니다.

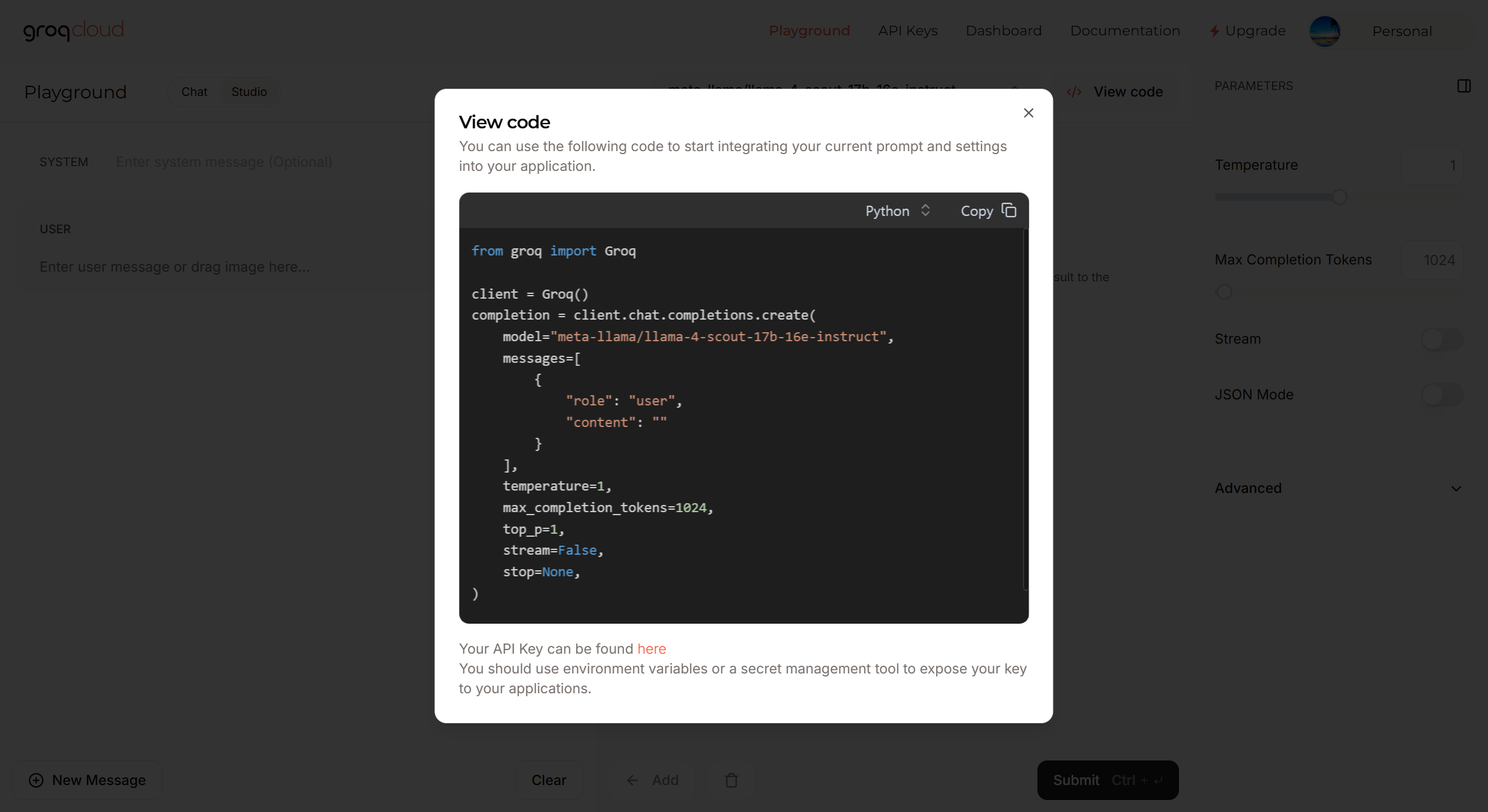

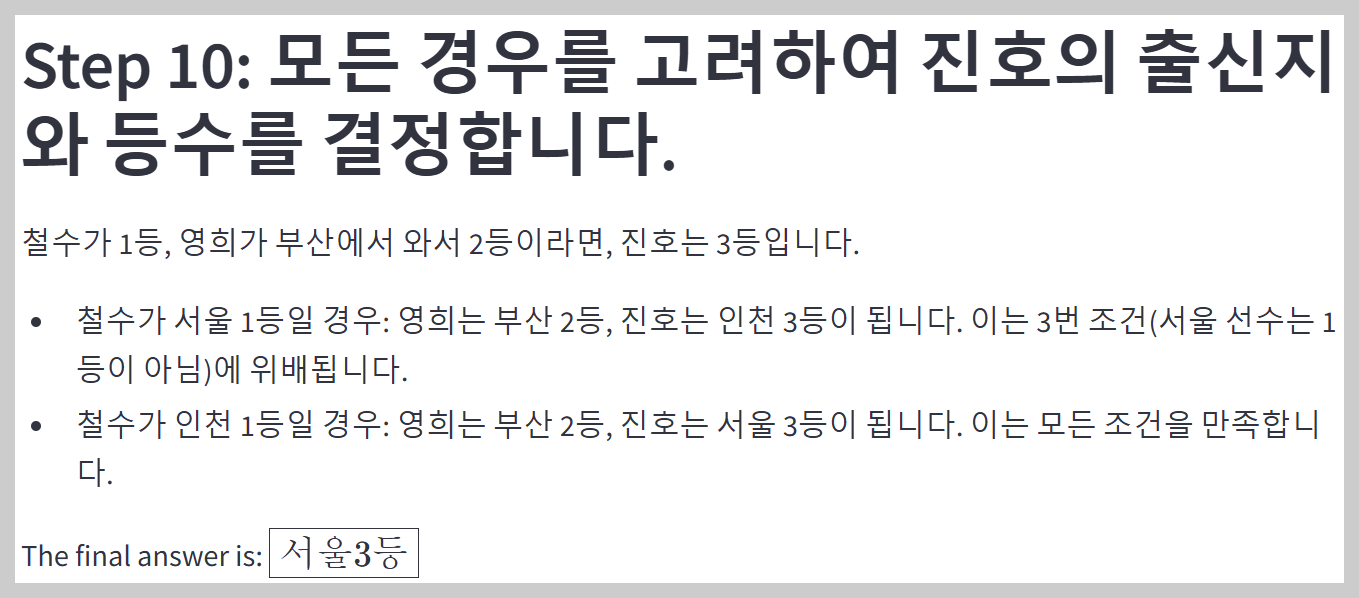

- GroqCloud: GroqCloud는 Llama 4 Scout 모델을 API를 통해 실시간으로 사용할 수 있는 환경을 제공합니다. Groq의 inference-first 아키텍처를 통해 낮은 지연 시간과 예측 가능한 비용으로 고성능 추론을 경험할 수 있습니다.

Groq 클라우드 설정

BASE URL:https://api.groq.com/openai/v1

모델명: meta-llama/llama-4-scout-17b-16e-instruct

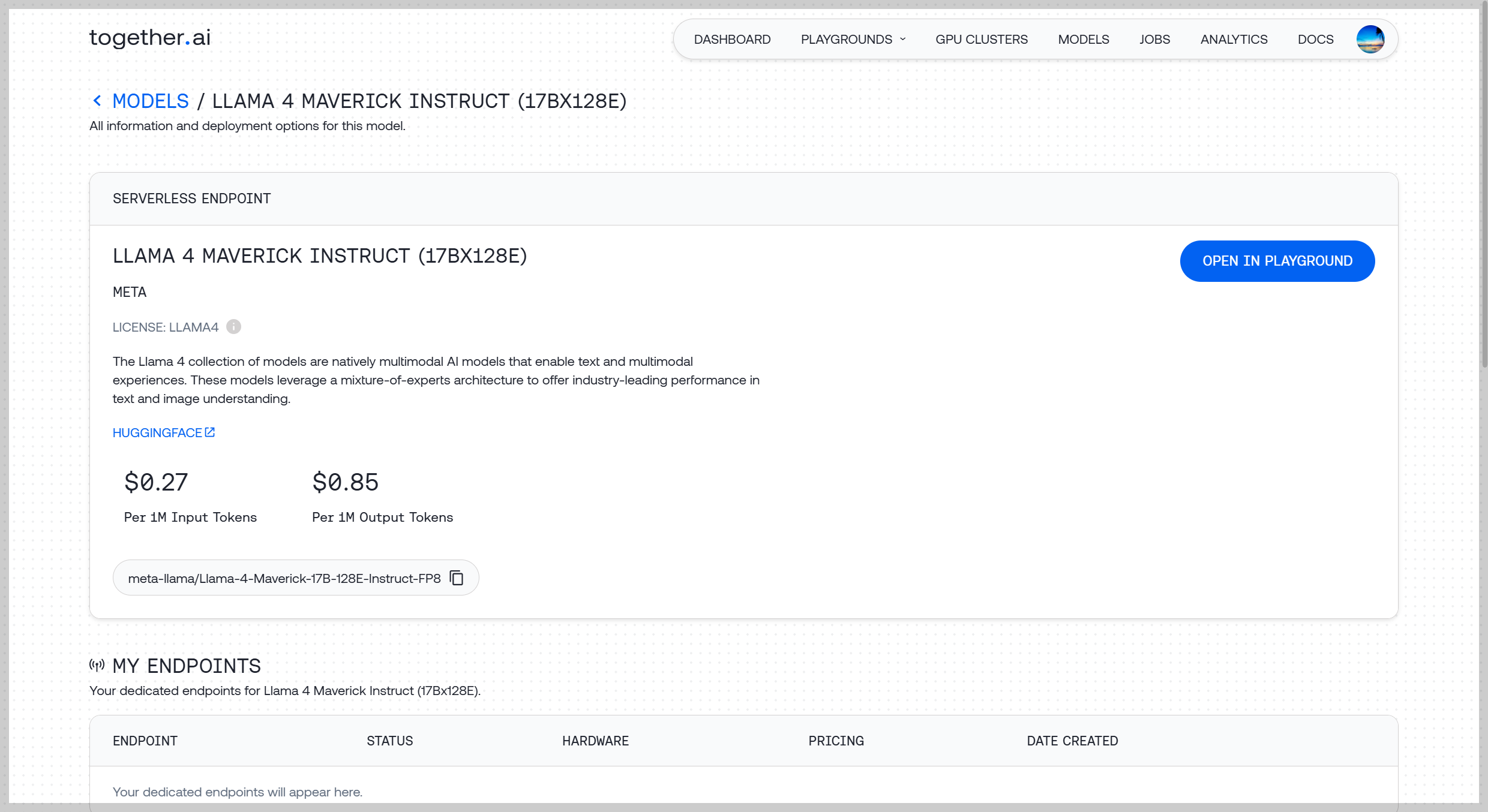

- Together AI: Together AI 플랫폼에서도 Llama 4 Scout 및 Maverick 모델을 사용할 수 있으며, Playground 환경을 통해 쉽게 테스트해 볼 수 있습니다.

- GLHF: https://glhf.chat/chat/create 에서 Llama-4-Maverick-17B-128E 모델을 사용할 수 있습니다.

GLHF 설정

Base URL: https://api.glhf.chat/v1

모델명: hf:meta-llama/Llama-4-Maverick-17B-128E-Instruct-FP8- Meta AI 제품: WhatsApp, Messenger, Instagram Direct, Meta.AI 웹사이트 등 Meta의 다양한 제품에서 Llama 4 기반의 Meta AI 기능을 직접 체험해 볼 수 있습니다.

이외에도 쳇봇아레나(https://lmarena.ai/)나 파이어웍스 AI(https://fireworks.ai/models/fireworks/llama4-maverick-instruct-basic/playground)에서도 Llama 4를 사용해 보실 수 있습니다.

5. Llama-4-Maverick-17B 성능 테스트

Llama-4-Maverick-17B의 성능을 직접 확인하기 위해 몇 가지 테스트를 진행해 보았습니다. 테스트는 GLHF 플랫폼과 groq 클라우드, OpenWebUI 그리고 자체 테스트 프로그램을 활용하였습니다.

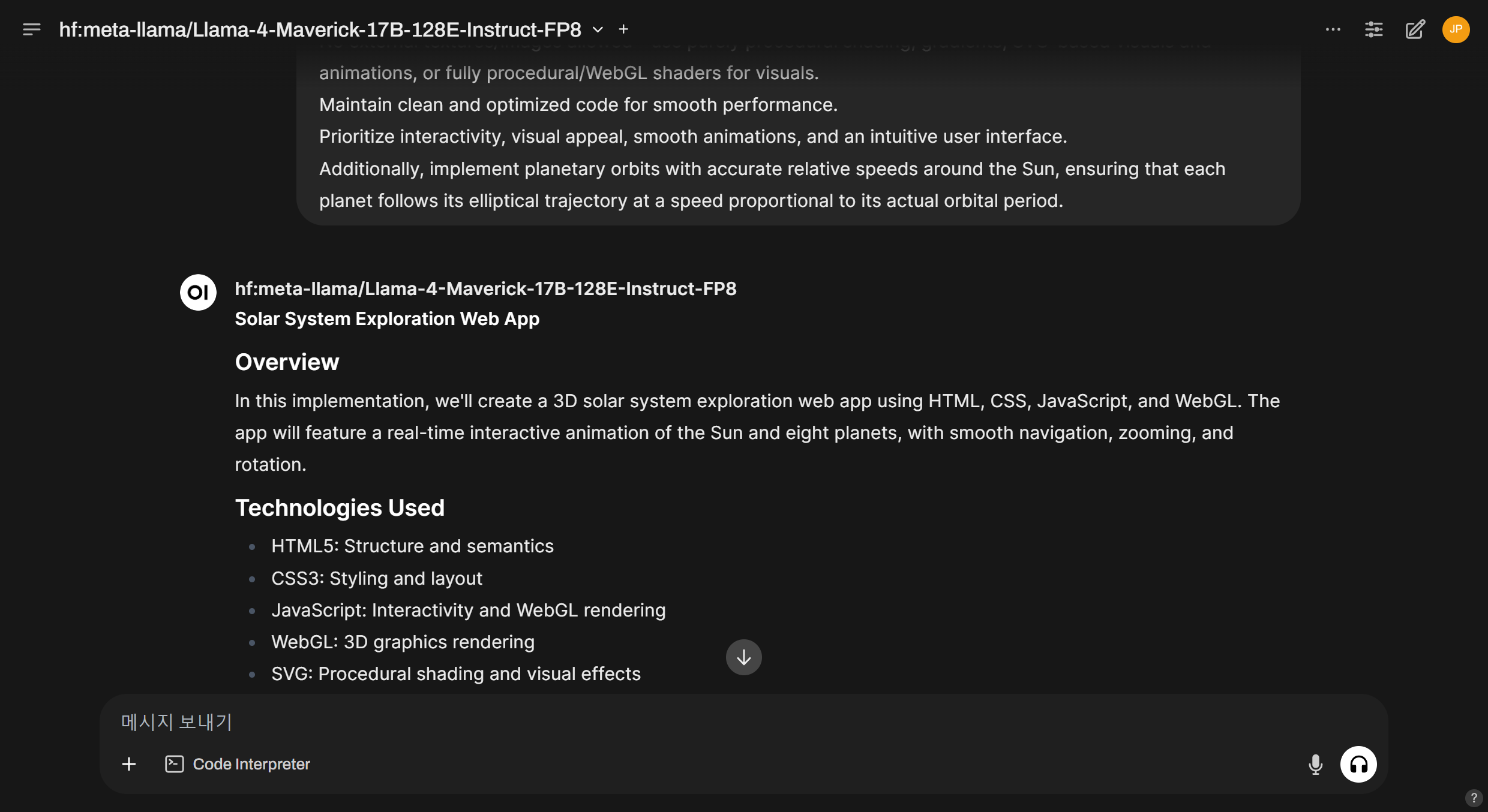

- 3D 인터랙티브 태양계 애니메이션: 사용자가 자유롭게 확대, 축소, 회전하며 탐색할 수 있는 태양계를 만들고, 각 행성의 공전 애니메이션을 구현하도록 요청한 결과, Llama-4-Maverick-17B-128E는 한 번에 성공하지 못했으나, 몇 번의 피드백과 에러 수정을 통해 아래 동영상과 같이 구현에 성공하였습니다.

요청 프롬프트

Create a single-page, interactive, fully 3D solar system exploration web app using pure HTML, CSS, SVG, and JavaScript, enhanced with WebGL

Real-time interactive Solar System animation with Sun and eight planets (Mercury, Venus, Earth, Mars, Jupiter, Saturn, Uranus, Neptune).

User should be able to smoothly navigate by zooming and rotating around the solar system. When a user zooms in or moves close to a planet, a simple informational popup appears automatically next to the planet displaying concise planet details (name, orbit, rotation period, moons, unique features).

No external textures/images allowed—use purely procedural shading, gradients, SVG-based visuals and animations, or fully procedural/WebGL shaders for visuals.

Maintain clean and optimized code for smooth performance.

Prioritize interactivity, visual appeal, smooth animations, and an intuitive user interface.

Additionally, implement planetary orbits with accurate relative speeds around the Sun, ensuring that each planet follows its elliptical trajectory at a speed proportional to its actual orbital period.

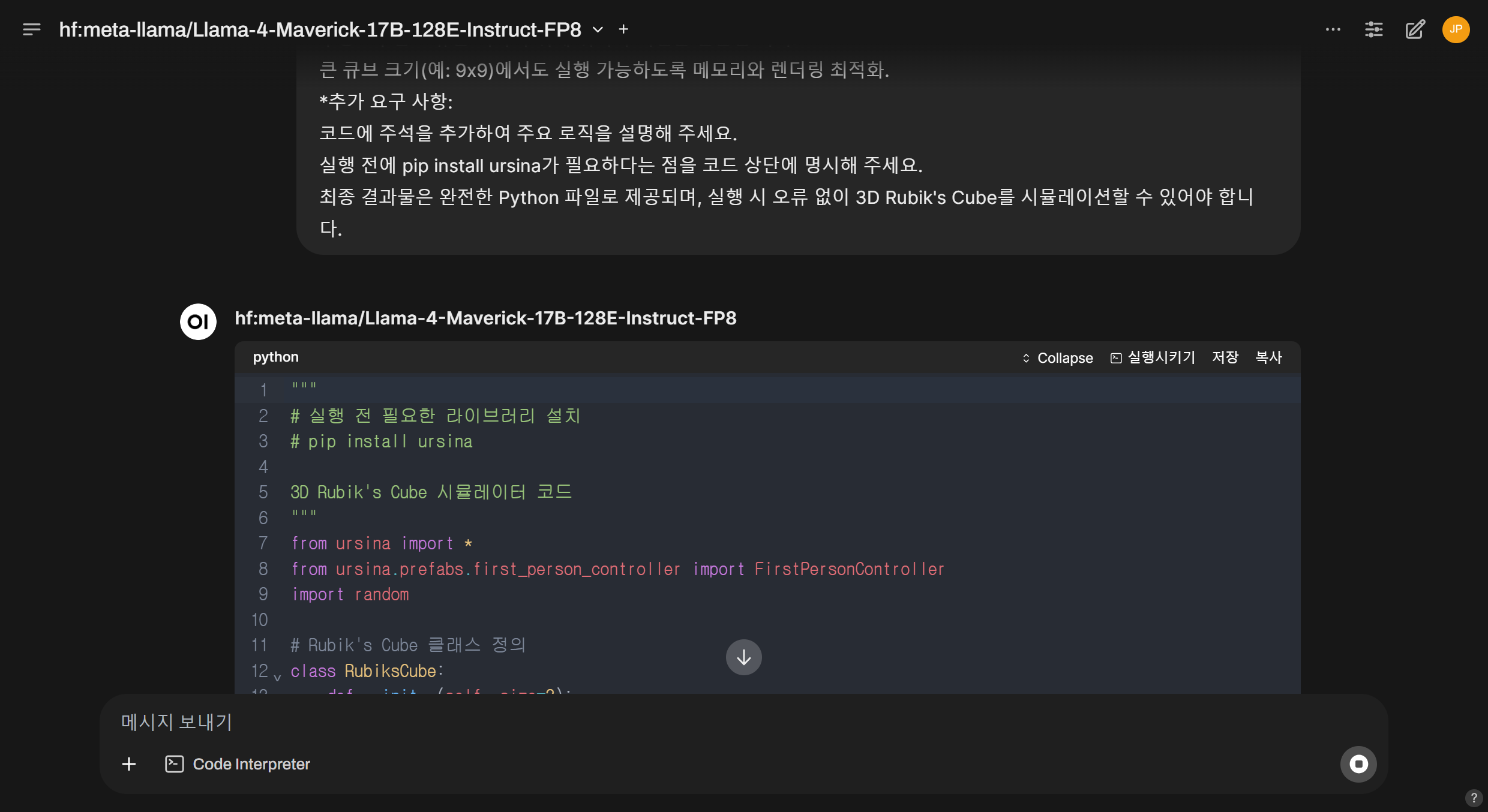

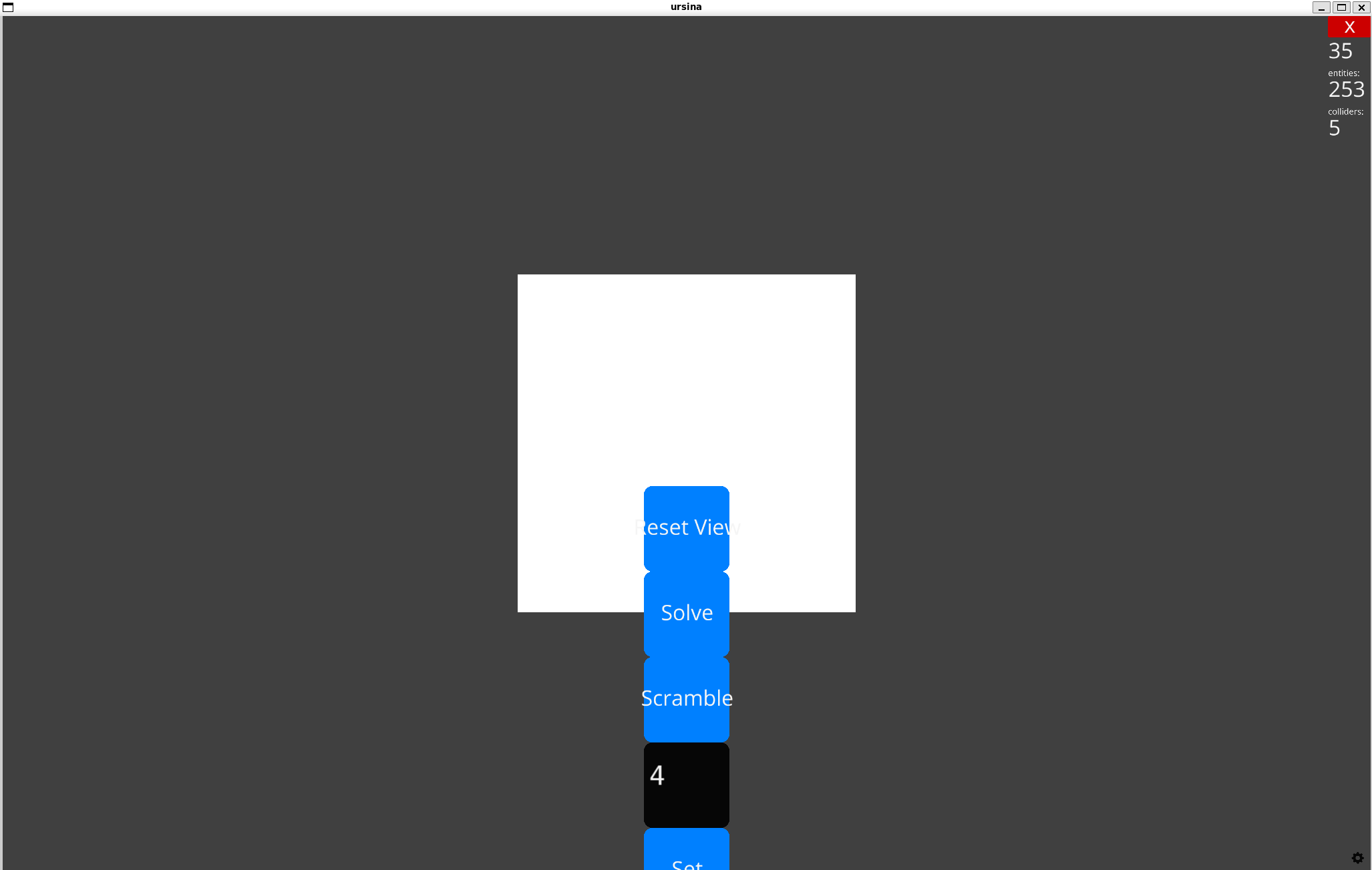

- Rubik's 큐브 시뮬레이터: 크기 조정이 가능한 정육면체 큐브의 색을 섞은 후, 전체 면의 색을 다시 맞추는 시뮬레이터 구현에서 Llama-4-Maverick-17B는 인터페이스와 시뮬레이터 기능을 대부분 구현하지 못하였습니다.

요청 프롬프트

Ursina 엔진을 사용하여 Python으로 3D Rubik's Cube 시뮬레이터 코드를 작성해 주세요. 다음 요구 사항을 충족해야 합니다:

*큐브 생성:

기본 크기는 3x3x3이지만, 사용자가 UI를 통해 1x1부터 9x9까지 크기를 조정할 수 있어야 합니다.

큐브는 각 면에 대해 표준 Rubik's Cube 색상(흰색, 노란색, 빨간색, 주황색, 초록색, 파란색)을 사용해야 합니다.

내부 큐비(보이지 않는 부분)는 렌더링하지 않아 성능을 최적화해야 합니다.

*큐브 회전:

표준 Rubik's Cube 표기법(U, D, L, R, F, B, 그리고 ', 2와 같은 수정자)을 지원해야 합니다.

특정 면을 회전할 때 부드러운 애니메이션(예: 0.15초 지속)이 적용되어야 합니다.

회전 중에는 다른 동작이 실행되지 않도록 잠금 메커니즘이 있어야 합니다.

*기능:

"Scramble" 버튼: 큐브를 무작위로 섞는 기능(최소 20~30개 무작위 동작).

"Solve" 버튼: 스크램블 동작을 역순으로 실행해 원래 상태로 복원.

카메라 컨트롤: 마우스 오른쪽 버튼으로 회전, 스크롤로 줌 인/아웃 가능.

*UI:

큐브 크기를 입력할 수 있는 텍스트 필드와 "Set" 버튼.

"Scramble", "Solve", "Reset View" 버튼을 포함한 패널.

입력 오류(예: 음수, 비숫자)에 대한 기본 예외 처리가 포함되어야 합니다.

*최적화 및 안정성:

부동소수점 오류를 피하기 위해 위치와 회전을 반올림 처리.

큰 큐브 크기(예: 9x9)에서도 실행 가능하도록 메모리와 렌더링 최적화.

*추가 요구 사항:

코드에 주석을 추가하여 주요 로직을 설명해 주세요.

실행 전에 pip install ursina가 필요하다는 점을 코드 상단에 명시해 주세요.

최종 결과물은 완전한 Python 파일로 제공되며, 실행 시 오류 없이 3D Rubik's Cube를 시뮬레이션할 수 있어야 합니다.

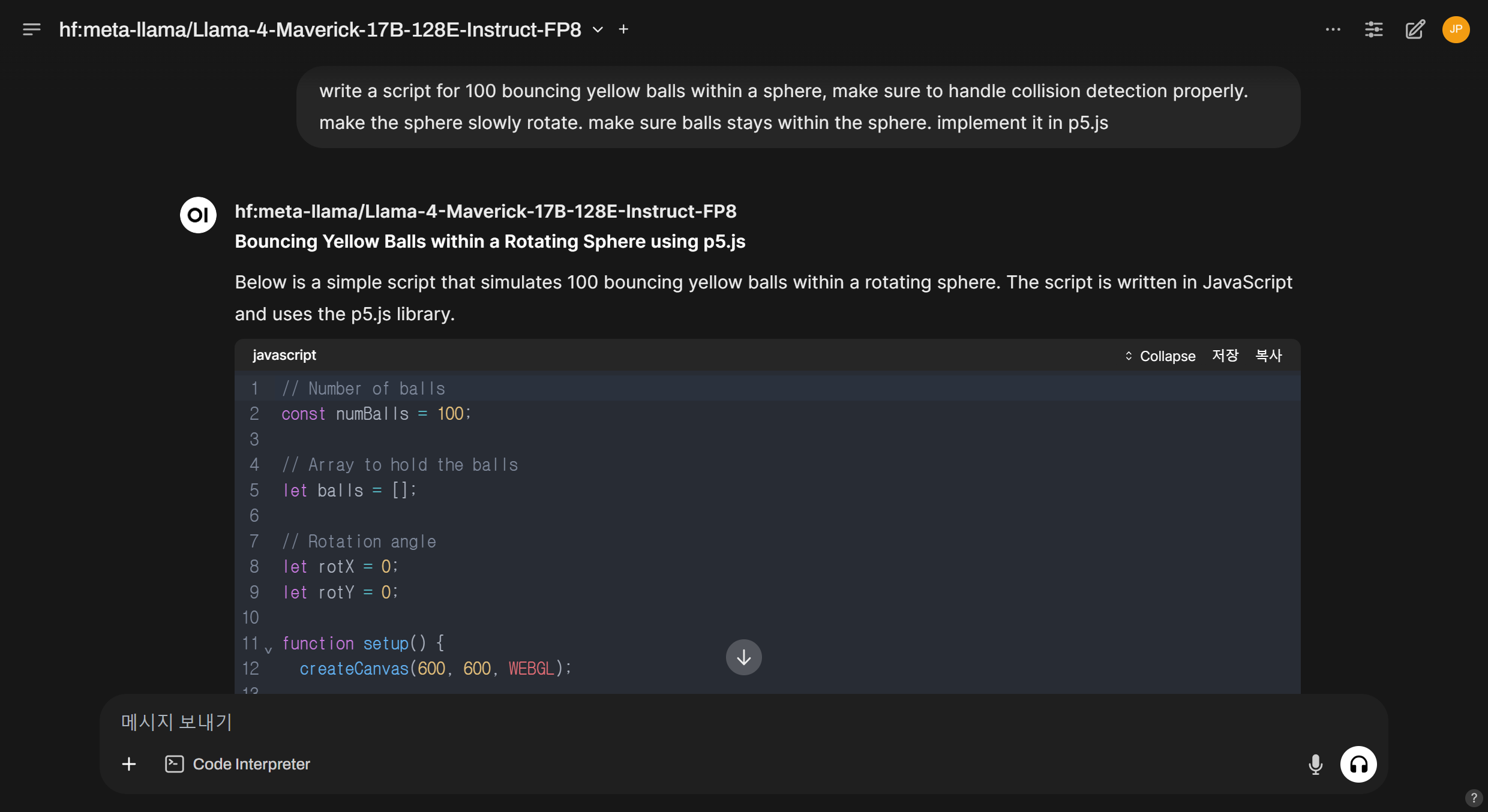

- 구면 내에서 튀는 100개의 노란색 공 생성 스크립트: Llama-4-Maverick-17B는 천천히 회전하는 구 내에서 노란색 공이 머무르면서 충돌 감지를 처리하는 스크립트를 p5.js로 구현하였지만, 공이 구 내에 머무르지는 않았으며, 충돌 처리도 명확하게 확인하기 어려웠습니다.

write a script for 100 bouncing yellow balls within a sphere, make sure to handle collision detection properly. make the sphere slowly rotate. make sure balls stays within the sphere. implement it in p5.js

구면 내에서 100개의 튀는 노란색 공에 대한 스크립트를 작성해줘, 충돌 감지를 제대로 처리해야 해. 구가 천천히 회전하도록 해줘. 공이 구 안에 머무르도록 해줘. p5.js로 구현해줘

Llama-4-Maverick-17B가 생성한 구면 내 100개의 노란색 공 생성 스크립트 실행 동영상은 아래와 같습니다.

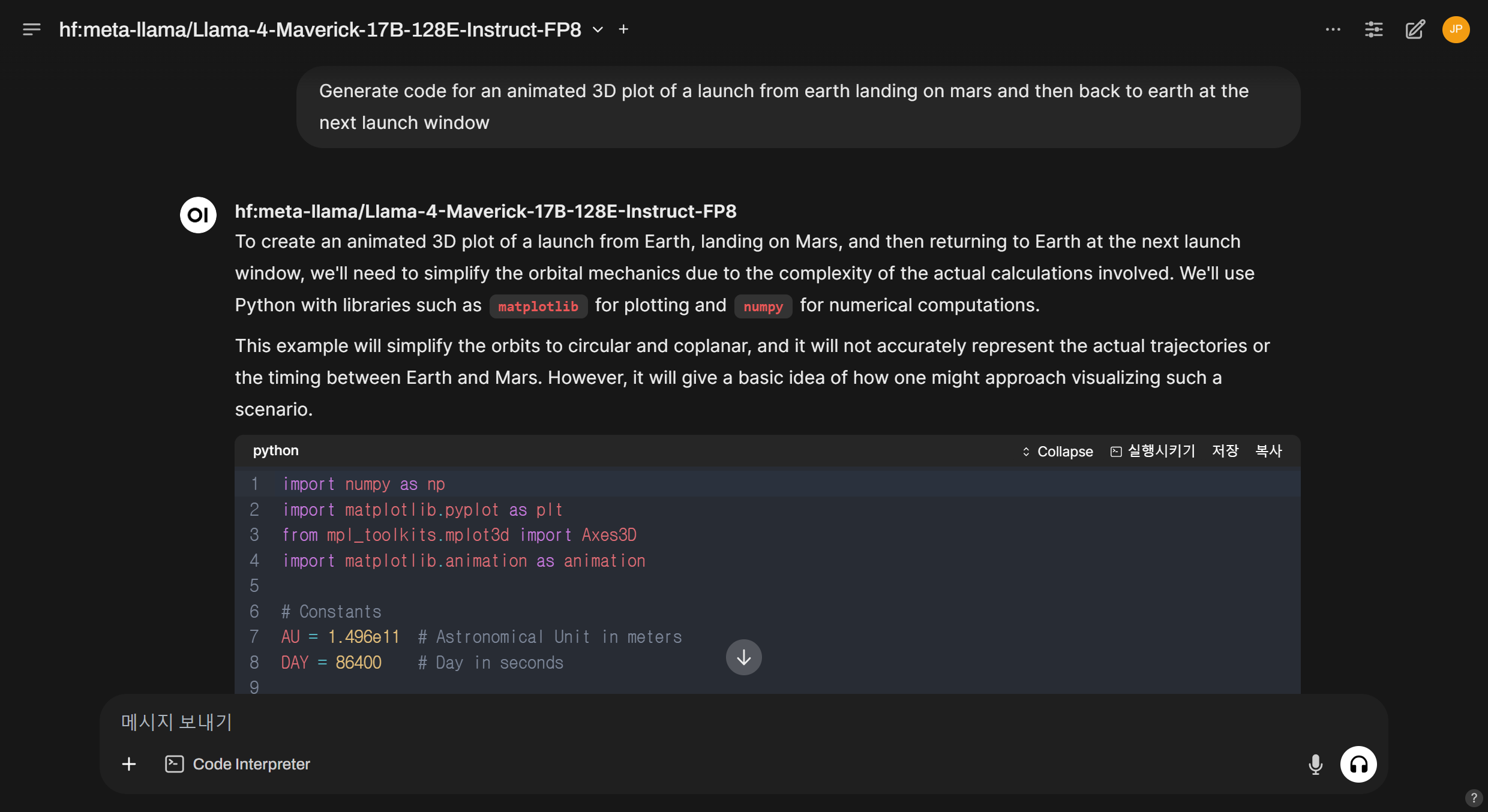

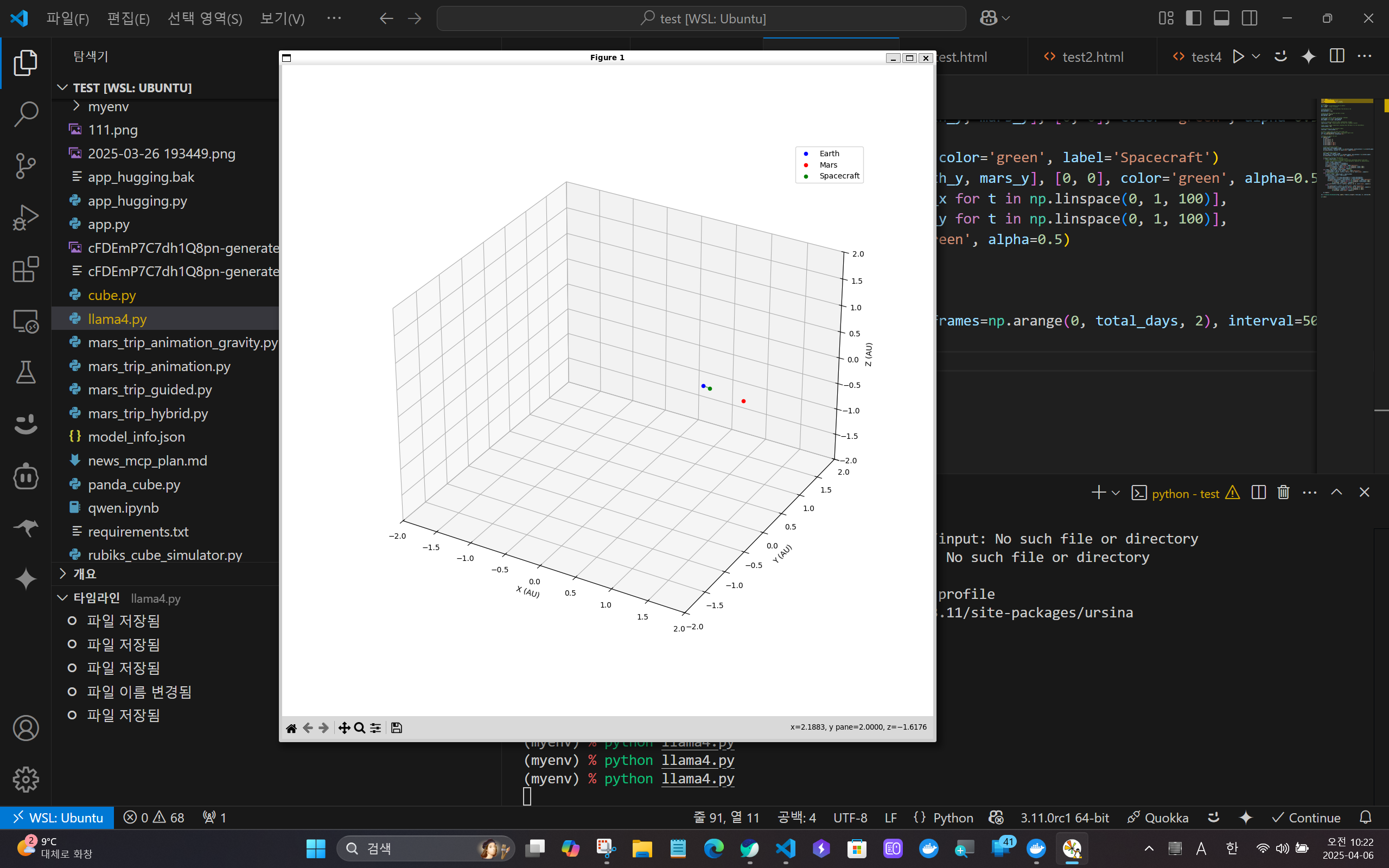

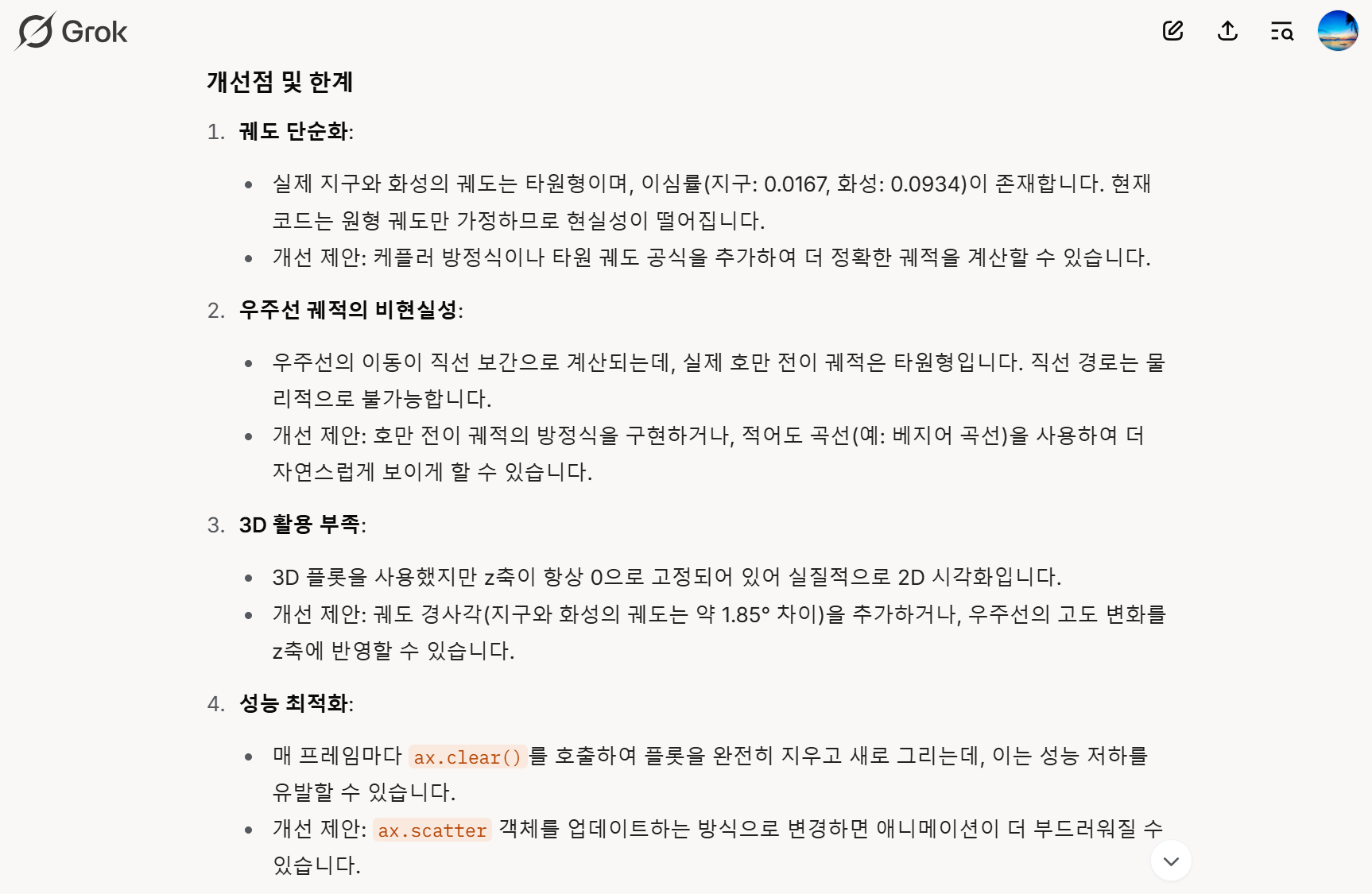

- 지구-화성 탐사궤도 애니메이션 생성: 우주선이 지구에서 출발해서 화성까지 갔다가 돌아오는 애니메이션 구현은 여러 번의 디버깅 끝에 간략화된 물리법칙이 적용된 결과물을 생성하였습니다.

Generate code for an animated 3D plot of a launch from earth landing on mars and then back to earth at the next launch window

지구에서 화성에 착륙한 후 다음 발사 창에서 지구로 돌아오는 애니메이션 3D 플롯에 대한 코드를 생성해줘

Llama-4-Maverick-17B가 생성한 지구-화성 탐사궤도 애니메이션 코드를 Grok-3가 평가한 결과는 아래와 같습니다.

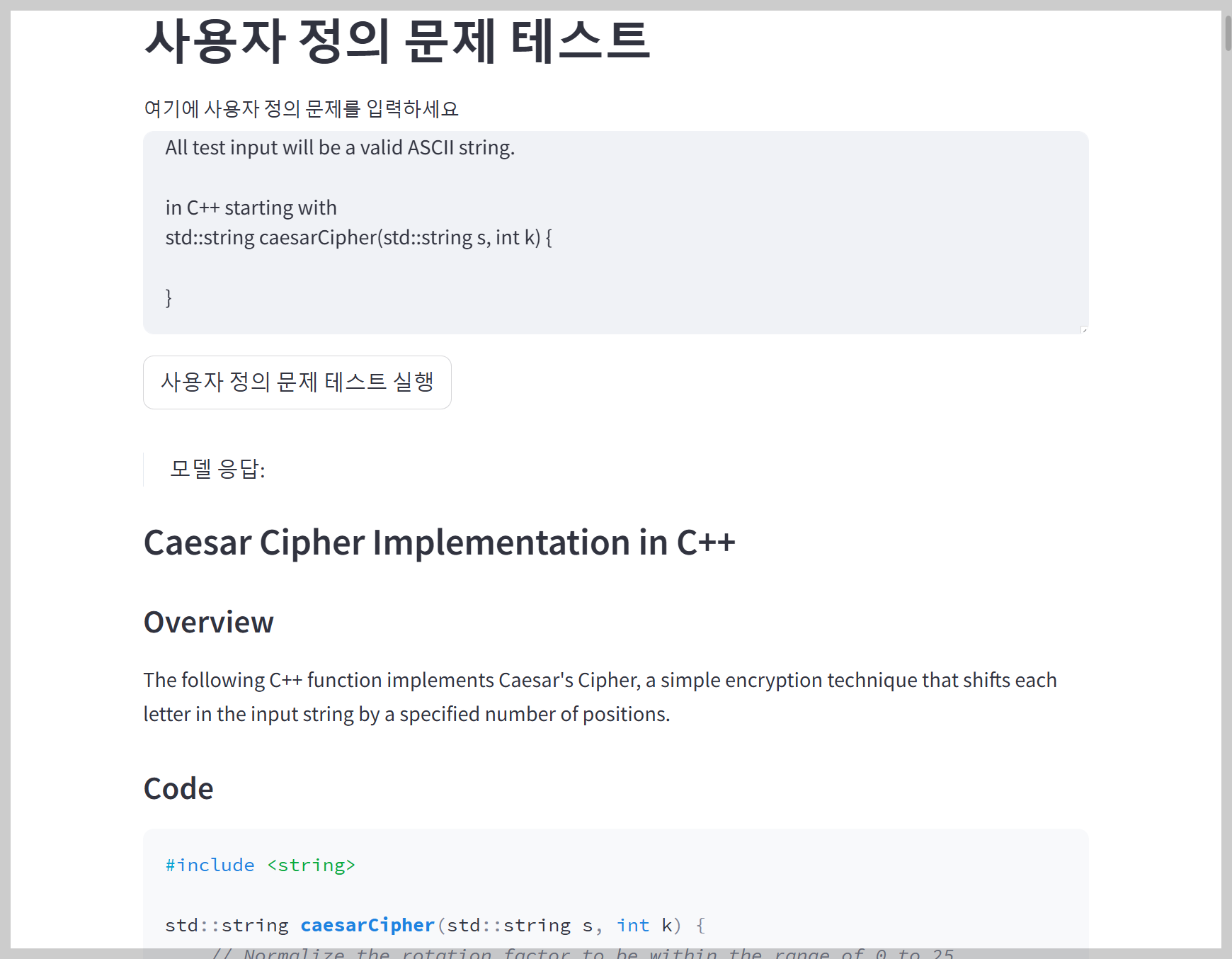

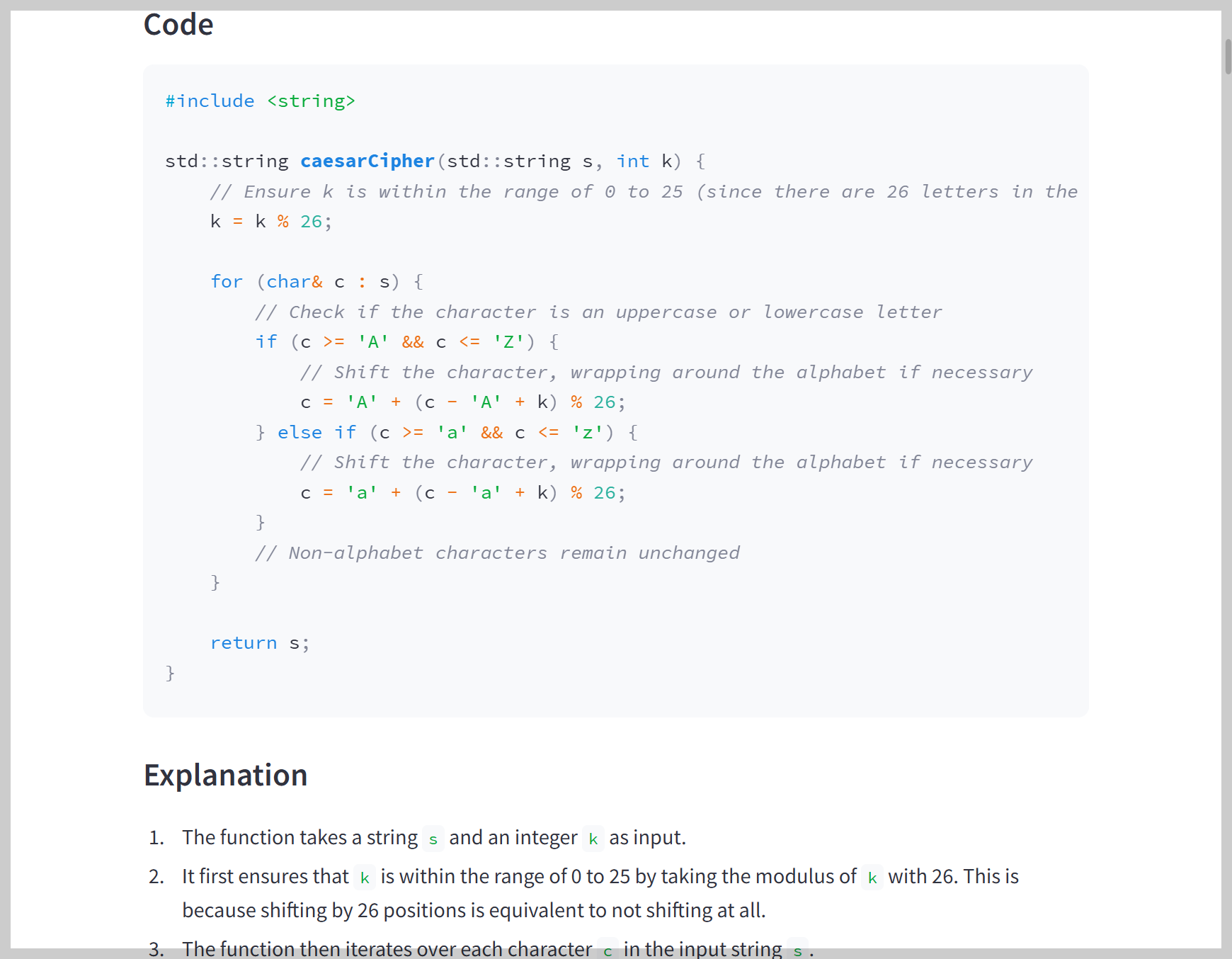

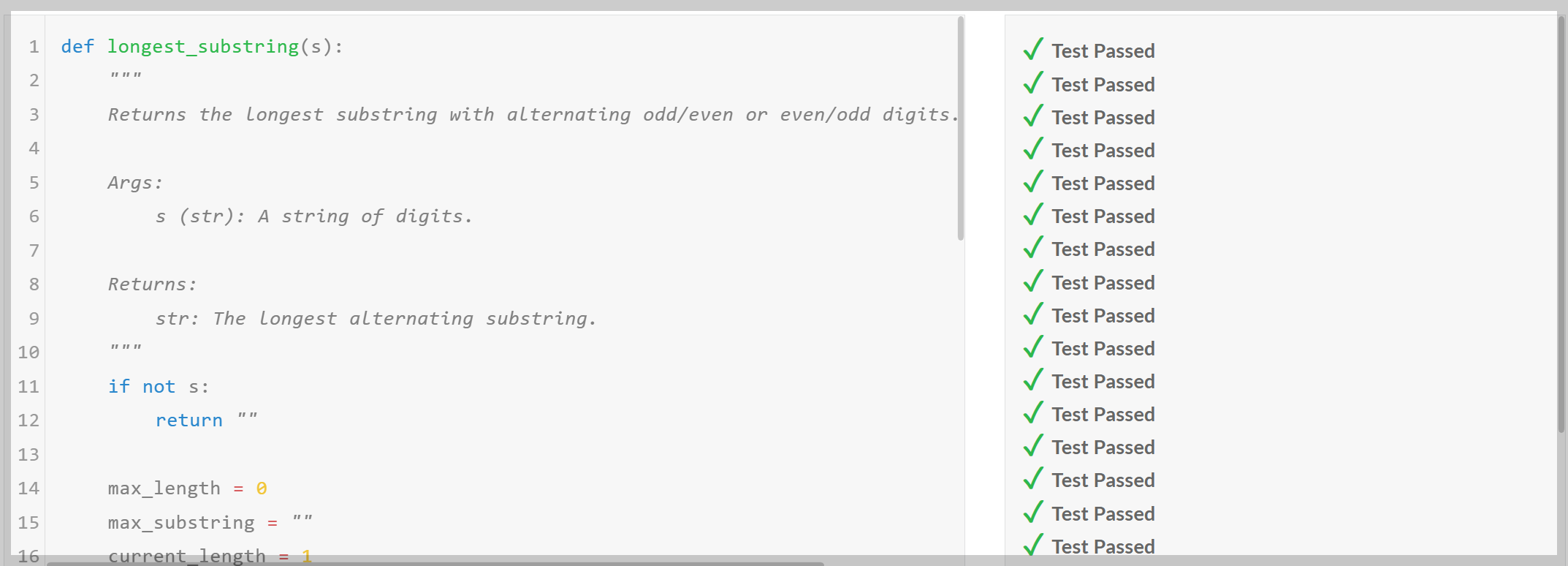

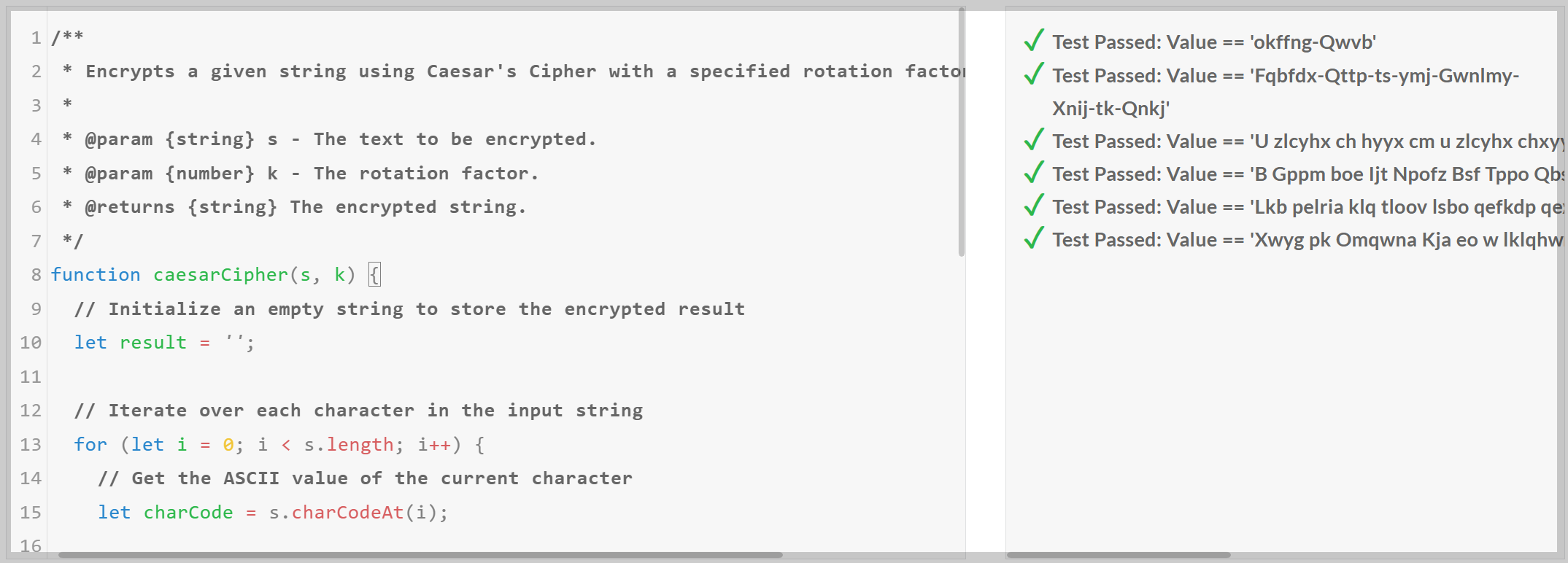

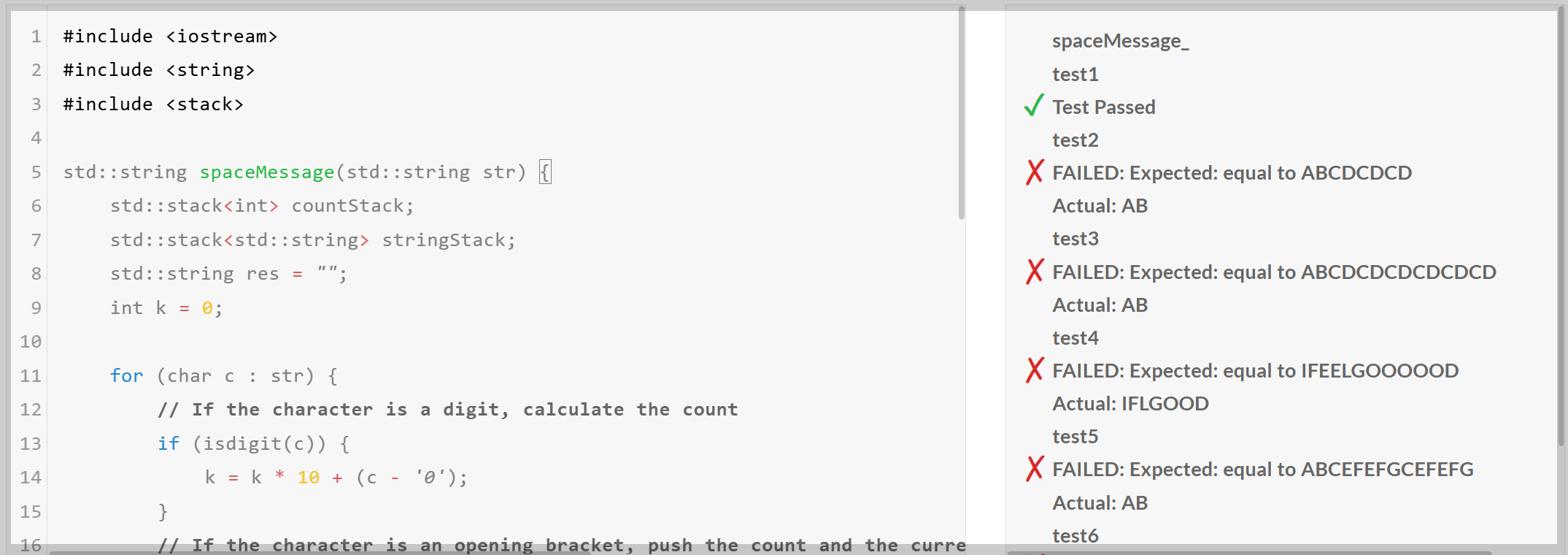

다음은 Llama-4-Maverick-17B의 코딩, 수학, 추론 성능을 테스트해 보겠습니다. 코딩 성능은 코딩 교육 사이트 edabit.com의 Python, JavaScript, C++ 문제를 통해 테스트하고, 수학 문제는 기하학, 확률, 수열, 최적화, 복합 문제 등으로 구성된 6개의 문제를 사용했습니다. 모든 평가 항목은 재시도 없이 첫 번째 시도의 채점 결과를 그대로 반영하였습니다.

1) 코딩 테스트

| Llama-4-Maverick-17B | Medium | Hard | Very Hard | Expert |

| Python | Pass | Pass | Pass | Pass |

| JavaScript | Pass | Pass | Pass | Pass |

| C++ | Pass | Pass | Pass | Fail |

코딩 테스트 결과, Llama-4-Maverick-17B는 C++ Expert 난이도를 제외하고 모든 난이도 문제를 성공하였습니다.

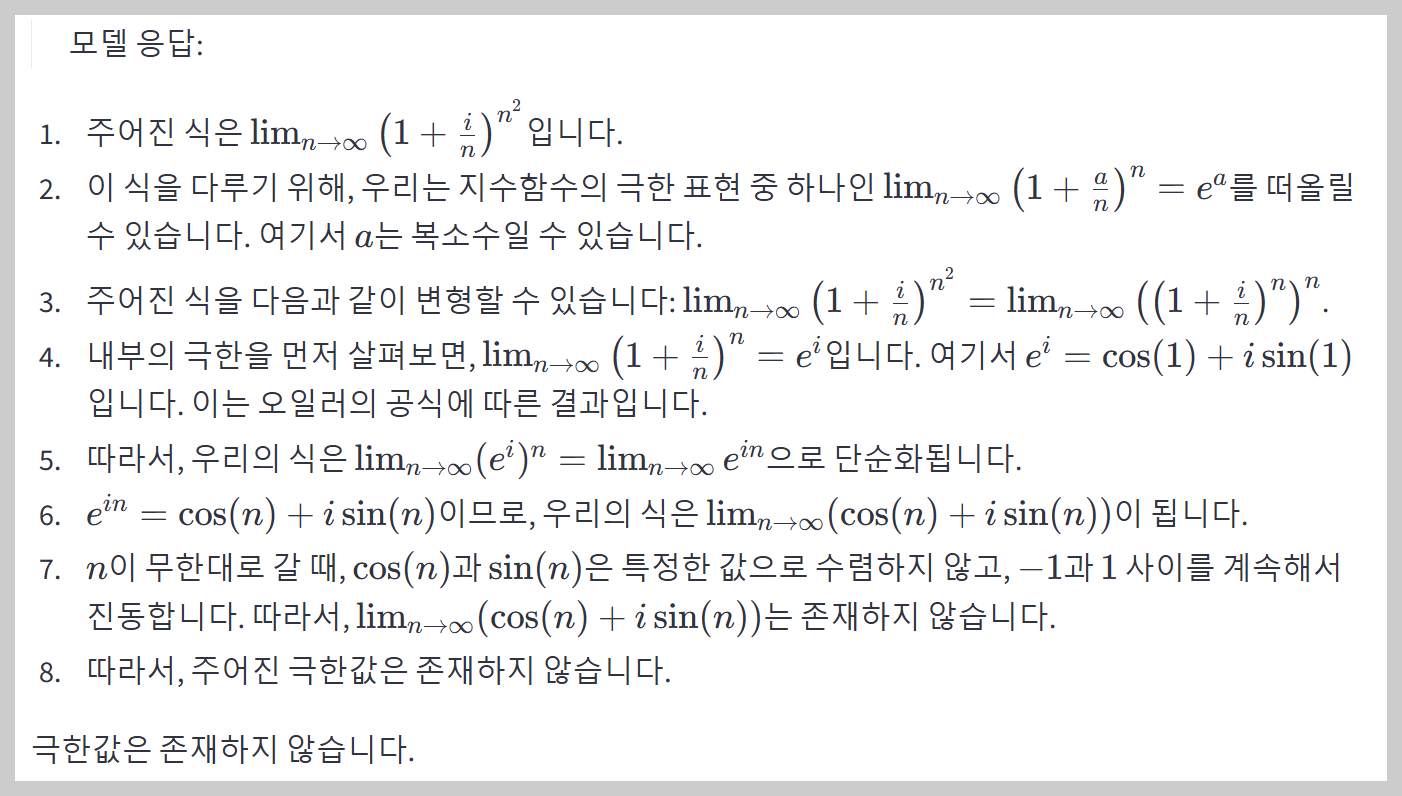

2) 수학 테스트

| No. | 문제 구분 | 문제 | Llama-4-Maverick-17B |

| 1 | 기초 대수 문제 | 두 숫자 𝑥 x와 𝑦 y가 있습니다. 이들이 만족하는 식은 3 𝑥 + 4 𝑦 = 12 3x+4y=12이며, 𝑥 − 2 𝑦 = 1 x−2y=1입니다. 𝑥 x와 𝑦 y의 값을 구하세요 | Pass |

| 2 | 기하학 문제 | 반지름이 7cm인 원의 넓이를 구하세요. 𝜋 = 3.14159 π=3.14159로 계산하세요. | Pass |

| 3 | 확률 문제 | 주사위를 두 번 던졌을 때, 두 숫자의 합이 7이 될 확률을 구하세요. | Pass |

| 4 | 수열 문제 | 첫 번째 항이 3이고, 공차가 5인 등차수열의 10번째 항을 구하세요. | Pass |

| 5 | 최적화 문제 | 어떤 직사각형의 둘레가 36cm입니다. 이 직사각형의 넓이를 최대화하려면 가로와 세로의 길이는 각각 얼마여야 하나요? | Pass |

| 6 | 복합 문제 | 복소평면에서 다음 극한값을 구하시오. lim[n→∞] (1 + i/n)^(n^2) 여기서 i는 허수단위 (i^2 = -1)입니다. | Pass |

수학 테스트에서는 기초 대수, 기하학, 확률, 수열, 최적화, 복합문제 등 여섯 문제를 모두 성공하였습니다.

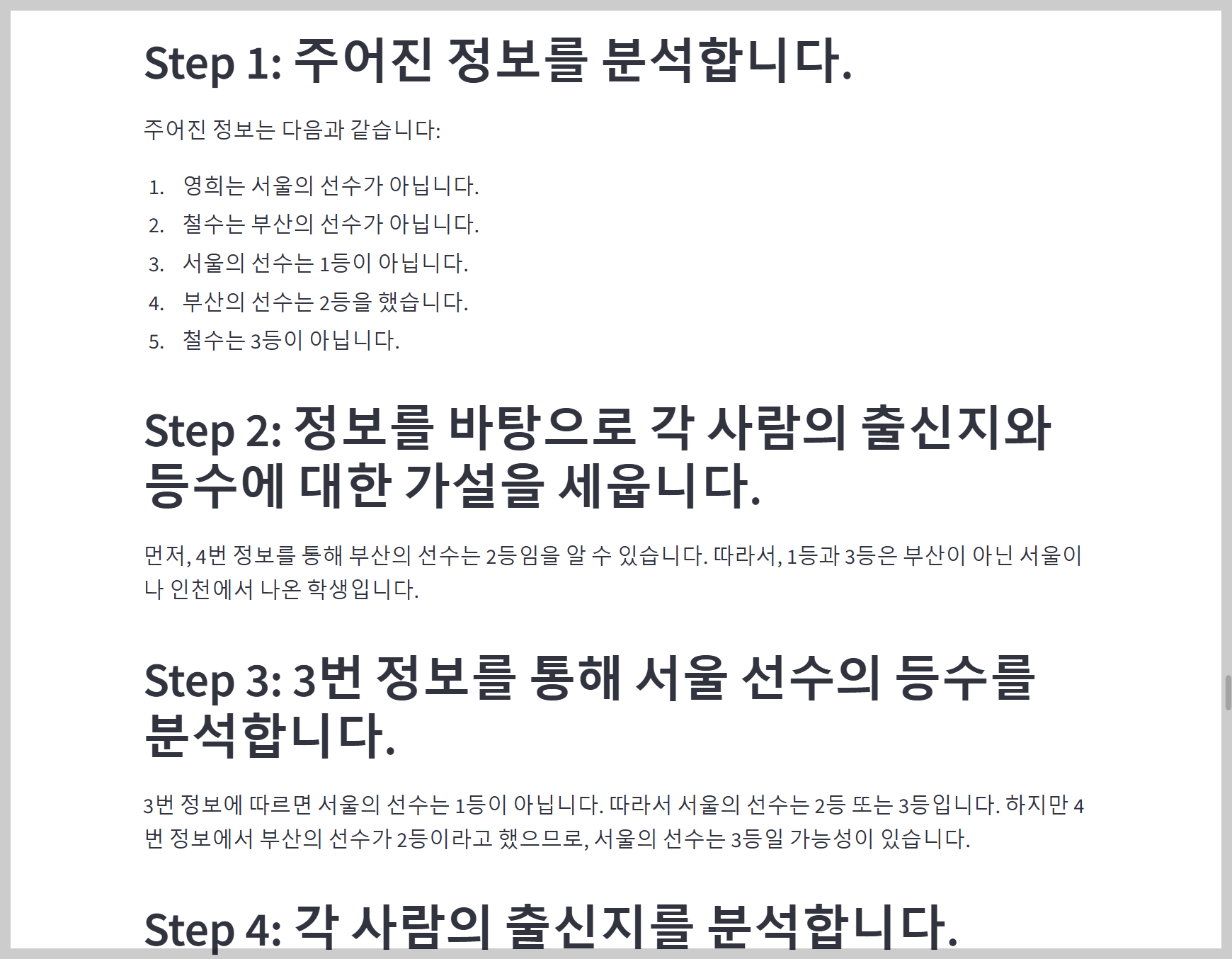

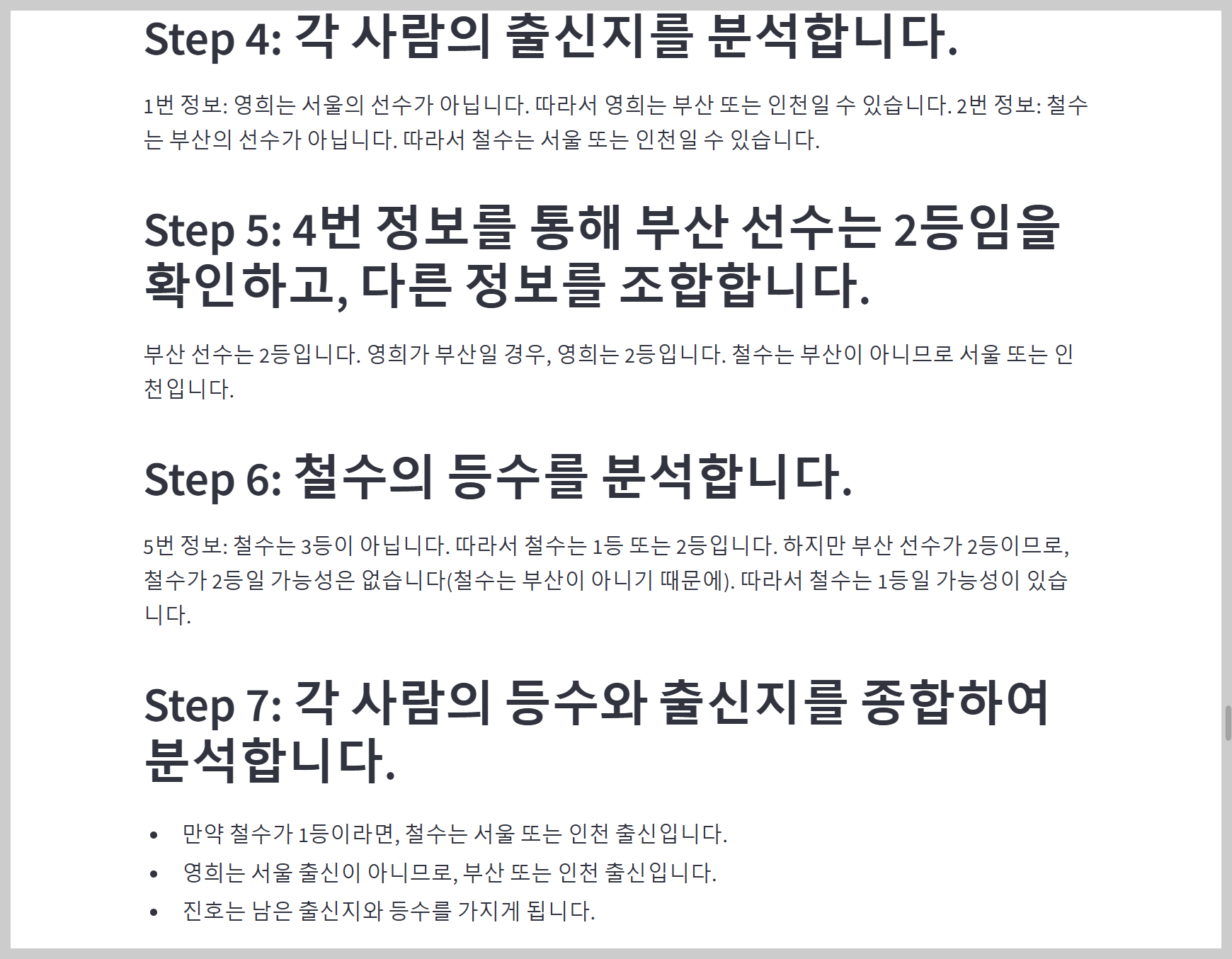

3) 추론 테스트

| No. | 문제 | Llama-4-Maverick-17B |

| 1 | 5학년과 6학년 학생 160명이 나무 심기에 참가하였습니다. 6학년 학생들이 각각 평균5그루,5학년 학생들이 각각 평균 3그루씩 심은 결과 모두 560그루를 심었습니다. 나무심기에 참가한 5,6학년 학생은 각각 몇명일까요? |

Pass |

| 2 | 베티는 새 지갑을 위해 돈을 모으고 있습니다. 새 지갑의 가격은 $100입니다. 베티는 필요한 돈의 절반만 가지고 있습니다. 그녀의 부모는 그 목적을 위해 $15를 주기로 결정했고, 할아버지와 할머니는 그녀의 부모들의 두 배를 줍니다. 베티가 지갑을 사기 위해 더 얼마나 많은 돈이 필요한가요? | Pass |

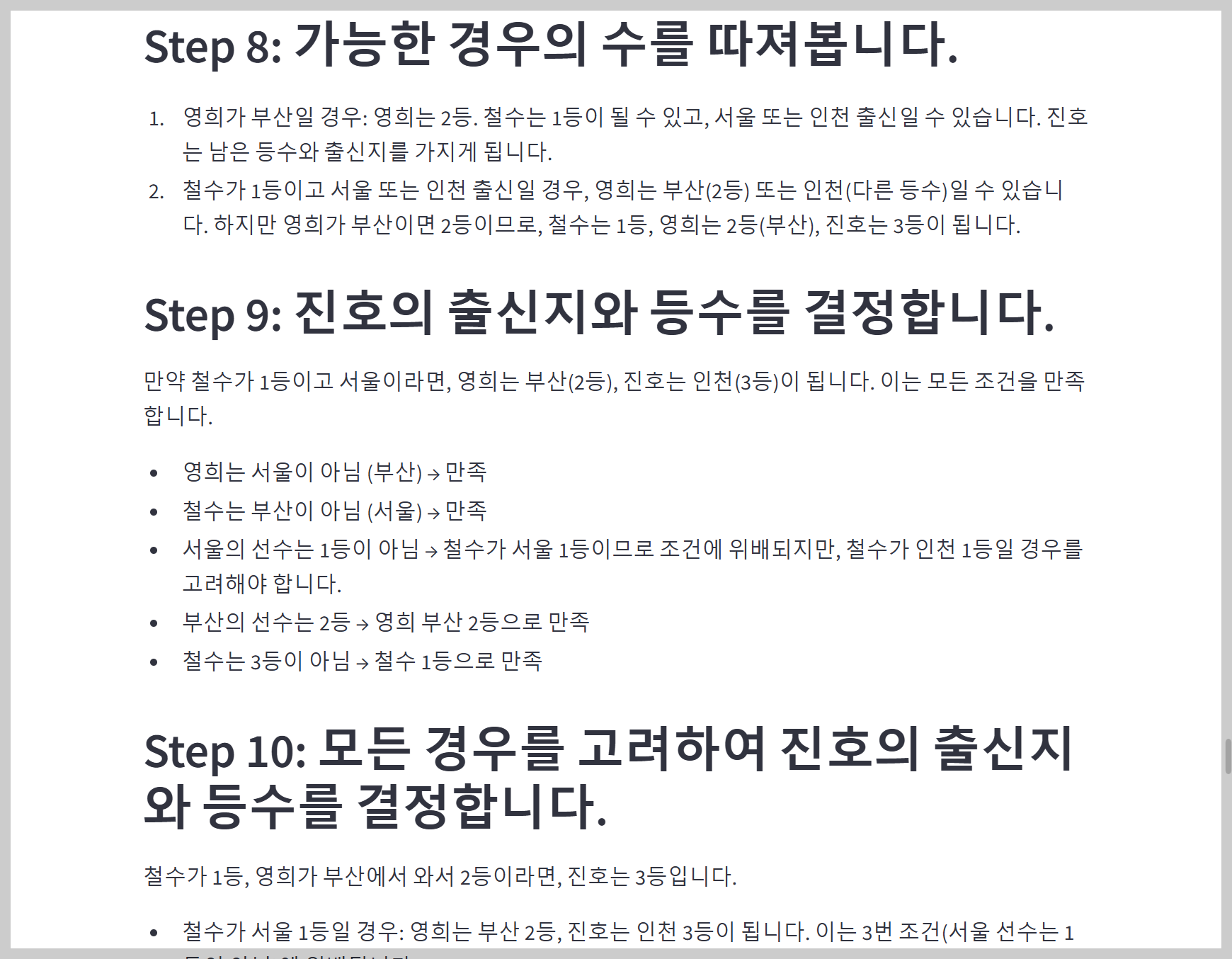

| 3 | 전국 초등학생 수학경시대회가 열렸는데 영희,철수,진호 세사람이 참가했습니다. 그들은 서울,부산,인천에서 온 학생이고 각각 1등,2등,3등 상을 받았습니다. 다음과 같은 사항을 알고 있을때 진호는 어디에서 온 학생이고 몇등을 했습니까? 1) 영희는 서울의 선수가 아닙니다. 2) 철수는 부산의 선수가 아닙니다. 3)서울의 선수는 1등이 아닙니다. 4) 부산의 선수는 2등을 했습니다. 5)철수는 3등이 아닙니다. | Pass |

| 4 | 방 안에는 살인자가 세 명 있습니다. 어떤 사람이 방에 들어와 그중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 남아 있는 살인자는 몇 명입니까? 단계별로 추론 과정을 설명하세요. | Pass |

| 5 | A marble is put in a glass. The glass is then turned upside down and put on a table. Then the glass is picked up and put in a microwave. Where's the marble? Explain your reasoning step by step. | Pass |

| 6 | 도로에 5대의 큰 버스가 차례로 세워져 있는데 각 차의 뒤에 모두 차의 목적지가 적혀져 있습니다. 기사들은 이 5대 차 중 2대는 A시로 가고, 나머지 3대는 B시로 간다는 사실을 알고 있지만 앞의 차의 목적지만 볼 수 있습니다. 안내원은 이 몇 분의 기사들이 모두 총명할 것으로 생각하고 그들의 차가 어느 도시로 가야 하는지 목적지를 알려 주지 않고 그들에게 맞혀 보라고 하였습니다. 먼저 세번째 기사에게 자신의 목적지를 맞혀 보라고 하였더니 그는 앞의 두 차에 붙여 놓은 표시를 보고 말하기를 "모르겠습니다." 라고 말하였습니다. 이것을 들은 두번째 기사도 곰곰히 생각해 보더니 "모르겠습니다." 라고 말하였습니다. 두명의 기사의 이야기를 들은 첫번째 기사는 곰곰히 생각하더니 자신의 목적지를 정확하게 말하였습니다. 첫번째 기사가 말한 목적지는 어디입니까? | Pass |

Llama-4-Maverick-17B-128E는 추론 성능 테스트도 모두 성공하였습니다.

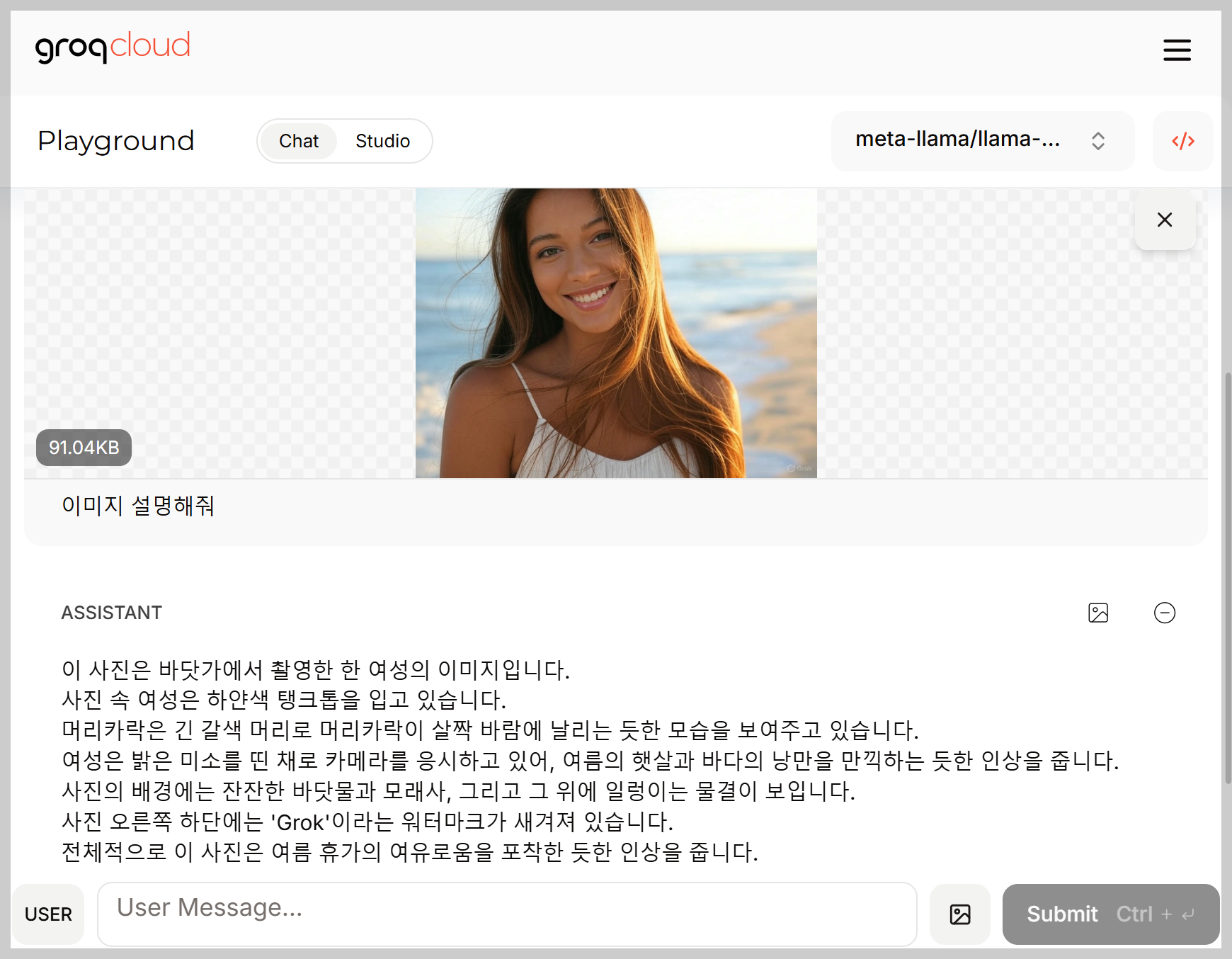

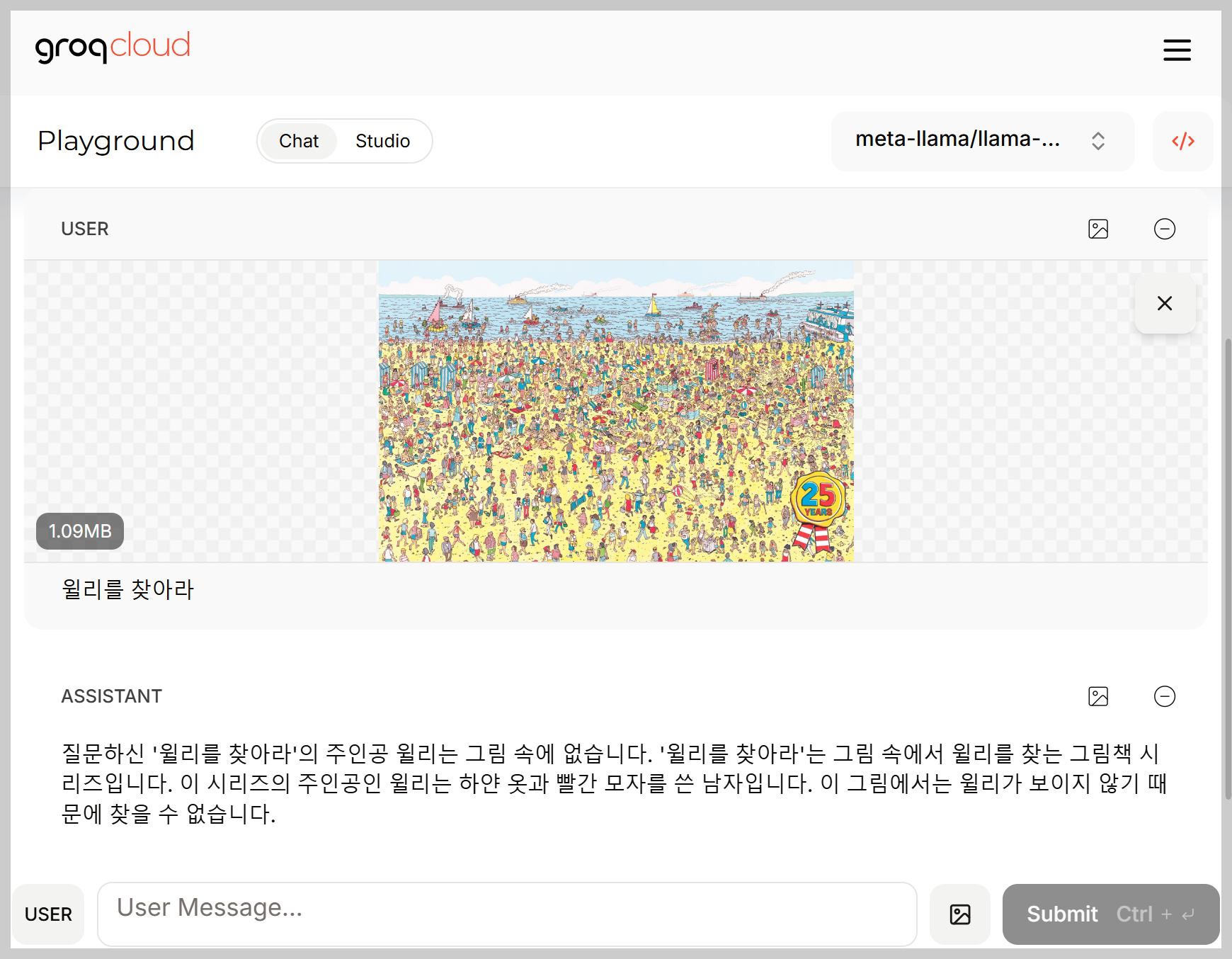

4) 이미지 테스트

윌리가 해변에 있다는 Llama-4의 답변에 빵 터져서 한 번 더 질문했습니다. 하지만 결국 Llama-4-Maverick-17B는 윌리를 찾지 못하였습니다. 참고로 윌리는 1사분면 중앙에서 약간 왼쪽에 위치해 있습니다.

6. 맺음말

Meta Llama 4는 네이티브 멀티모달리티, 혁신적인 MoE 아키텍처, 획기적으로 확장된 컨텍스트 창 등 이전 세대 모델을 뛰어넘는 다양한 특징과 기능을 통해 AI 분야에 새로운 가능성을 제시하고 있습니다. Llama 4 Scout와 Maverick 모델은 이미 다양한 벤치마크에서 뛰어난 성능을 입증했으며, 특히 추후 공개될 Llama 4 Behemoth와 Reasoning 모델은 더욱 강력한 성능과 특화된 기능을 제공하여 AI 기술의 발전을 이끌어갈 것으로 예상됩니다.

오늘 블로그에서는 Llama-4- Maverick-17B가 우리에게 큰 웃음을 주었네요. 윌리는 해변에 있다..ㅎㅎ Meta의 지속적인 노력과 오픈 소스 커뮤니티의 활발한 참여를 통해 Llama 4가 더 발전하길 기대하면서 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.12.08 - [AI 언어 모델] - 🦙Llama 3.3: Claude 3.5 Sonnet 따라잡은 메타의 최신 AI 언어 모델

🦙Llama 3.3: Claude 3.5 Sonnet 따라잡은 메타의 최신 AI 언어 모델

안녕하세요! 오늘은 Meta에서 새롭게 발표한 최신 AI 모델 Llama 3.3에 대해 소개드리겠습니다. Llama 3.3은 텍스트 생성과 대화형 AI 애플리케이션에 최적화된 다국어 대규모 언어 모델(LLM)로, 700억 개

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| 🔍🧬📊o3, o4-mini: GPT-4o에 이은 OpenAI의 차세대 추론 모델 (6) | 2025.04.18 |

|---|---|

| ✨📈🦾GPT-4.1: 100만 토큰 지원하는 OpenAI의 차세대 언어 모델 (6) | 2025.04.16 |

| 🤖🔍QVQ-Max: 생각하고 이해하는 알리바바의 최첨단 시각적 추론 AI (6) | 2025.03.31 |

| 👀👂🗣️✍️Qwen2.5-Omni: 보고, 듣고, 말하고, 쓰는 차세대 멀티모달 모델! (2) | 2025.03.30 |

| 🔥♊Gemini 2.5 Pro-Exp: LMArena 1위! 구글의 최신 플래그십 AI 모델 (12) | 2025.03.29 |