안녕하세요! 오늘은 Aria라는 오픈소스 멀티모달 네이티브 Mixture-of-Experts (MoE) 모델에 대해서 알아보겠습니다. Aria는 Rhymes AI가 개발한 모델로 텍스트, 이미지, 비디오, 코드를 포함한 다양한 형태의 데이터를 단일 모델로 처리하고 이해할 수 있습니다. Aria는 멀티모달 네이티브 이해, 긴 컨텍스트 윈도우, 빠른 처리 속도와 뛰어난 명령어 따르기 능력, 오픈소스 및 개발자 친화적인 환경을 통해 다양한 멀티모달 작업에서 잠재력을 가진 강력한 AI 모델입니다. 이 블로그에서는 Aria의 개요, 특징, 주요기능, 벤치마크 결과에 대해 알아보고, 실제성능을 테스트해 보겠습니다.

https://rhymes.ai/

We're building the next generation of advanced multimodal AI. Developed with speedy, powerful, and advanced reasoning, designed to be intuitive and accessible for everyone.

rhymes.ai

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

Aria 개요

Aria는 Rhymes AI에서 개발한 오픈소스, 멀티모달 네이티브 Mixture-of-Experts (MoE) 모델로, 텍스트, 이미지, 비디오 및 코드를 한 번에 처리할 수 있으며, 각 유형에 대해 별도의 설정이 필요하지 않습니다. Aria 모델은 249억 개의 매개변수를 가지고 있으며, 텍스트 토큰당 35억 개, 비주얼 토큰당 39억 개의 매개변수가 활성화되고, 64,000 토큰의 컨텍스트 크기를 가지고 있습니다.

- 최상의 오픈 멀티모달 네이티브 모델: Aria는 텍스트, 코드, 이미지, 비디오와 같은 다양한 입력 모달리티를 위해 설계된 단일 모델로, 광범위한 멀티모달, 언어 및 코딩 작업에서 Pixtral-12B 및 Llama3.2-11B보다 우수한 성능을 보여주는 모델입니다. 활성화된 매개변수 수가 39억 개로 적기 때문에 더 낮은 추론 비용을 누릴 수 있습니다.

- 독점 모델과의 경쟁력: Aria는 문서 이해, 차트 읽기, 장면 텍스트 인식 및 비디오 이해를 포함한 다양한 멀티모달 작업에서 GPT-4o 및 Gemini-1.5와 같은 독점 모델과 경쟁력 있는 성능을 보여줍니다.

- 긴 컨텍스트 멀티모달 이해: Aria는 Qwen2-VL-7B 및 LLaVA-OneVision-72B와 같은 오픈 모델보다 훨씬 뛰어나게 데이터를 이해하며, 독점 모델과 비교할 때 긴 비디오 이해에서 GPT-4o mini보다 뛰어나고, 긴 문서 이해에서 Gemini-1.5-Flash보다 뛰어나므로, 컴퓨팅 효율적이고 시간 효율적인 방식으로 긴 멀티모달 데이터를 처리할 수 있습니다.

- 긴 컨텍스트 윈도우: Aria는 64,000 토큰의 긴 멀티모달 컨텍스트 윈도우를 가지고 있어 256프레임 비디오를 10초 안에 캡션할 수 있습니다.

- 오픈소스: Aria는 협업 개발을 위해 모델 가중치, 코드 저장소, 기술 보고서를 오픈소스로 제공합니다. 라이선스는 Apache 2.0입니다.

https://huggingface.co/rhymes-ai/Aria

rhymes-ai/Aria · Hugging Face

Aria Model Card Key features SoTA Multimodal Native Performance: Aria achieves strong performance on a wide range of multimodal, language, and coding tasks. It is superior in video and document understanding. Lightweight and Fast: Aria is a mixture-of-expe

huggingface.co

Aria 주요기능 및 벤치마크 결과

Aria는 문서 이해, 이미지 인식, 비디오 이해와 같은 멀티모달 작업과, 긴 시퀀스를 포함하는 데이터를 처리할 수 있으며, 명령어 따르기 및 단계별 학습 파이프라인으로 새로운 데이터를 학습할 수 있습니다. Aria의 주요 기능은 다음과 같습니다.

- 멀티모달 네이티브 성능: Aria는 최고의 오픈 및 클로즈드 멀티모달 네이티브 모델과 비교하여 다양한 멀티모달, 언어 및 코딩 작업에서 뛰어난 성능을 보여줍니다. 특히 Pixtral-12B 및 Llama3.2-11B와 같은 모델보다 우수한 성능을 나타냅니다. 또한 문서 이해, 차트 읽기, 장면 텍스트 인식 및 비디오 이해를 포함한 멀티모달 작업에서 GPT-4o 및 Gemini-1.5와 같은 독점 모델과 경쟁력 있는 성능을 보여줍니다.

- 긴 멀티모달 입력 이해: Aria는 자막이 있는 비디오 또는 긴 문서와 같이 시각적 요소와 텍스트가 결합된 긴 시퀀스를 포함하는 복잡한 멀티모달 데이터를 효율적으로 이해하고 처리할 수 있습니다. Aria는 긴 비디오 이해에서 GPT-4o mini를 능가하고 긴 문서 이해에서 Gemini-1.5-Flash를 능가합니다.

- 명령어 따르기: Aria는 MIA-Bench 및 MT-Bench에서 최고의 오픈소스 모델보다 뛰어난 성능을 보여주며 멀티모달 및 언어 입력에 대한 명령을 이해하고 따르는 데 매우 효과적입니다.

- 멀티모달 네이티브 학습: Aria는 4단계 학습 파이프라인을 사용하여 처음부터 사전 학습되어 이전에 습득한 지식을 유지하면서 점진적으로 새로운 기능을 학습합니다.

또한, Aria는 다양한 벤치마크에서 최첨단 성능을 보여주는 오픈 멀티모달 네이티브 MoE 모델로, 3.9B의 활성화된 매개변수를 가지고 있어 빠른 추론 속도와 낮은 미세 조정 비용을 가능하게 합니다.

멀티모달 성능: 다양한 지표에서 Pixtral 12B 및 Llama3.2 11B를 능가하고, 일부 벤치마크에서 GPT-4o 및 Gemini-1.5보다 우수한 성능을 보입니다. 하지만, 항상 벤치마크 지표가 실제 성능과 일치하진 않으므로 주의가 필요합니다.

- 지식: MMMU 벤치마크에서 Aria는 54.9점을 기록하며 Pixtral 12B(52.5점) 및 Llama3.2 11B(50.7점) 보다 우수한 성능을 보였습니다.

- 수학: MathVista 벤치마크에서 Aria는 66.1점을 기록하며 Pixtral 12B(58.0점) 및 Llama3.2 11B(51.5점) 보다 우수한 성능을 보였습니다.

- 문서 이해: DocQA 벤치마크에서 Aria는 92.6점을 기록하며 Pixtral 12B(90.7점) 및 Llama3.2 11B(84.4점) 보다 우수한 성능을 보였습니다.

- 차트 이해: ChartQA 벤치마크에서 Aria는 86.4점을 기록하며 Pixtral 12B(81.8점) 및 Llama3.2 11B(83.4점) 보다 우수한 성능을 보였습니다.

- 장면 텍스트 인식: TextVQA 벤치마크에서 Aria는 81.1점을 기록하며 Gemini-1.5 Flash(78.7점) 보다 우수한 성능을 보였습니다.

- 일반 시각적 질의응답: MMBench-1.1 벤치마크에서 Aria는 80.3점을 기록하며 GPT-4o mini(76.0점) 보다 우수한 성능을 보였습니다.

- 비디오 이해: LongVideoBench 벤치마크에서 Aria는 65.3점을 기록하며 Pixtral 12B(47.4점) 및 Llama3.2 11B(45.7점) 보다 우수한 성능을 보였으며, GPT-4o 및 Gemini-1.5보다도 높은 점수를 기록하였습니다.

언어 및 코딩 성능: 지식, 수학, 추론, 코딩 등 대부분 지표에서 기존 오픈소스 멀티모달 모델을 앞서는 성능을 보입니다.

- 지식: MMLU (5-shot) 벤치마크에서 Aria는 73.3점을 기록하며 Pixtral 12B(69.2점) 및 Llama3.2 11B(69.4점) 보다 우수한 성능을 보였습니다.

- 수학: MATH 벤치마크에서 Aria는 50.8점을 기록하며 Pixtral 12B(48.1점) 보다 우수한 성능을 보였습니다.

- 추론: 복잡한 과학 문제들로 구성된 ARC Challenge 벤치마크에서 Aria는 91.0점을 기록하며 Llama3.2 11B(83.4점) 보다 우수한 성능을 보였습니다.

- 코딩: HumanEval 벤치마크에서 Aria는 73.2점을 기록하며 Pixtral 12B(72.0점) 및 Llama3.2 11B(72.6점) 보다 우수한 성능을 보였습니다.

Aria는 다양한 벤치마크에서 인상적인 결과를 보여주는 강력한 오픈 멀티모달 네이티브 MoE 모델입니다. 특히 긴 컨텍스트 멀티모달 이해와 명령어 수행 능력이 뛰어납니다. Aria는 멀티모달 AI 모델의 개발과 적용에 중요한 진전을 이루었으며 광범위한 실제 애플리케이션에 사용될 수 있는 잠재력이 있습니다.

Aria 테스트

다음은 Aria 모델의 성능을 몇 가지 테스트해 보겠습니다. 테스트는 아래 Rhymes AI의 웹 사이트에 접속해서 웹 페이지 하단에 있는 "Try Aria!"를 클릭해서 테스트하였습니다. 현재 웹 사이트에서는 Aria 모델과의 대화, 1 세션에 사용자 프롬프트 5회가 넘으면 다시 새로운 세션을 시작해야 하고, 1 프롬프트 당 2000자 이상을 초과할 수 없습니다.

1. 긴 텍스트 요약: 먼저 약 1,500자 정도의 영어문장을 1 문장으로 요약하도록 요청하였습니다.

| 질문 | Please summarize the following content in English in 1 sentences. Aria is an open-source, multimodal native Mixture-of-Experts (MoE) model developed by Rhymes AI that can process text, images, videos, and code at once, without the need for separate settings for each type. The Aria model has 24.9 billion parameters, with 3.5 billion parameters activated per text token and 3.9 billion parameters activated per visual token, and a context size of 64,000 tokens. Best open multimodal native model: Aria is a single model designed for different input modalities such as text, code, images, and videos, and is a model that outperforms Pixtral-12B and Llama3.2-11B in a wide range of multimodal, language, and coding tasks. It has a lower number of activated parameters at 3.9 billion, so it can enjoy a lower inference cost. Competitive with proprietary models: Aria shows competitive performance with proprietary models such as GPT-4o and Gemini-1.5 in a variety of multimodal tasks, including document understanding, chart reading, scene text recognition, and video understanding. Long context multimodal understanding: Aria is excellent at long context multimodal understanding. Real-world multimodal data is inherently complex, and often involves long sequences of visual-language inputs, such as videos with subtitles or multi-page documents. Aria understands data much better than open models such as Qwen2-VL-7B and LLaVA-OneVision-72B, and when compared to proprietary models, it outperforms GPT-4o mini in long video understanding and Gemini-1.5-Flash in long document understanding, making it a preferred choice for processing long multimodal data in a computationally efficient and time-efficient manner. Long context window: Aria has a long multimodal context window of 64,000 tokens, which allows it to caption a 256-frame video in 10 seconds. |

| Aria 답변 |

Aria, an open-source, multimodal native Mixture-of-Experts (MoE) model by Rhymes AI, can process text, images, videos, and code simultaneously without separate settings. With 24.9 billion parameters, 3.5 billion for text and 3.9 billion for visual tokens, and a context size of 64,000 tokens, it outperforms Pixtral-12B and Llama3.2-11B in various tasks and is competitive with proprietary models like GPT-4o and Gemini-1.5, excelling in long video and document understanding, thanks to its 64,000-token context window that enables it to caption a 256-frame video in 10 seconds.- 프롬프트 미준수 |

| 라이머스 AI의 오픈소스 멀티모달 네이티브 Mixture-of-Experts(MoE) 모델인 아리아는 별도의 설정 없이 텍스트, 이미지, 비디오, 코드를 동시에 처리할 수 있습니다. 249억 개의 파라미터, 텍스트 35억 개, 시각 토큰 39억 개, 컨텍스트 크기 64,000 토큰으로 다양한 작업에서 Pixtral-12B 및 Llama3.2-11B를 능가하고 GPT-4o 및 Gemini-1.5와 같은 독점 모델과 경쟁하며, 256프레임 비디오를 10초 만에 캡션할 수 있는 64,000토큰 컨텍스트 창 덕분에 긴 비디오 및 문서 이해에서 뛰어납니다. | |

| GPT-4o-mini 답변 |

Aria, an open-source, multimodal Mixture-of-Experts model with 24.9 billion parameters, processes text, images, videos, and code efficiently, outperforms models like Pixtral-12B and proprietary ones such as GPT-4o and Gemini-1.5 in multimodal tasks, and excels in long-context understanding with a 64,000-token context window, making it a top choice for computationally efficient handling of complex, long-form data. - 프롬프트 준수 |

| 249억 개의 매개변수를 가진 오픈소스 멀티모달 Mixture-of-Experts 모델인 Aria는 텍스트, 이미지, 비디오 및 코드를 효율적으로 처리하며, Pixtral-12B와 같은 모델 및 GPT-4o 및 Gemini-1.5와 같은 독점 모델을 멀티모달 작업에서 능가하고 64,000개 토큰 컨텍스트 창으로 긴 컨텍스트 이해에 뛰어나므로 복잡하고 긴 형식의 데이터를 계산 효율적으로 처리하는 데 있어 최고의 선택입니다. |

테스트 결과, Aria 모델은 1문장으로 요약하라는 프롬프트를 따르지 않고, 2 문장으로 요약하였으며, GPT-4o-mini는 프롬프트를 잘 준수하여 1 문장으로 요약하였습니다. 요약 단어수를 지정해도 Aria는 프롬프트를 잘 준수하지 않았습니다.

2. 추론성능 테스트: 다음은 수학 및 과학적 추론 문제를 테스트하였습니다.

| No. | 문제 | GPT-4o-mini | Aria |

| 1 | 160 students in 5th and 6th grade participated in tree planting. As a result of planting an average of 5 trees each by 6th graders and an average of 3 trees each by 5th graders, a total of 560 trees were planted. How many 5th and 6th graders participated in tree planting?(5, 6학년 학생 160명이 나무 심기에 참여했습니다. 6학년은 평균 5그루, 5학년은 평균 3그루의 나무를 심은 결과, 총 560그루의 나무가 심어졌습니다. 나무 심기에 참여한 5, 6학년 학생은 몇 명인가요?) |

Pass | Pass |

| 2 | Betty is saving money for a new purse. The purse costs $100. Betty only has half the money she needs. Her parents decide to give her $15 for that purpose, and her grandparents give her twice as much as her parents. How much more money does Betty need to buy the purse?(베티는 새 지갑을 사기 위해 돈을 모으고 있습니다. 지갑은 100달러입니다. 베티는 필요한 돈의 절반만 가지고 있습니다. 그녀의 부모님은 그 목적으로 15달러를 주기로 결정하고, 그녀의 조부모님은 부모님보다 두 배 더 많이 줍니다. 베티가 지갑을 사기 위해 얼마나 더 많은 돈이 필요한가요?) | Pass | Pass |

| 3 | A national elementary school math competition was held, and three people, Young-hee, Chul-soo, and Jin-ho, participated. They are students from Seoul, Busan, and Incheon, and they received first, second, and third place awards, respectively. When you know the following, where is Jin-ho from and what place did he get? 1) Young-hee is not a player from Seoul. 2) Chul-soo is not a player from Busan. 3) The player from Seoul is not first place. 4) The player from Busan got second place. 5) Chul-soo is not third place.(전국 초등학생 수학경시대회가 열렸고, 영희, 철수, 진호 세 사람이 참가했다. 이들은 서울, 부산, 인천의 학생이며, 각각 1, 2, 3등 상을 받았다. 다음을 알 때, 진호는 어느 지역 출신이고 몇 등을 했는가? 1) 영희는 서울 출신 선수가 아니다. 2) 철수는 부산 출신 선수가 아니다. 3) 서울 출신 선수는 1등이 아니다. 4) 부산 출신 선수는 2등을 했다. 5) 철수는 3등이 아니다.) | Pass | Pass |

| 4 | There are three murderers in a room. A person enters the room and kills one of them. No one leaves the room. How many murderers are left in the room? Consider only living killers. Explain the reasoning process step by step.(한 방에 살인자가 세 명 있습니다. 한 사람이 방에 들어가서 그 중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 남은 살인자는 몇 명입니까? 살아있는 살인자만 고려하세요. 추론 과정을 단계별로 설명해주세요.) | Pass | Pass |

| 5 | A marble is put in a glass. The glass is then turned upside down and put on a table. Then the glass is picked up and put in a microwave. Where's the marble? Explain your reasoning step by step.(유리잔에 구슬을 넣습니다. 그런 다음 유리잔을 뒤집어 테이블 위에 놓습니다. 그런 다음 유리잔을 집어서 전자레인지에 넣습니다. 구슬은 어디에 있나요? 이유를 단계별로 설명하세요.) | Pass | Pass |

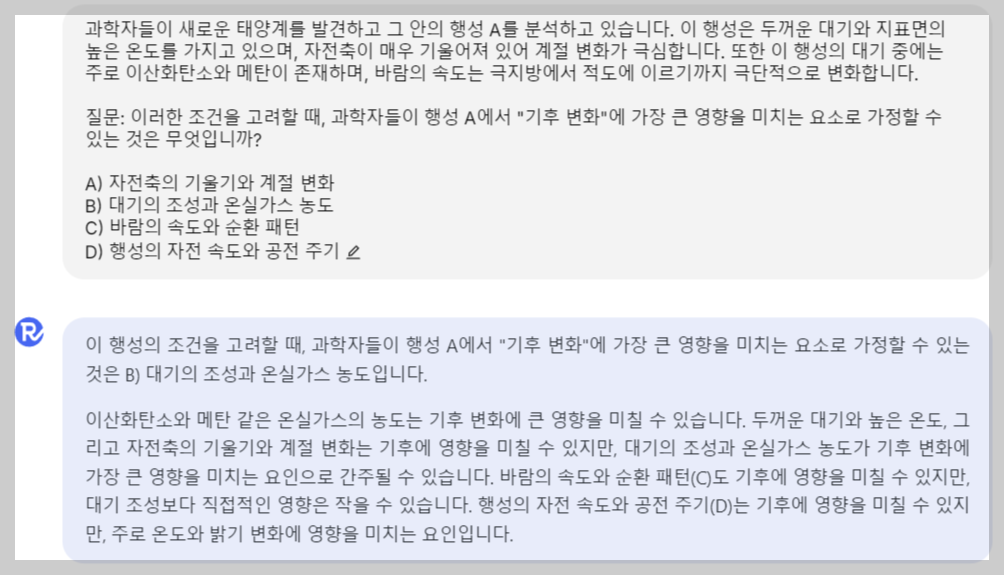

| 6 | 과학자들이 새로운 태양계를 발견하고 그 안의 행성 A를 분석하고 있습니다. 이 행성은 두꺼운 대기와 지표면의 높은 온도를 가지고 있으며, 자전축이 매우 기울어져 있어 계절 변화가 극심합니다. 또한 이 행성의 대기 중에는 주로 이산화탄소와 메탄이 존재하며, 바람의 속도는 극지방에서 적도에 이르기까지 극단적으로 변화합니다. 질문: 이러한 조건을 고려할 때, 과학자들이 행성 A에서 "기후 변화"에 가장 큰 영향을 미치는 요소로 가정할 수 있는 것은 무엇입니까? A) 자전축의 기울기와 계절 변화 B) 대기의 조성과 온실가스 농도 C) 바람의 속도와 순환 패턴 D) 행성의 자전 속도와 공전 주기 | Pass | Pass |

추론 테스트 결과, Aria 모델은 6문제 모두를 맞혔으며, 난이도가 높은 문제도 논리적으로 정확한 답변을 하였습니다.

3. 이미지 인식 테스트: 이미지 내 텍스트, 흐리거나 왜곡된 이미지와 입체 이미지에 대해 테스트하였습니다.

|

|

| 질문) What time does the flight to Bali leave? 답변) The flight to Bali leaves at 00:25. - 오답 |

|

|

|

| 질문) Describe this image 답변) The image depicts a bustling scene with several people in motion, captured with a sense of speed and blur, suggesting movement. The setting appears to be an indoor space, possibly an airport or a train station, given the presence of luggage and the hurried pace of the individuals. The blurred motion of the people conveys a sense of urgency or haste, as if they are in a rush to reach their destination. The background features large windows, allowing natural light to flood the space, and the reflective floor adds to the modern and sleek aesthetic of the environment. The overall atmosphere is dynamic, with a focus on the transient nature of the moment, highlighting the constant movement and activity in such public spaces. - 정답 번역) 이미지는 여러 사람들이 움직이는 모습을 담고 있으며, 움직임이 포착된 것처럼 빠르게 흐릿하게 표현되어 있습니다. 배경은 실내로 보이며, 짐을 들고 있는 사람들의 모습과 서두르는 듯한 분위기로 보아 공항이나 기차역과 같은 장소일 수 있습니다. 사람들의 흐릿한 움직임은 목적지에 도달하기 위해 서두르는 듯한 느낌을 전달합니다. 배경에는 큰 창문이 있어 자연광이 실내로 들어오고, 반사되는 바닥은 현대적이고 세련된 분위기를 자아냅니다. 이러한 분위기는 순간의 일시적인 성격을 강조하며, 이러한 공공장소에서의 끊임없는 움직임과 활동을 강조합니다. |

|

|

|

| 질문) Give me the MMMU, MathVista, ChartQA, DocVQA, and VQAv2 accuracy of each model in numbers 답변) Sure! Here are the accuracy percentages for each model on the different tasks: MMMU Pixtal 12B: ~60% Qwen2-VL 7B: ~30% Phi-3 Vision: ~35% Claude-3 Haiku: ~40% LLaVA-OV 7B: ~50% MathVista Pixtal 12B: ~65% Qwen2-VL 7B: ~55% Phi-3 Vision: ~50% Claude-3 Haiku: ~45% LLaVA-OV 7B: ~55% ChartQA Pixtal 12B: ~75% Qwen2-VL 7B: ~50% Phi-3 Vision: ~65% Claude-3 Haiku: ~60% LLaVA-OV 7B: ~60% DocVQA Pixtal 12B: ~50% Qwen2-VL 7B: ~40% Phi-3 Vision: ~45% Claude-3 Haiku: ~45% LLaVA-OV 7B: ~40% VQAv2 Pixtal 12B: ~70% Qwen2-VL 7B: ~50% Phi-3 Vision: ~65% Claude-3 Haiku: ~60% LLaVA-OV 7B: ~60% These values represent the accuracy percentages for each model on the respective tasks. - 오답 (기울어진 이미지의 시각적 왜곡을 고려하지 않음) |

|

|

|

| 질문) Solve the CAPTCHA 답변) The CAPTCHA code is v4xBG - 정답 |

질문) Tell me the etched number of cubes on each floor. 답변) The numbers on the cubes from the bottom to the top are: First floor: 0, 1, 2, 3 Second floor: 4, 5, 6 Third floor: 7, 8 Fourth floor: 9 - 정답 |

|

|

| 질문) Aria의 코딩 벤치마크 결과는 얼마야? 답변) Aria의 코딩 벤치마크 결과는 73.2입니다. - 정답 | |

테스트 결과 Aria는 일부 복잡하거나 왜곡된 이미지를 제외하고, 대부분의 이미지 테스트에서 상당히 우수한 수준의 이미지 이해성능을 보였습니다.

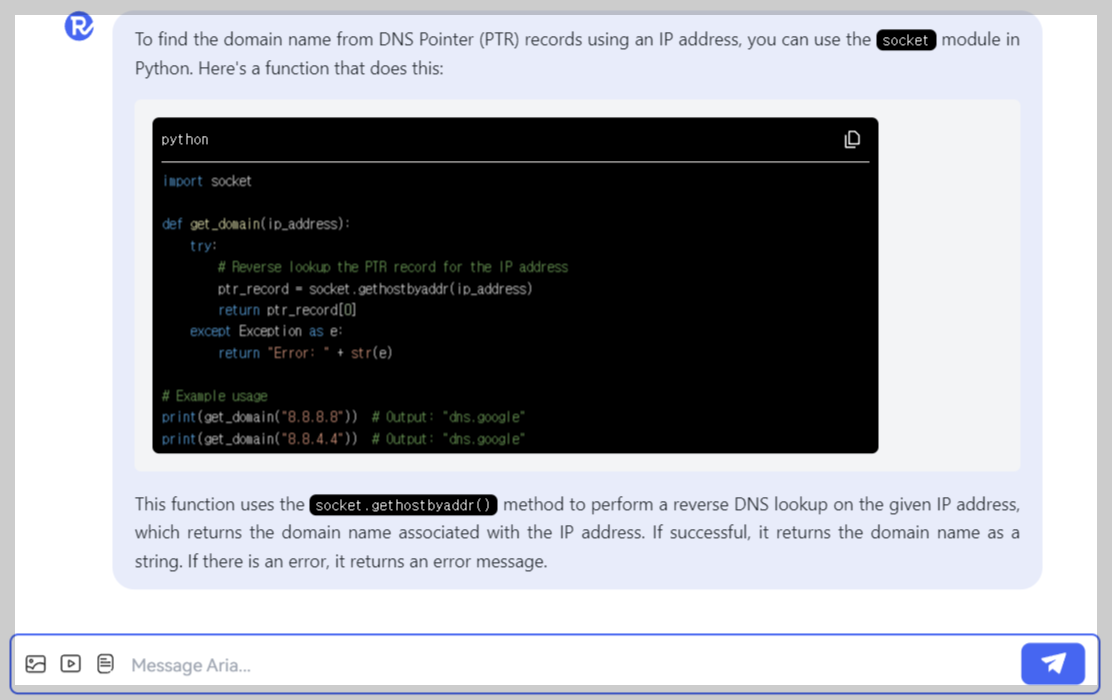

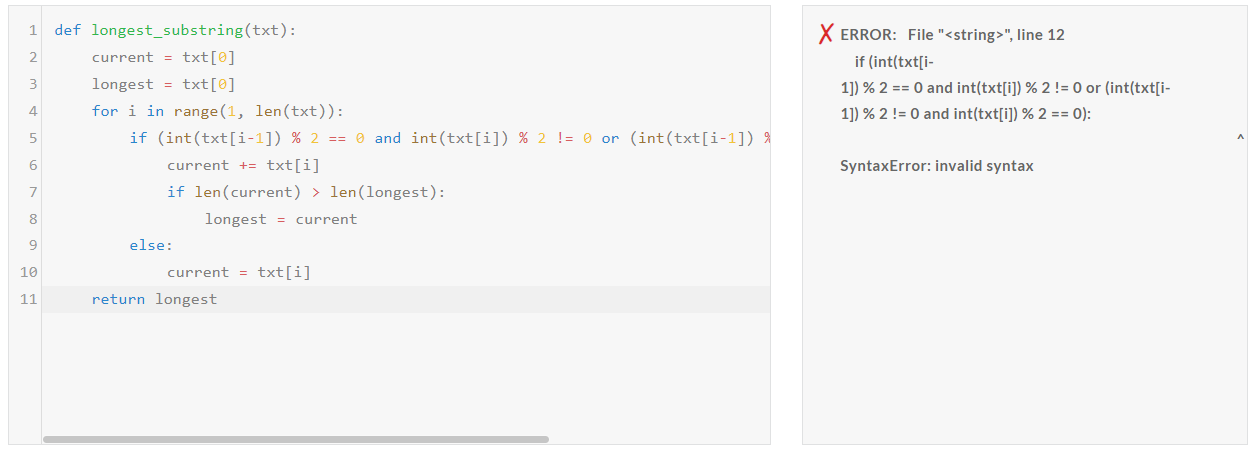

4. 코딩 성능 테스트: https://edabit.com/ 파이썬 난이도 Medium, Hard, Very Hard, Expert 문제를 테스트하였습니다.

| Aria/Pass@1 | Medium | Hard | Very Hard | Expert |

| Python | Pass | Pass | Pass | Fail |

테스트 결과, Expert 난이도를 제외하고 Medium, Hard, Very Hard 문제를 맞혔습니다.

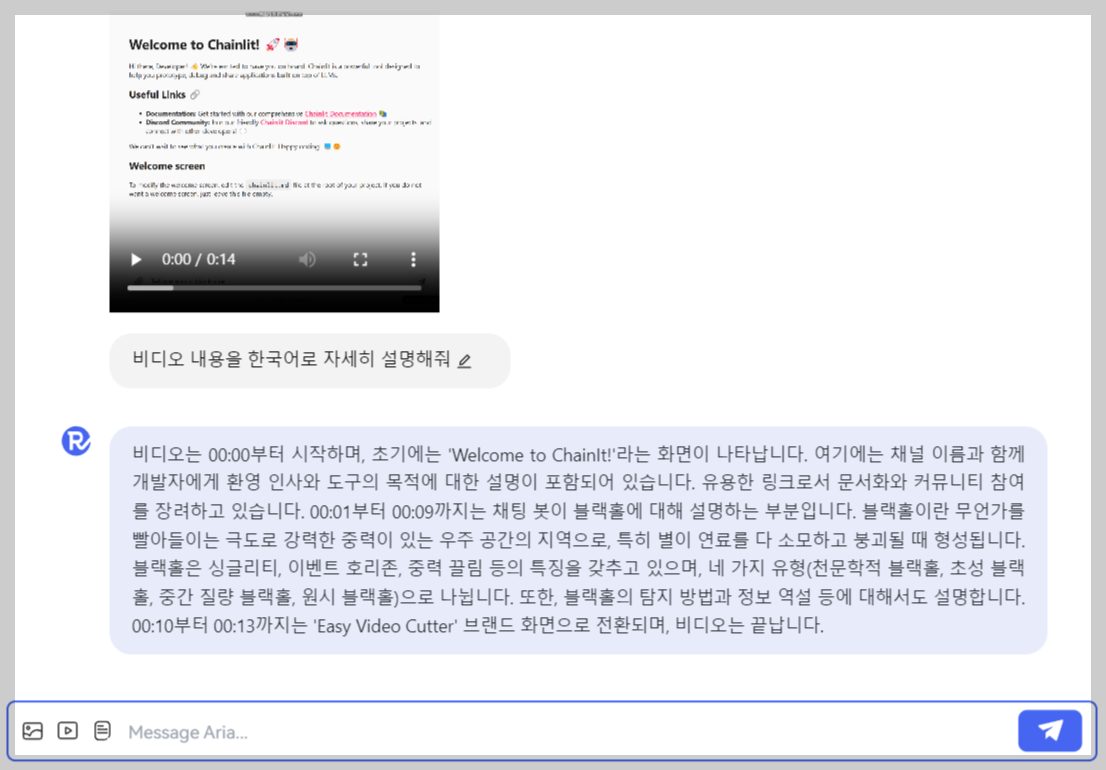

5. 비디오 이해: 현재 Rhyme.ai에서는 4분 길이, 50MB 크기의 비디오 파일로 업로드가 제한되어 있어, 긴 비디오 이해 성능은 테스트하지 못했으며, 대신 짧은 동영상으로 테스트하였습니다.

테스트 결과, Aria는 비디오의 도입부와 주요 내용, 마무리 부분까지 정확하게 설명하였습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

마치며

Aria는 Rhymes AI에서 개발한 오픈소스 멀티모달 네이티브 Mixture-of-Experts (MoE) 모델로, 텍스트, 이미지, 비디오, 코드를 동시에 처리할 수 있습니다. Aria는 249억 개의 매개변수를 가지고 있으며, 64,000 토큰의 긴 컨텍스트 윈도우를 활용해 다양한 멀티모달 작업에서 우수한 성능을 발휘합니다.

또한 Aria는 최신 오픈소스 모델 Pixtral-12B 및 Llama3.2-11B보다 나은 성능을 보여주며, GPT-4o와 Gemini-1.5와 같은 독점 모델과도 경쟁력을 갖추고 있습니다. 여러분도 Rhymes AI 사이트에서 Aria 모델의 멀티모달 기능을 체험하고, 오픈소스 모델의 발전을 느껴보시면 좋을 것 같습니다.

오늘 블로그 내용은 여기까지입니다. 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.09.18 - [AI 언어 모델] - 🖼️Pixtral 12B: 추론과 코딩에 강한 Mistral AI의 첫번째 멀티모달 모델

🖼️Pixtral 12B: 추론과 코딩에 강한 Mistral AI의 첫번째 멀티모달 모델

안녕하세요! 오늘은 Mistral AI의 첫 번째 멀티모달 모델, Pixtral 12B에 대해 알아보겠습니다. Pixtral 12B는 텍스트와 이미지를 동시에 이해하는 모델로, 128k 토큰의 긴 컨텍스트 윈도우를 지원하며 임

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| 🎙️Spirit LM: 풍부한 감정을 표현하는 Meta의 최신 음성 모델 (33) | 2024.10.23 |

|---|---|

| 🏆NVIDIA Llama-3.1-nemotron-70B: GPT-4o를 뛰어넘은 오픈소스 모델 (36) | 2024.10.20 |

| 🚀Flux 1.1 Pro: 6배 더 빨라진 고품질 이미지 생성 모델🎨 (22) | 2024.10.07 |

| 🎬Movie Gen: 메타의 차세대 미디어 생성 AI 모델🤖 (30) | 2024.10.05 |

| 👁️🤖Llama 3.2: 에지 컴퓨팅과 비전까지 확장한 Meta의 AI 모델 (36) | 2024.09.28 |