안녕하세요! 오늘은 Lightning AI라는 클라우드 컴퓨팅 기반 AI 개발 플랫폼을 소개해 드리겠습니다. Lightning AI는 머신러닝(ML)과 인공지능(AI) 프로젝트를 빠르고 효율적으로 개발, 프로토타입, 훈련, 배포, 호스팅 할 수 있는 플랫폼으로, 코드 작성부터 모델 배포까지 모든 과정을 단순화하고 가속화할 수 있습니다. 이 블로그에서는 Lightning AI의 개요, 특징에 대해 알아보고, GPU 클라우드 Ollama 실행방법에 대해 알아보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

Lightning AI 개요

Lightning AI는 브라우저 기반의 클라우드 플랫폼으로, AI와 머신러닝 프로젝트를 빠르고 효율적으로 개발, 프로토타입, 훈련, 배포할 수 있습니다. 복잡한 환경 설정 없이 GPU를 무료로 사용할 수 있으며, 다중 노드 훈련과 무한 스토리지를 지원해 대규모 작업을 간편하게 처리하고, 협업 기능과 경제적인 사용 비용으로 다양한 사용자에게 사랑받고 있습니다.

Lightning AI의 주요 특징 및 장점은 다음과 같습니다.

- Zero Setup: 복잡한 환경 설정 없이 브라우저에서 바로 사용할 수 있습니다. 로컬 환경과 클라우드 환경의 불일치를 제거하여 생산성을 높입니다.

- 통합 개발 환경: VSCode와 같은 친숙한 개발 도구를 브라우저에서 사용할 수 있으며, 필요한 모든 종속성, 코드, 컴퓨팅 자원을 한 곳에서 관리할 수 있습니다.

- 다중 노드 지원: 빠른 다중 노드 훈련을 지원하여 대규모 모델 훈련을 더욱 효율적으로 수행할 수 있습니다.

- GPU 전환: CPU에서 GPU로의 전환이 빠르고 간편하여, 파일 복사나 마운트 작업 없이도 쉽게 처리할 수 있습니다.

- 협업 기능: 여러 명의 전문가가 동시에 실험을 진행하고 디버깅할 수 있는 협업 환경을 제공합니다.

- 확장성: 무한한 스토리지와 클라우드 컴퓨팅 자원을 이용하여 대규모 데이터 처리와 모델 훈련을 할 수 있습니다.

- 비용 효율성: 사용한 만큼만 비용을 지불하는 Pay-as-you-go 방식과 무료 GPU 시간을 제공하여 경제적인 사용이 가능합니다.

Lightning AI는 빠른 프로토타입 개발이 가능하여 모델이 작동하는지 하루 만에 확인할 수 있으며, 간편한 환경 관리로 환경 설정 없이도 로컬 머신에서 작업하는 것처럼 편리하게 클라우드에서 작업할 수 있습니다. 또한 대규모 모델 피팅으로 수천 개의 모델을 몇 주 만에 피팅할 수 있어, AI 개발을 혁신적으로 단순화하고 가속화하는 도구입니다.

Lightning AI | Turn ideas into AI, Lightning fast

The all-in-one platform for AI development. Code together. Prototype. Train. Scale. Serve. From your browser - with zero setup. From the creators of PyTorch Lightning.

lightning.ai

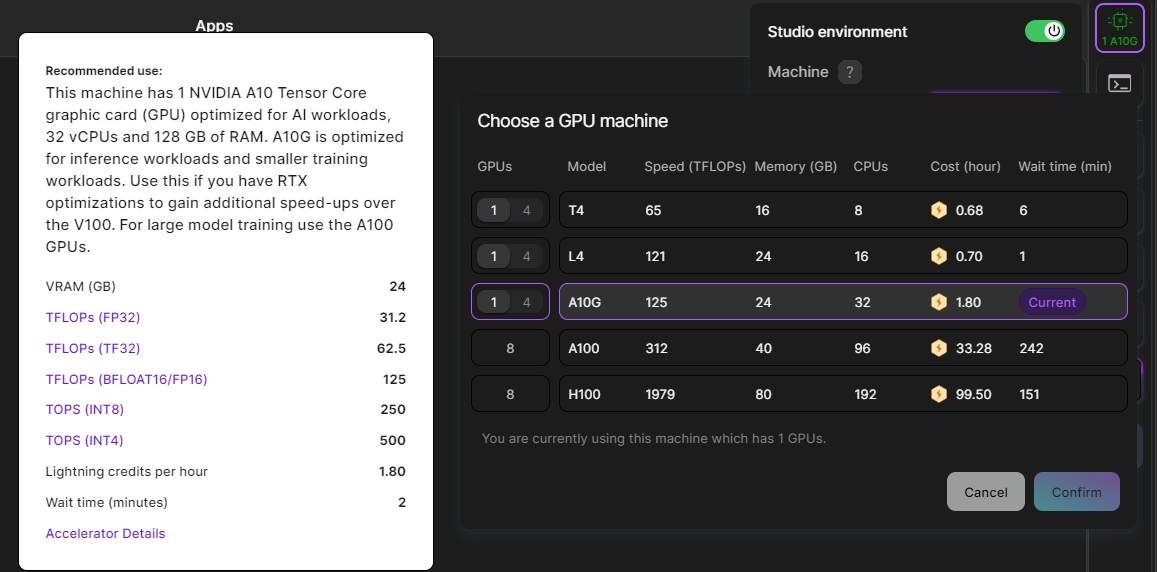

Lightning AI에 가입하면 한 달에 15 크레디트를 무료로 제공(1 크레디트=1 USD) 해 주며, A10G GPU의 이용요금이 시간당 1.8 크레디트이므로, 한 달에 8시간 넘게 무료로 A10G GPU를 사용하실 수 있습니다. 추가로 사용하고자 하면 원하는 GPU 성능과 기간을 선택해서 결제하면 됩니다.

무료로 사용가능한 A10G GPU의 성능을 구글 Colab의 T4와 비교해 보면, CUDA 코어는 9216개로 T4의 2560개보다 훨씬 많으며, FP32 성능은 최대 31.2 TFLOPS로 T4의 8.1 TFLOPS보다 약 4배 높은 성능을 제공합니다. A10G의 메모리는 24GB GDDR6 메모리를 가지고 있으며, T4의 16GB보다 더 큰 용량이고, 메모리 대역폭은 600 GB/s로 T4의 320 GB/s보다 약 2배 높은 대역폭을 제공합니다.

| Specification | NVIDIA T4 | NVIDIA A10G |

| Architecture | NVIDIA Turing | NVIDIA Ampere |

| GPU Memory | 16GB GDDR6 | 24GB GDDR6 |

| CUDA Cores | 2560 | 9216 |

| Tensor Cores | 320 | 288 |

| RT Cores | 40 | 72 |

| FP32 Performance | 8.1 TFLOPS | 31.2 TFLOPS |

| Tensor Performance | 65 TFLOPS (FP16, Sparse) |

249.6 TFLOPS (FP16, Sparse)

|

| Memory Bandwidth | 320 GB/s | 600 GB/s |

| TDP (Thermal Design Power) | 70W | 150W |

GPU 클라우드 Ollama

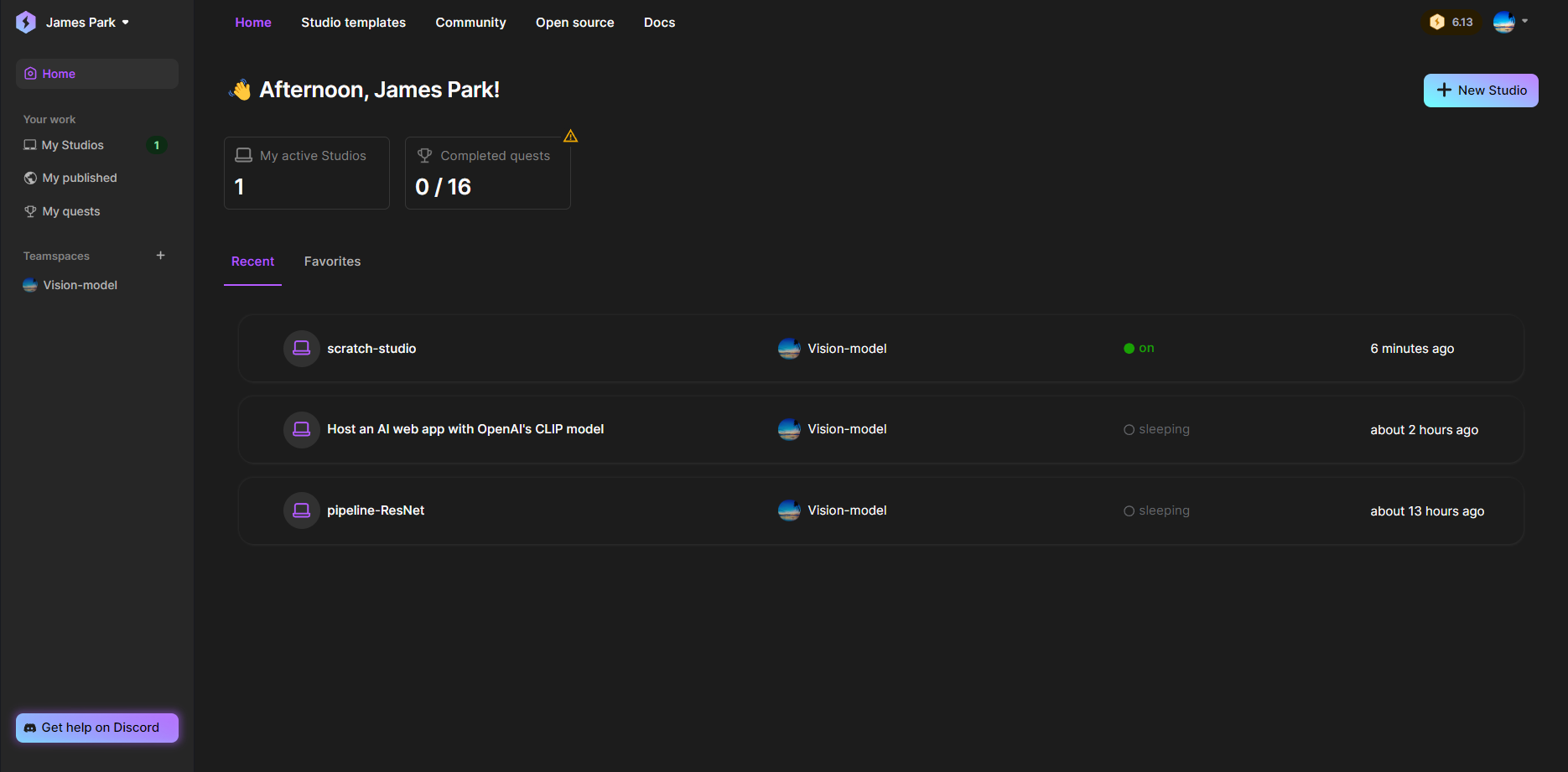

Lightning AI에서 제공하는 무료 GPU 클라우드를 이용해서 빠르고 쾌적하게 Ollama 언어 모델 애플리케이션을 실행해 보겠습니다. Lightning AI에 가입하고, 기본적인 사항을 입력하면, 아래와 같은 홈화면까지 쉽게 오실 수 있습니다.

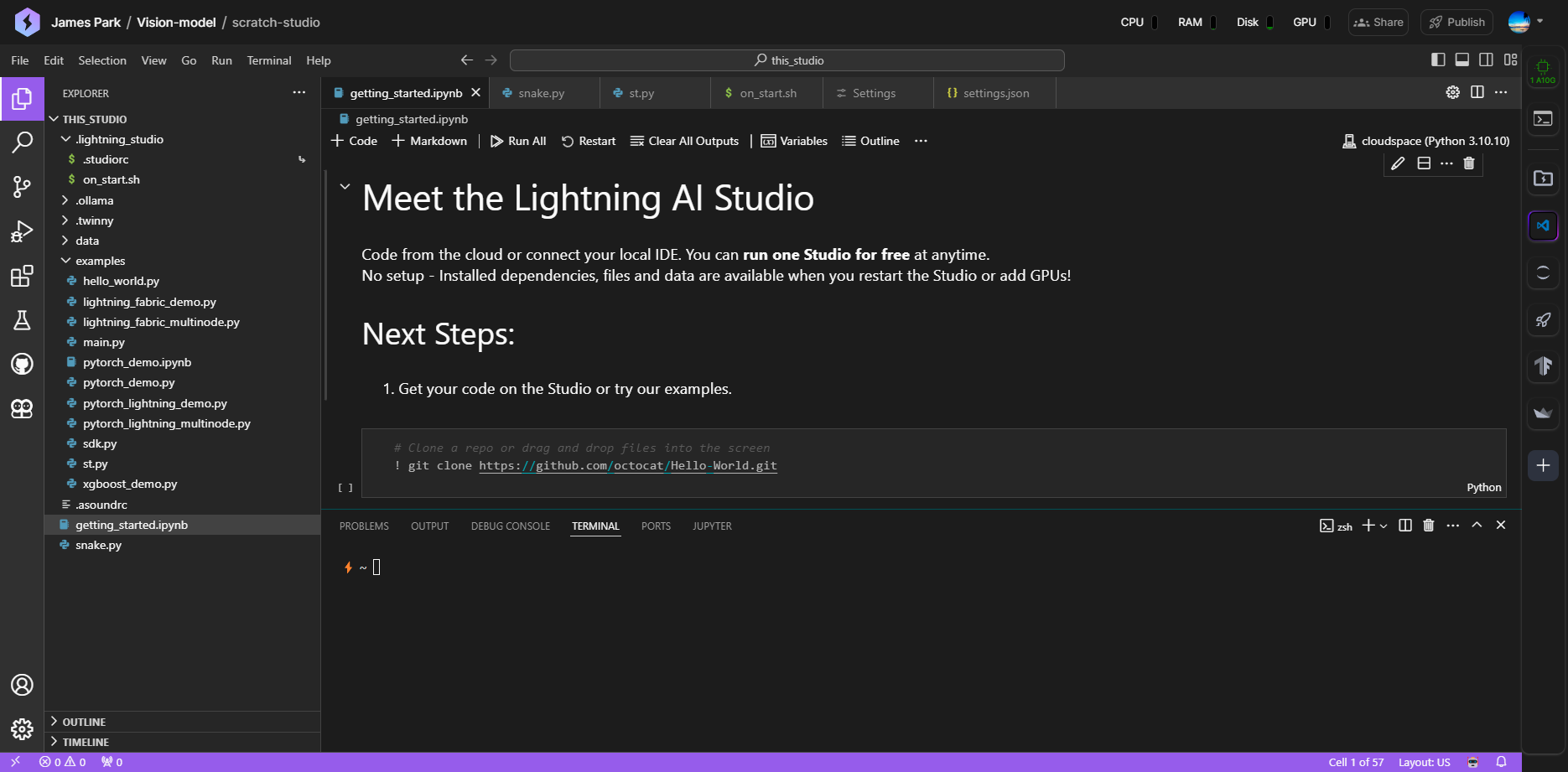

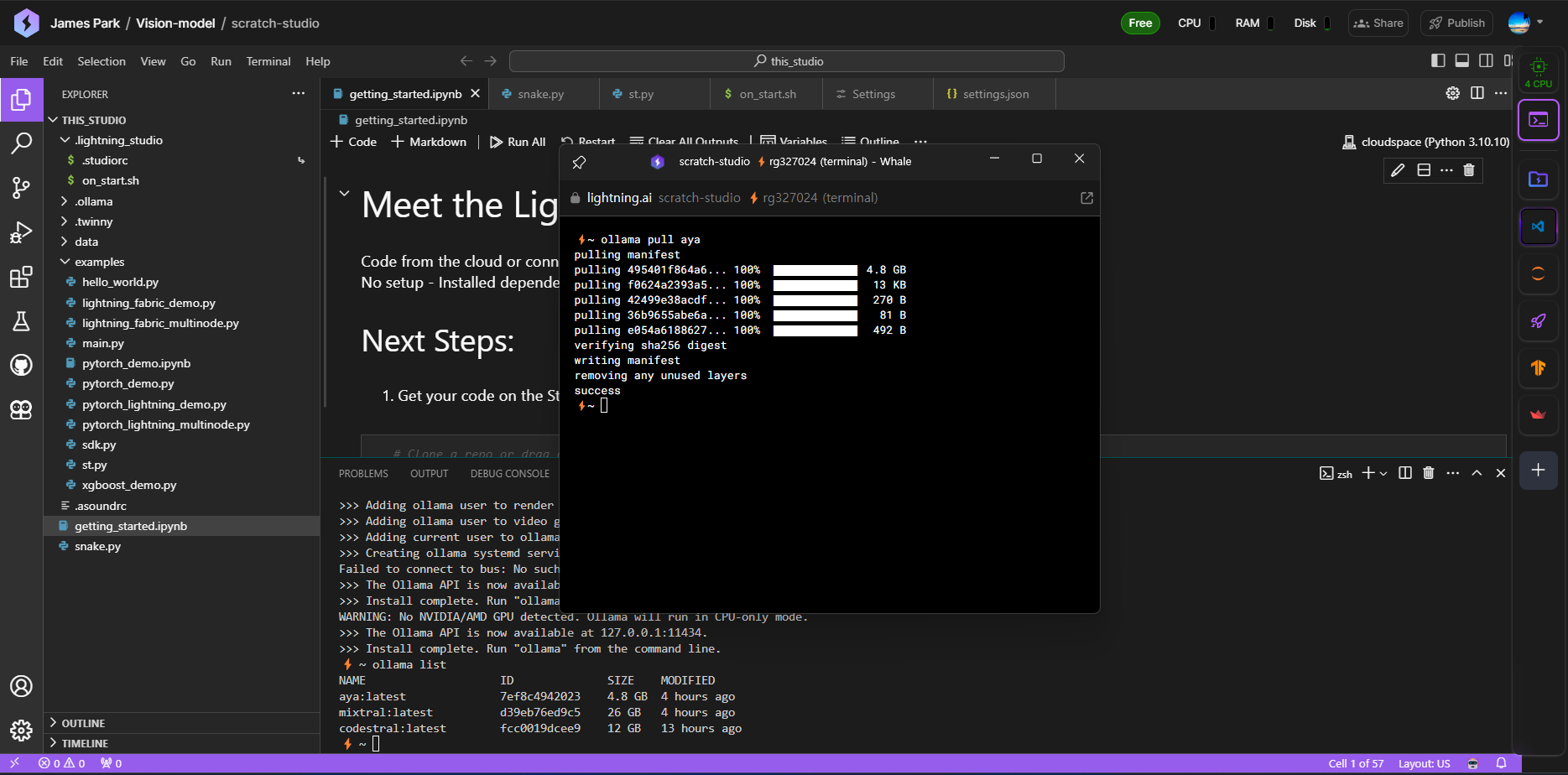

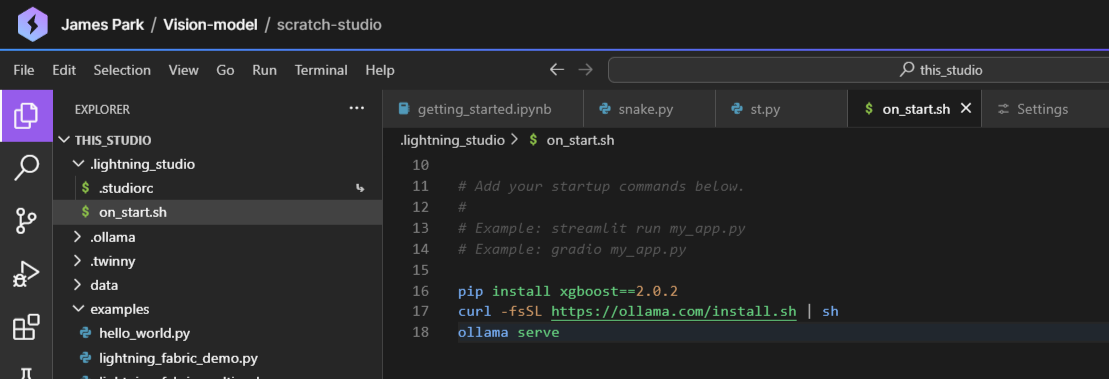

Lightning AI에서 기본적으로 생성되는 단위 개발환경, scratch-studio를 클릭하면 아래 화면과 같이 비주얼 스튜디오 코드와 동일한 인터페이스를 만나실 수 있습니다.

GPU 클라우드에서 Ollama 애플리케이션을 실행하기 위한 작업순서는 다음과 같습니다.

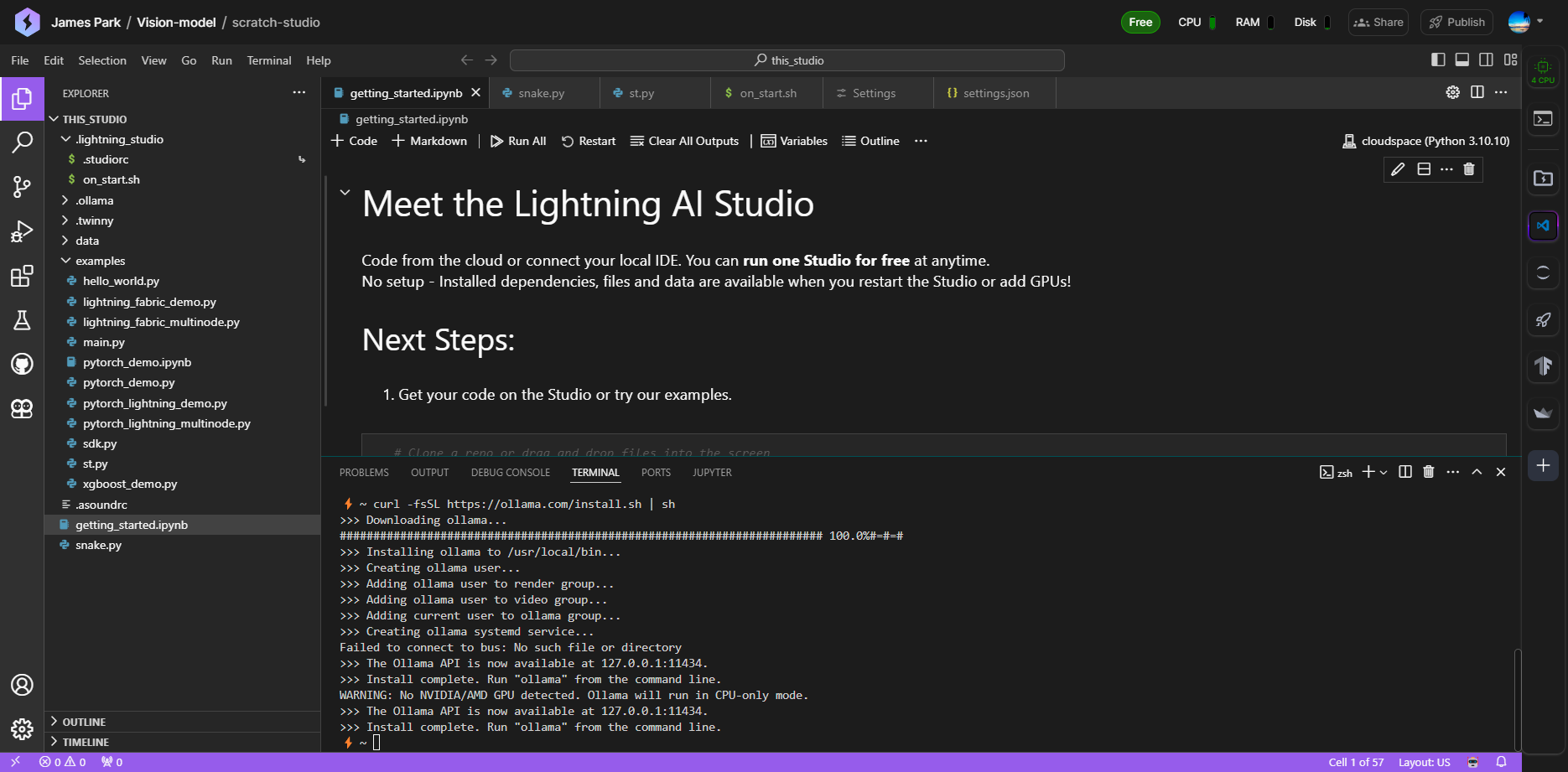

1. Ollama 설치 및 기동: 터미널에 아래 명령어를 입력해서 Ollama를 설치하고 기동 합니다.

curl -fsSL https://ollama.com/install.sh | sh

ollama serve

2. Aya 23 모델 다운로드: 아래 명령어로 Aya 23 언어모델을 다운로드합니다. Aya 23 언어모델에 대한 자세한 내용은 이전 포스팅을 참조하시기 바랍니다.

2024.06.01 - [AI 언어 모델] - [AI 논문] Aya 23 모델: 🌐23개 언어 지원 다국어 LLM 성능 분석

[AI 논문] Aya 23 모델: 🌐23개 언어 지원 다국어 LLM 성능 분석

안녕하세요! 오늘은 Command R+ 언어모델로 유명한 Cohere의 최신 다국어 지원 언어모델 Aya 23에 대해서 알아보겠습니다. Aya 23 모델은 23개 언어를 지원하는 다국어 언어 모델로, 높은 성능의 사전 학

fornewchallenge.tistory.com

ollama pull aya

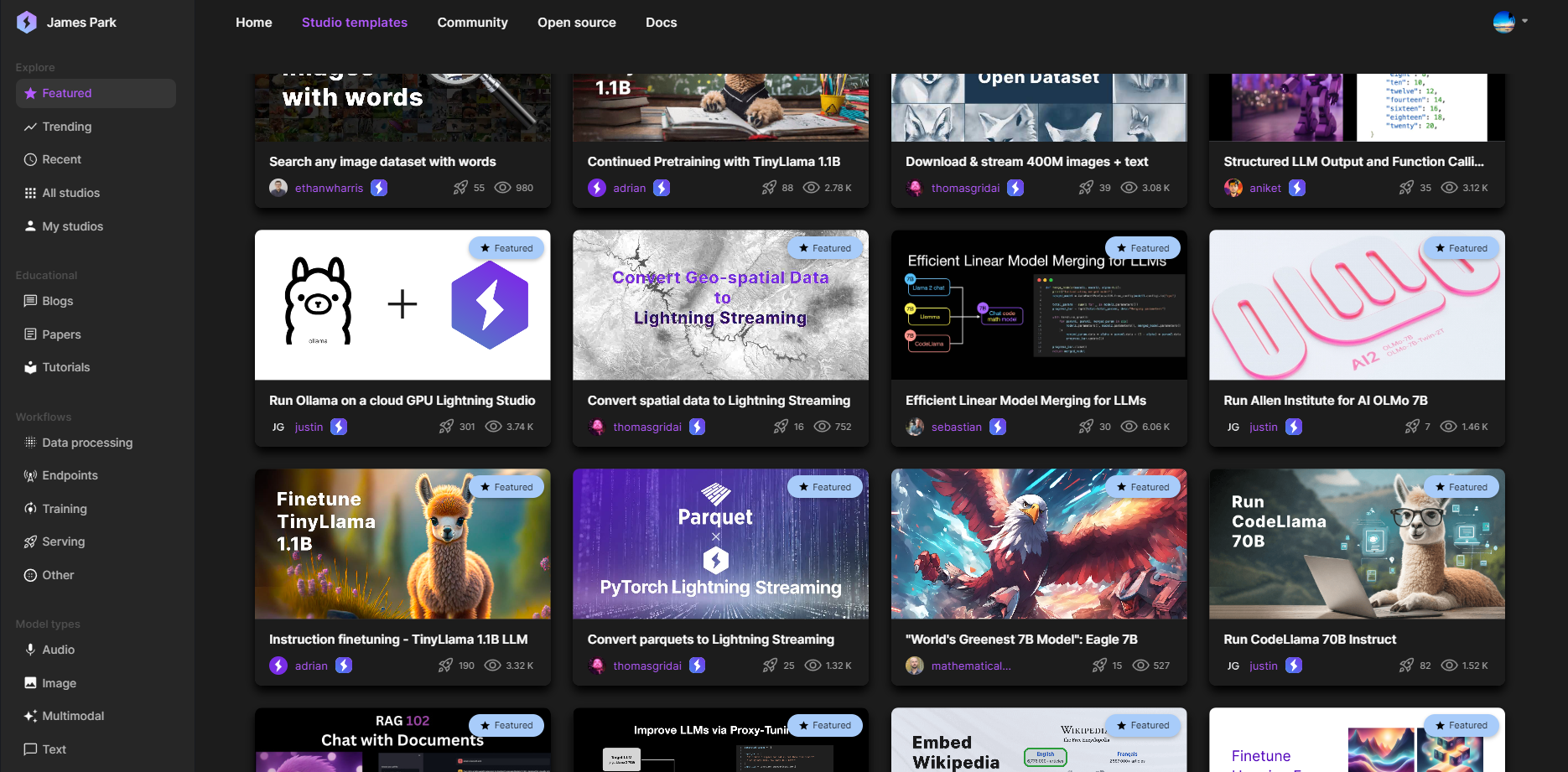

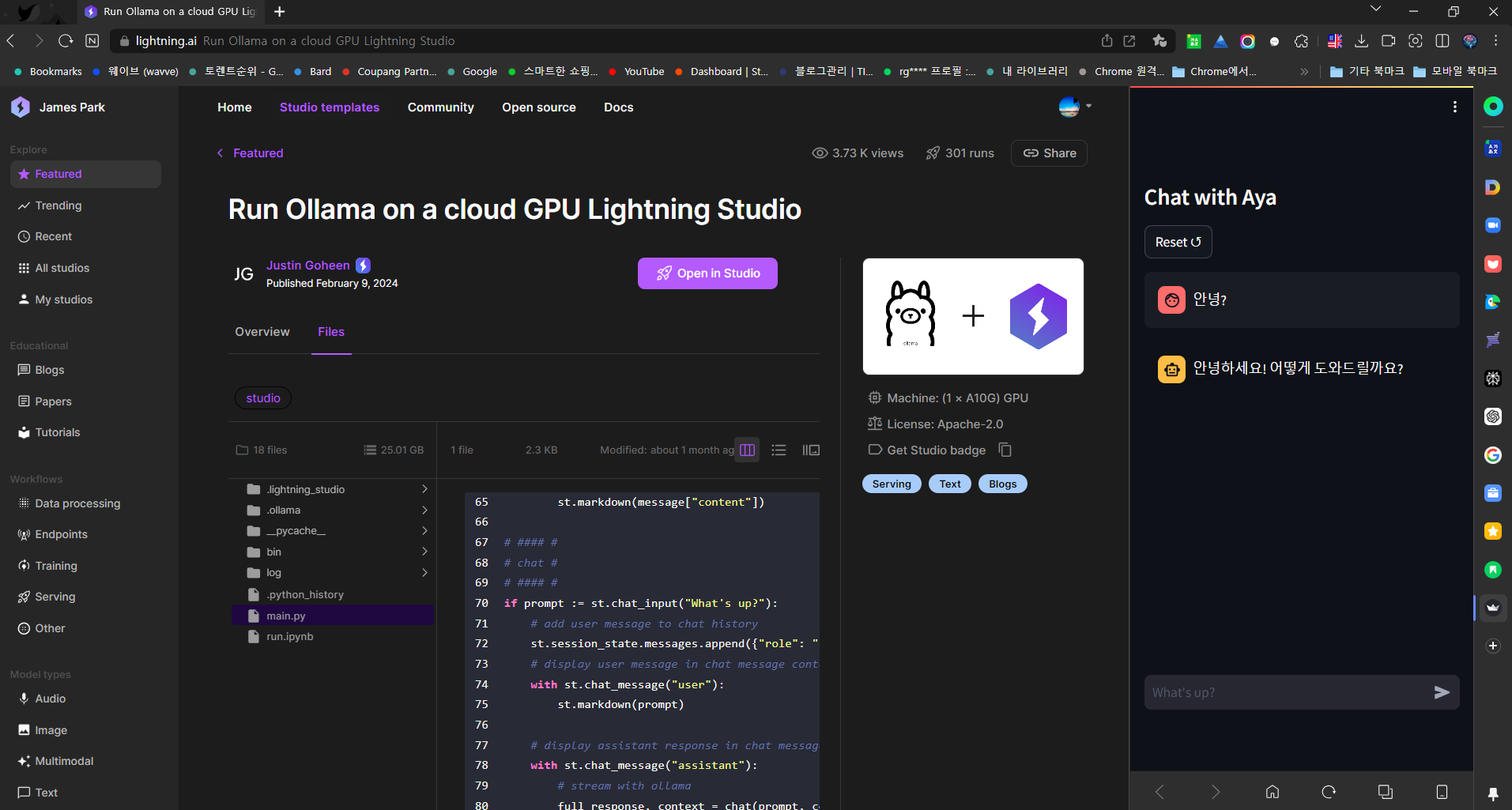

3. Home화면 Studio templates로 이동: 템플릿 중 "Run Ollama on a cloud GPU Lightning Studio"를 클릭합니다.

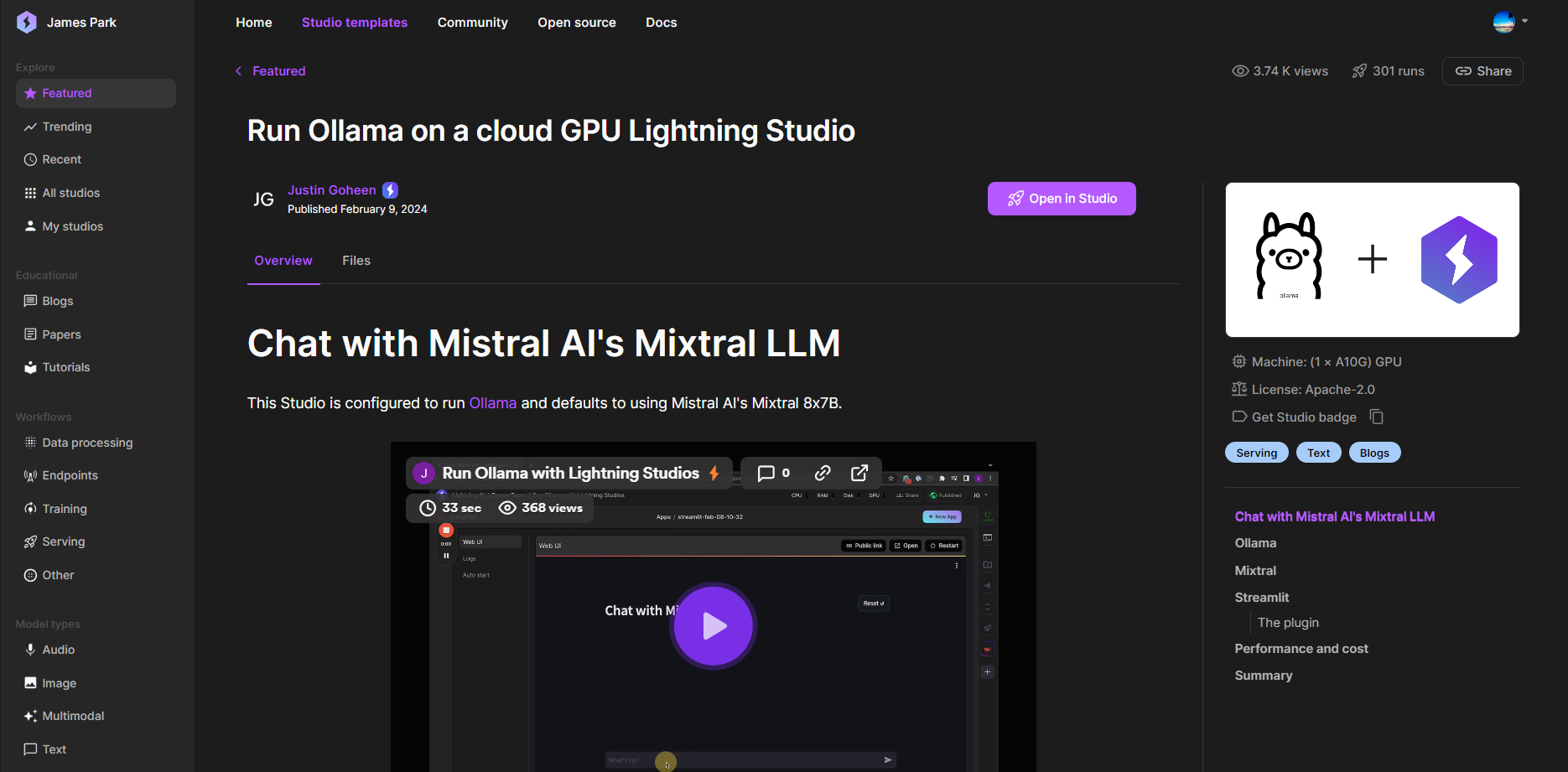

아래 화면과 같이 템플릿 화면으로 이동한 다음, "Open in Studio"를 클릭합니다.

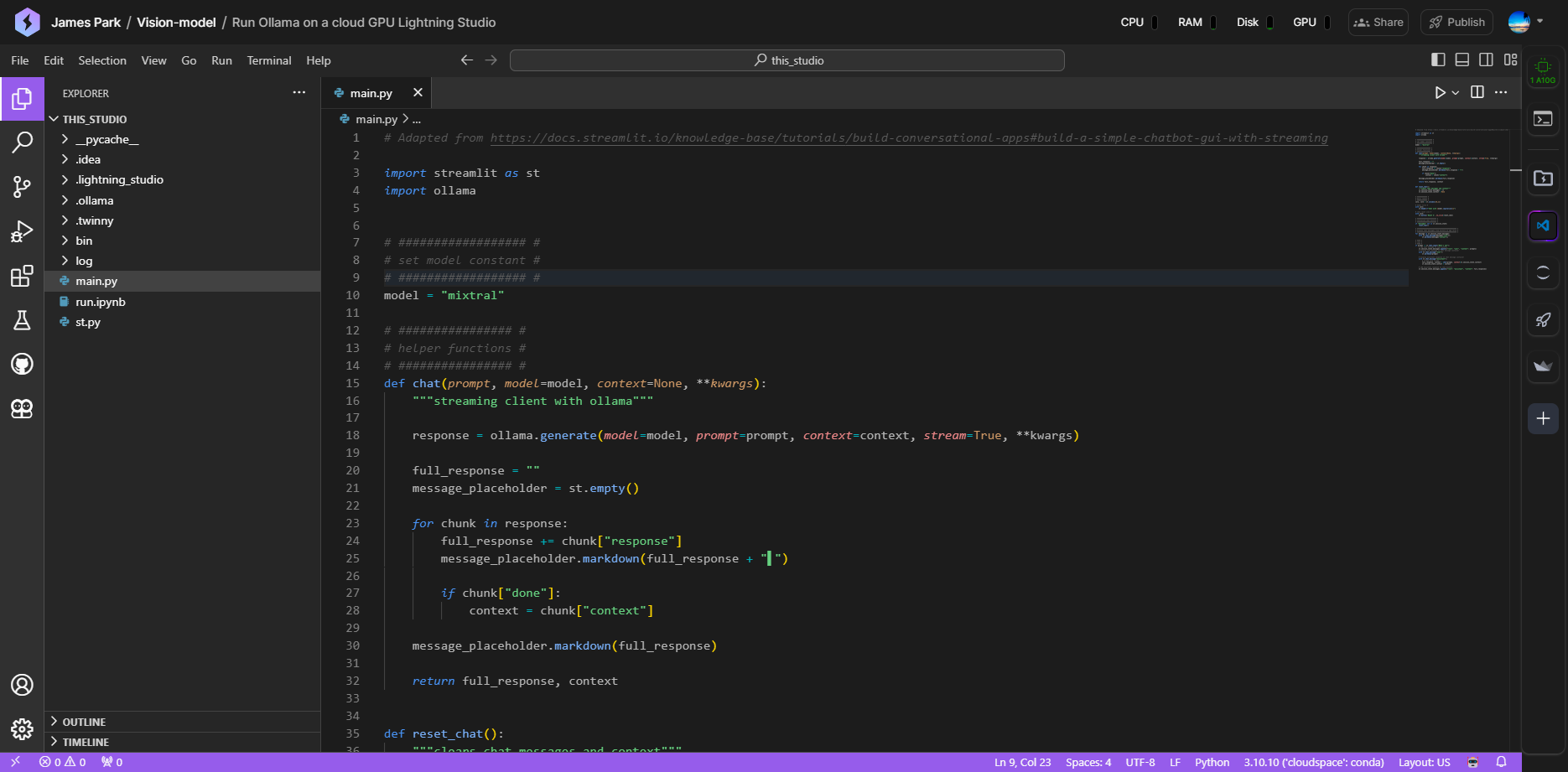

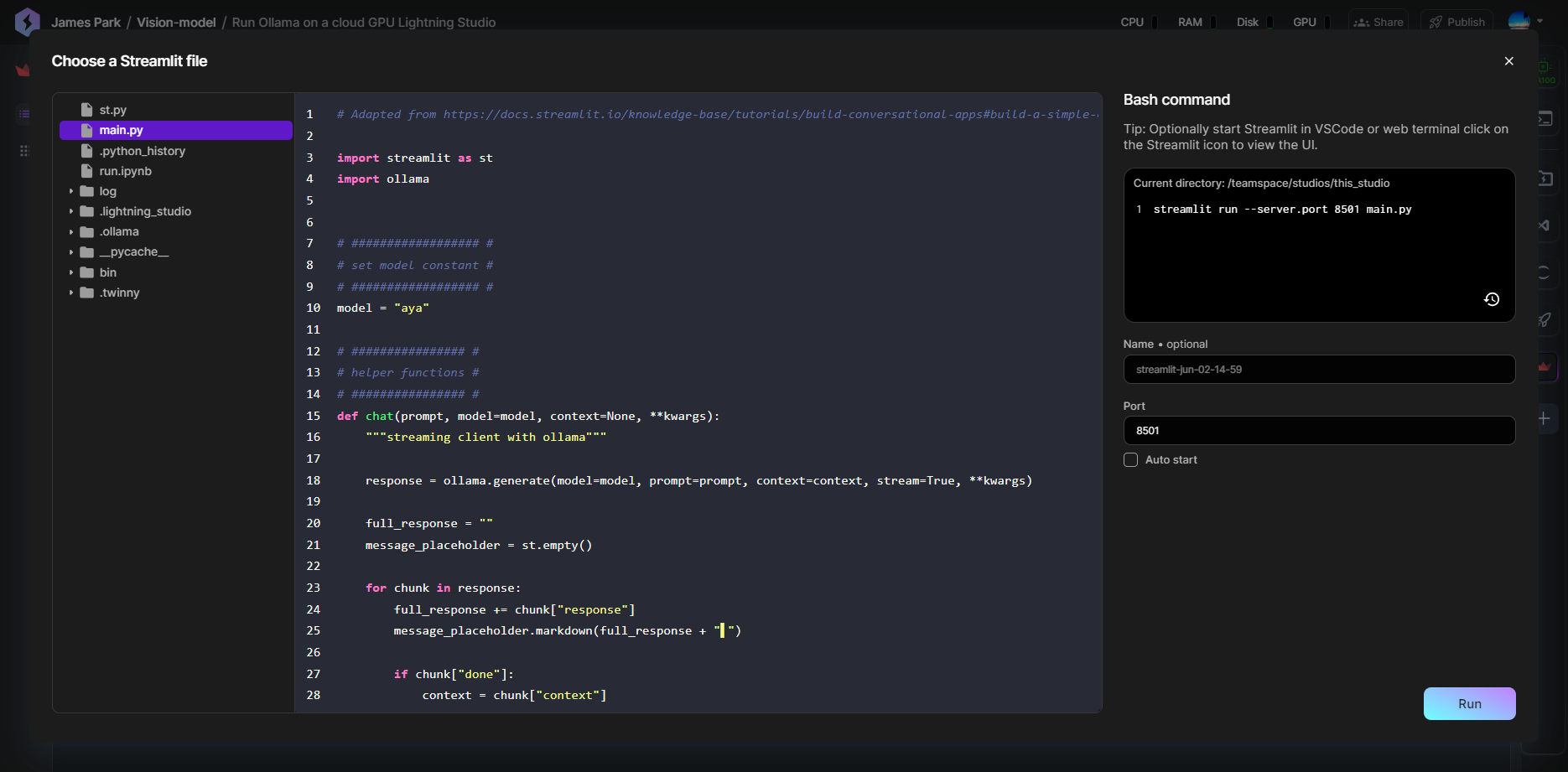

4. 모델명 변경: 좌측 main.py를 선택하고 오른쪽 코드의 "model" 부분의 모델명을 "mixtral"에서 "aya"로 변경합니다.

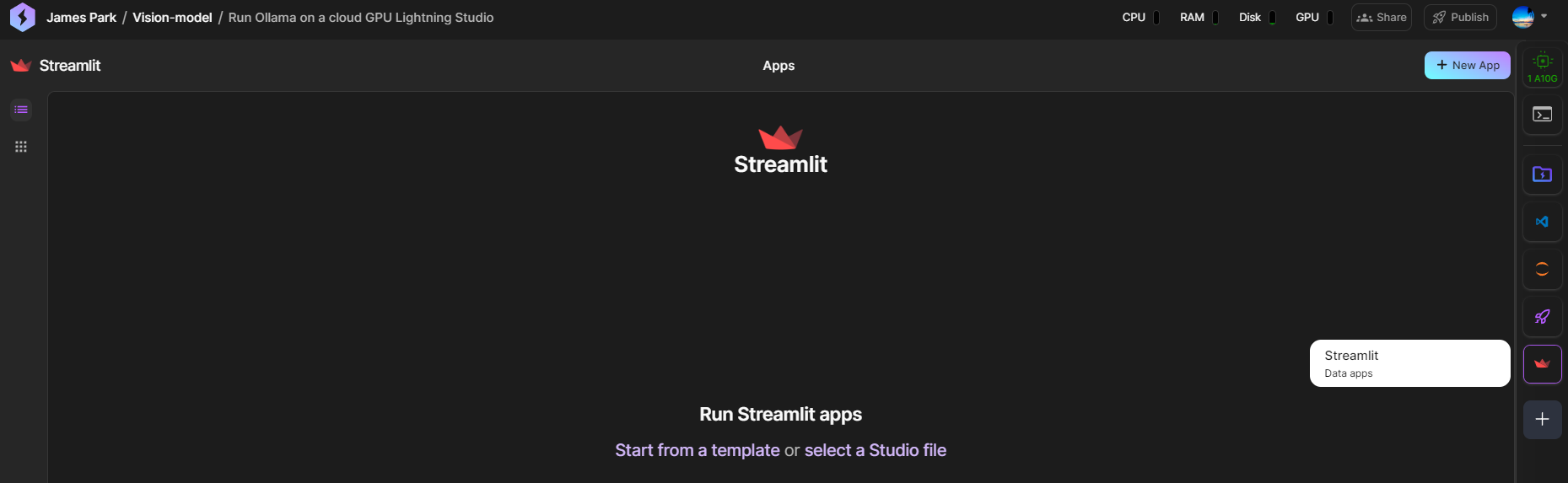

5. Streamlit 플러그인 설치: 변경내용을 저장한 후, 오른쪽 아이콘에서 +를 누르고, Streamlit 플러그인을 설치합니다.

플러그인이 설치완료되면, 우측 메뉴바에 Streamlit 아이콘이 생성됩니다.

6. Streamlit 실행: 아이콘 클릭 후, 화면 가운데 "select Studio file"을 클릭하고, 아까 수정한 main.py를 선택하고 "Run"을 클릭해서 실행합니다.

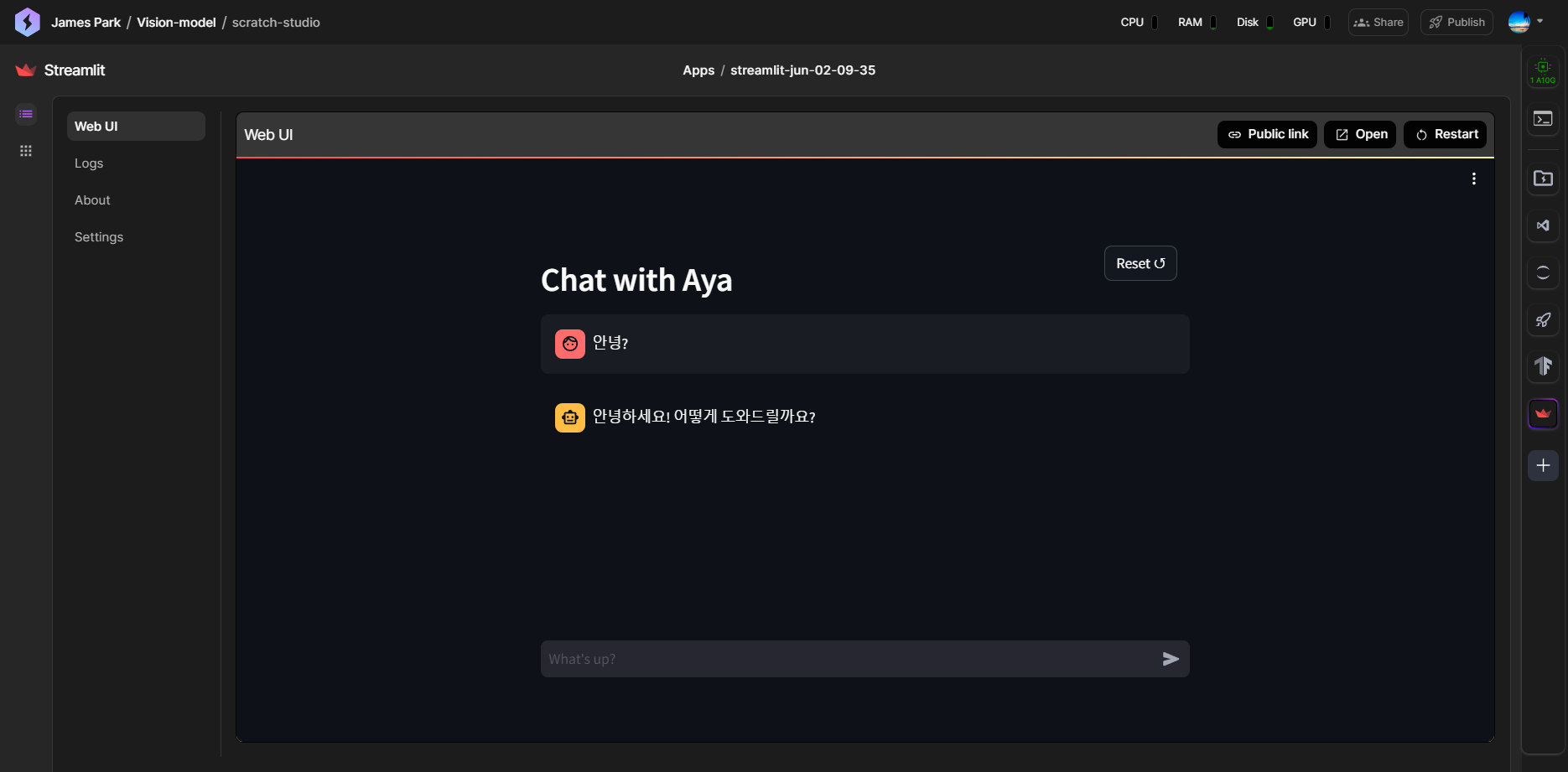

Run을 클릭하면 아래 화면과 같이 애플리케이션이 실행되고, "running" 상태로 보입니다.

애플리케이션을 클릭하면 아래 화면과 같이 웹 UI가 보이며, Aya 23 모델과 한국어로 대화할 수 있습니다.

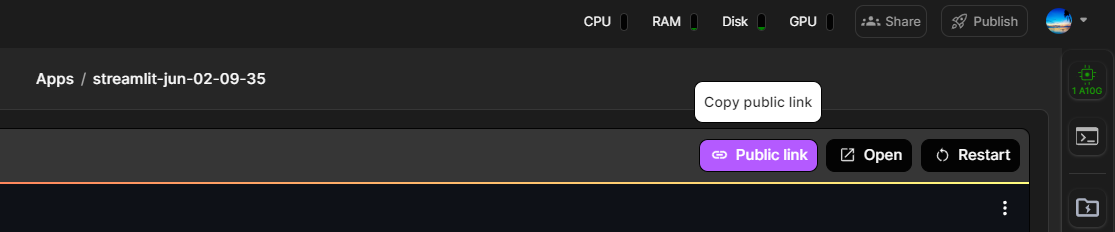

참고로 웹 UI 화면에서 "Public link"를 클릭해서 링크를 복사하고 웨일 브라우저 사이드바 아이콘의 바로가기에 붙여 넣으면, 웹 브라우저에서도 언어 모델과 편리하게 대화할 수 있습니다.

참고로 스튜디오를 종료한 후 다시 시작할 때 Ollama 관련 작업을 자동으로 시작되도록 아래 화면과 같이 "on_start.sh" 파일에 Ollama 최신버전 설치 및 서비스 시작 명령어를 추가하면 편리합니다.

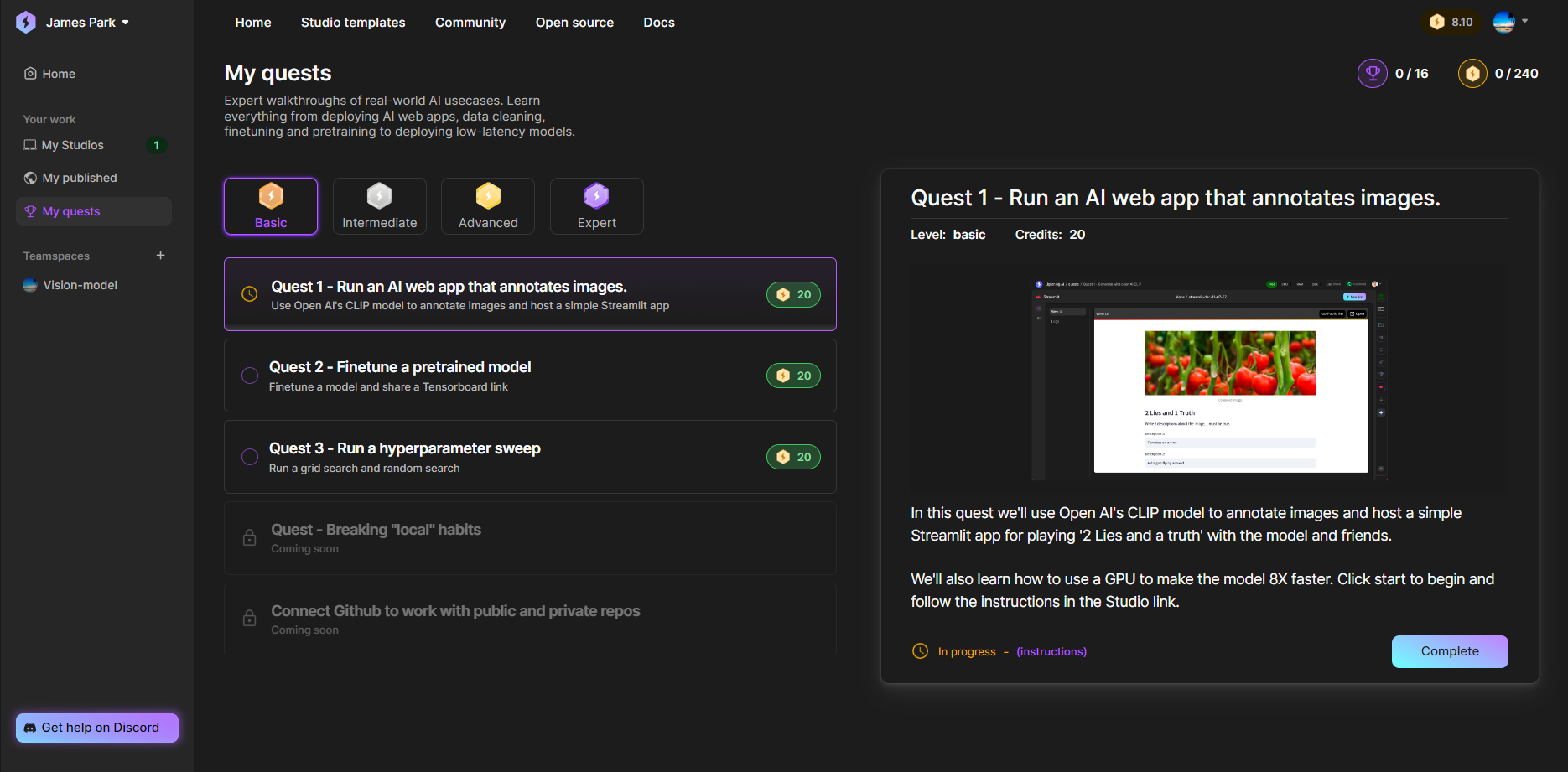

만약, 이용 도중에 크레디트가 부족한 경우, 아래 화면과 같이 퀘스트를 수행하면 크레디트를 충전할 수 있습니다.

맺음말

오늘은 Lightning AI라는 클라우드 컴퓨팅 기반 AI 개발 플랫폼에 대해 소개해드렸습니다. Lightning AI는 복잡한 환경 설정 없이 브라우저에서 바로 사용할 수 있는 편리함과, 고성능 GPU를 무료로 제공하여 AI 개발을 단순화하고 가속화하는 플랫폼입니다. 특히 다중 노드 훈련, 협업 기능, 무한 스토리지 등을 통해 대규모 작업도 효율적으로 처리할 수 있습니다.

Lightning AI를 사용해본 느낌은 다음과 같습니다.

- 수십기가의 대형 언어 모델이 가볍고 빠르게 실행될때 신세계를 경험하게됩니다.

- VSCode를 고성능으로 업그레이드한 느낌입니다.

- 퀘스트 수행하면 AI 애플리케이션 공부에 도움이 됩니다.

오늘 소개한 내용을 바탕으로 여러분도 Lightning AI를 사용하여 AI 개발의 속도와 효율성을 높여보시길 바랍니다. 더 많은 정보와 사용법은 공식 사이트와 가이드를 참조해 주세요. 감사합니다!

2024.05.31 - [AI 언어 모델] - 🌟코딩 혁신: Codestral - 미스트랄이 만든 AI 코드 생성 끝판왕!🚀

🌟코딩 혁신: Codestral - 미스트랄이 만든 AI 코드 생성 끝판왕!🚀

안녕하세요! 오늘은 미스트랄의 새로운 코드 생성 언어 모델 Codestral에 대해서 알아보겠습니다. Codestral은 Python, Java, C, C++, JavaScript, Bash를 포함한 80개 이상의 프로그래밍 언어로 학습되었으며, Sw

fornewchallenge.tistory.com

'AI 도구' 카테고리의 다른 글

| OpenRecall: 디지털 메모리를 기록하고, 검색하는 오픈소스 솔루션 (0) | 2024.06.09 |

|---|---|

| NVIDIA 최신 소프트웨어 기술 NIM: AI 애플리케이션 간편하게 구축하기 (2) | 2024.06.06 |

| 🌐✨Page Assist: Ollama 기반 웹 브라우저 AI Co-pilot 설치 및 사용법 (0) | 2024.05.30 |

| LobeChat: AI 기반 대화 서비스 플랫폼 설치 및 활용 가이드 (1) | 2024.05.28 |

| 💻구글 Firebase Genkit: Ollama와 연동되는 쉽고 빠른 AI앱 개발 환경 (0) | 2024.05.25 |