목차

안녕하세요. 오늘은 애플이 2023년 10월에 발표한 "FERRET: REFER AND GROUND ANYTHING ANYWHERE AT ANY GRANULARITY"라는 논문에 대해 자세히 알아보겠습니다. 이 논문은 이미지 내에서 어떤 대상이든 어디서든 참조하고 위치를 지정하는 데 있어 매우 뛰어난 능력을 갖춘 Ferret 모델에 대한 것입니다. 이 블로그에서는 Ferret의 구조, 동작원리, 특징, 성능평가 등에 대해서 확인하실 수 있습니다.

논문개요 및 목적

- 논문 제목: FERRET: REFER AND GROUND ANYTHING ANYWHERE AT ANY GRANULARITY

- 논문 저자: Apple AI/ML

- 논문 게재 사이트: https://arxiv.org/abs/2310.07704v1

- 논문 게재일: 2023년 10월

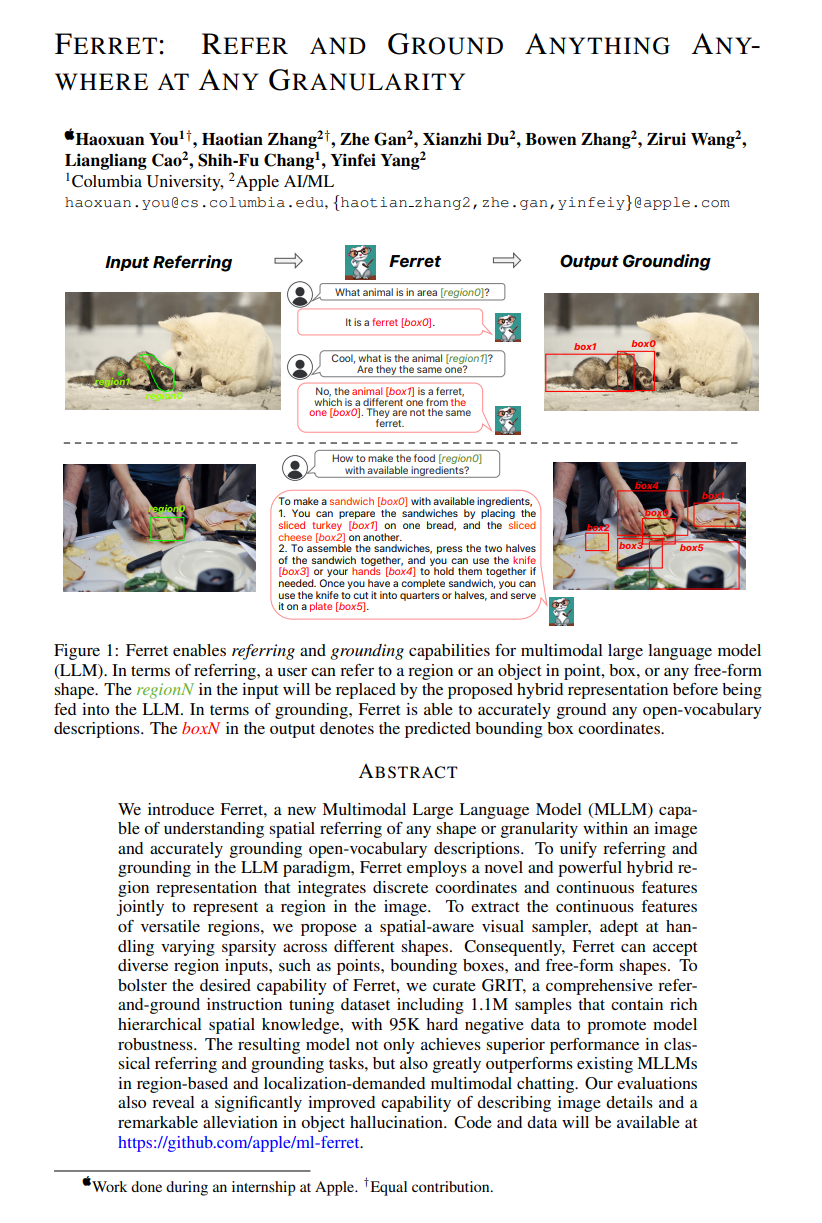

Ferret는 Apple AI/ML에서 개발한 최신의 멀티모달 대규모 언어 모델입니다. 이 모델은 이미지 내에서 어떤 대상이든 어디서든 참조하고 지목할 수 있는 능력을 가지고 있습니다. "Ferret(탐색자)"이라는 이름은 이 모델이 데이터의 다양한 부분에 민감하게 참조하고, 원하는 위치에 지속적으로 지목할 수 있는 능력을 나타냅니다.

이 논문의 주요 목적은 Ferret이라는 모델을 소개하고, 이미지 내에서 텍스트로 참조한 대상을 정확하게 지정하는 능력을 제시하는데 중점을 두고 있습니다. Ferret은 자연어 처리 및 컴퓨터 비전의 융합적인 기술로써, 다양한 환경에서 어떠한 대상이든 정확하게 지목하고 참조하는 것을 목표로 합니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

논문의 연구내용 및 결과

Ferret은 여러 작업에서 강력한 성능을 보이는 다목적의 대형 언어 모델입니다. 이 모델은 참조(Referring) 및 위치 파악(Grounding) 작업에서 특히 뛰어난 능력을 발휘합니다. "Referring"은 "참조"(지시, 지칭)이라는 뜻으로, 모델이 다양한 방식으로 묘사된 지역이나 물체를 가리킬 수 있는 능력을 나타냅니다. "Grounding"은 "근거화 하다"(구체화하다)라는 뜻으로, 모델이 텍스트에서 언급된 내용을 기반으로 정확한 시각적 위치를 파악할 수 있는 능력을 나타냅니다.

Ferret의 주요 특징

- 자유도형 형태로 참조(Referring in Any Free-Form Shape): Ferret은 참조하는 표현을 자유로운 형태로 나타낼 수 있습니다. 즉, 포인트, 상자, 자유 형태의 도형(스케치, 폴리곤 등) 등을 사용하여 이미지 내의 특정 영역을 가리킬 수 있습니다.

- 텍스트의 위치파악(Grounding for Text): 모델은 텍스트 내에서 지시 가능한 부분에 대한 Grounding을 자동으로 수행합니다. Grounding은 모델이 텍스트에서 지시하는 부분이 실제 이미지에서 어디에 해당하는지를 이해하고 표현하는 것을 의미합니다.

- 혼합 영역 표현(Hybrid Region Representation): Ferret은 이미지 내의 특정 지역을 나타내기 위한 불연속적인 이산 좌표와 연속적인 시각적 특징을 효과적으로 결합하는 혼합된 영역 표현을 사용합니다. 이는 지시된 지역의 모양에 관계없이 유연하게 대응할 수 있도록 합니다.

- 공간 인식 시각 샘플러(Spatial-Aware Visual Sampler): Ferret 모델의 핵심 부분으로, 이미지 내 지시된 영역의 시각적 특징을 효과적으로 추출하는 메커니즘입니다. 입력으로 이미지 특성 맵과 이진 형태의 영역 표시정보를 받아 샘플링하고, 샘플링된 포인트의 특징을 결합하여 최종적인 시각적 특징을 얻어 텍스트와 함께 활용됩니다.

- 멀티모달 대규모 언어모델(Multimodal Large Language Model): Ferret은 MLLM으로서 언어, 이미지, 및 지역 특징을 결합하여 다양한 작업을 수행합니다. 이 모델은 Vicuna와 같은 강력한 언어 모델을 기반으로 하며, 지시된 지역에 대한 언어적 표현과 시각적 특징을 조합하여 종합적으로 이해합니다.

Ferret은 이러한 특징을 결합하여 자연어 처리와 컴퓨터 비전 작업 간의 강력한 상호작용을 통해 참조(Referring) 및 위치파악(Grounding) 작업에서 뛰어난 성과를 거두고 있습니다.

Ferret 모델의 훈련 데이터셋

Ferret 모델의 훈련을 위해 GRIT(Ground-and-Refer Instruction-Tuning) 데이터셋과 Ferret-Bench 데이터셋이 사용됐습니다. GRIT 데이터셋은 지시를 따르는 형식으로 구성된 데이터와 GPT-4 및 ChatGPT를 활용한 생성 데이터, 모델의 강인성 강화를 위한 부정 데이터로 구성되었습니다.

GRIT 데이터셋은 Ferret 모델을 훈련시키기 위한 지시어 튜닝 데이터셋입니다. 이 데이터셋은 모델이 이미지 지역을 참조하고 묘사할 수 있도록 다양한 형태의 데이터를 제공합니다. 데이터 유형은 다음과 같습니다.

- 공공 데이터셋: 이 부분은 기존의 공개 데이터셋을 활용하여 Ferret 모델을 훈련시키는 데 사용됩니다. 이 데이터는 명시적인 지침에 따라 이미지와 지역을 참조하는 형태로 변환됩니다.

- ChatGPT, GPT-4 생성 데이터셋: ChatGPT 및 GPT-4를 사용하여 생성된 데이터가 포함되어 있습니다. 이 데이터는 모델이 지시어를 사용하여 지역을 참조하고 이에 대한 응답을 생성하는 데 사용됩니다.

- 부정 데이터셋: 모델의 강인성을 향상시키기 위한 부정적인 데이터가 추가되어 있습니다. 모델이 거짓 정보에 얼마나 강인한지를 훈련시키는 데 사용됩니다.

데이터 예시: 데이터는 지침에 따라 이미지 및 지역을 참조하는 형태로 구성됩니다.

GRIT 데이터셋은 Ferret 모델이 이미지에 대한 참조와 설명을 수행하는 데 필요한 훈련 데이터를 제공합니다. 이를 통해 모델은 지역에 대한 명확한 언어적 표현을 학습하고, 참조 지시문에 따라 지역을 정확하게 튜닝할 수 있게 됩니다.

Ferret 모델의 아키텍처

Ferret 모델의 아키텍처는 크게 세 가지 주요 구성 요소로 이루어져 있습니다. 이 구성 요소들은 이미지 인코더, 공간 인식 시각 샘플러, 그리고 대규모 언어모델 (Large Language Model)로 구성되어 있습니다.

- 이미지 인코더 (Image Encoder): 이미지 인코더는 이미지를 나타내는 원래의 픽셀 값이나 특징들을 저차원의 숫자로 된 벡터로 변환하는 역할(임베딩)을 합니다. 이 과정에서 CLIP-ViT-L/14라는 미리 훈련된 비주얼 인코더를 사용하며, 결과적으로 이미지 임베딩인 Z ∈ R^(H×W×C)를 얻습니다. Z ∈ R^(H×W×C)는 이미지를 숫자로 표현한 것으로, H는 이미지의 높이, W는 이미지의 너비, C는 이미지의 컬러 채널을 나타냅니다

- 혼합 영역 표현(Hybrid Region Representation): Ferret은 이미지 내의 특정 지역을 나타내기 위한 불연속적인 이산 좌표와 연속적인 시각적 특징을 효과적으로 결합하는 혼합된 영역 표현을 사용합니다. 이는 지시된 지역의 모양에 관계없이 유연하게 대응할 수 있도록 합니다.

- 공간 인식 비주얼 샘플러 (Spatial-aware Visual Sampler): 이 부분은 주어진 이미지의 지역적인 특징을 추출하기 위한 새로운 방법입니다. 해당 지역의 모양은 점이나 직사각형 상자로 제한되지 않으며, 기존의 그리드 기반 처리 방법이 이러한 비정형 모양을 처리하는 데 어려운 경우 적용됩니다. 입력으로 이미지 특성 맵과 이진 형태의 영역 표시정보를 받아 샘플링하고, 샘플링된 포인트의 특징을 결합하여 최종적인 시각적 특징을 얻어 텍스트와 함께 활용됩니다.

- 대규모 언어모델 (Large Language Model): LLM은 Vicuna라는 특정한 LLM이 사용되며, 이 모델은 다양한 응용 분야에서 활용되는 범용적인 언어 모델인 LLaMA(Language Model for Many Applications) 위에 작업에 특화된 지시에 따라 동작하는 디코더만을 가지고 있는 모델입니다. 이미지 임베딩은 LLM으로 전달되기 전에 추가적인 선형 레이어를 통해 텍스트 토큰의 임베딩 차원에 맞게 변환됩니다.

이러한 구성으로 Ferret 모델은 이미지, 텍스트, 지역 특징을 공동으로 모델링하고, 이를 통해 모델은 텍스트 입력에 따라 이미지 내 어떤 것이 어디에 있는지에 대한 이해력을 가지게 됩니다. Ferret모델은 이미지에서 참조된 지역 또는 물체를 정확하게 식별하고 해당 지역의 위치를 예측하거나 추론할 수 있습니다.

Ferret 모델에 대한 실험과 성능평가

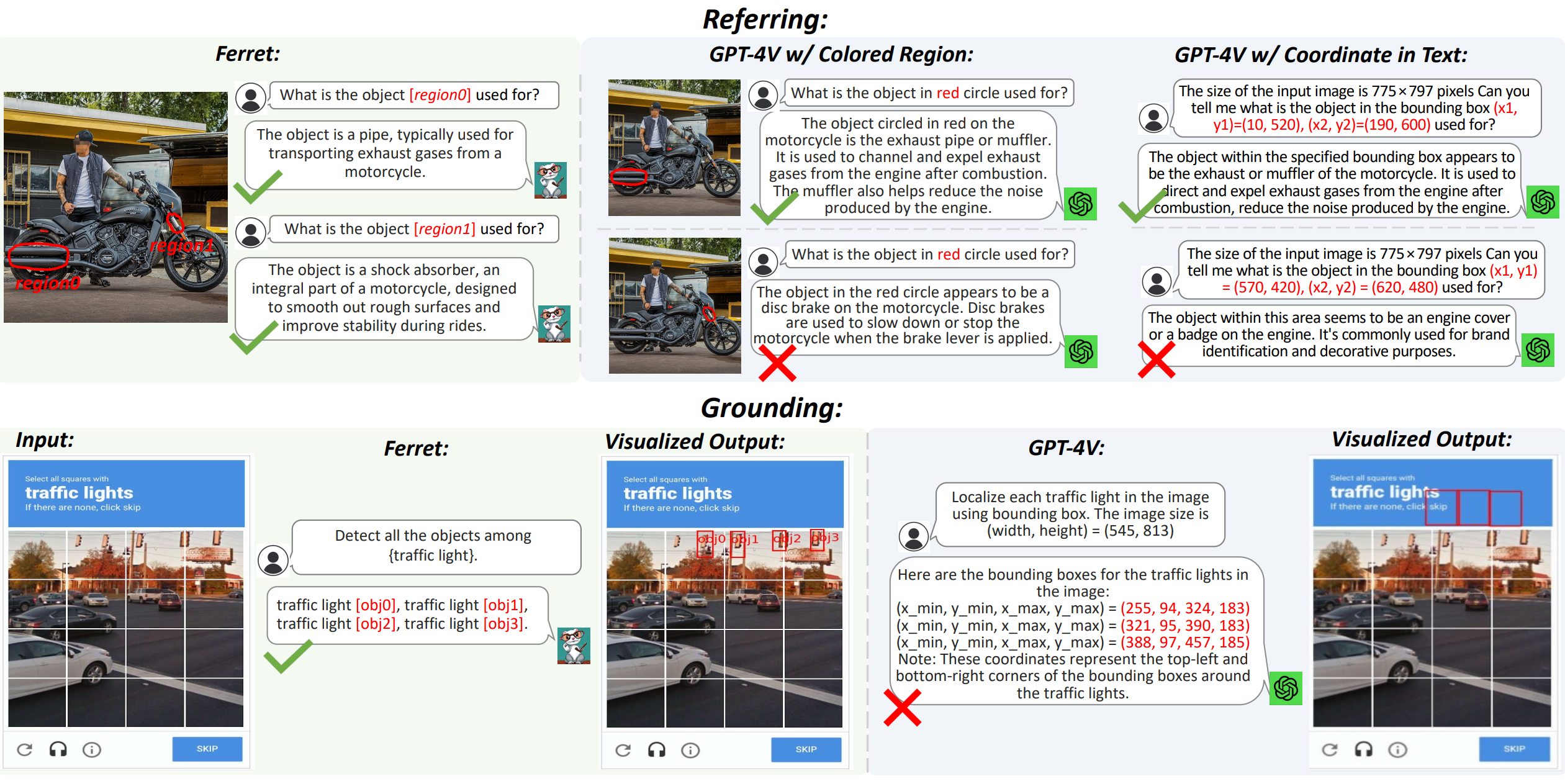

- 교통 신호등 탐지(Traffic Light Detection): Ferret 모델이 교통 신호등을 탐지하는 능력을 평가했습니다. 여러 지표를 사용하여 성능을 측정하였고, Ferret의 우수성을 확인했습니다. Ferret은 혼잡한 장면에서도 신호등을 정확하게 식별하는 데 능숙합니다. Ferret의 성능은 GPT-4V를 능가하며 복잡한 시각적 장면에서 모델의 강력함을 나타냅니다.

- 객체 환상 벤치마크(Object Hallucination Benchmark): 객체 환상 벤치마크를 사용하여 Ferret와 다른 모델 간의 성능을 비교하였습니다. 여러 메트릭을 활용하여 정확도, 정밀도, 재현율 등을 평가하였습니다.

- 참조 작업(Referring) : GPT-4V는 일부 능숙함을 나타내지만 특히 상대적으로 작은 지역을 포함하는 경우에 한계가 있었습니다. Ferret과 비교했을 때 GPT-4V는 특히 작은 영역에 정확하게 이해하는 데 제약이 있습니다.

- 위치파악 작업(Grounding) : GPT-4V는 색상 지역이나 텍스트 좌표를 사용하여 일정 수준의 위치확인 능력을 보여줍니다. 특히 작은 지역을 다룰 때 GPT-4V는 정확한 이해에서 어려움을 겪습니다. 정확한 이해에서 Ferret은 GPT-4V를 능가하며 특히 복잡한 시각적 장면에서 도전적인 시나리오에서 강력함을 나타냅니다.

Ferret은 다양한 시나리오에서 높은 성능을 보였습니다. 특히, 교통 신호등 탐지와 객체 환상 벤치마크에서 다른 모델들을 앞서며, 참조 및 위치파악 작업에서도 뛰어난 성과를 보여주었습니다. 실험 결과를 통해 Ferret이 어떠한 시각적 작업에서도 뛰어난 참조와 위치파악 능력을 갖추고 있음을 확인하였으며, 다양한 응용 분야에서의 효과적인 활용 가능성을 제시하였습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

논문의 결론 및 전망

이 논문에서 Ferret은 참조 및 위치파악 작업에 있어서 뛰어난 능력을 갖춘 새로운 멀티모달 대규모 언어 모델로 소개됩니다. 논문은 모델 훈련을 위해 GRIT 데이터셋을 정리하였으며, 성능 평가를 위해 Ferret-Bench 데이터셋을 소개하였습니다. 그러나 모든 대규모 언어모델과 마찬가지로 Ferret도 해롭거나 예상치 못한 방식으로 응답을 생성할 수 있다는 점을 인정하고 있습니다.

향후 연구에서는 Ferret을 보다 발전시켜 직사각형 형태의 박스뿐만 아니라 세분화된 픽셀 수준의 세그멘테이션 마스크도 출력할 수 있도록 할 계획이며, 이러한 발전은 더욱 정교한 작업 및 응용 분야에서 활용 범위를 확장할 것으로 기대됩니다.

오늘은 조금 언론에 뒤늦게 소개된 애플의 멀티모달 대규모 언어 모델, Ferret에 대해 소개해 드렸습니다. 그럼 저는 다음에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2023.12.23 - [AI 논문 분석] - VideoPoet: 구글의 제로샷(Zero-Shot) 비디오 생성 대규모 언어 모델

VideoPoet: 구글의 제로샷(Zero-Shot) 비디오 생성 대규모 언어 모델

안녕하세요. 오늘은 구글이 개발한 대규모 언어모델 VideoPoet에 대한 논문을 살펴보겠습니다. VideoPoet은 구글 리서치에서 개발한 대규모 언어 모델로, 텍스트 입력을 통해 제로샷(Zero-Shot) 비디오

fornewchallenge.tistory.com

'AI 논문 분석' 카테고리의 다른 글

| Mixtral-8x7B, MoE 언어 모델의 고속 추론 혁신 기술 (2) | 2024.01.04 |

|---|---|

| SOLAR 10.7B: 대규모 언어 모델의 효과적인 깊이 업스케일링 (2) | 2023.12.31 |

| VideoPoet: 구글의 제로샷(Zero-Shot) 비디오 생성 대규모 언어 모델 (2) | 2023.12.23 |

| [AI 논문 리뷰] 대규모 언어 모델을 위한 애플의 메모리 최적화 기술 (0) | 2023.12.22 |

| AI 논문 분석: 대규모 언어 모델을 활용한 프로그램 탐색, FunSearch (0) | 2023.12.19 |