목차

안녕하세요! 오늘은 Ollama를 언제 어디서나 이용할 수 있는 Ollama 모바일 앱에 대해 알아보겠습니다. Ollama는 강력한 AI 모델을 호스팅 하고 관리할 수 있는 도구로, 이제 Ollama 앱을 통해 모바일에서도 손쉽게 AI 모델과 대화할 수 있습니다. 이 블로그에서는 Windows 환경에서 Ollama 서비스를 설정하고, 외부 네트워크에서 Ollama 모바일 앱을 통해 접속하는 방법을 단계별로 설명드리겠습니다. 설정이 완료되면, http://x.x.x.x:11434와 같은 공용 IP의 API 엔드포인트에 접속해서 AI 모델과 어디서나 스마트폰으로 소통할 수 있게 됩니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

Ollama 모바일 앱 개요

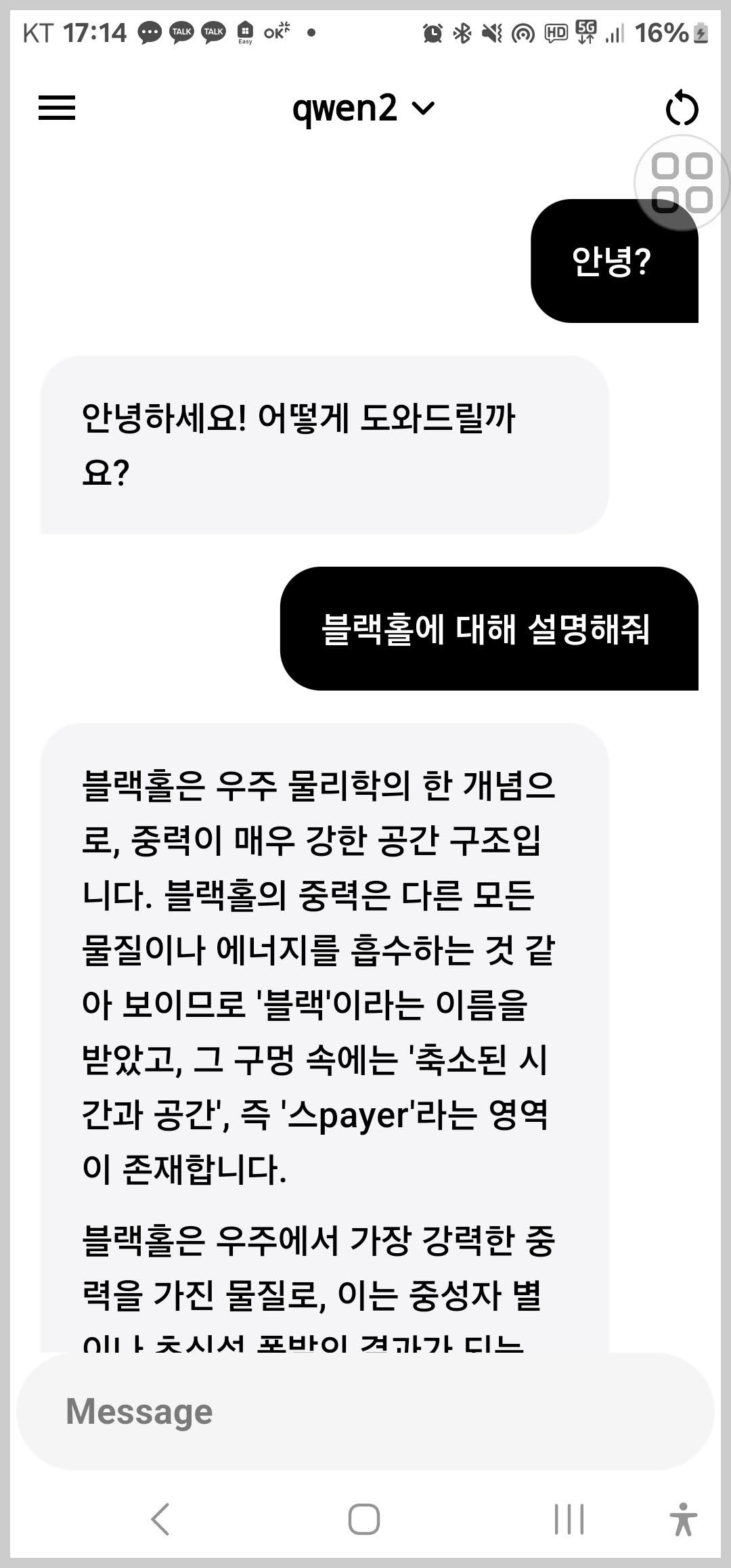

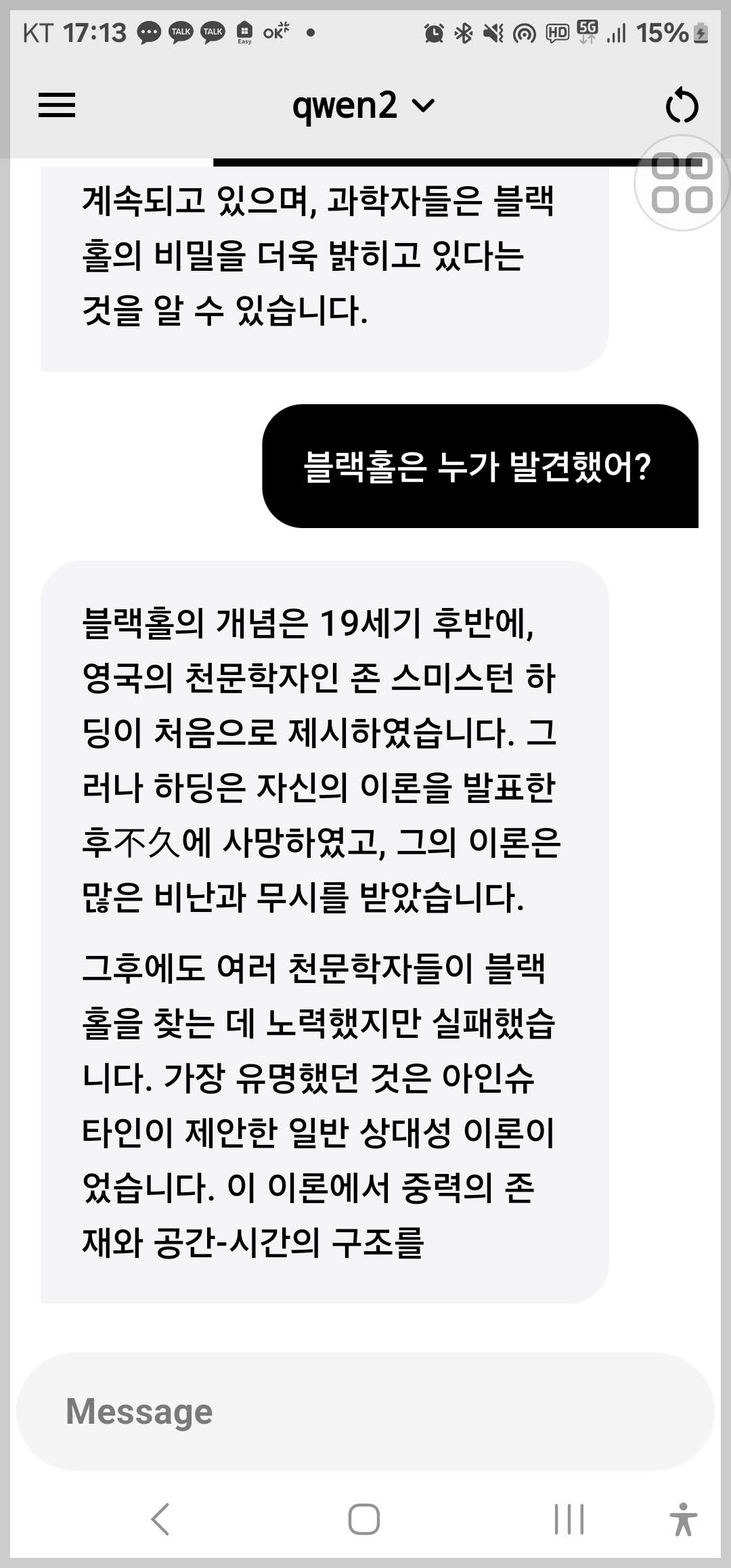

Ollama 앱은 Ollama 서버와 통신하여 AI 모델을 사용하는 모바일 클라이언트 응용 프로그램입니다. 이 앱은 AI 모델과 상호작용할 수 있는 현대적이고 사용하기 쉬운 인터페이스를 제공하며, 사용자 데이터가 로컬 네트워크 내에서 비공개로 유지되도록 설계되었습니다. 이 앱 자체는 서버를 호스팅 하지 않고, 설정된 Ollama 서버에 연결하여 그 API 엔드포인트를 사용합니다.

Ollama 앱은 모바일 기기에서 Ollama 서버에 연결하여, 외부에서도 AI 모델과의 대화를 쉽게 할 수 있도록 돕습니다. 이는 특히 AI 모델을 이용한 데이터 분석, 실시간 상담, 교육 목적으로 유용하며, 주요 특징은 다음과 같습니다.

- 현대적이고 사용하기 쉬운 클라이언트: Ollama 앱은 직관적인 사용자 인터페이스를 통해 사용자들이 쉽게 AI 모델과 상호작용할 수 있도록 돕습니다.

- 로컬 네트워크에서의 데이터 보안: 사용자 데이터가 로컬 네트워크 내에서 비공개로 유지되며, 외부 인터넷 서버로 전송되지 않습니다.

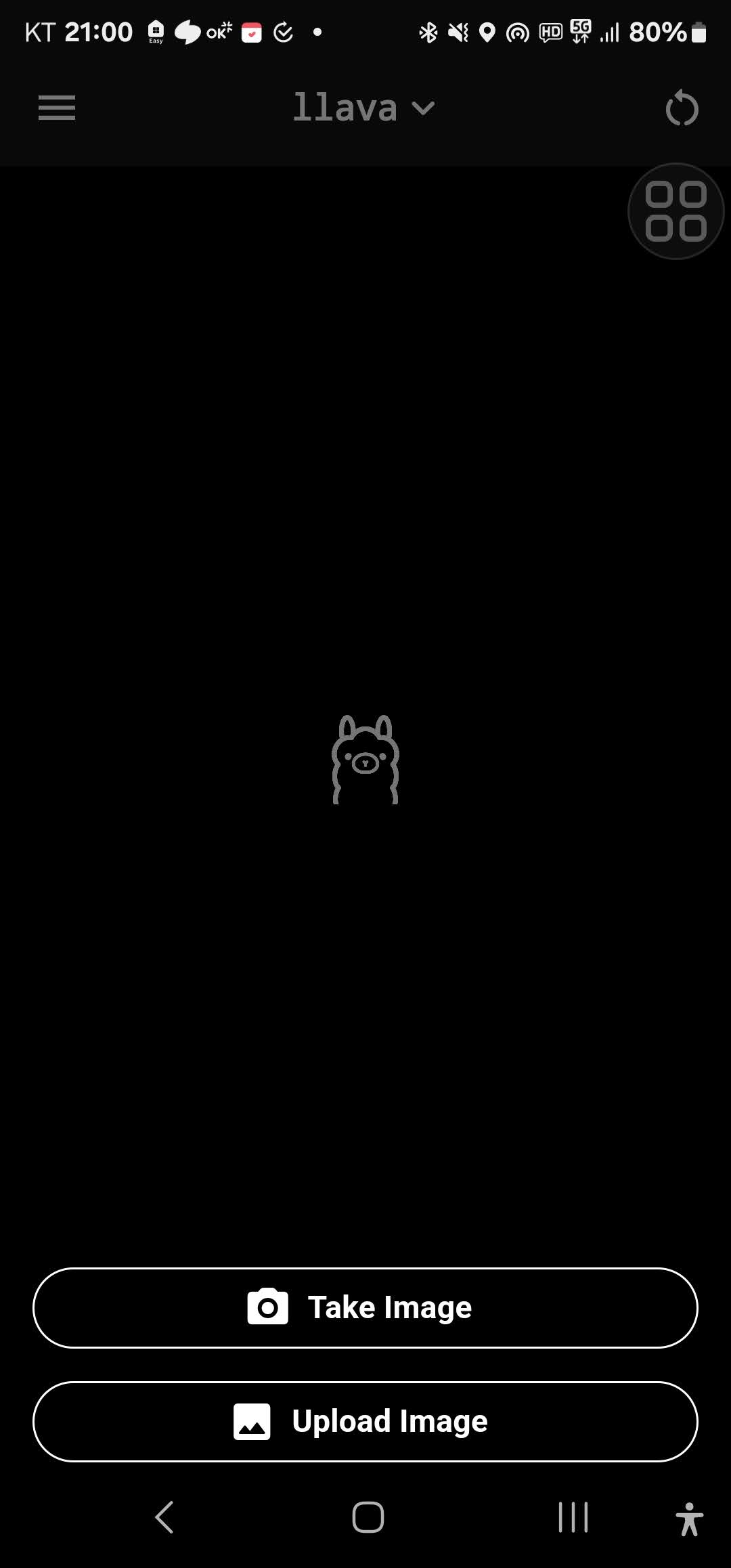

- 다양한 모델 지원: 여러 AI 모델을 지원하며, 사용자가 다양한 입력 방식(텍스트, 이미지 등)을 통해 모델과 상호작용할 수 있습니다.

Ollama 앱 설정방법

Ollama 모바일 앱을 설치하는 방법은 서버 설정부분과 클라이언트 앱 설정 부분으로 나눌 수 있습니다. 이 블로그에서 진행하는 구성은 스마트폰으로 테더링 한 노트북이 Ollama 서버로 동작하고, 다른 스마트폰에서 Ollama 앱을 열어 AI 모델과 실시간으로 대화할 수 있도록 환경을 구성하는 방법입니다. 노트북은 Windows 11 Pro(23H2), CPU i9-13900H/2.60 GHz/16GB, GPU RTX 4060입니다.

서버 설정

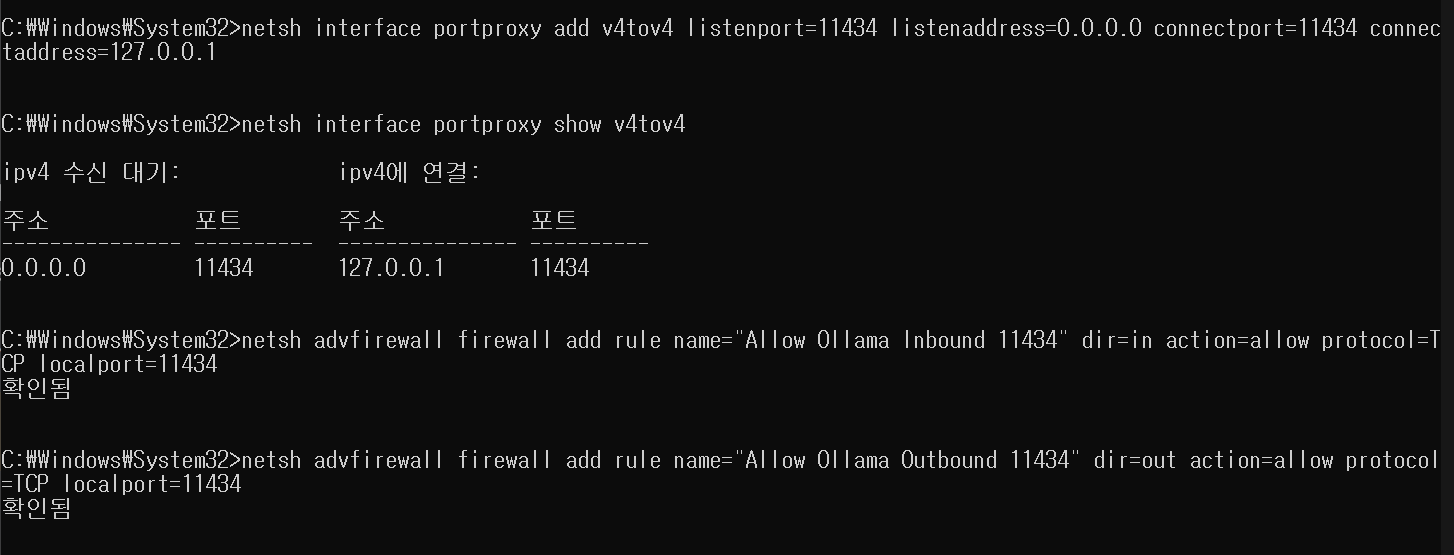

1. 포트 프록시 설정: 노트북에서 포트 프록시를 설정하여 모든 네트워크 인터페이스에서 127.0.0.1:11434로의 접근을 가능하도록 구성합니다. 명령프롬프트에서 관리자 권한으로 아래 명령어를 입력하여 포트 프록시를 추가합니다.

netsh interface portproxy add v4tov4 listenport=11434 listenaddress=0.0.0.0 connectport=11434 connectaddress=127.0.0.1

2. 포트 프록시 설정 확인: 포트 프록시가 올바르게 설정되었는지 아래 명령어를 입력하여 확인합니다.

netsh interface portproxy show v4tov4

3. Windows 방화벽 설정: 방화벽이 트래픽을 차단하지 않도록 설정합니다.

- 인바운드 규칙 설정: 포트 11434에 대한 새 규칙을 추가하여 인바운드 TCP 트래픽을 허용합니다.

netsh advfirewall firewall add rule name="Allow Ollama Inbound 11434" dir=in action=allow protocol=TCP localport=11434

- 아웃바운드 규칙 설정: 동일한 방법으로 포트 11434의 아웃바운드 트래픽도 허용합니다.

netsh advfirewall firewall add rule name="Allow Ollama Outbound 11434" dir=out action=allow protocol=TCP localport=11434

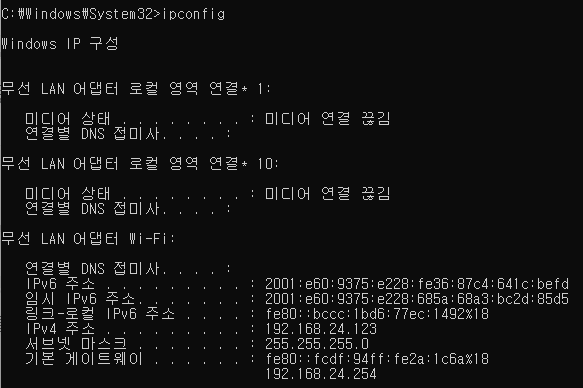

4. IP 주소 확인: ipconfig 명령어를 이용하여 노트북의 IP주소를 확인합니다. 집에서 공유기에 접속된 경우 포트 포워딩 설정이 추가로 필요합니다. 이 블로그에서는 스마트폰 테더링 상황에서의 설정입니다.

클라이언트 앱 설정

1. 최신 버전 다운로드: Ollama 앱의 최신 버전은 공식 GitHub 페이지에서 다운로드할 수 있습니다. APK 파일을 다운로드하여 Android 기기에 설치합니다.

https://github.com/JHubi1/ollama-app/releases

Releases · JHubi1/ollama-app

A modern and easy-to-use client for Ollama. Contribute to JHubi1/ollama-app development by creating an account on GitHub.

github.com

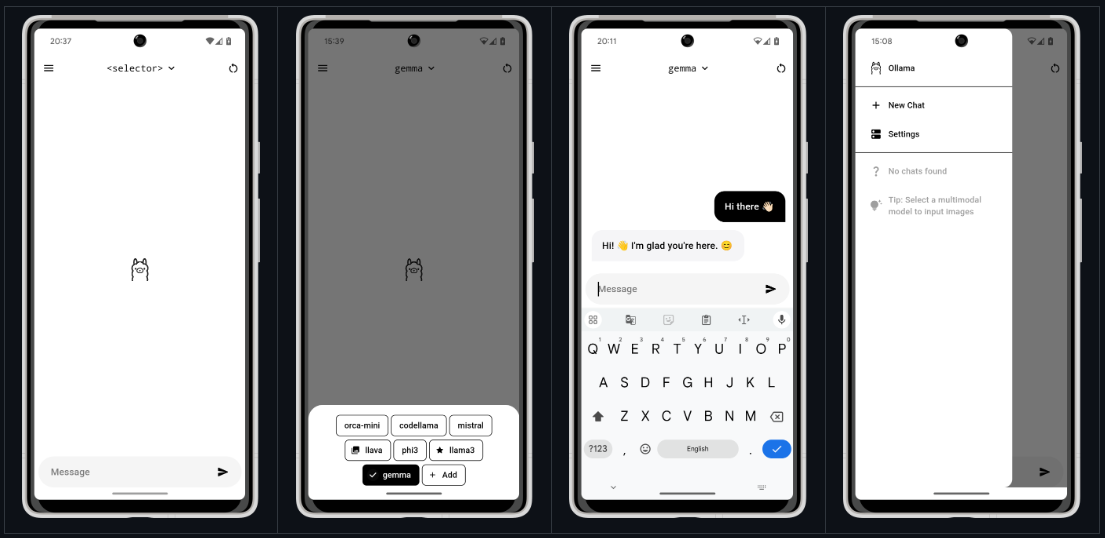

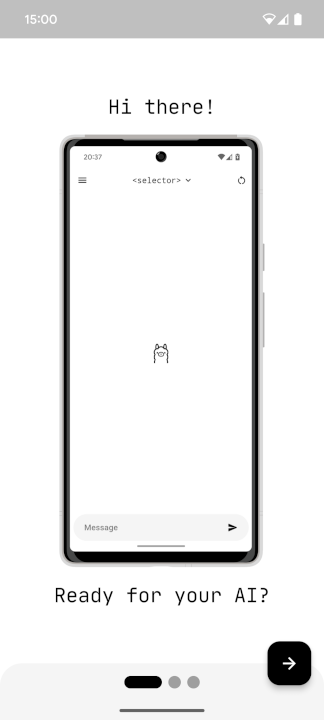

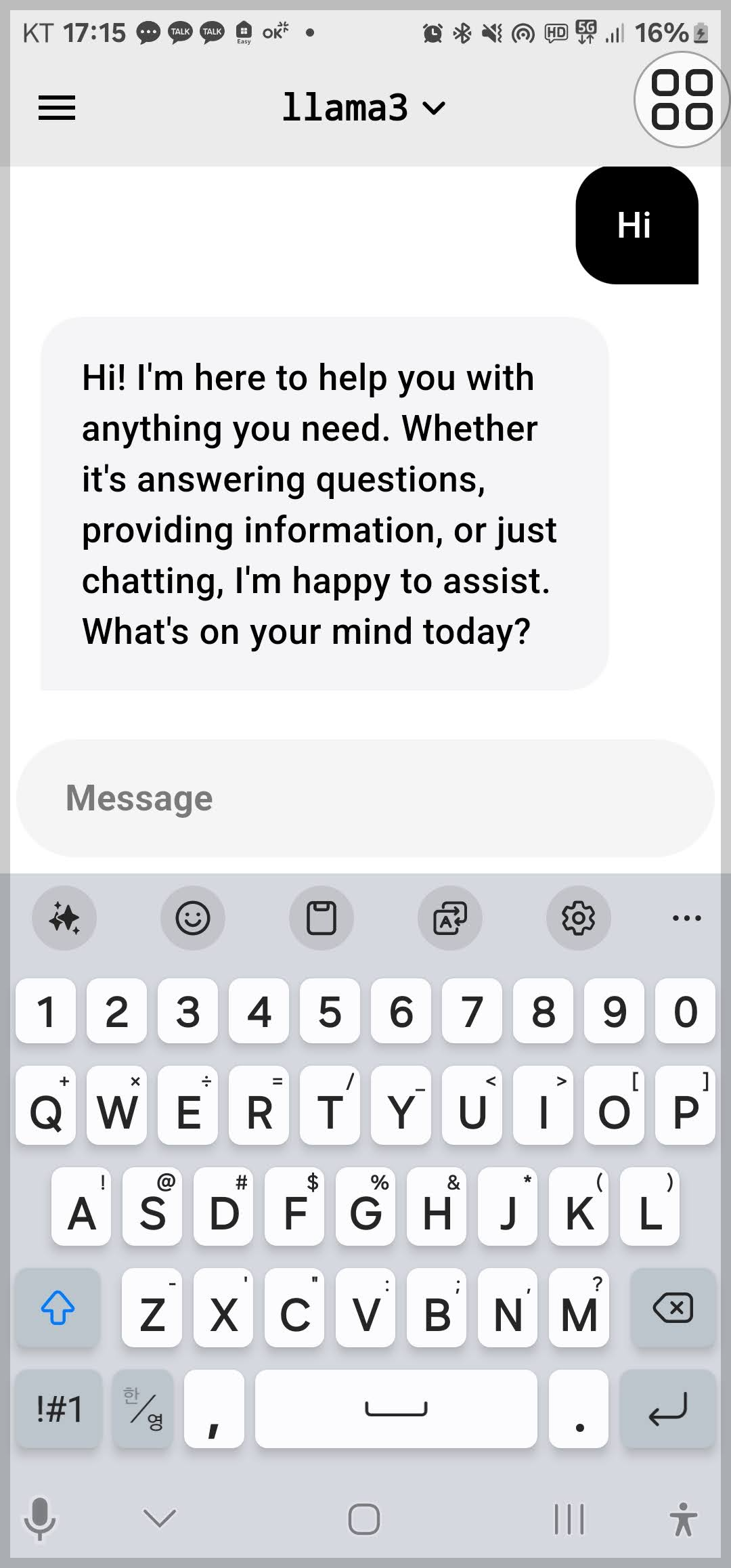

2. 초기 설정: 앱을 설치한 후 처음 열면 다음과 같은 환영 메시지와 초기 안내 화면이 나타납니다.

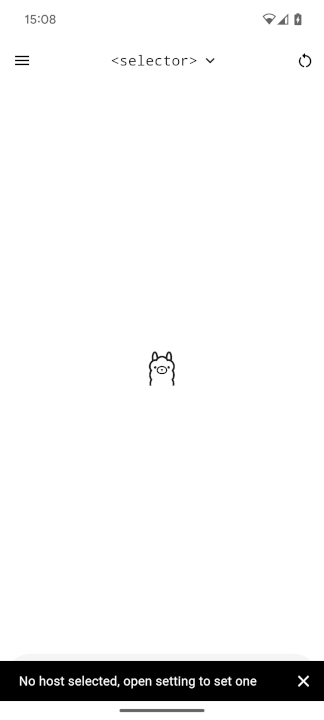

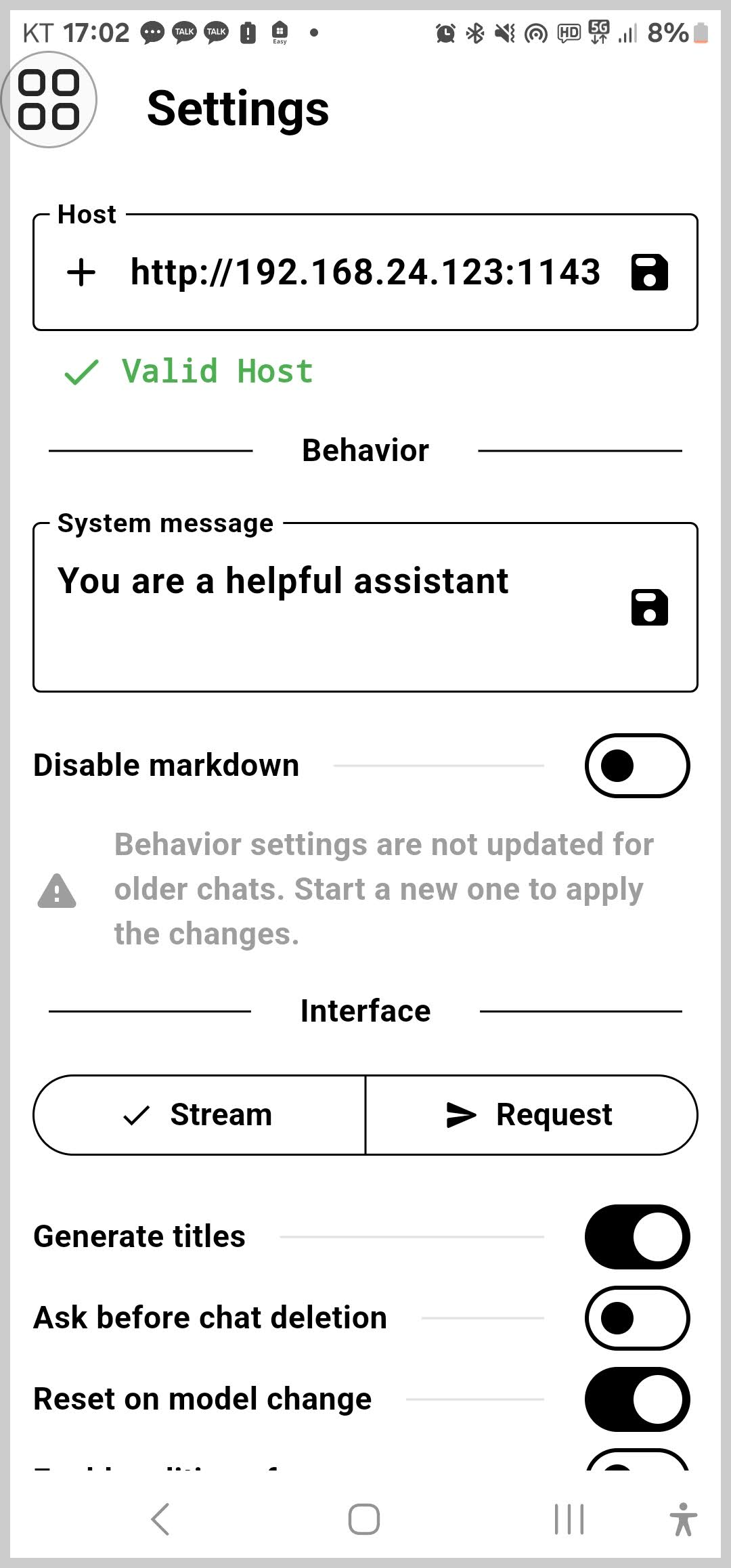

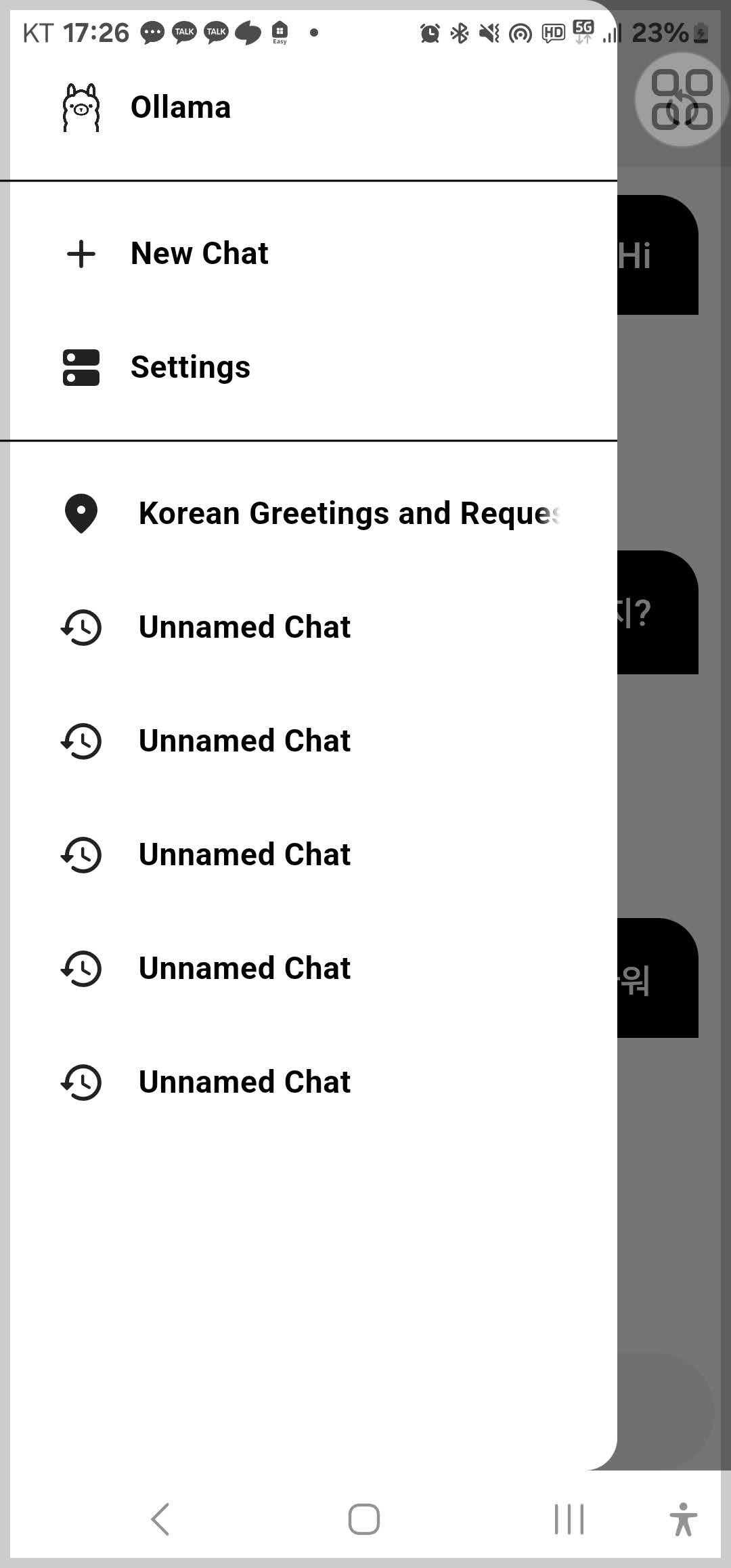

3. 호스트 설정: 초기 설정 후, 오른쪽 상단의 메뉴 버튼을 눌러 사이드 메뉴를 열고 설정을 선택합니다. 호스트 텍스트 필드에 Ollama 서버의 기본 URL을 입력합니다. 위에서 확인한 IP주소와 포트번호를 http://x.x.x.x:11434 형식으로 입력하고 저장 아이콘을 클릭하여 설정을 저장합니다. 주소가 유효하고 접속이 정상인경우 "Valid Host"라고 체크표시가 뜹니다.

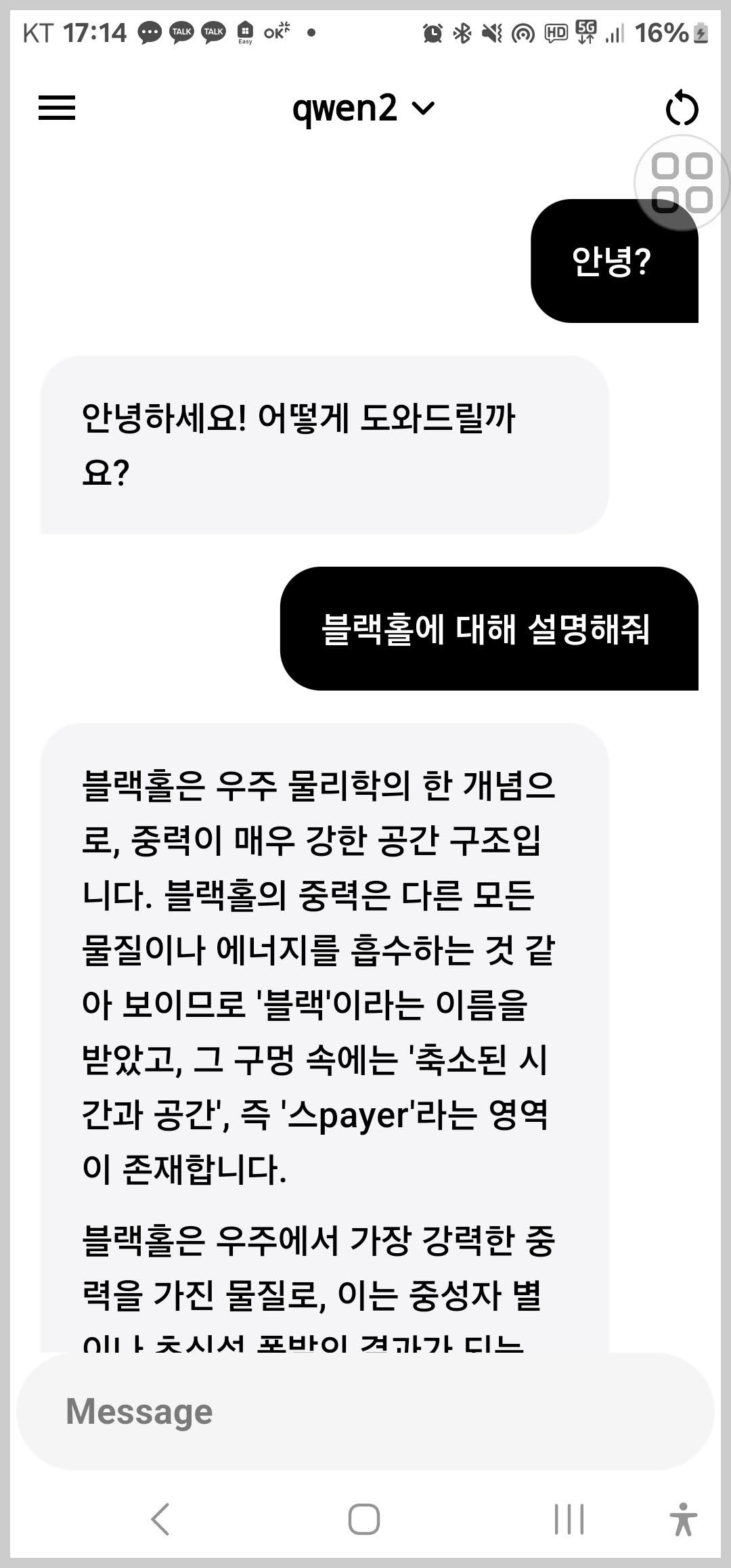

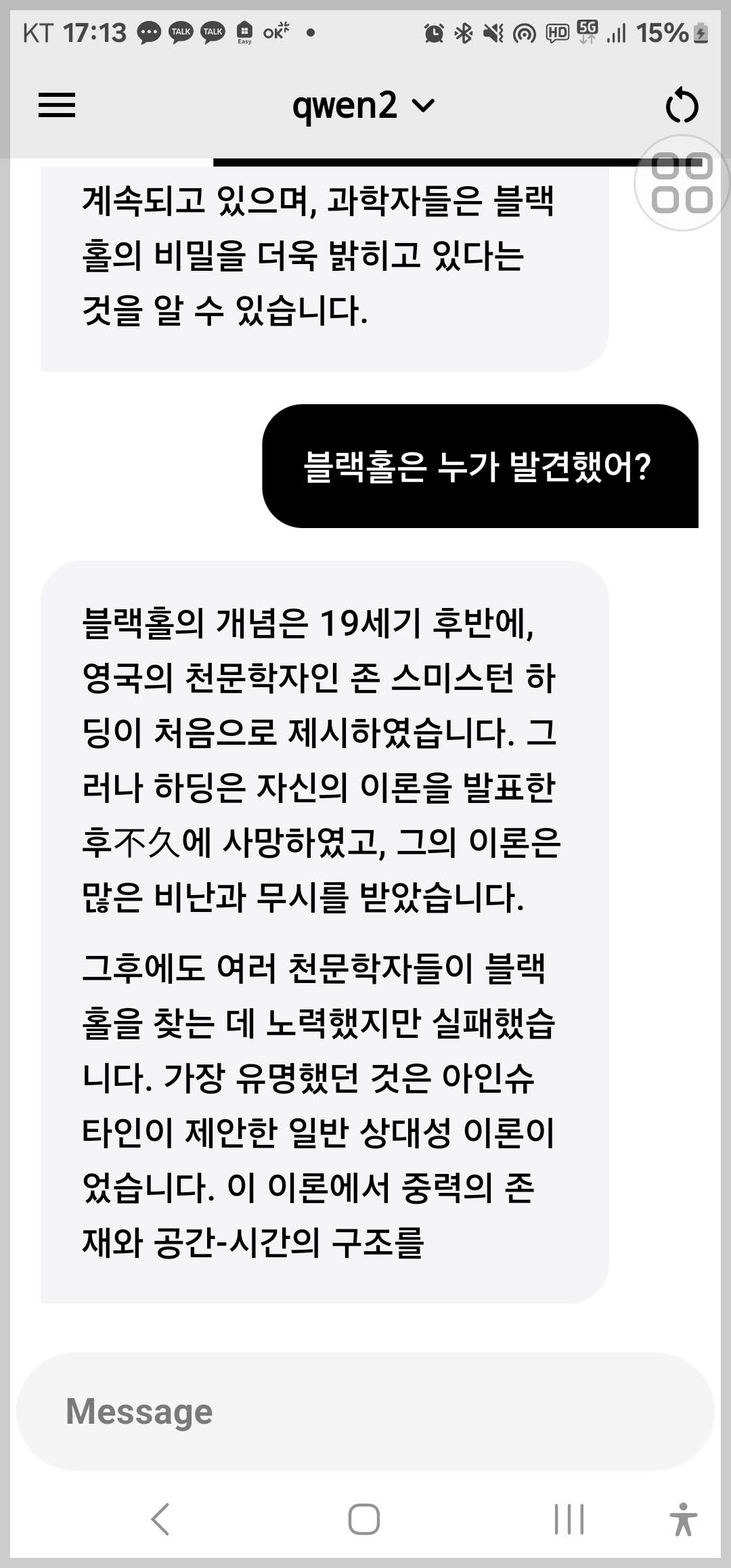

4. AI 모델 선택 및 대화 시작: 설정이 완료되면, 상단 중앙의 텍스트를 클릭하여 모델 선택기 화면을 열고 원하는 모델을 선택합니다. 메시지 입력란에 텍스트를 입력하고 전송 아이콘을 눌러 AI 모델과 대화를 시작할 수 있습니다.

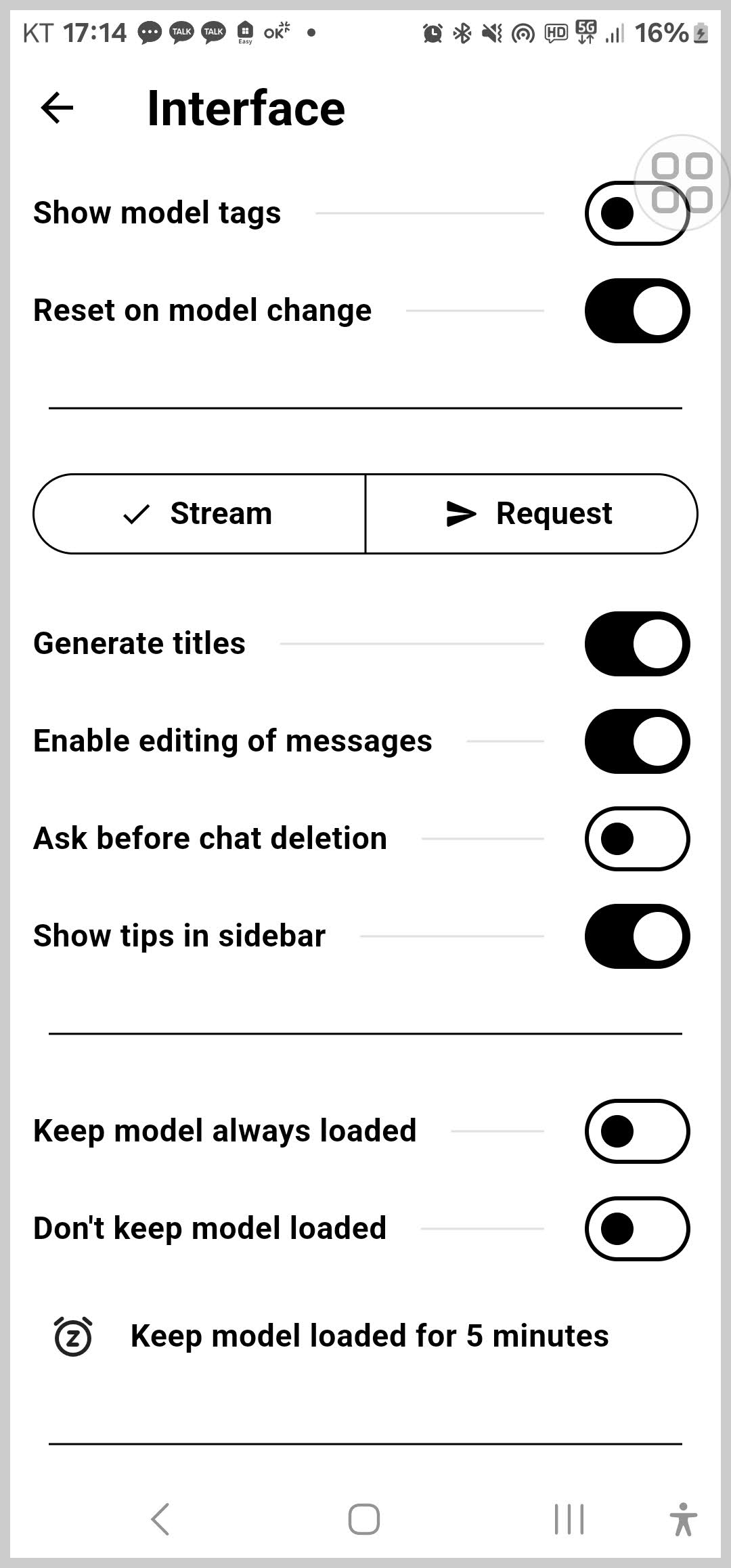

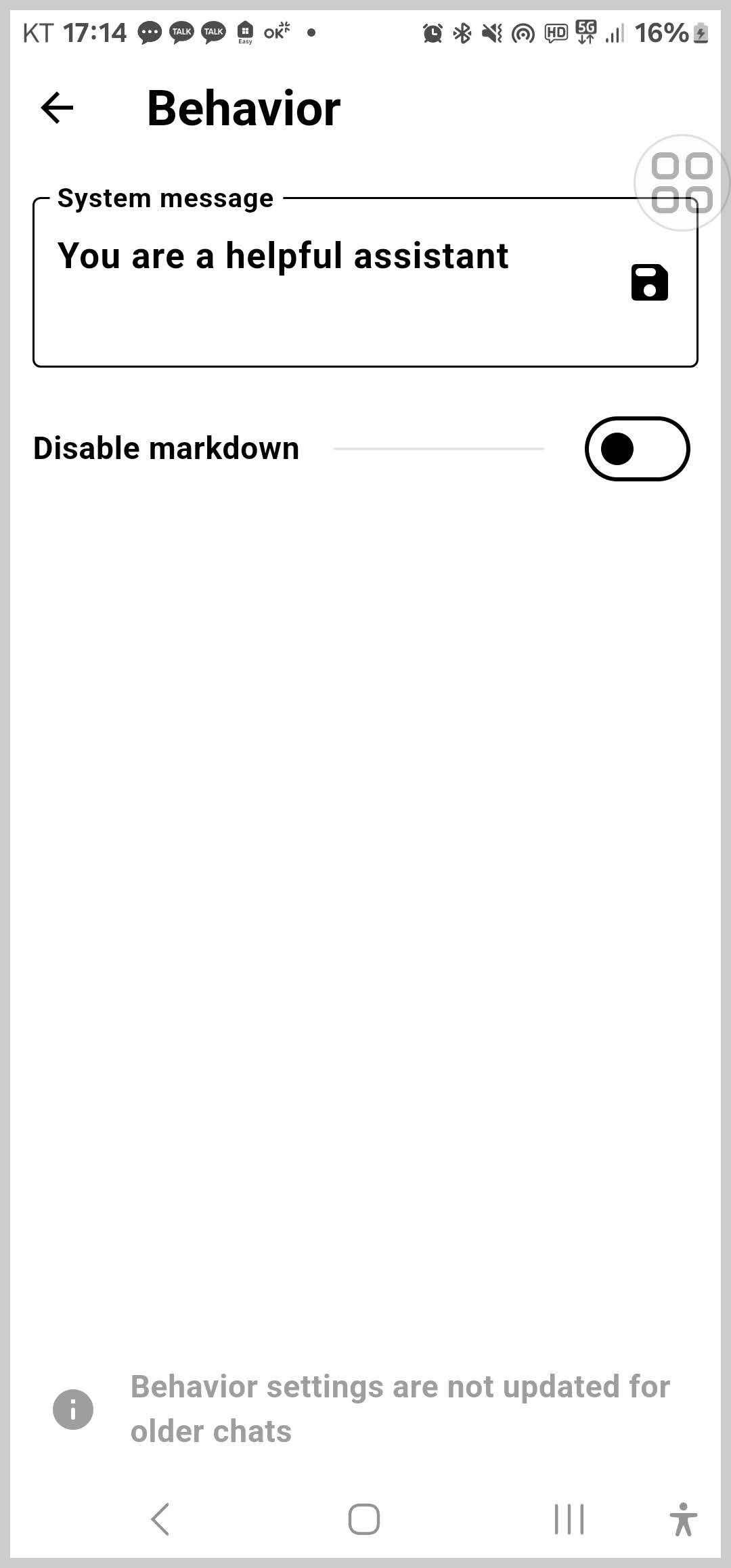

Ollama 앱 사이드 메뉴와 설정 기능에 대한 설명은 다음과 같습니다.

- 새 채팅: 새로운 채팅 세션을 시작할 수 있습니다.

- 설정: 호스트 URL 및 기타 앱 설정을 변경할 수 있습니다.

- 모델 추가: 현재는 모델을 앱에서 직접 추가하는 기능은 없으며, 지침에 따라 모델을 인스턴스에 추가합니다.

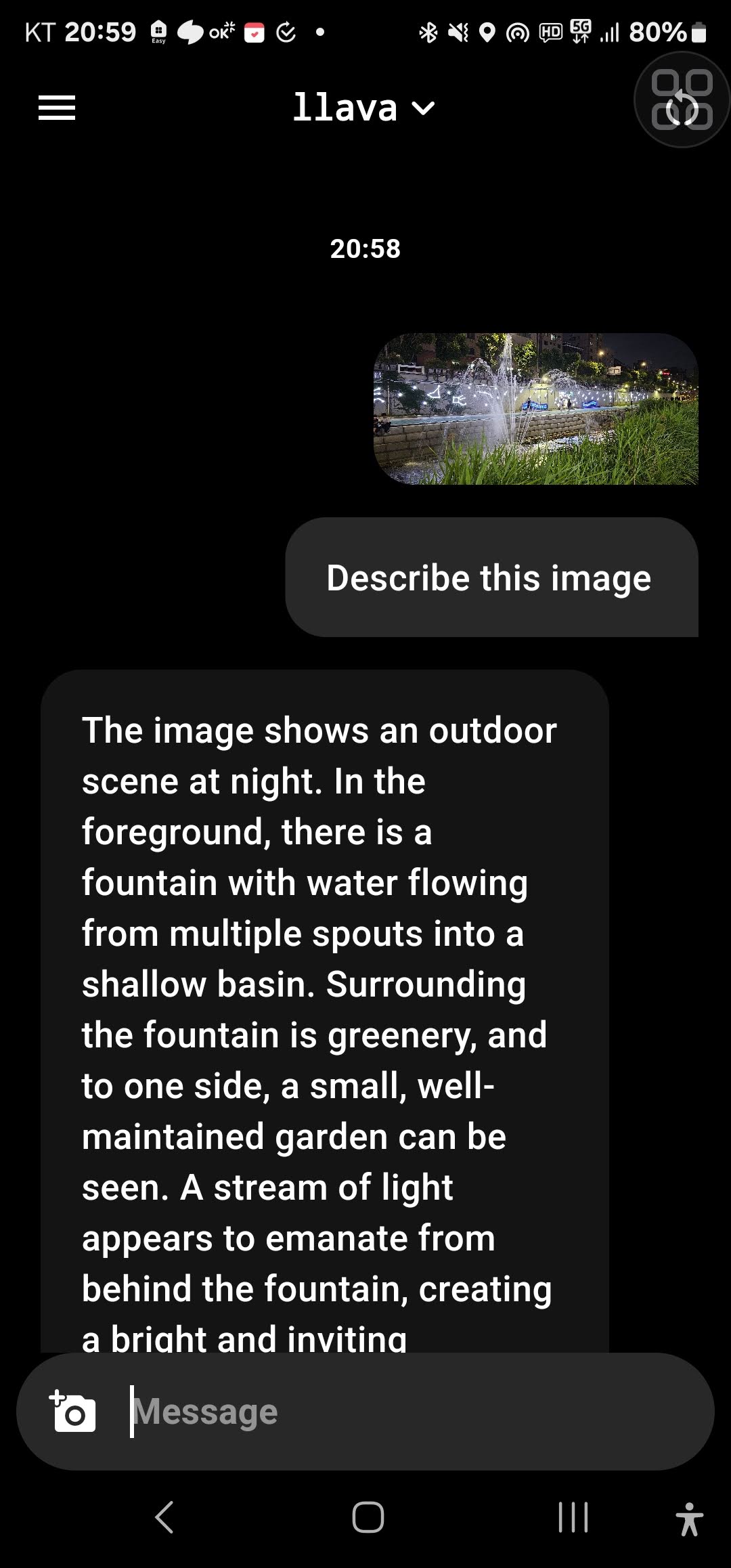

- 멀티모달 이미지 입력: 이미지 입력을 지원하는 모델을 선택하면, 메시지 입력란 하단에 카메라 아이콘이 나타납니다. 이를 통해 이미지를 업로드하고 AI 모델과 상호작용할 수 있습니다.

- 다국어 인터페이스: Ollama 앱은 현재 영어와 독일어를 지원하며, 다국어 인터페이스를 제공합니다.

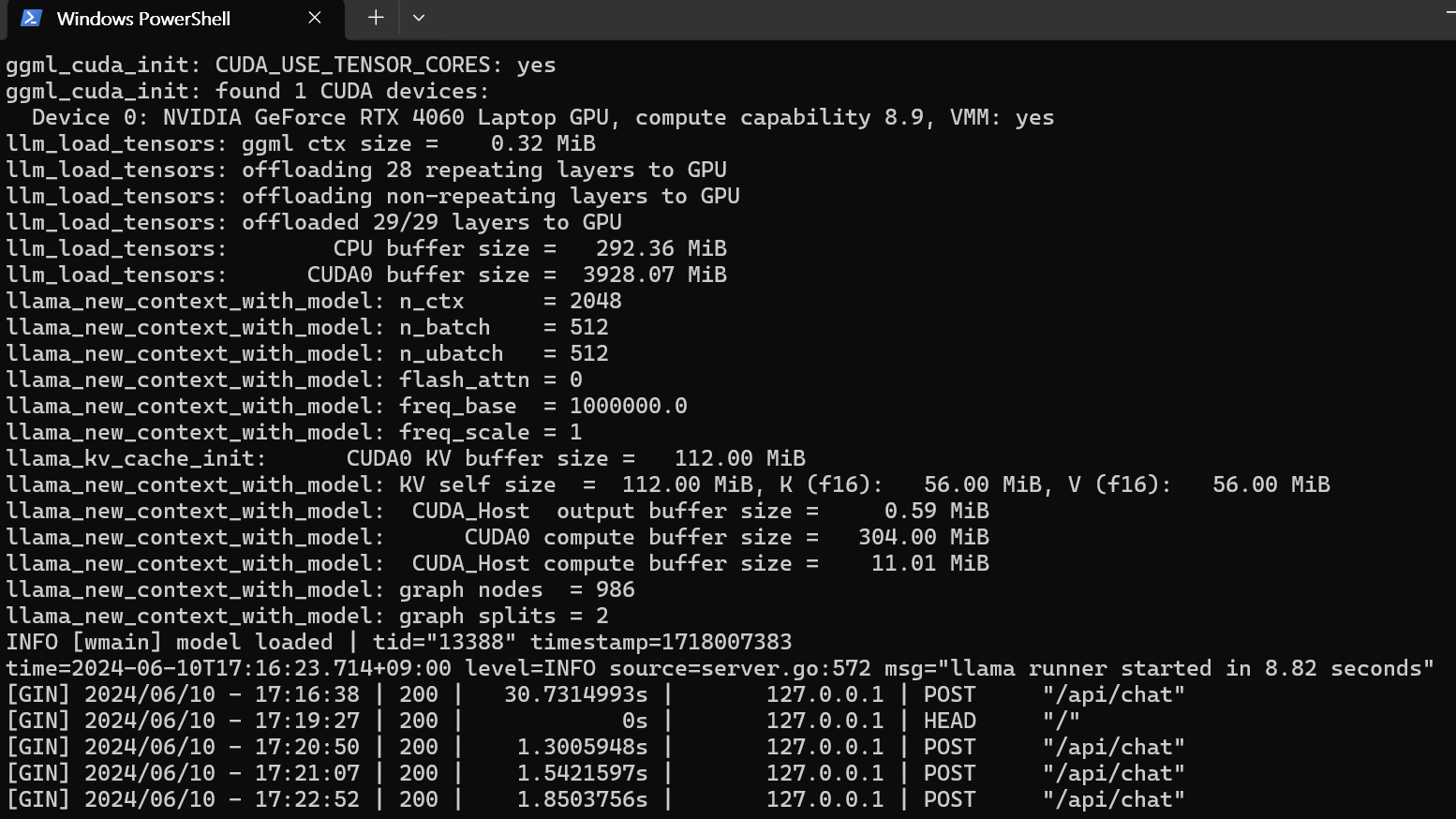

로그 확인 및 모니터링

Ollama 서버의 상태를 확인할 수 있는 로그 확인 및 서비스 모니터링 방법은 다음과 같습니다.

1. 로그 파일 확인: 파일 경로는 C:\Users\사용자명\AppData\Local\Ollama\server.log server.log이며, 파일을 메모장, Notepad++, VS Code 등 텍스트 편집기를 사용하여 로그 파일을 열고 내용을 확인합니다.

2. 실시간 로그 모니터링: 실시간으로 로그 파일을 모니터링하여 Ollama 서비스의 현재 상태를 파악할 수 있습니다.

다음 명령어를 사용하여 PowerShell을 사용하여 실시간 로그를 모니터링합니다.

Get-Content "C:\Users\User\AppData\Local\Ollama\server.log" -Wait

맺음말

오늘 블로그를 통해 Ollama 모바일 앱을 통해 어디서나 손쉽게 AI 모델과의 상호작용을 할 수 있게 되었습니다. 이 가이드에서는 Windows에서 Ollama 서버의 설치부터 포트 프록시 설정, 방화벽 규칙 추가, IP 확인, 그리고 Ollama 모바일 앱에서 호스트 설정과 AI 모델 선택을 마친 후, 실시간으로 AI와 대화할 수 있었습니다.

Ollama 앱의 데이터는 로컬 네트워크 내에서 안전하게 처리되며, 외부 서버로 전송되지 않으므로 프라이버시도 보호됩니다. 특히 AI 모델과의 상호작용이 필요할 때마다, Ollama 모바일 앱은 빠르고 쉽게 접근할 수 있는 강력한 도구가 될 것입니다. 또한 Ollama 서버의 로그를 실시간으로 모니터링하여 서비스 상태를 점검하고, 필요할 때마다 문제를 해결할 수 있습니다.

이 가이드를 통해 Ollama를 설정하고 활용하는 데 도움이 되셨길 바라면서 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.05.30 - [AI 도구] - 🌐✨Page Assist: Ollama 기반 웹 브라우저 AI Co-pilot 설치 및 사용법

🌐✨Page Assist: Ollama 기반 웹 브라우저 AI Co-pilot 설치 및 사용법

안녕하세요!! 오늘은 Ollama를 활용해서 웹 브라우저 Co-pilot으로 사용할 수 있는 Page Assist라는 크롬 확장 프로그램을 소개해 드리겠습니다. Page Assist는 로컬 AI 모델과 상호 작용할 수 있는 사이드

fornewchallenge.tistory.com

'AI 도구' 카테고리의 다른 글

| Luma AI 드림머신: 혁신적인 다중 모달 비디오 생성기(feat. SwarmUI) (0) | 2024.06.17 |

|---|---|

| InvokeAI 설치 가이드: 최신 AI 모델로 이미지 생성 및 편집(feat. LightningAI) (2) | 2024.06.12 |

| OpenRecall: 디지털 메모리를 기록하고, 검색하는 오픈소스 솔루션 (0) | 2024.06.09 |

| NVIDIA 최신 소프트웨어 기술 NIM: AI 애플리케이션 간편하게 구축하기 (2) | 2024.06.06 |

| ⚡️🆓Lightning AI: 무료 GPU 클라우드 기반 AI 개발 플랫폼 Ollama 가이드 (2) | 2024.06.02 |