안녕하세요! 오늘은 미스트랄의 최신 대형 언어 모델 Mistral Large 2에 대해서 알아보겠습니다. 123B(1230억 개)의 파라미터와 128k 컨텍스트 윈도우를 갖춘 Mistral Large 2는 코드 생성, 수학, 추론 능력에서 이전 모델보다 뛰어나며, 다국어 지원과 고급 함수 호출 기능이 향상된 차세대 AI 모델로, 연구 및 비상업적 용도로 무료로 제공됩니다. 이 블로그에서는 MIstral Large 2 모델의 개요 및 특징, 벤치마크 결과에 대해 알아보고 코딩 및 추론성능 테스트를 해보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

Mistral Large 2 개요

미스트랄의 새로운 세대의 주력 모델, Mistral Large 2는 코드 생성, 수학적 능력, 그리고 추론 능력에서 이전 모델보다 훨씬 더 강력한 성능을 제공하며, 다국어 지원과 고급 함수 호출 기능이 크게 향상되었습니다. Mistral Large 2는 128k의 컨텍스트 윈도우를 가지고 있으며, 프랑스어, 독일어, 스페인어, 이탈리아어, 포르투갈어, 아랍어, 힌디어, 러시아어, 중국어, 일본어, 한국어를 포함한 수십 개의 언어를 지원할 뿐만 아니라 Python, Java, C, C++, JavaScript, Bash 등 80개 이상의 프로그래밍 언어도 지원합니다.

https://mistral.ai/news/mistral-large-2407/

Large Enough

Today, we are announcing Mistral Large 2, the new generation of our flagship model. Compared to its predecessor, Mistral Large 2 is significantly more capable in code generation, mathematics, and reasoning. It also provides a much stronger multilingual sup

mistral.ai

Mistral Large 2는 Mistral AI의 최신 플래그십 모델답게 이전 모델에 비해 여러 면에서 크게 향상되었습니다. 주요 기능은 다음과 같습니다:

- 코드 생성 및 수학 능력: Mistral Large 2는 코드 생성, 수학, 그리고 추론 능력에서 크게 향상되었습니다. 특히 코드 생성에서는 Codestral 22B와 Codestral Mamba의 경험을 바탕으로 훈련되었으며, GPT-4o, Claude 3 Opus, Llama 3 405B와 같은 선도적인 모델들과 비슷한 성능을 보입니다.

- 다국어 지원: 프랑스어, 독일어, 스페인어, 이탈리아어, 포르투갈어, 아랍어, 힌디어, 러시아어, 중국어, 일본어, 한국어 등 수십 개의 언어를 지원합니다. 또한 파이썬, 자바, C, C++, 자바스크립트, 배시 등 80개 이상의 코딩 언어를 지원합니다.

- 긴 문맥 지원: 128k 문맥 창을 가지고 있어 긴 문맥 애플리케이션에 적합합니다. 1230억 개의 파라미터를 가지고 있어 단일 노드에서 대규모 처리량을 유지할 수 있습니다.

- 비용 효율성 및 성능: MMLU 벤치마크에서 84.0%의 정확도를 달성하여 비용 대비 성능에서 새로운 기준을 세웠습니다. 이는 오픈 모델의 성능과 비용의 균형을 새롭게 정의했습니다.

- 추론 능력 및 정확성: 모델이 허구를 생성하거나 잘못된 정보를 제공하는 경향을 최소화하기 위해 신중하고 신뢰할 수 있는 응답을 제공하도록 훈련되었습니다. 또한 답변을 제공할 수 없을 때 이를 인정하도록 설계되었습니다.

- 지침 준수 및 대화 능력: 정확한 지침을 따르고 긴 다회차 대화를 처리하는 능력이 크게 향상되었습니다. MT-Bench, Wild Bench, Arena Hard 벤치마크에서 뛰어난 성능을 보입니다.

- 도구 사용 및 함수 호출: 병렬 및 순차적 함수 호출을 능숙하게 수행할 수 있도록 훈련되어 복잡한 비즈니스 애플리케이션의 강력한 엔진 역할을 할 수 있습니다.

- 클라우드 서비스 제공자를 통한 접근성: Google Cloud Platform, Azure AI Studio, Amazon Bedrock, IBM watsonx.ai 등 주요 클라우드 서비스 제공자와 협력하여 Mistral Large 2를 전 세계 사용자에게 제공합니다.

Mistral Large 2 벤치마크 결과

Mistral Large 2는 벤치마크 결과에서 뛰어난 성능/크기 비율을 보여줍니다. 코딩과 수학능력 두 작업 모두에서 최상의 성능/크기 비율을 나타내는 영역에 위치하고 있으며, GPT-4o 등 선도 모델과 동등한 성능을 보여줍니다. 특히, "환각" 현상을 줄여 신뢰성과 정확성을 높이고, 명령을 따르는 능력과 대화 능력도 크게 개선되어 MT-Bench 등에서 우수한 성능을 보였으며, 간결하고 요점만을 제시하는 응답을 생성합니다.

Mistral Large 2는 여러 성능 평가 지표에서 뛰어난 성능을 보입니다. Human Eval 지표에서는 다양한 작업에서 생성된 답변을 인간이 직접 평가하며, Mistral Large 2는 GPT-4o를 제외한 모든 모델보다 우수한 성능을 기록했습니다. 특히 난이도가 높은 Human Eval Plus에서도 가장 높은 정확도를 보였습니다. MBBP (Massive Multitask Language Understanding) 지표에서는 객관식 문제를 제시하여 모델의 정답 비율을 측정합니다. Mistral Large 2는 기본 난이도의 MBBP Base에서 GPT-4o와 Claude 3.5 140B에는 못 미치지만, Llama 3.1 70B 모델과 비슷한 수준을 보였고, 더 어려운 MBBP Plus에서는 Llama 3.1 70B보다 높은 성능을 기록했습니다.

Mistral Large 2는 평균 74.4%의 정확도로 Llama 3.1 405B와 비슷한 성능을 보이며, Java(84.2%)와 TypeScript(86.8%)에서 특히 뛰어납니다. C++(84.5%)와 PHP(77.6%)에서도 준수한 성능을 보이지만, Bash(51.9%)와 C#(61.4%)에서는 개선이 필요합니다. Mistral Large 1보다 모든 언어에서 성능이 향상되었지만, GPT-4는 여전히 평균 75.3%로 더 높은 정확도를 기록하고 있습니다. Mistral Large 2는 다양한 언어에서 강점을 보이나, 일부 언어에서는 개선이 필요합니다.

Mistral Large 2 테스트

다음은 Mistral Large 2 모델의 코딩 및 추론성능을 테스트해 보겠습니다. 테스트 환경은 Windows 11 Pro(23H2), WSL2, 파이썬 버전 3.11, 비주얼 스튜디오 코드(이하 VSC) 1.91.1이며, VSC를 실행하여 "WSL 연결"을 통해 Windows Subsystem for Linux(WSL) Linux 환경에 액세스 하도록 구성하고, 채팅 인터페이스로 PraisonAI Chat을 사용하였습니다.

1. 가상환경 생성 및 활성화: VSC에서 메인 디렉토리를 생성한 후, 아래 명령어로 가상환경을 생성하고 활성화합니다.

python3.11 -m venv myenv

source myenv/bin/activate2. 의존성 패키지 설치 및 API KEY 설정: Mistral Large 2 모델과 대화하기 위한 웹 기반 채팅 인터페이스, PraisonAI [Chat] 패키지를 설치하고 https://console.mistral.ai/api-keys/ 에서 Mistral API KEY를 발급받아 설정합니다.

pip install praisonai[chat]

export Mistral_API_KEY=발급받은 API KEY3. 챗봇 인터페이스 실행: "praisonai chat"을 입력하여 채팅 인터페이스를 실행하면 http://localhost:8084/주소에서 웹 채팅 인터페이스 로그인 창이 뜨며, ID와 패스워드에 admin/admin을 입력하여 로그인합니다.

praisonai chat

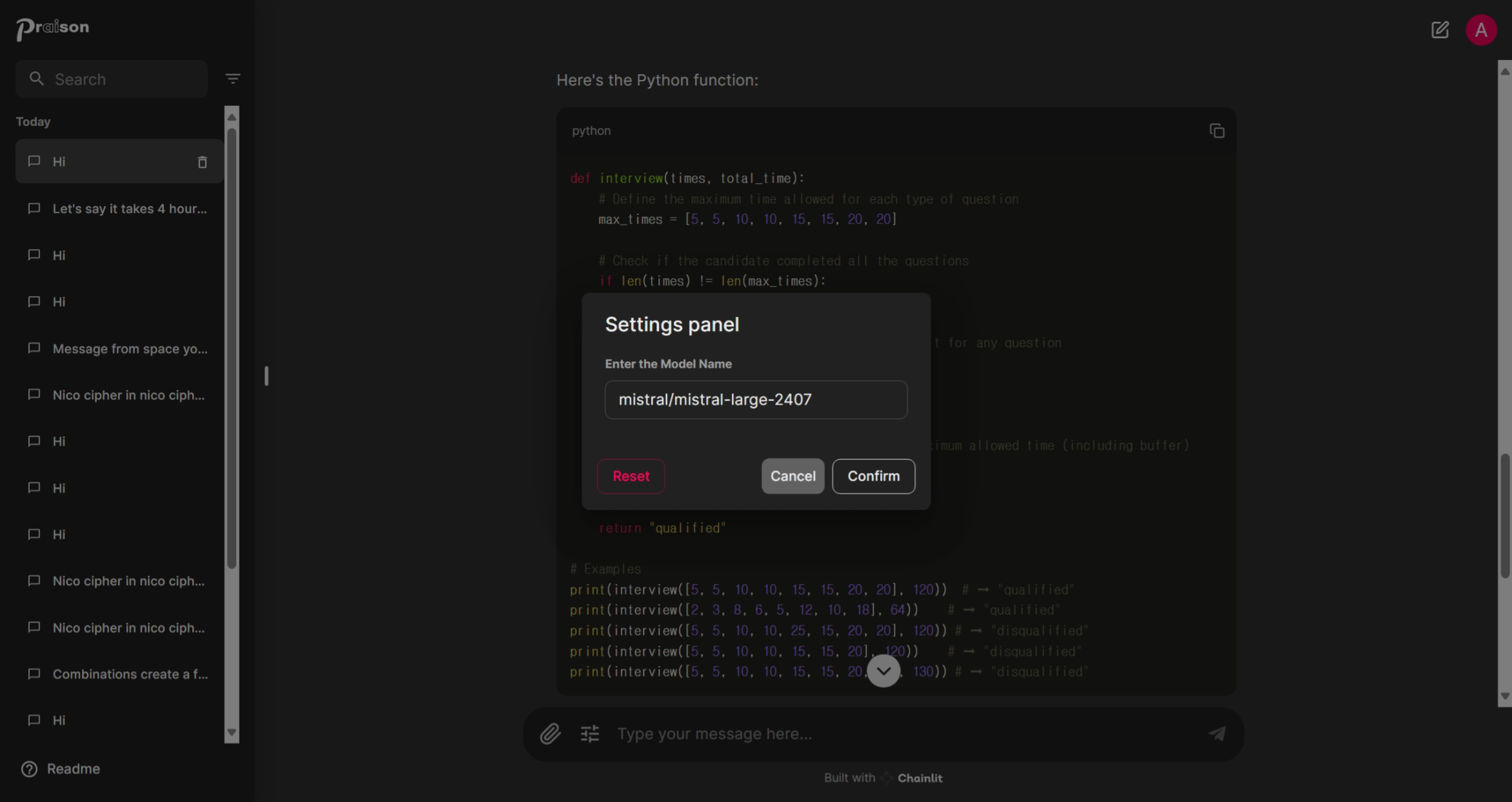

4. 모델 설정: 사용자 프롬프트 입력창 왼쪽 설정 아이콘을 클릭하고 "mistral/mistral-large-2407"를 입력합니다.

코딩 테스트

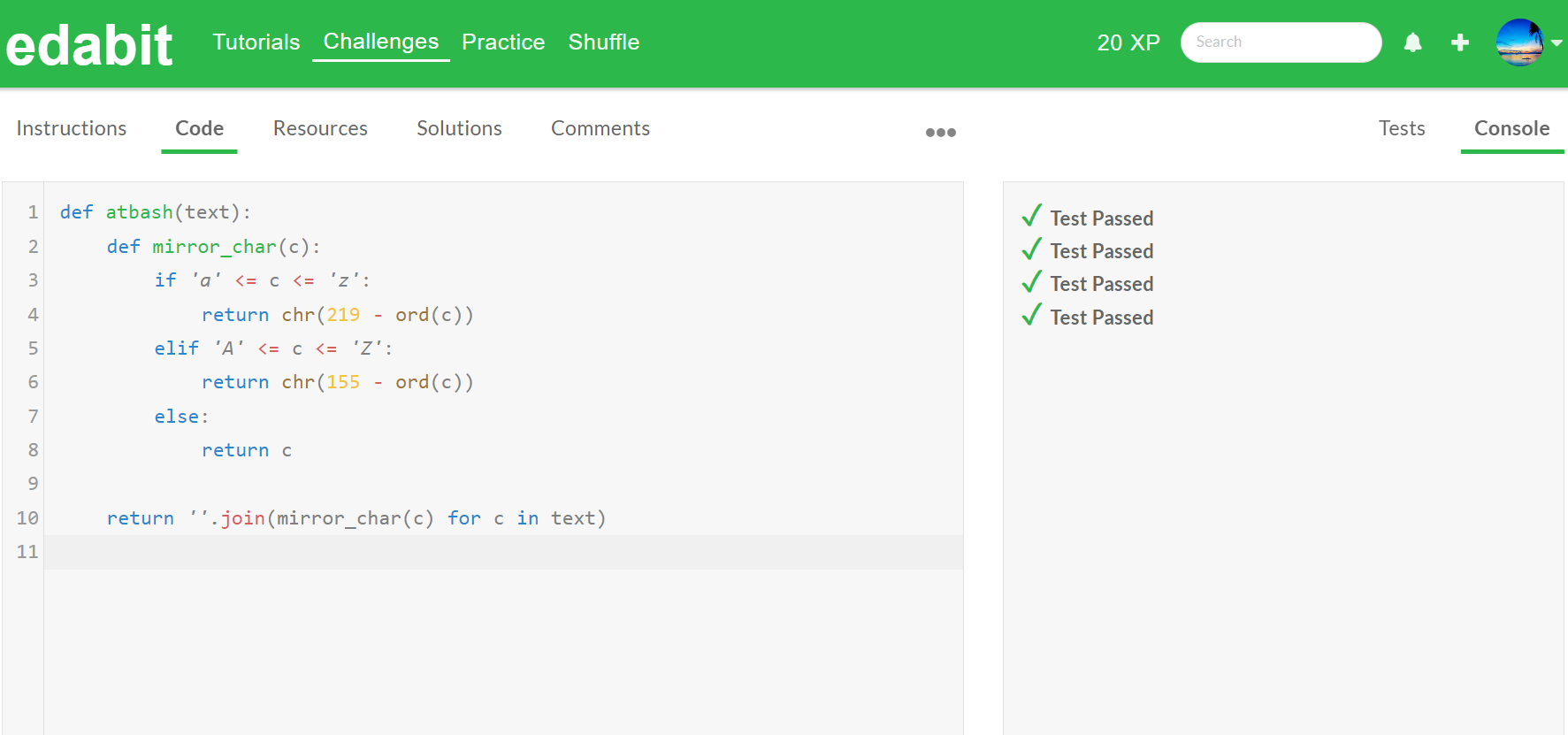

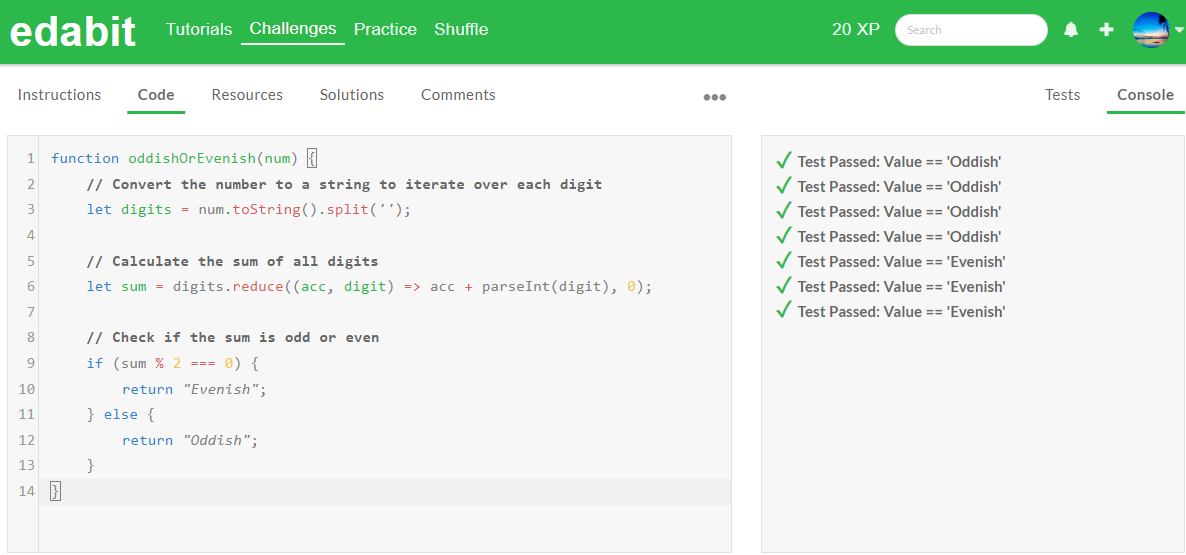

Mistral Large 2 모델의 코딩 테스트는 edabit.com 코딩 교육 사이트 Python, JavaScript, C++에 대하여 테스트하였으며, 모든 문제는 재시도 없이 첫 번째 시도의 채점결과를 그대로 반영하였습니다.

| Mistral Large-2-123B/Pass@1 | Very Easy | Easy | Medium | Hard | Very Hard | Expert |

| Python/ | Pass | Pass | Pass | Pass | Pass | Pass |

| Java Script | Pass | Pass | Pass | Pass | Pass | Fail |

| C++ | Pass | Pass | Fail | Pass | Pass | Pass |

추론테스트

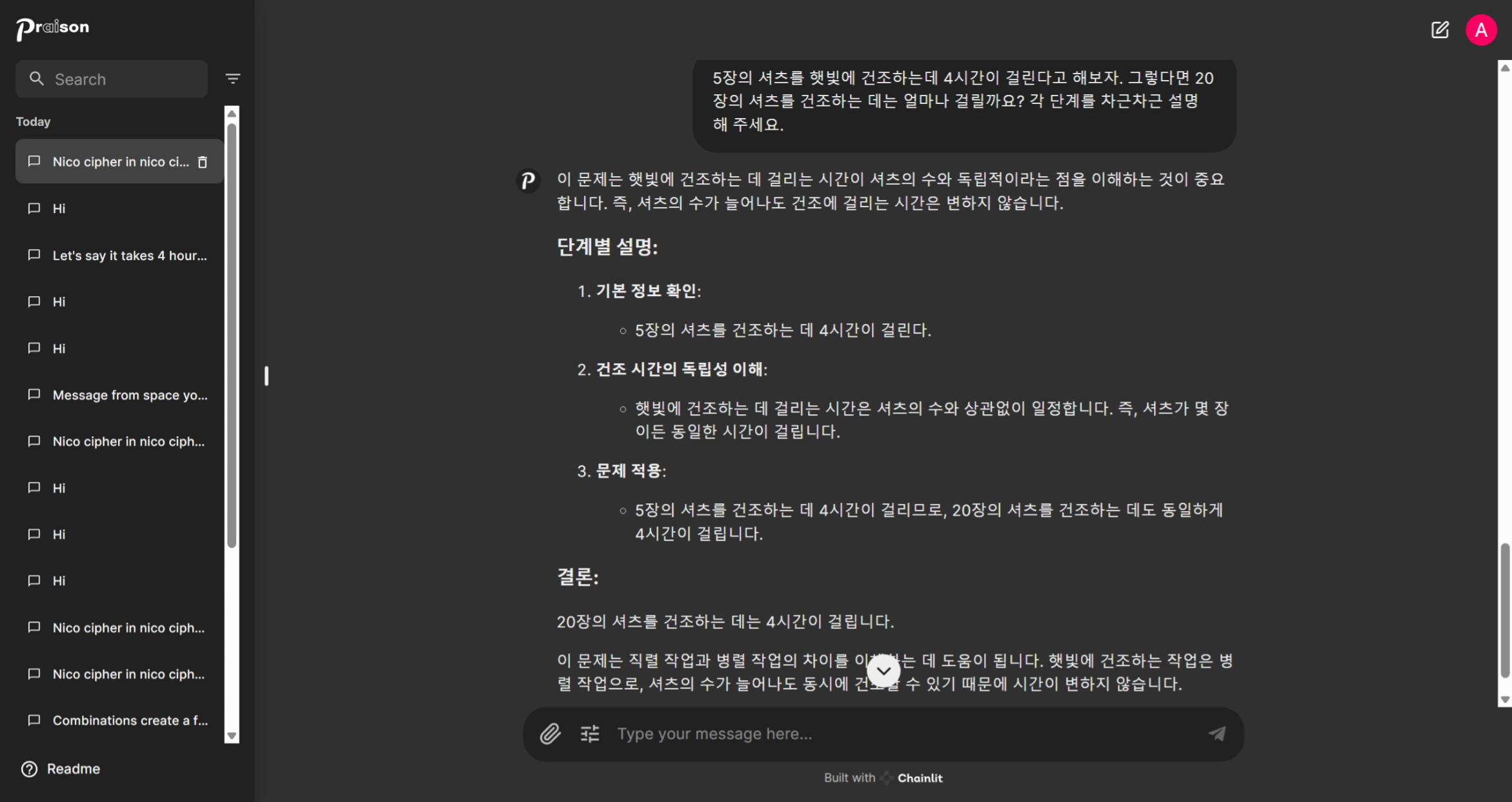

다음은 추론성능 테스트로, 첫 번째 문제는 셔츠 건조시간 문제입니다.

"5장의 셔츠를 햇빛에 건조하는데 4시간이 걸린다고 해보자. 그렇다면 20장의 셔츠를 건조하는 데는 얼마나 걸릴까요? 각 단계를 차근차근 설명해 주세요." - Mistral Large 2 정답 : 4시간

다음 추론문제는 GSM8K (Grade School Math 8K, 8,500개의 다양한 초등학교 수학 서술형 문제 데이터셋)입니다.

"베티는 새 지갑을 위해 돈을 모으고 있습니다. 새 지갑의 가격은 $100입니다. 베티는 필요한 돈의 절반만 가지고 있습니다. 그녀의 부모는 그 목적을 위해 $15를 주기로 결정했고, 할아버지와 할머니는 그녀의 부모들의 두 배를 줍니다. 베티가 지갑을 사기 위해 더 얼마나 많은 돈이 필요한가요?" - Mistral Large 2 정답 : 5달러

"방 안에는 살인자가 세 명 있습니다. 어떤 사람이 방에 들어와 그중 한 명을 죽입니다. 아무도 방을 나가지 않습니다. 방에 아 있는 살인자는 몇 명입니까? 단계별로 추론 과정을 설명하세요." - Mistral Large 2 정답 : 3명

이 문제에서 MIstral Large 2 모델은 제가 본 중에 가장 명쾌한 대답을 하였습니다.

다음 추론 테스트는 영문 추론입니다. 문제는 다음과 같습니다.

A marble is put in a glass. The glass is then turned upside down and put on a table. Then the glass is picked up and put in a microwave. Where's the marble? Explain your reasoning step by step.(구슬을 유리컵에 넣습니다. 그다음 유리컵을 거꾸로 뒤집어서 테이블 위에 놓습니다. 그다음에 유리컵을 들어서 전자레인지에 넣습니다. 구슬은 어디에 있습니까? 단계별로 설명해 주세요.)

추론 성능 테스트에서 Mistral Large 2 123B는 4문제 모두 맞히면서 우수한 성능을 보여주었습니다.

| 추론 테스트/Pass@1 | 셔츠 건조시간 | GSM8K 문제 | 살인자 문제 | 구슬 문제 |

| Mistral Large 2 | Pass | Pass | Pass | Pass |

Mistral Large 2 모델은 코딩이나 추론 테스트에서 전반적으로 매우 우수한 성능을 보였으며, 특히 논리적 추론에서 매우 명쾌하고 깔끔한 답변을 제공하면서도, 한국어 표현이 매우 자연스러웠습니다.

맺음말

오늘은 미스트랄 AI의 최신 모델, Mistral Large 2에 대해 자세히 알아보았습니다. 1230억 개의 파라미터와 128k의 컨텍스트 윈도우를 갖춘 이 모델은 코드 생성, 수학, 추론 능력에서 이전 모델을 크게 능가하며, 다국어 지원과 고급 함수 호출 기능 또한 크게 향상되었습니다. Mistral Large 2의 벤치마크 결과는 다른 선도 모델들과 비교했을 때 매우 인상적이었습니다. 특히, Human Eval과 MBBP 지표에서 높은 성능을 기록하며 코드 생성과 추론 능력에서 탁월한 성과를 보였습니다.

Mistral Large 2 모델을 사용해 본 후기는 다음과 같습니다.

- 코딩 테스트 88%는 보기 드문 우수한 성적으로 DeepSeek-Coder-V2에 근접하였다.

- 논리적 추론의 답변이 매우 명쾌하고 청량해서 읽으면서 소름이 돋았다.

- 한국어 표현이 매우 자연스러웠습니다.

Mistral Large 2는 그 성능과 다양성으로 인해 연구자와 개발자들에게 매우 유용한 도구가 될 것입니다. 앞으로도 Mistral AI의 기술 발전이 더욱 기대됩니다. 여러분도 블로그에 소개된 방법을 통해 Mistral Large 2의 뛰어난 성능을 체험해 보시길 추천드립니다. 저는 그럼 다음 시간에 더욱 유익한 정보를 가지고 찾아뵙겠습니다. 감사합니다!

2024.06.20 - [AI 언어 모델] - DeepSeek-Coder-V2: 현존 최강 AI 코딩 언어 모델 분석 및 테스트

DeepSeek-Coder-V2: 현존 최강 AI 코딩 언어 모델 분석 및 테스트

안녕하세요! 오늘은 최신 코딩 언어 모델 DeepSeek-Coder-V2에 대해 알아보겠습니다. 이 모델은 수학적 추론과 코딩 능력 벤치마크에서 GPT-4-터보, Claude-3-Opus, Gemini-1.5-pro와 같은 고성능 상용 AI 모델을

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| ✨Gemini 1.5 프로 실험 버전: GPT-4o를 제치고 챗봇 아레나 1위! (2) | 2024.08.03 |

|---|---|

| 🧠 최강 AI 검색 비서: Mistral Large 2 모델 설정 가이드 (0) | 2024.07.26 |

| 🚀 Llama 3.1: Meta의 최강 오픈소스 AI 모델 출시! 📈 (12) | 2024.07.24 |

| Mistral NeMo: 🚀128k 긴 텍스트와 다국어 지원 미스트랄 최신 모델 (5) | 2024.07.20 |

| 🚀 GPT-4o mini: OpenAI의 최첨단 고성능 저비용 AI 모델 (0) | 2024.07.20 |