안녕하세요! 오늘은 로컬에서 대규모 언어 모델(LLM)을 실행할 수 있는 GPT4All 애플리케이션에 대해 알아보겠습니다. 최근 인공지능의 발전과 함께 LLM이 다양한 응용 분야에서 뛰어난 성능을 보여주고 있으며, 특히 자연어 처리(NLP) 분야에서 많은 주목을 받고 있지만, 대부분의 고성능 상용 LLM은 클라우드 기반으로 운영되며, 이는 데이터 프라이버시와 보안에 대한 우려를 불러일으킬 수 있습니다. GPT4All은 사용자의 데이터를 로컬에서 안전하게 처리하며, 다양한 하드웨어와 언어 모델을 지원하는 오픈소스 소프트웨어로, 사용자 맞춤형 설정과 높은 프라이버시를 보장합니다. 오늘 블로그에서는 GPT4All의 개요와 주요기능, 설정방법 등에 대해서 알아보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

GPT4All 개요

GPT4All은 로컬 환경에서 대규모 언어 모델을 실행할 수 있도록 설계된 소프트웨어로, 인터넷 연결 없이도 작동할 수 있어 데이터 프라이버시를 보장합니다. GPT4All은 윈도우, 맥, 리눅스 등 다양한 운영체제에서 사용할 수 있으며, CPU와 GPU를 모두 지원하여 사용자에게 최적의 성능을 제공합니다. GPT4All은 오픈 소스 프로젝트로, 사용자는 자유롭게 소프트웨어를 다운로드하고 커스터마이즈할 수 있습니다.

다음은 GPT4All의 주요 특징입니다.

- 프라이버시 우선: GPT4All은 사용자의 대화 내용이 절대 외부로 유출되지 않도록 설계되었습니다. 모든 데이터는 사용자의 장치 내에 안전하게 저장되며, 인터넷 연결 없이도 작동합니다. 이를 통해 사용자는 민감한 정보를 안심하고 GPT4All과 공유할 수 있습니다.

- 로컬 실행: GPT4All은 소비자 하드웨어에서 대규모 언어 모델을 실행할 수 있도록 지원합니다. 이는 Mac M 시리즈 칩, AMD, NVIDIA GPU 등 다양한 하드웨어를 완벽히 지원하여 사용자에게 최적의 성능을 제공합니다.

- 개인 맞춤화: 사용자는 로컬 파일에 액세스 할 수 있는 GPT4All의 기능을 활용하여 자신의 민감한 정보를 안전하게 다룰 수 있습니다. LocalDocs 기능을 통해 인터넷 연결 없이도 데이터를 처리할 수 있어, 사용자에게 높은 수준의 데이터 프라이버시를 보장합니다.

- 오픈 소스 및 커스터마이즈: GPT4All은 MIT 라이선스를 따르는 오픈 소스 프로젝트로, 누구나 코드베이스를 검토하고 기여할 수 있습니다. 또한, 사용자는 자신의 시스템 프롬프트, 온도, 컨텍스트 길이, 배치 크기 등을 설정하여 챗봇 경험을 맞춤화할 수 있습니다.

- 광범위한 모델 지원: GPT4All은 LLaMa, Mistral, Nous-Hermes 등 인기 있는 모델을 포함해 1000개 이상의 오픈 소스 언어 모델을 지원합니다. 이를 통해 사용자는 다양한 모델을 탐색하고 자신에 맞는 모델을 선택할 수 있습니다.

GPT4All

Run Large Language Models Locally: privacy-first and no internet required

www.nomic.ai

GPT4All 주요 기능

다음은 GPT4All의 주요기능입니다. GPT4All의 주요 기능은 아래 초기화면에서와 같이 LLM 대화, 로컬 문서 대화, 모델 찾기 세 가지로 구성되어 있습니다. 설치는 GPT4All 사이트에서 윈도우즈, MacOS, Ubuntu 중에서 자신의 운영체제에 맞는 버전을 선택해서 다운로드 후 실행하시면 됩니다.

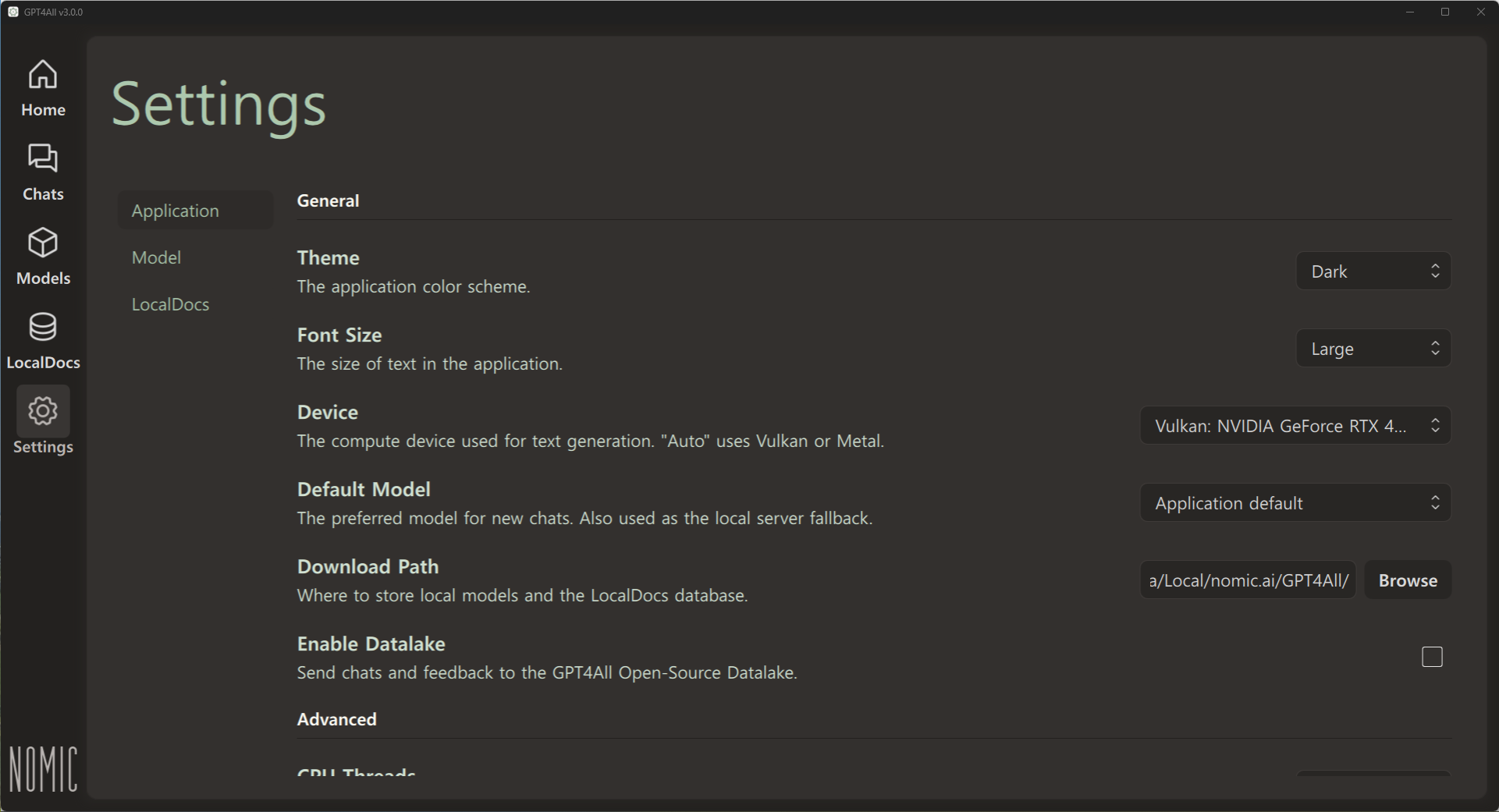

설정

먼저, 설정 메뉴의 Device에서 Auto, Vulkan, Cuda, CPU 중에서 본인에게 맞는 설정을 선택해야 하는데요, Vulkan은 AMD, Intel, Nvidia 등 다양한 제조사의 GPU를 지원하고, CUDA는 Nvidia GPU에 최적화되어 있으며, AMD, Intel 등 다른 제조사의 GPU에서는 지원되지 않습니다.

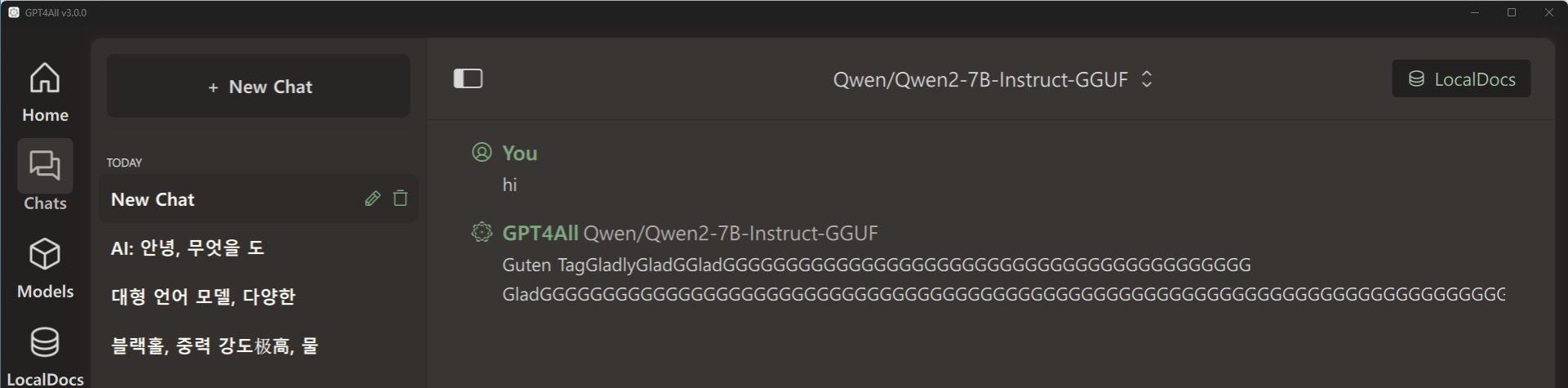

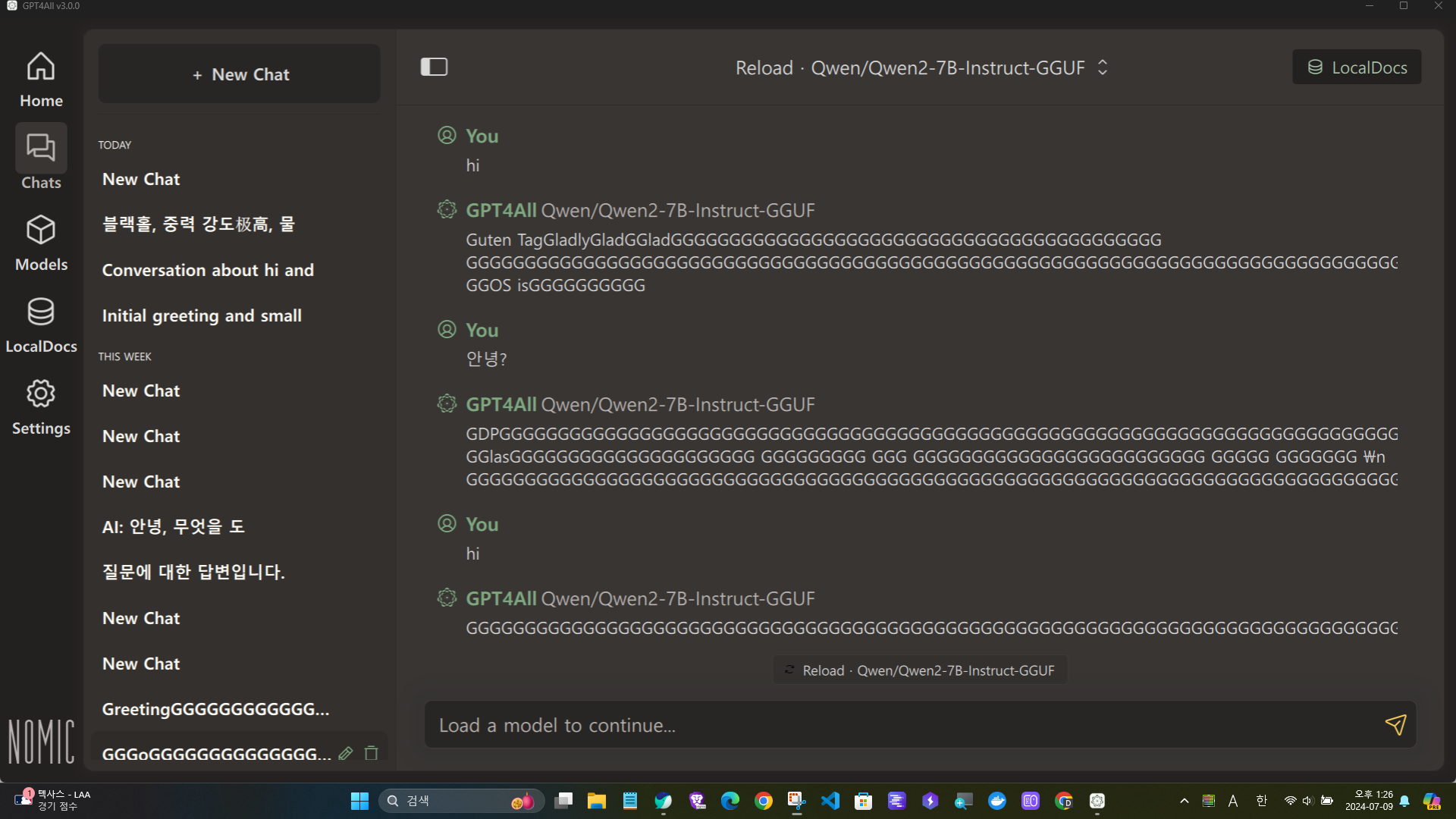

저의 경우 Nvidia GPU를 사용하고 있어서 CUDA를 선택하였지만, 아래 화면과 같이 에러가 발생하였고, Vulkan으로 변경하면 정상적으로 응답이 출력되었습니다. 언어 모델의 출력이 비정상적인 경우 GPU 설정을 확인해 보시기 바랍니다.

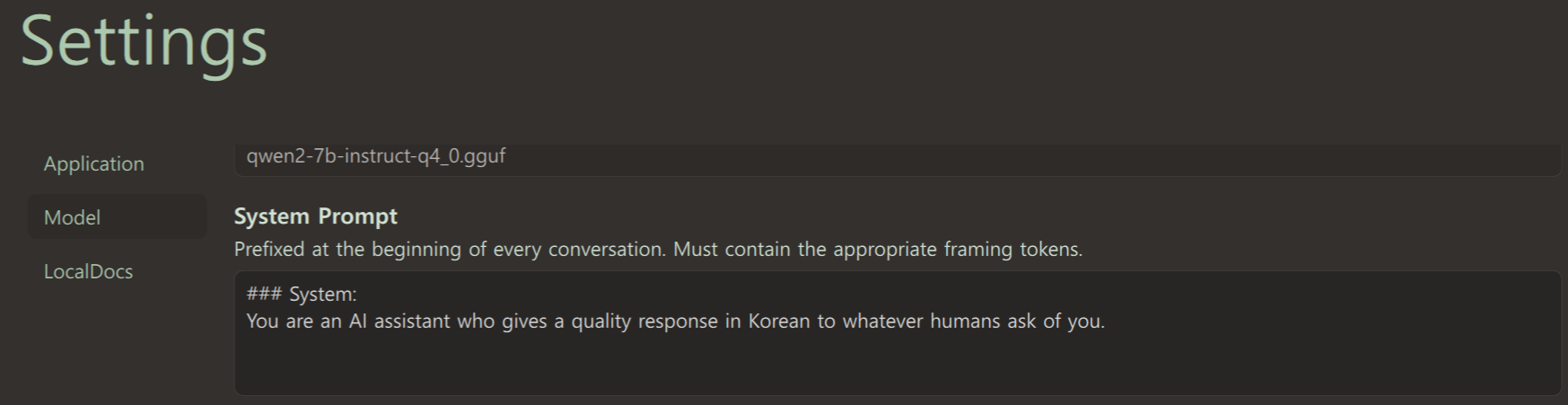

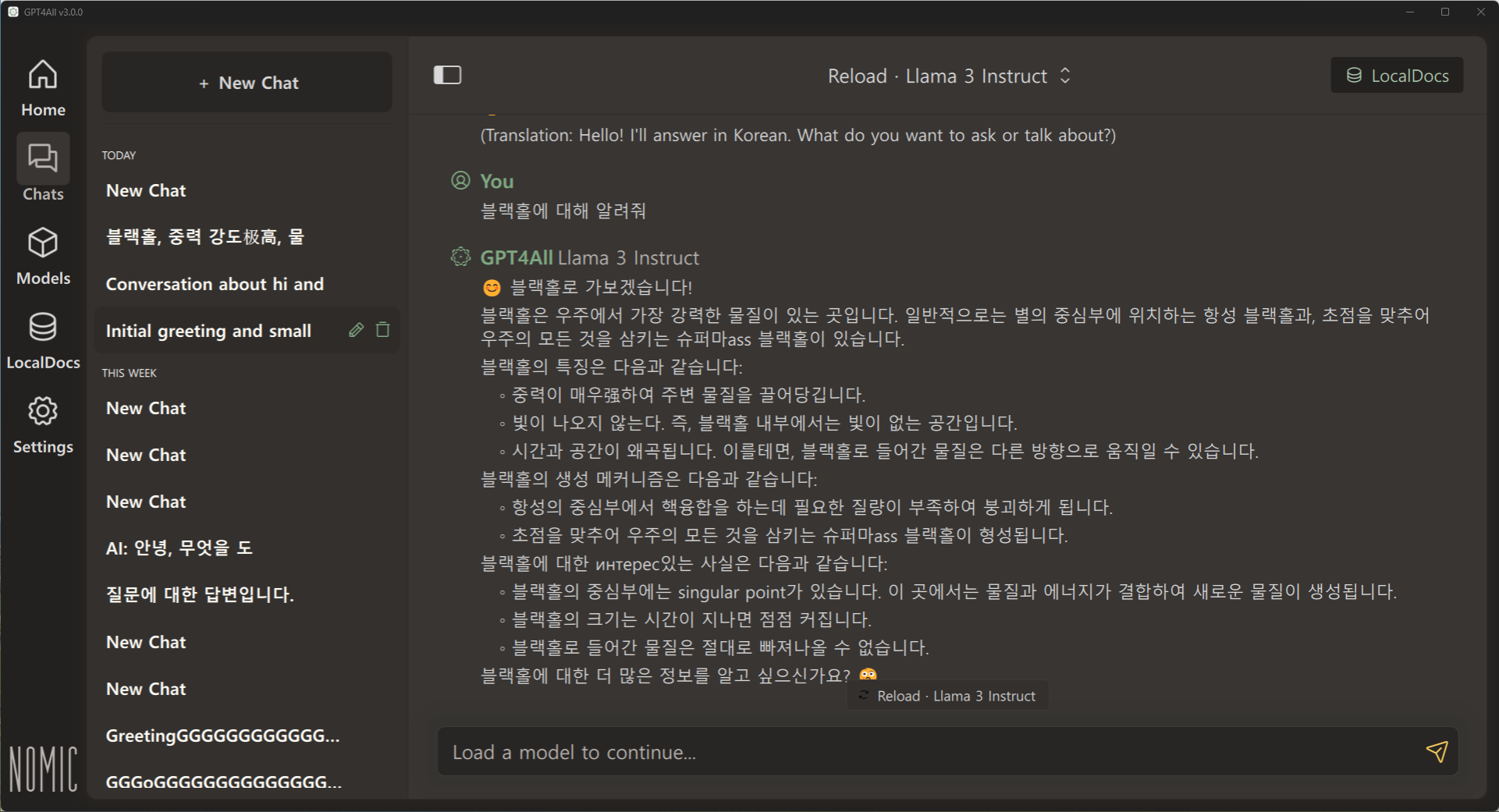

설정 메뉴 중 Model에서는 아래 화면과 같이 시스템 프롬프트를 설정하여 한국어로 응답하도록 설정할 수 있습니다.

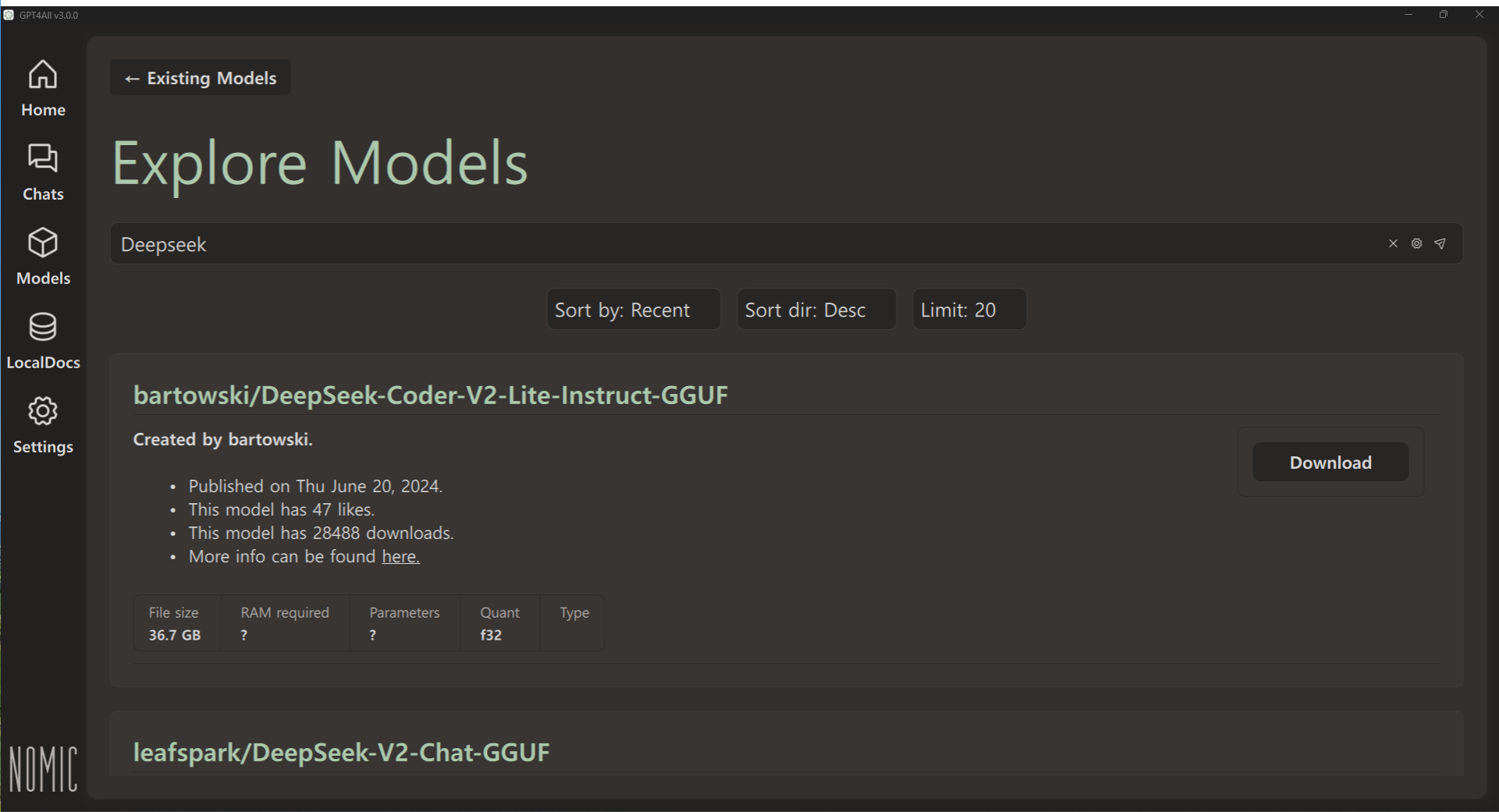

모델 찾기

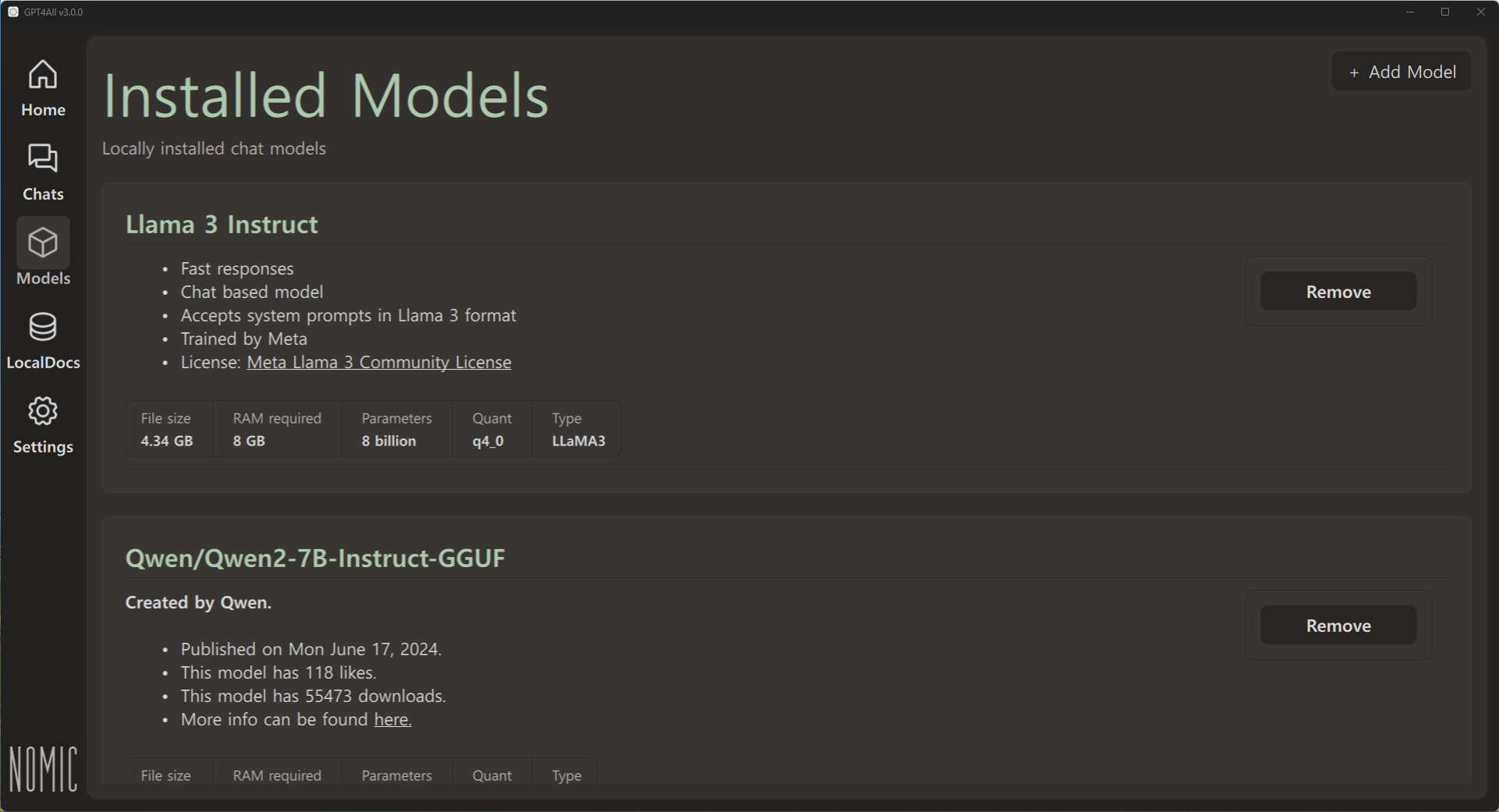

초기화면에서 Find Models를 클릭하면 아래와 같은 화면이 나오고, 검색창에서 원하는 모델을 검색하거나, 리스트에 있는 모델을 다운로드하면 됩니다. Llama3, Mistral, Phi-3, Qwen2 등 다양한 모델을 다운로드할 수 있습니다.

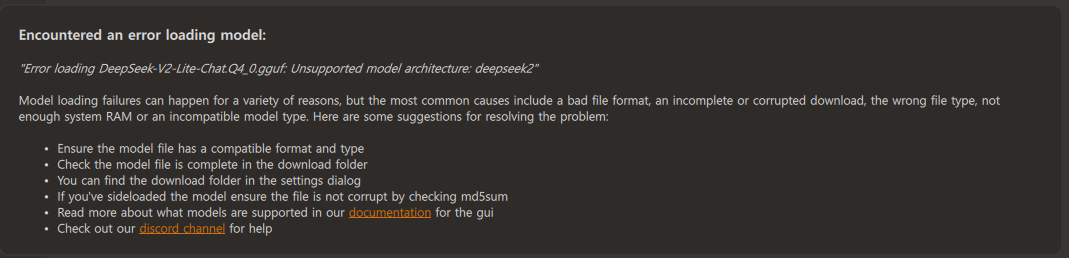

제가 시도해 본 결과, Llama3, Qwen2 모델은 사용에 큰 무리가 없었고, GPT4All Falcon 모델은 질문에 맞지 않는 답변이 많았으며, DeepSeek-V2와 Aya-23 모델은 로딩에러가 계속 발생했습니다.

모델 검색결과에는 모델의 기본정보와 허깅페이스 모델카드 링크가 표시되고, 검색창 오른쪽 톱니바퀴 아이콘을 클릭하면 날짜순이나 다운로드수로 정렬이 가능합니다.

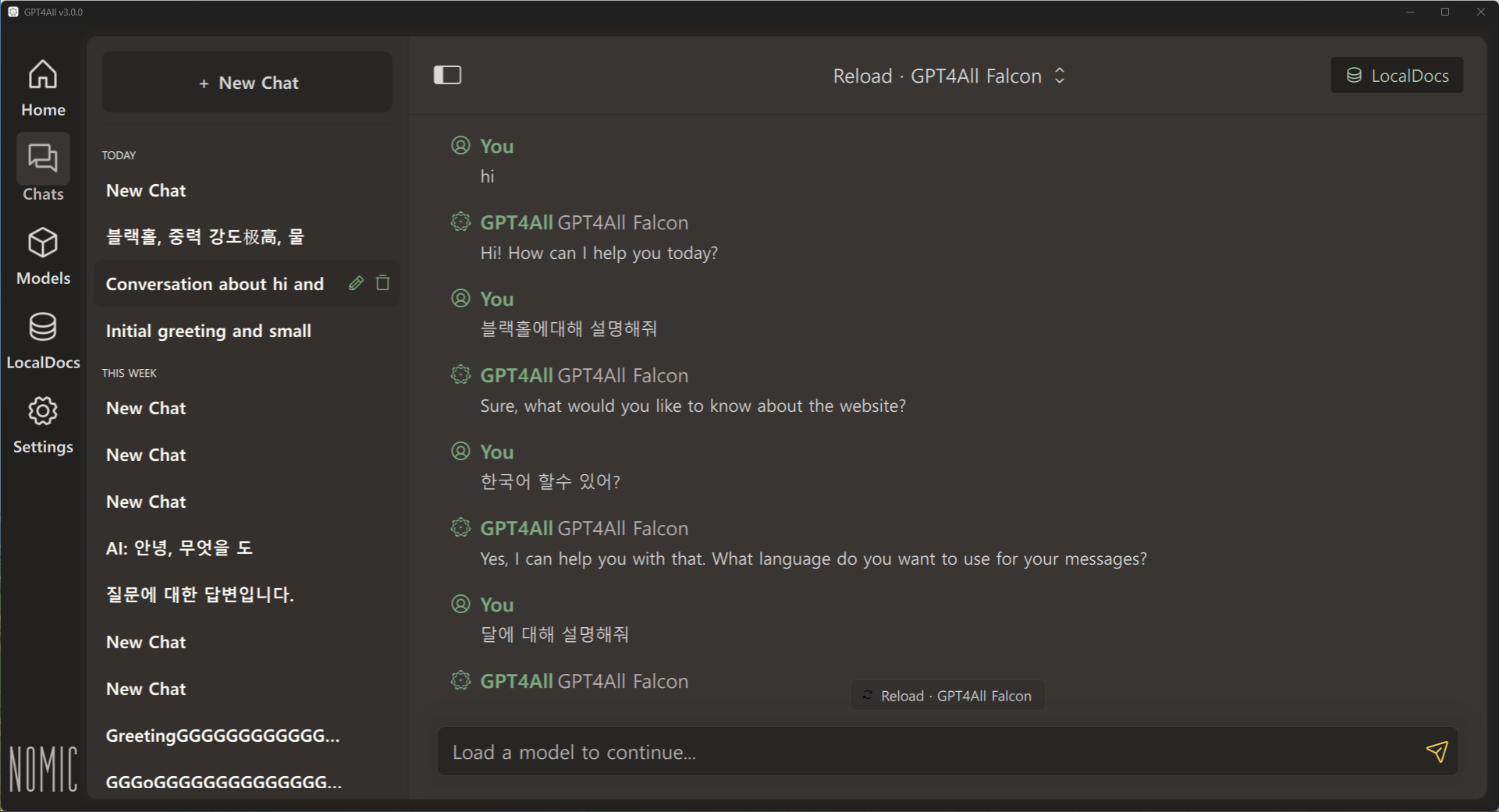

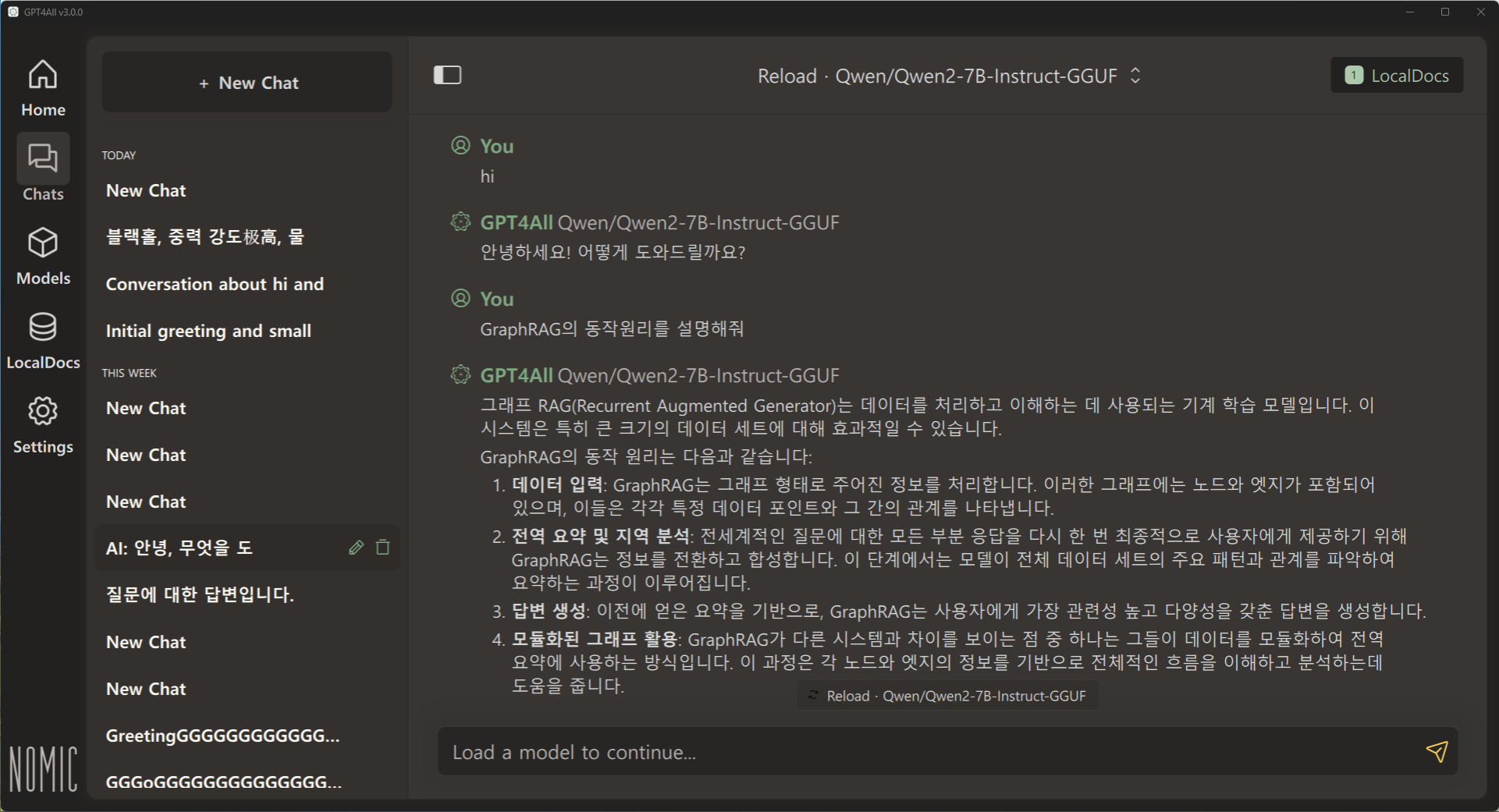

LLM 대화

LLM 대화기능에는 대화 저장기능, 대형 언어 모델 선택기능, 대화내용 복사기능 등이 있으며, 대화내용 편집, 내보내기 및 공유기능, 응답 재생성 기능은 없습니다.

정상적으로 대화했던 모델이 GPU 설정에 따라 아래 화면과 같이 응답 에러가 발생하는 경우도 있었습니다.

로컬 문서 대화

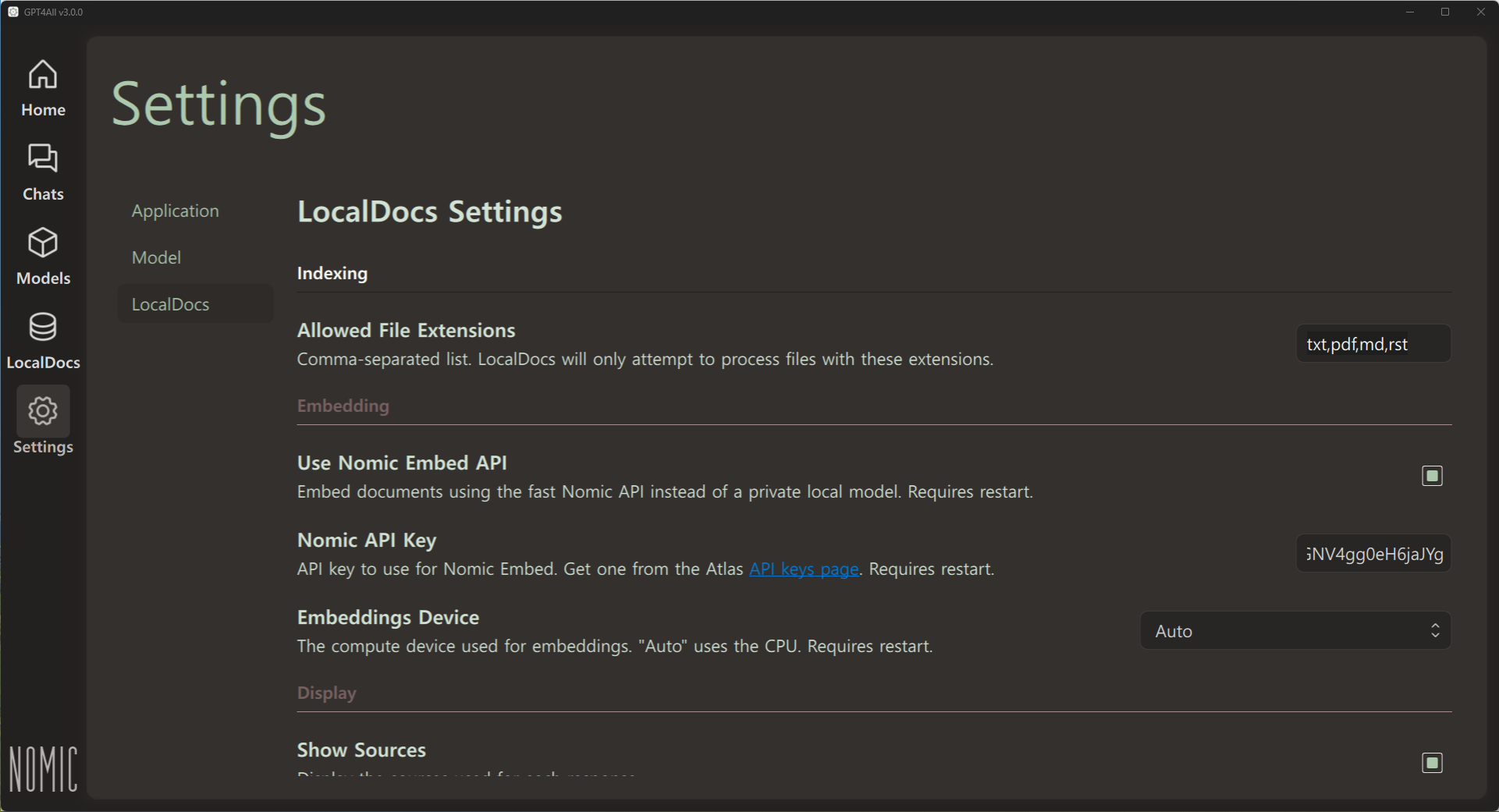

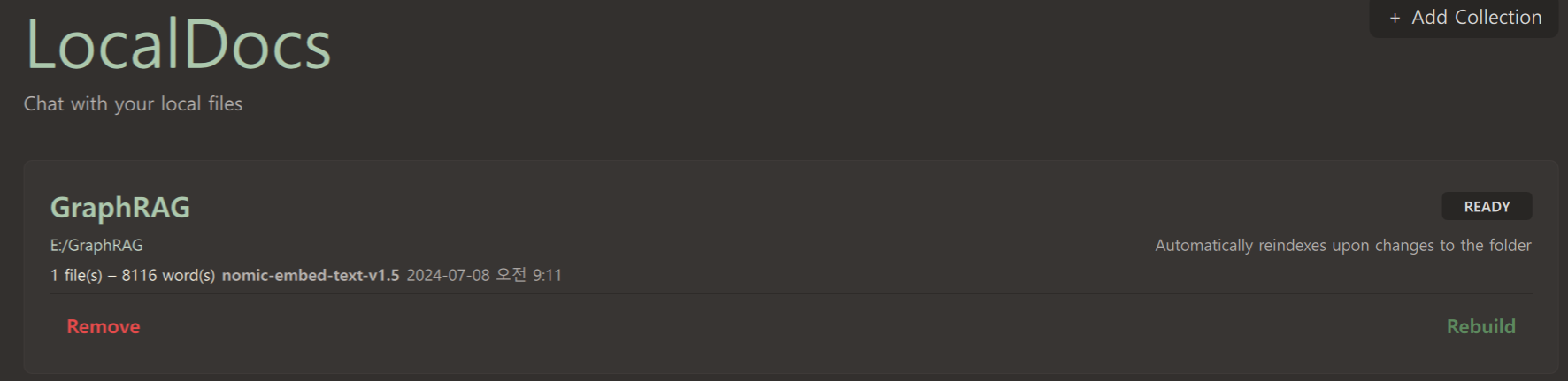

로컬 문서 대화기능은 txt, pdf, md, rst 파일 형식이 지원되며, 환경설정에서 로컬 임베딩 모델 대신 노믹 엠베드 API 사용을 설정할 수 있습니다. 노믹 엠베드 사이트에서 API Key를 발급해서 입력한 후, GPT4All을 다시 시작하면 적용됩니다.

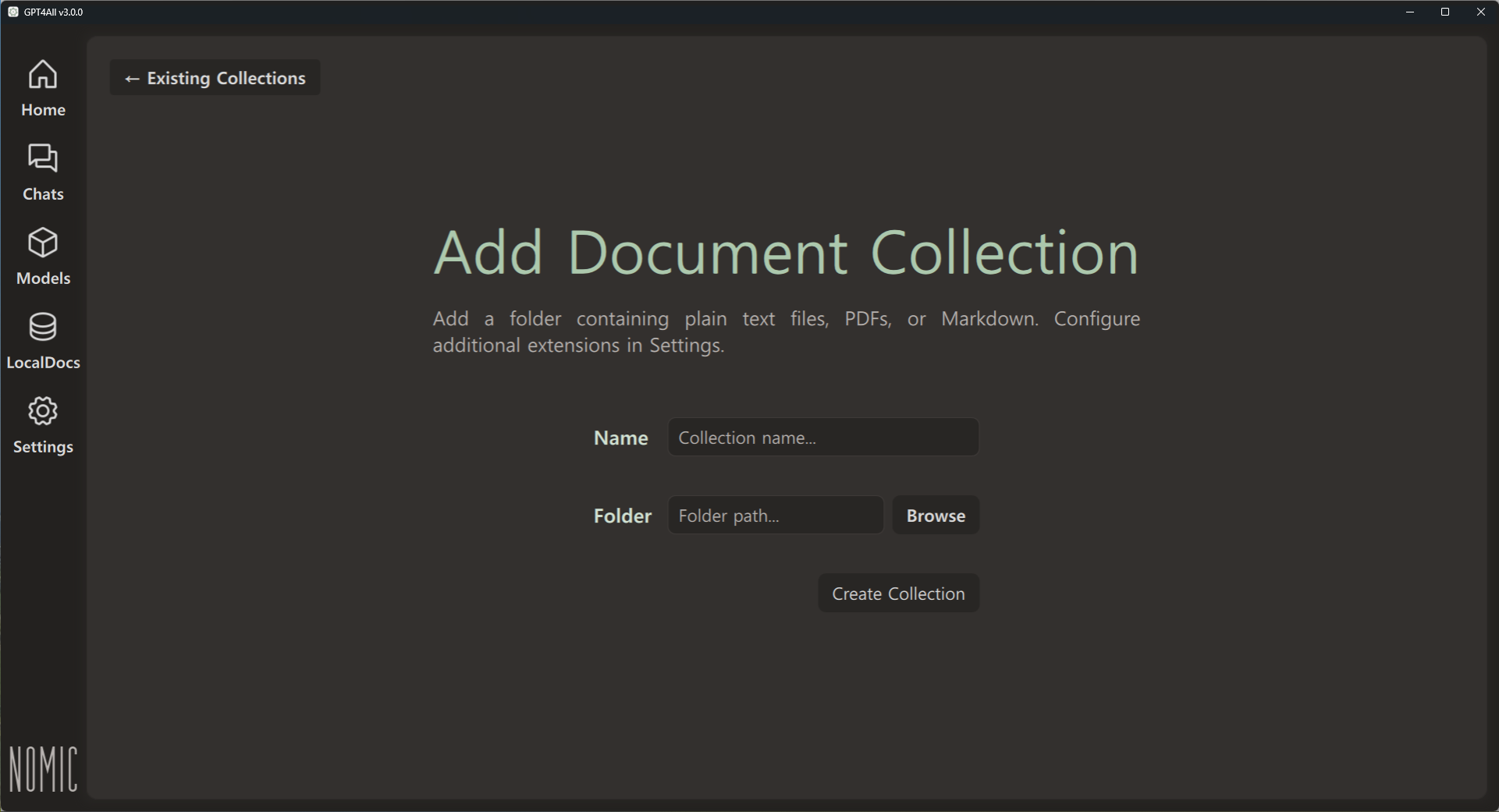

로컬 문서 추가는 아래 화면과 같이 이름과 문서 경로를 지정해서 문서 렉션을 생성한 후, 언어 모델과 대화 할 때 오른쪽 상단에 있는 "Local Docs"를 클릭하면 문서에 대해 대화할 수 있습니다.

맺음말

GPT4All은 로컬 환경에서 대규모 언어 모델을 실행할 수 있는 유용한 소프트웨어로, 데이터 프라이버시와 보안을 중요시하는 사용자들에게 큰 호응을 얻고 있으며, 다양한 운영체제와 하드웨어를 지원하고, 오픈 소스 프로젝트로서 사용자가 자유롭게 커스터마이즈 할 수 있는 장점을 가지고 있습니다.

GPT4All을 사용해 본 후기는 다음과 같습니다.

- 데이터가 외부로 유출되지 않는다는 점에서 안심하고 사용할 수 있다.

- 다양한 언어 모델을 테스트할 수 있지만 기본적인 호환성에 이슈가 있다.

- 간편하게 로컬 문서 파일에 접근하여 작업할 수 있다

- Open WebUI나 LM Studio에 비해 성능이나 호환성, 기능이 부족하다.

오늘 블로그 내용은 여기까지입니다. 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다.

2024.05.07 - [AI 도구] - Msty와 Open WebUI: 직관적인 UI와 로컬 RAG까지 지원하는 언어 모델 활용 도구

Msty와 Open WebUI: 직관적인 UI와 로컬 RAG까지 지원하는 언어 모델 활용 도구

안녕하세요! 오늘은 로컬 및 온라인 언어 모델을 간편하게 사용할 수 있는 Msty와 Open WebUI에 대해 알아보겠습니다. Msty는 클릭 한 번으로 인기 있는 대형 언어 모델과 상호 작용할 수 있는 직

fornewchallenge.tistory.com

'AI 도구' 카테고리의 다른 글

| PraisonAI Code: AI 코딩 혁신! 이젠 전체 코드 베이스와 대화하세요!(feat. 제미나이) 💬🚀 (0) | 2024.07.16 |

|---|---|

| 🤖STORM: AI로 논문 작성하기,📈주제만 입력하면 고품질 리포트 3분 완성! (2) | 2024.07.12 |

| 📊GraphRAG: 마이크로소프트의 그래프기반 RAG 접근법(feat. Ollama) (9) | 2024.07.07 |

| Brave 브라우저 AI 어시스턴트: Ollama와 LM Studio 활용법🚀🛡️🤖 (0) | 2024.07.04 |

| [Ollama 활용] 🤖AI 자동화로 손쉽게 앱 만들기: Maestro 설치 및 활용 (0) | 2024.07.02 |