안녕하세요! 오늘은 요즘 가장 핫한 이미지 생성모델 Flux.1에 대해 알아보는 두 번째 시간입니다. 지난 시간에는 모델의 크기가 23GB로 너무 커서 직접 로컬에서 실행하지 못하고 API 방식으로 이미지를 생성해 보았는데요. 오늘은 모델의 크기를 30% 이상 축소한 메모리 최적화 버전을 사용해서 ComfyUI를 통해 직접 이미지를 생성해 보겠습니다. 메모리 최적화 버전은 원본보다 결과물의 정밀도는 약간 낮지만, 이미지 품질이 나쁘지 않아서 GPU 사양이 낮은 분들도 따라 해 보시면 좋을 것 같습니다. 이 블로그에서는 Flux Dev FP8 메모리 최적화 버전의 설치방법과 ComfyUI를 이용한 이미지 생성방법에 대해 알아보겠습니다.

"이 포스팅은 쿠팡 파트너스 활동의 일환으로, 이에 따른 일정액의 수수료를 제공받습니다."

FLux Dev FP8 설치방법

FP8(Floating Point 8, 8비트 부동 소수점) 형식은 데이터를 더 작은 비트 수로 표현하여 메모리 사용을 줄이고 연산 속도를 높이는 데이터 형식입니다. FP8 형식은 1비트의 부호 비트(sign), 4비트의 지수(exponent), 3비트의 유효 숫자(mantissa)로 구성되며, 이는 정밀도를 낮추는 대신, 메모리 효율성을 극대화하고 처리 속도를 향상시킵니다. FP8 형식은 메모리 제약이 있는 환경에서 특히 유용하며, 임베디드 시스템, 실시간 응용 프로그램, 그리고 빠른 추론이 필요한 머신러닝 모델에 적합합니다.

현재 공개된 Flux Dev FP8 형식을 사용하는 방법은 크게 두 가지로, Unet 버전과 Checkpoint버전이 있습니다. 두 가지 방식 모두 로컬에서 사용하기 위해서는 기본적으로 ComfyUI 프로그램이 필요하며, 설치는 아래 다운로드 링크에서 최신 버전의 ComfyUI를 설치시면 됩니다.

https://github.com/comfyanonymous/ComfyUI/releases

Releases · comfyanonymous/ComfyUI

The most powerful and modular diffusion model GUI, api and backend with a graph/nodes interface. - comfyanonymous/ComfyUI

github.com

Unet 버전

1. ComfyUI가 설치된 상태에서 아래 표를 참고하여 각 파일을 다운로드한 후 ComfyUI 폴더 밑에 각각 저장합니다.

| 파일명 | 다운로드 링크 | 저장위치 |

| flux1-dev-fp8.safetensors | https://huggingface.co/Kijai/flux-fp8/resolve/main/flux1-dev-fp8.safetensors?download=true | ComfyUI\models\unet |

| t5xxl_fp8.safetensor | https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/t5xxl_fp8_e4m3fn.safetensors?download=true | ComfyUI\models\clip |

| clip_l.safetensor | https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/clip_l.safetensors?download=true | ComfyUI\models\clip |

| ae.sft | https://huggingface.co/black-forest-labs/FLUX.1-dev/resolve/main/ae.safetensors?download=true | ComfyUI\models\vae |

2. ComfyUI를 실행하고 아래 워크 플로우 파일을 다운로드한 후, 오른쪽 Load 메뉴를 통해 불러옵니다.

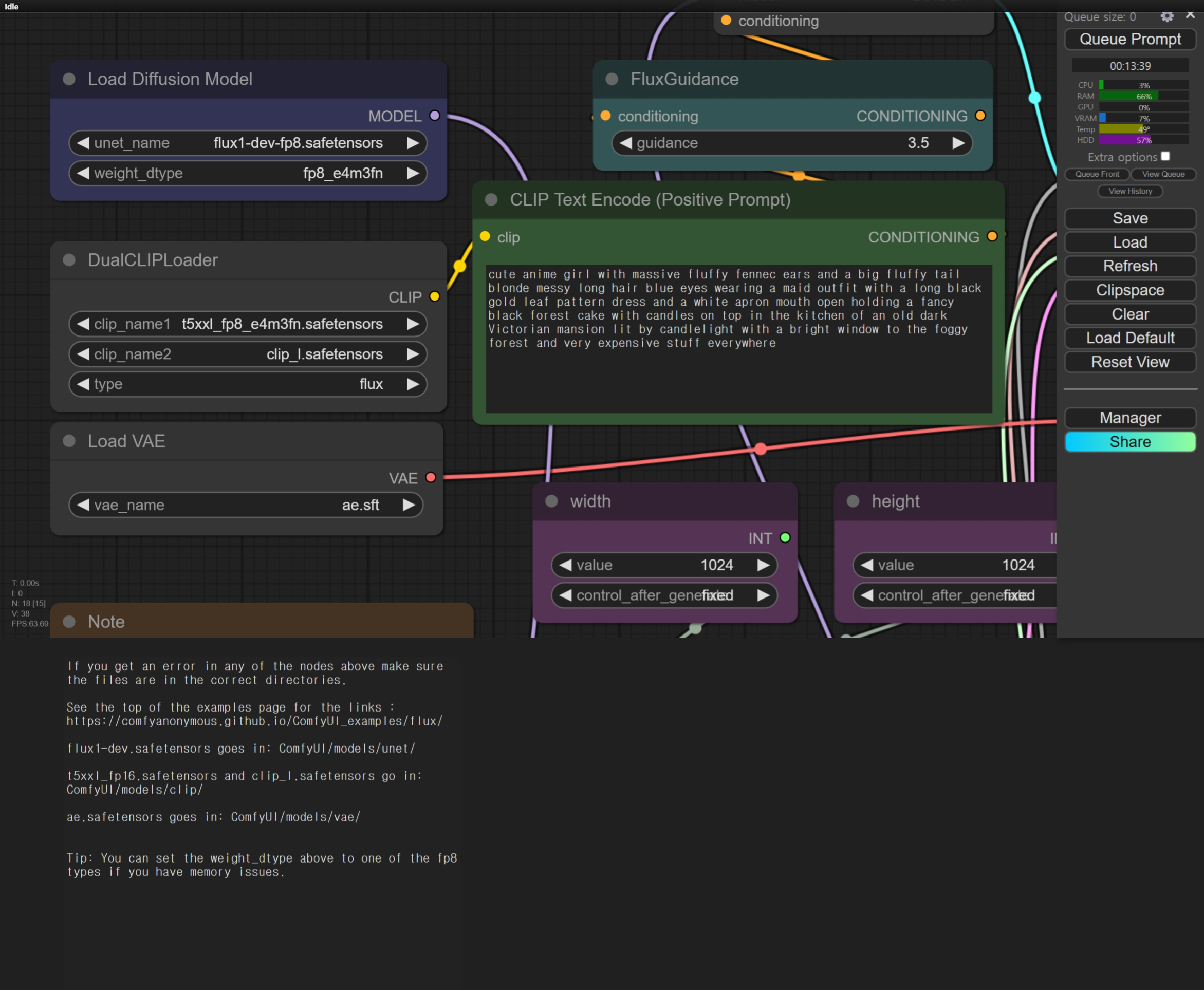

3. 아래 이미지를 참고해서 Load Diffusion Model, DualCLIPLoader, Load VAE 노드에서 사용되는 모델명을 설정합니다.

4. CLIP Text Encode 노드에 원하는 프롬프트를 입력하고 우측 상단 Queue Prompt 버튼을 클릭하면 이미지 생성이 시작됩니다.

Checkpoint 버전

1. 체크포인트 버전 Flux Dev FP8모델을 아래 링크에서 다운로드해서 ComfyUI\models\checkpoints 디렉토리에 저장합니다. 용량은 약 17GB입니다.

https://huggingface.co/Comfy-Org/flux1-dev/resolve/main/flux1-dev-fp8.safetensors

2. ComfyUI를 실행하고 아래 워크 플로우 파일을 다운로드한 후, 오른쪽 Load 메뉴를 통해 불러옵니다.

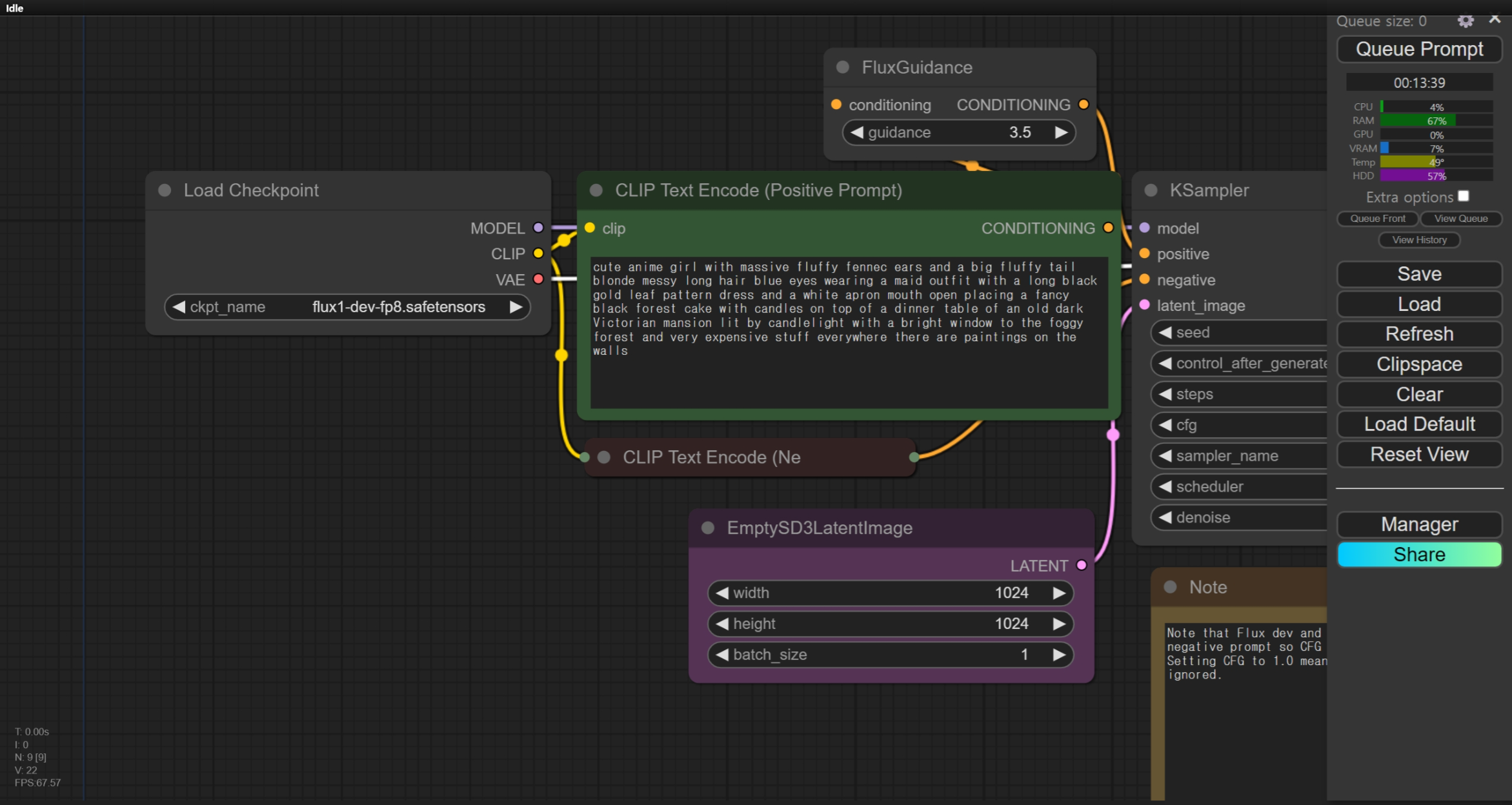

3. 아래 이미지를 참고해서 Load Checkpoint 노드에서 사용되는 모델명을 설정합니다.

4. CLIP Text Encode 노드에 원하는 프롬프트를 입력하고 우측 상단 Queue Prompt 버튼을 클릭하면 이미지 생성이 시작됩니다.

이미지 비교

다음 표는 Unet 버전과 Checkpoint 버전의 이미지를 비교한 것인데요, 개인적으로는 Unet 버전이 좀더 마음에 드는데 여러분도 한번 직접 생성해서 비교해보시기 바랍니다.

| Unet 버전 | Checkpoint 버전 |

|

|

아래 표는 원본 모델과 FP8 버전 모델이 생성한 이미지를 비교한 표입니다. 사진을 확대해서 보면 정밀도의 차이를 확인할 수 있지만, 이미지 품질이 큰 문제가 되지는 않습니다.

| fp8 모델 생성 이미지 | 원본 모델 생성 이미지 |

|

|

|

|

|

|

|

|

맺음말

오늘은 Flux Dev FP8 메모리 최적화 버전을 사용해서 로컬 ComfyUI에서 직접 이미지를 생성하는 방법에 대해 알아보았습니다. 메모리 사용량을 30% 이상 줄이면서도 높은 품질의 이미지를 생성할 수 있는 FP8 형식을 사용하면, 낮은 사양의 GPU에서도 Flux.1 모델을 통해 손쉽게 고품질 이미지를 생성할 수 있습니다.

여러분도 한번 Flux Dev FP8 메모리 최적화 버전을 사용해서 고품질의 이미지를 무료로 생성해 보시면 좋을 것 같습니다. 그럼 저는 다음 시간에 더 유익한 정보를 가지고 다시 찾아뵙겠습니다. 감사합니다!

2024.08.04 - [AI 언어 모델] - 🚀최고의 이미지 생성 모델! Flux.1: GPU 스트레스 없는 API 방식 가이드

🚀최고의 이미지 생성 모델! Flux.1: GPU 스트레스 없는 API 방식 가이드

안녕하세요! 오늘은 독일의 스타트업 Black Forest Labs가 개발한 고품질 이미지 생성 모델 FLUX.1에 대해 알아보겠습니다. Stable Diffusion의 창시자들이 설립한 회사인 Black Forest Labs는 FLUX.1의 개발을 위

fornewchallenge.tistory.com

'AI 언어 모델' 카테고리의 다른 글

| ⚡Hermes 3: Llama 3.1을 넘어선 최첨단 오픈 소스 언어 모델의 등장 (2) | 2024.08.21 |

|---|---|

| 🚀EXAONE 3.0 7.8B 리뷰: LG AI 연구소의 혁신적인 언어 모델 (5) | 2024.08.11 |

| 🚀최고의 이미지 생성 모델! Flux.1: GPU 스트레스 없는 API 방식 가이드 (0) | 2024.08.04 |

| ✨Gemini 1.5 프로 실험 버전: GPT-4o를 제치고 챗봇 아레나 1위! (2) | 2024.08.03 |

| 🧠 최강 AI 검색 비서: Mistral Large 2 모델 설정 가이드 (0) | 2024.07.26 |